Hadoop Tmp Dir

今天早上的报表没有出来,报表是从用 hadoop 进行跑的 一看 hadoop 相关日志,报如下错误 Message: org.apache.hadoop.ipc.RemoteException: java.io.IOException: org.apache.hadoop.fs.FSError: java.io.IOException: No space left on device 咋一看, 以为

今天早上的报表没有出来,报表是从用 hadoop 进行跑的

一看 hadoop 相关日志,报如下错误

<code>Message: org.apache.hadoop.ipc.RemoteException: java.io.IOException: org.apache.hadoop.fs.FSError: java.io.IOException: No space left on device </code>

咋一看, 以为是 hdfs没空间了,运行如下命令

<code> hadoop dfsadmin -report

Configured Capacity: 44302785945600 (40.29 TB)

Present Capacity: 42020351946752 (38.22 TB)

DFS Remaining: 8124859072512 (7.39 TB)

DFS Used: 33895492874240 (30.83 TB)

DFS Used%: 80.66%

Under replicated blocks: 1687

Blocks with corrupt replicas: 0

Missing blocks: 0

</code>从输出的结果来看,dfs的空间还很大,所以”No space left on device”这样的错误应该不是hdfs的问题

应该是本地磁盘的问题,发现hadoop运行时,要用到一个临时目录,可以在core-site.xml文件中配置

<code>hadoop.tmp.dir </code>

默认的路径是 /tmp/hadoop-${user.name}

看了一下 /tmp/的空间,确实很小了,把hadoop.tmp.dir挂到一个大一点的盘上就可以了

hadoop.tmp.dir是其它临时目录的父目录

但是一个问题还没有解决, hadoop.tmp.dir到底需要多大空间呢?怎么样计算呢?

common-question-and-requests-from-our-users

原文地址:Hadoop Tmp Dir, 感谢原作者分享。

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1393

1393

52

52

Das Reinigungsprinzip des Ordners /tmp/ im Linux-System und die Rolle der tmp-Datei

Dec 21, 2023 pm 05:36 PM

Das Reinigungsprinzip des Ordners /tmp/ im Linux-System und die Rolle der tmp-Datei

Dec 21, 2023 pm 05:36 PM

Bei den meisten .tmp-Dateien handelt es sich um Dateien, die aufgrund eines abnormalen Herunterfahrens oder Absturzes zurückgeblieben sind. Diese temporären Arbeitsdisketten haben nach einem Neustart des Computers keine Verwendung mehr, sodass Sie sie bedenkenlos löschen können. Wenn Sie das Windows-Betriebssystem verwenden, finden Sie möglicherweise häufig einige Dateien mit dem Suffix TMP im Stammverzeichnis des Laufwerks C. Außerdem finden Sie im Windows-Verzeichnis ein TEMP-Verzeichnis. TMP-Dateien sind temporäre Dateien, die von verschiedenen Softwareprogrammen generiert werden Systeme, auch Junk-Dateien genannt. Von Windows generierte temporäre Dateien sind im Wesentlichen dasselbe wie virtueller Speicher, mit der Ausnahme, dass temporäre Dateien gezielter sind als virtueller Speicher und nur einem bestimmten Programm dienen. Und seine Besonderheit hat dazu geführt, dass sich viele Neulinge davon einschüchtern ließen und es nicht löschten.

Wie kann ich in CentOS 7 auf Junk-Dateien im Verzeichnis /tmp zugreifen und diese bereinigen?

Dec 27, 2023 pm 09:10 PM

Wie kann ich in CentOS 7 auf Junk-Dateien im Verzeichnis /tmp zugreifen und diese bereinigen?

Dec 27, 2023 pm 09:10 PM

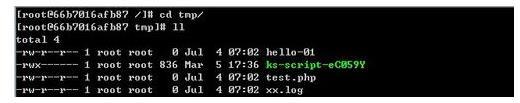

Im tmp-Verzeichnis des Centos7-Systems befindet sich viel Müll. Wie sollten Sie den Müll löschen? Werfen wir einen Blick auf das ausführliche Tutorial unten. Um die Liste der Dateien im tmp-Dateiverzeichnis anzuzeigen, führen Sie den Befehl cdtmp/ aus, um zum aktuellen Dateiverzeichnis von tmp zu wechseln, und führen Sie den Befehl ll aus, um die Liste der Dateien im aktuellen Verzeichnis anzuzeigen. Wie nachfolgend dargestellt. Verwenden Sie den Befehl rm, um Dateien zu löschen. Beachten Sie, dass der Befehl rm Dateien dauerhaft aus dem System löscht. Daher wird empfohlen, vor dem Löschen der Datei eine Eingabeaufforderung zu geben. Verwenden Sie den Befehl rm-i file name, warten Sie, bis der Benutzer den Löschvorgang bestätigt (y) oder den Löschvorgang überspringt (n), und das System führt die entsprechenden Vorgänge aus. Wie nachfolgend dargestellt.

Was bedeutet tmp unter Linux?

Mar 10, 2023 am 09:26 AM

Was bedeutet tmp unter Linux?

Mar 10, 2023 am 09:26 AM

Unter Linux bezieht sich tmp auf einen Ordner, in dem temporäre Dateien gespeichert werden, und die Standardzeitbegrenzung des tmp-Ordners beträgt 30 Tage. Dateien unter tmp werden automatisch gespeichert vom System gelöscht.

Java-Fehler: Hadoop-Fehler, wie man damit umgeht und sie vermeidet

Jun 24, 2023 pm 01:06 PM

Java-Fehler: Hadoop-Fehler, wie man damit umgeht und sie vermeidet

Jun 24, 2023 pm 01:06 PM

Java-Fehler: Hadoop-Fehler, wie man damit umgeht und sie vermeidet Wenn Sie Hadoop zur Verarbeitung großer Datenmengen verwenden, stoßen Sie häufig auf einige Java-Ausnahmefehler, die sich auf die Ausführung von Aufgaben auswirken und zum Scheitern der Datenverarbeitung führen können. In diesem Artikel werden einige häufige Hadoop-Fehler vorgestellt und Möglichkeiten aufgezeigt, mit ihnen umzugehen und sie zu vermeiden. Java.lang.OutOfMemoryErrorOutOfMemoryError ist ein Fehler, der durch unzureichenden Speicher der Java Virtual Machine verursacht wird. Wenn Hadoop ist

Welche Datei ist TmP?

Dec 25, 2023 pm 03:39 PM

Welche Datei ist TmP?

Dec 25, 2023 pm 03:39 PM

Die „tmp“-Datei ist eine temporäre Datei, die normalerweise vom Betriebssystem oder Programm während des Betriebs generiert wird und zum Speichern temporärer Daten oder Zwischenergebnisse verwendet wird, wenn das Programm ausgeführt wird. Diese Dateien werden hauptsächlich verwendet, um die reibungslose Ausführung des Programms zu unterstützen, werden jedoch normalerweise nach der Ausführung des Programms automatisch gelöscht. tmp-Dateien befinden sich normalerweise im Stammverzeichnis des Laufwerks C auf Windows-Systemen. Allerdings sind tmp-Dateien mit einer bestimmten Anwendung oder einem bestimmten System verknüpft, sodass ihr spezifischer Inhalt und Zweck von Anwendung zu Anwendung unterschiedlich sein kann.

Welche Datei ist tmp

Feb 22, 2023 pm 02:35 PM

Welche Datei ist tmp

Feb 22, 2023 pm 02:35 PM

tmp ist eine temporäre Datei, die von verschiedenen Softwareprogrammen oder Systemen generiert wird und oft als Junk-Datei bezeichnet wird. Normalerweise löschen Programme, die temporäre Dateien erstellen, diese, wenn sie fertig sind, aber manchmal bleiben diese Dateien erhalten. Es kann viele Gründe dafür geben, dass temporäre Dateien erhalten bleiben: Das Programm kann vor Abschluss der Installation unterbrochen werden oder beim Neustart abstürzen. Diese Dateien sind im Allgemeinen von geringem Nutzen und wir können sie direkt löschen.

Verwendung von Hadoop und HBase in Beego für die Speicherung und Abfrage großer Datenmengen

Jun 22, 2023 am 10:21 AM

Verwendung von Hadoop und HBase in Beego für die Speicherung und Abfrage großer Datenmengen

Jun 22, 2023 am 10:21 AM

Mit dem Aufkommen des Big-Data-Zeitalters sind Datenverarbeitung und -speicherung immer wichtiger geworden und die effiziente Verwaltung und Analyse großer Datenmengen ist für Unternehmen zu einer Herausforderung geworden. Hadoop und HBase, zwei Projekte der Apache Foundation, bieten eine Lösung für die Speicherung und Analyse großer Datenmengen. In diesem Artikel wird erläutert, wie Sie Hadoop und HBase in Beego für die Speicherung und Abfrage großer Datenmengen verwenden. 1. Einführung in Hadoop und HBase Hadoop ist ein verteiltes Open-Source-Speicher- und Computersystem, das dies kann

Wie man PHP und Hadoop für die Big-Data-Verarbeitung verwendet

Jun 19, 2023 pm 02:24 PM

Wie man PHP und Hadoop für die Big-Data-Verarbeitung verwendet

Jun 19, 2023 pm 02:24 PM

Da die Datenmenge weiter zunimmt, sind herkömmliche Datenverarbeitungsmethoden den Herausforderungen des Big-Data-Zeitalters nicht mehr gewachsen. Hadoop ist ein Open-Source-Framework für verteiltes Computing, das das Leistungsengpassproblem löst, das durch Einzelknotenserver bei der Verarbeitung großer Datenmengen verursacht wird, indem große Datenmengen verteilt gespeichert und verarbeitet werden. PHP ist eine Skriptsprache, die in der Webentwicklung weit verbreitet ist und die Vorteile einer schnellen Entwicklung und einfachen Wartung bietet. In diesem Artikel wird die Verwendung von PHP und Hadoop für die Verarbeitung großer Datenmengen vorgestellt. Was ist HadoopHadoop ist