Hallo Leute, ich bin Luga, heute werden wir über Technologien im Zusammenhang mit dem ökologischen Bereich der künstlichen Intelligenz (KI) sprechen – LLM-Entwicklungsrahmen.

Im Bereich der LLM-Anwendungsentwicklung (Large Scale Language Model) spielen Open-Source-Frameworks eine wichtige Rolle und bieten leistungsstarke Toolunterstützung für Entwickler. Als führendes Unternehmen auf diesem Gebiet hat LangChain für sein innovatives Design und seine umfassende Funktionalität große Anerkennung gefunden. Gleichzeitig sind aber auch einige alternative Frameworks entstanden, die bessere Auswahlmöglichkeiten für die Bedürfnisse in verschiedenen Szenarien bieten.

Schließlich weist jedes Framework zwangsläufig bestimmte Einschränkungen auf. Beispielsweise kann die Geschwindigkeitsabstraktion von LangChain in einigen Fällen den Einstieg erschweren, das Debugging-Erlebnis muss verbessert werden und auch die Qualität einiger Codes verdient eine Verbesserung. Dies ist genau die Richtung, in die alternative Produkte streben. Sie streben danach, eine komfortablere und effizientere Anwendungserstellung für Entwickler zu schaffen, indem sie das Architekturdesign optimieren, technische Praktiken verbessern, die Community-Unterstützung stärken usw.

Dies ist ein beliebtes Open-Source-Framework. LangChain soll Entwickler bei der Erstellung von Anwendungen für künstliche Intelligenz unterstützen. LangChain vereinfacht den Prozess der Entwicklung von LLM (LangLink Model)-basierten Anwendungen durch die Bereitstellung von Standardschnittstellen für Verkettung, Proxys und Speichermodule.

In praktischen Anwendungsszenarien ist das LangChain+ Framework besonders hilfreich bei der schnellen Erstellung von Proofs of Concept (POC). Die Verwendung eines beliebigen Frameworks bringt jedoch einige Herausforderungen mit sich. Konkret wie folgt:

Im Aufschwung der LLM-Entwicklung und -Anwendung (Large-Scale Language Model) wird die Bewertung und Autorisierung der Vorteile verschiedener Toolplattformen ein entscheidender Faktor sein. Eine umfassende Analyse basierend auf sieben Schlüsseldimensionen, darunter Prompt Engineering, Datenintegration, Workflow-Orchestrierung, Testvisualisierung, Bewertungsindikatoren, Produktionsbereitschaft und Lebenszyklusmanagement, ist zweifellos eine sehr zukunftsweisende und systematische Idee und Richtung.

Als nächstes führen wir eine detaillierte Analyse nach der anderen durch:

Es besteht kein Zweifel, dass ein qualitativ hochwertiges Prompt Engineering die Voraussetzung und der Grundstein dafür ist, das Potenzial von LLM voll auszuschöpfen. Eine ideale Tool-Plattform sollte nicht nur eine prägnante und flexible Schnittstelle zum Erstellen von Eingabeaufforderungen bieten, sondern auch fortschrittliche Technologien wie das Verständnis natürlicher Sprache und semantische Analyse integrieren, um die automatische Generierung und Optimierung von Eingabeaufforderungen zu realisieren, die Anpassung an bestimmte Aufgabenkontexte zu maximieren und die Kosten zu senken des manuellen Eingriffs.

Darüber hinaus ist bei komplexen mehrstufigen Aufgaben auch die Frage wichtig, ob die parametrisierte Verwaltung und Versionskontrolle von Eingabeaufforderungen unterstützt werden kann.

Der Aufstieg des RAG-Paradigmas macht effiziente externe Wissensdatenbank-Integrationsfunktionen zu einer notwendigen Fähigkeit für Toolplattformen. Eine hervorragende Plattform sollte nicht nur in der Lage sein, verschiedene heterogene Datenquellen einfach zu verbinden und zu importieren, sondern auch über starke Datenvorverarbeitungs- und Qualitätskontrollfunktionen verfügen, um die Genauigkeit und Konsistenz der Wissensinjektion sicherzustellen. Darüber hinaus wird die visuelle Analyse und Optimierung umfangreicher Suchergebnisse auch die Arbeitseffizienz der Entwickler erheblich verbessern.

Angesichts komplexer Aufgabenanforderungen in der realen Welt ist es für einen einzelnen LLM normalerweise schwierig, diese unabhängig zu erledigen. Daher wird die Fähigkeit, den Arbeitsablauf mehrerer Modellmodule flexibel zu orchestrieren und durch Parametersteuerung differenzierte Kombinationen zu erreichen, zur zentralen Wettbewerbsfähigkeit der Werkzeugplattform.

Gleichzeitig wird eine gute Unterstützung für Workflow-Versionsverwaltung, Parameteroptimierung, Wiederholbarkeit und andere Funktionen auch die Entwicklungseffizienz erheblich verbessern.

Als typische „Black-Box“-KI war der interne Mechanismus des LLM-Systems schon immer verwirrend. Eine hervorragende Tool-Plattform sollte darauf abzielen, diese Einschränkung zu überwinden und Einblicke in den internen Zustand des Modells durch Mittel wie die Visualisierung der Aufmerksamkeitsverteilung und die Verfolgung des Argumentationspfads zu gewähren. Gleichzeitig sollte sie eine genauere Fehlerbehebung, Abweichungskorrektur und Leistungsoptimierung unterstützen Dadurch wird die Interpretierbarkeit und Vertrauenswürdigkeit des Systems erheblich verbessert.

Ein strenger Bewertungsprozess ist ein wesentlicher Bestandteil der Sicherstellung der Qualität von LLM-Bewerbungen. An diesem Punkt werden die von den verschiedenen Plattformen bereitgestellte Bewertungsinfrastruktur, die abgedeckten Indikatordimensionen, der Grad der Automatisierung und der Grad der Integration mit der manuellen Bewertung direkt die Objektivität und Autorität der Bewertungsergebnisse bestimmen.

Generell gesehen bietet ein ausgereiftes Bewertungssystem auf jeden Fall eine solide Qualitätsgarantie für die tatsächliche Umsetzung des Endprodukts.

Für industrietaugliche Anwendungen, die auf Produktionsumgebungen ausgerichtet sind, werden die Bereitstellungs- sowie Betriebs- und Wartungsfunktionen der Tool-Plattform ein zentraler Aspekt sein. Ein vollständiger Online-Mechanismus, unterstützte Bereitstellungsoptionen (Cloud, Edge-Geräte usw.), Sicherheitskonformität, Leistungsoptimierung, Überwachung und Alarmierung sowie andere Produktgarantien wirken sich direkt auf die endgültige Verfügbarkeit und Zuverlässigkeit des LLM-Systems aus.

Als innovative Spitzentechnologie ist die nahtlose Integration der LLM-Plattform in bestehende Unternehmenstechnologie-Stacks eine Voraussetzung, um ihre breite Anwendung sicherzustellen. Ein riesiger Anwendungsspeicher von Drittanbietern und eine Partnerressourcenbibliothek werden dazu beitragen, ein reichhaltiges Ökosystem aufzubauen, das ein breiteres Spektrum an Branchenszenarien und differenzierten Anforderungen abdeckt und so die groß angelegte Popularisierung und innovative Anwendung der LLM-Technologie fördert.

Durch eine umfassende Analyse und einen Kompromissvergleich der oben genannten sieben Dimensionen können wir die Vor- und Nachteile verschiedener LLM-Entwicklungstoolplattformen relativ objektiv bewerten. Beispielsweise sind wir bei Szenarien, die sich auf schnelle technische Fähigkeiten konzentrieren, möglicherweise eher dazu geneigt, Plattformen zu wählen, die in diesem Bereich eine herausragende Leistung erbringen, während es bei industriellen Anwendungen, die starke Produktionsbetriebs- und Wartungsgarantien erfordern, Faktoren wie Bereitstellung und Zuverlässigkeit sein werden wichtiger.

Zusätzlich zu den oben genannten sieben Funktionsmerkmalen müssen wir natürlich auch einige andere nichtfunktionale Faktoren berücksichtigen, wie z. B. Benutzerfreundlichkeit, Lernkurve, Dokumentqualität, Community-Aktivität, Entwicklungsroute usw., basierend auf den spezifischen Szenenanforderungen und Arbeitsgewohnheiten können wir eine wirklich anspruchsvolle Entscheidung über die Werkzeugauswahl treffen.

Gleichzeitig sind die Vitalität und die nachhaltige Entwicklungsfähigkeit der Tool-Plattform auch unverzichtbare Perspektiven. Eine aktive Entwicklungsgemeinschaft, ein umfassender Geschäftsunterstützungsplan und ein kontinuierlicher Weg zur technologischen Innovation werden uns langfristigen und zuverlässigen Support bieten. Schließlich steckt die Entwicklung der LLM-Technologie noch in den Kinderschuhen und Toolplattformen müssen mit der Zeit gehen und sich ständig an neue Veränderungstendenzen anpassen und diese aufgreifen.

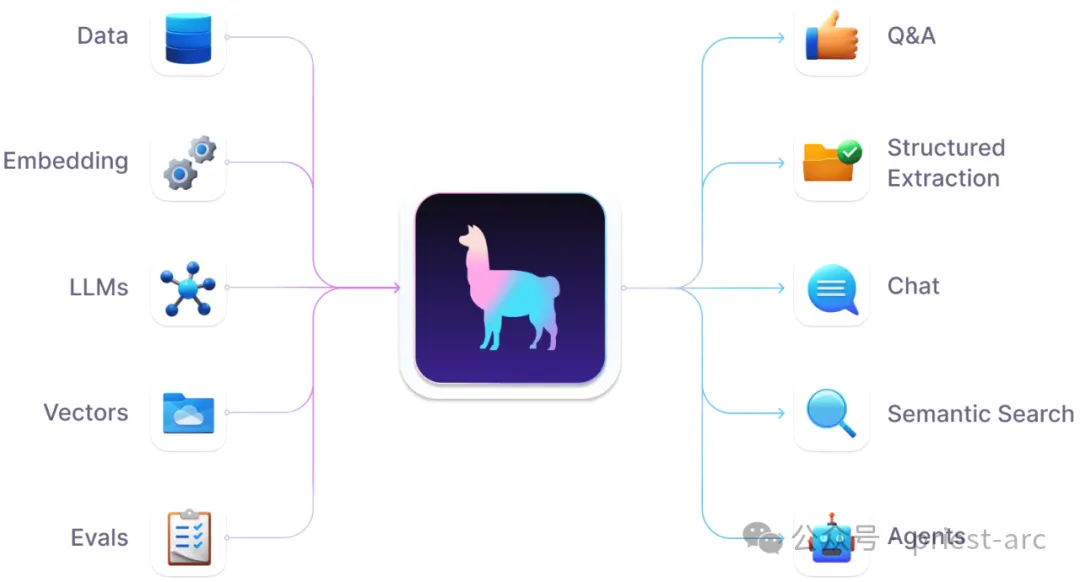

In der Welle des LLM (Large Scale Language Model) wird die RAG-Architektur (Retrieval Augmented Generation) zunehmend zum Mainstream-Paradigma. Als Open-Source-Datenframework, das sich auf die Erstellung von RAG-Anwendungen konzentriert, weist LlamaIndex zweifellos ein vielversprechendes Entwicklungspotenzial auf.

LlamaIndex-Datenrahmen für LLM-Anwendungen (Quelle: LlamaIndex)

Im Vergleich zu bekannten Projekten wie Langchain bietet LlamaIndex Benutzern aufgrund seiner fokussierten Feldoptimierung und innovativen Designkonzepte Erfahrung in der Anwendungsentwicklung von RAG mehr Effizienz und Professionalität . Wir könnten genauso gut eine detailliertere Analyse seiner Hauptmerkmale und Vorteile durchführen:

Zuallererst schneidet LlamaIndex hervorragend bei der Datenaufnahme und Vorverarbeitung ab. Es ist nicht nur mit einer Vielzahl strukturierter und unstrukturierter Datenformate kompatibel, sondern, was noch wichtiger ist, stellt durch flexible Textsegmentierung, Vektorisierung und andere Mechanismen sicher, dass Daten mit hoher Qualität in den LLM-Speicher kodiert werden. Dies legt eine solide Grundlage für das Kontextverständnis während der Generierungsphase.

Gleichzeitig bietet LlamaIndex eine umfangreiche Auswahl an Indexdatenstrukturen und Abfragestrategien, sodass Entwickler die Vorteile der Abfrageeffizienz in verschiedenen Szenarien voll ausschöpfen und einen leistungsstarken semantischen Abruf erzielen können. Diese gezielte Optimierung ist eine der zentralen Anforderungen für RAG-Anwendungen.

Ein weiteres Highlight, das Aufmerksamkeit verdient, ist die natürliche Unterstützung multimodaler Daten (wie Bilder, Videos usw.) durch LlamaIndex. Durch die Integration mit führenden visuellen Semantikmodellen kann ein umfassender modalübergreifender Kontext in den RAG-Generierungsprozess eingeführt werden, der der Ausgabe neue Dimensionen verleiht. Es besteht kein Zweifel, dass dies den Weg für zahlreiche innovative Anwendungen ebnen wird.

Zusätzlich zu den Kernfunktionen des Datenmanagements konzentriert sich LlamaIndex auch auf die technische Praxis der RAG-Anwendungsentwicklung. Es bietet erweiterte Funktionen wie parallele Abfragen und Dask-basierte verteilte Computerunterstützung, was die Effizienz der Datenverarbeitung erheblich verbessert und den Grundstein für die Produktion in großem Maßstab legt.

Aus architektonischer Sicht hält sich LlamaIndex an das modulare und skalierbare Designkonzept. Das flexible Plug-in-System ermöglicht Entwicklern die einfache Einführung benutzerdefinierter Datenlader, Textsplitter, Vektorindizes und anderer Module, um personalisierte Anforderungen in verschiedenen Szenarien vollständig zu erfüllen.

Darüber hinaus ist die perfekte Integration der Open-Source-Ökologie ein einzigartiger Vorteil von LlamaIndex. Es verfügt über eine sofort einsatzbereite integrierte Unterstützung für gängige Tools und Frameworks wie Hugging Face, FAISS usw., sodass Benutzer erweiterte KI/ML-Funktionen ohne Hindernisse nutzen können, um effizient innovative Produkte zu entwickeln.

Als professionelles Tool, das auf RAG-Anwendungen basiert, hat sich LlamaIndex zu einer hervorragenden Ergänzung zu allgemeinen Frameworks wie Langchain entwickelt. Entwickler können nun je nach tatsächlichem Bedarf frei zwischen dem effizienten und optimierten Weg von LlamaIndex und dem allgemeinen und flexiblen Paradigma von Langchain wählen und so die Entwicklungseffizienz und Produktqualität maximieren.

Natürlich ist LlamaIndex schließlich ein junges und dynamisches Projekt, und es gibt noch viel Raum für Verbesserungen und Entwicklung. Beispielsweise werden die weitere Verbesserung der Modellierungsfähigkeiten komplexerer Szenarien, die Bereitstellung intelligenterer automatischer Optimierungsvorschläge und die Stärkung der Anhäufung von Best Practices und Referenzanwendungsfällen die Schlüsselrichtungen der Zukunft sein.

Gleichzeitig wird LlamaIndex weiterhin die neuesten Entwicklungen in LLM- und RAG-Architekturen verfolgen und aufkommende Modell- und Paradigmeninnovationen rechtzeitig integrieren, um branchenführende Standards in allen Dimensionen aufrechtzuerhalten. Nichts davon wäre ohne die langfristige Investition und die kontinuierliche Unterstützung einer aktiven Entwicklergemeinschaft, erstklassiger Unternehmenspartner und Kollegen in der wissenschaftlichen Forschungsgemeinschaft möglich.

Im Bereich der LLM-Anwendungsentwicklung (Large-Scale Language Model) waren die Senkung der Schwelle und die Verbesserung der Effizienz schon immer die gemeinsamen Bestrebungen der Branche. Als Open-Source-Tool zur Erstellung von LLM-Anwendungen ohne Code entwickelt sich Flowise zu einem leistungsstarken Praktiker in diesem Bestreben.

Im Gegensatz zu herkömmlichen Codierungsentwicklungs-Frameworks ist die innovative visuelle Drag-and-Drop-Oberfläche von Flowise das größte Highlight. Entwickler müssen sich nicht eingehend mit Programmiersprachen auskennen. Sie müssen lediglich voreingestellte Komponentenmodule per Drag-and-Drop auf die Schnittstelle ziehen und können durch einfache Parameterkonfiguration und -verkabelung problemlos leistungsstarke LLM-Anwendungen erstellen. Dieses neue Entwicklungsparadigma hat die Einstiegshürde erheblich gesenkt, sodass die Entwicklung von LLM-Anwendungen nicht länger die ausschließliche Domäne von Programmierern ist. Auch normale Benutzer können ihrer Kreativität freien Lauf lassen und Automatisierungsanforderungen realisieren.

Flowise AI Reference Flow (Quelle: Flowise)

Noch erwähnenswert ist, dass Flowise kein einfaches Low-Code-Tool ist, sondern auf Kernel-Ebene tief in LangChain, das Top-Framework der Branche, integriert ist. Dies bedeutet, dass Flowise alle Kernfunktionen wie die leistungsstarke LLM-Orchestrierung, verkettete Anwendungen und Datenverbesserung von LangChain nativ unterstützt und sie durch Drag-and-Drop-Komponenten vollständig der codefreien Schnittstelle zur Verfügung stellt, wodurch die Flexibilität und Erweiterung der Anwendungsentwicklung gewährleistet wird. Fähigkeit. Egal, ob Sie ein einfaches Frage-Antwort-System oder einen komplexen multimodalen Analyseprozess erstellen, Flowise kann Ihre Anforderungen vollständig erfüllen.

Ein weiterer herausragender Vorteil von Flowise ist neben der umfassenden Funktionalität die nahtlose Integration in das bestehende Ökosystem. Als echtes Open-Source-Projekt bietet Flowise sofort einsatzbereite Unterstützung für gängige LLM-Modelle und Toolketten, sodass Entwickler diese technischen Funktionen ohne Hindernisse nutzen und problemlos einzigartige und innovative Anwendungen erstellen können, die mit der Zeit Schritt halten.

Flowise ist beispielsweise nahtlos mit gängigen LLM-Modellen wie Anthropic, OpenAI, Cohere usw. kompatibel. Benutzer können die neuesten und leistungsstärksten Sprachfunktionen mit einfacher Konfiguration aufrufen, gleichzeitig ist es auch mit der Datenintegrationsökologie kompatibel wie Pandas, SQL, Web API usw. Die native Unterstützung ermöglicht Anwendungen auch den freien Zugriff auf umfangreiche heterogene Datenquellen.

Das Attraktivste ist, dass Flowise kein geschlossenes System ist, sondern eine offene API und einen eingebetteten Integrationsmechanismus bietet. Entwickler können Flowise-Anwendungen problemlos in jede Produktumgebung wie Websites, Apps, Desktop-Software usw. integrieren und benutzerdefinierte Anfragen von allen Parteien akzeptieren, um ein End-to-End-Closed-Loop-Erlebnis zu erreichen.

Man kann sagen, dass Flowise mit Hilfe des leistungsstarken technischen Kerns von LangChain, seiner eigenen flexiblen visuellen Architektur und der nahtlosen Integration in das Ökosystem zu einem leistungsstarken Bindeglied geworden ist, das LLM mit Endbenutzern verbindet und den Demokratisierungsprozess von LLM fördert. Jede bedürftige Einzelperson oder jedes Unternehmen kann mit einem Klick auf der Flowis-Plattform ihre eigenen intelligenten Anwendungen erstellen und bereitstellen und die Produktivitätsverbesserungen durch KI genießen. 3.AutoChain

from autochain.agent.conversational_agent.conversational_agent import (ConversationalAgent,)from autochain.chain.chain import Chainfrom autochain.memory.buffer_memory import BufferMemoryfrom autochain.models.chat_openai import ChatOpenAIllm = ChatOpenAI(temperature=0)memory = BufferMemory()agent = ConversationalAgent.from_llm_and_tools(llm=llm)chain = Chain(agent=agent, memory=memory)user_query = "Write me a poem about AI"print(f">> User: {user_query}")print(f""">>> Assistant: {chain.run(user_query)["message"]}""")>> User: Write me a poem about AIPlanningPlanning output: {'thoughts': {'plan': "Based on the user's request for a poem about AI, I can use a tool to generate a poem or write one myself.", 'need_use_tool': "Yes, I can use the 'Poem Generator' tool to generate a poem about AI."}, 'tool': {'name': 'Poem Generator', 'args': {'topic': 'AI'}}, 'response': "Sure, I can generate a poem about AI for you. Here it is:\n\nIn the world of AI, \nWhere machines learn and try, \nWe see a future bright, \nWhere technology takes flight. \nFrom self-driving cars, \nTo robots on Mars, \nAI is changing the game, \nAnd we'll never be the same. \nSo let's embrace this new age, \nAnd see where it takes us on this stage. \nFor AI is here to stay, \nAnd it's only just begun its play."}Plan to take action 'Poem Generator'Deciding if need clarificationPlanningPlanning output: {'thoughts': {'plan': "Since the tool 'Poem Generator' is not supported for the input 'AI', I will try to have a helpful conversation with the user.", 'need_use_tool': 'No'}, 'tool': {'name': '', 'args': {}}, 'response': "Sure, I'd love to! Here's a poem about AI:\n\nArtificial intelligence, a marvel of our time,\nA creation of man, a wonder so divine.\nIt learns and adapts, with each passing day,\nA true reflection of our own human way.\nIt can think and reason, and even dream,\nA world of possibilities, or so it seems.\nBut with great power, comes great responsibility,\nTo use it for good, and not for hostility.\nSo let us embrace, this gift of technology,\nAnd use it to build, a better society."}>>> Assistant:Sure, I'd love to! Here's a poem about AI:Artificial intelligence, a marvel of our time,A creation of man, a wonder so divine.It learns and adapts, with each passing day,A true reflection of our own human way.It can think and reason, and even dream,A world of possibilities, or so it seems.But with great power, comes great responsibility,To use it for good, and not for hostility.So let us embrace, this gift of technology,And use it to build, a better societyDie zentrale Designphilosophie von AutoChain kann als „Einfachheit, Anpassung und Automatisierung“ zusammengefasst werden. Die Details sind wie folgt:

(1) Einfach

Im Vergleich zu großen Frameworks wie LangChain strebt AutoChain bewusst eine Vereinfachung in Konzept und Architektur an, um die Lern- und Nutzungskosten für Entwickler so weit wie möglich zu reduzieren. Es abstrahiert den grundlegendsten LLM-Anwendungsentwicklungsprozess und bietet Benutzern einen klaren Entwicklungspfad durch eine Reihe leicht verständlicher Bausteine.

(2) Anpassung

AutoChain erkennt, dass die Anwendungsszenarien, mit denen jeder Entwickler konfrontiert ist, einzigartig sind. Dadurch bietet es Benutzern beispiellose Anpassungsmöglichkeiten, die es ihnen ermöglichen, intelligente Agenten zu erstellen, die durch steckbare Tools, Datenquellen und Entscheidungsprozessmodule spezifische Anforderungen erfüllen. Dieses Konzept zeigt die Aufgeschlossenheit von AutoChain gegenüber „Differenzierung“.

(3) Automatisierung

Als Framework für Dialogsysteme versteht AutoChain die Bedeutung der Szenariosimulation und automatisierten Auswertung. Durch die integrierte Dialogsimulations-Engine können Entwickler die Leistung verschiedener Agentenversionen in verschiedenen Mensch-Computer-Interaktionsszenarien effizient und automatisch bewerten, um sie kontinuierlich zu optimieren und zu iterieren. Diese Innovationsfähigkeit wird zweifellos die Entwicklungseffizienz erheblich verbessern.

Anhand dieser „drei einfachen“ Merkmale fällt es uns nicht schwer, den einzigartigen Charme von AutoChain zu entdecken:

Referenz:

Das obige ist der detaillierte Inhalt vonLesen Sie diesen Artikel, um mehrere gängige LangChain-Alternativen zu verstehen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

Was bedeutet STO in der Blockchain?

Was bedeutet STO in der Blockchain?

So überprüfen Sie die FTP-Serveradresse

So überprüfen Sie die FTP-Serveradresse

Welche Funktion hat Mobiltelefon-NFC?

Welche Funktion hat Mobiltelefon-NFC?

Das Metaverse erkennt die zehn potenziellen Coins

Das Metaverse erkennt die zehn potenziellen Coins

Was ist der Unterschied zwischen Douyin und Douyin Express Edition?

Was ist der Unterschied zwischen Douyin und Douyin Express Edition?

So registrieren Sie sich bei Matcha Exchange

So registrieren Sie sich bei Matcha Exchange