Die Sicherheitsfragen der künstlichen Intelligenz (KI) werden weltweit mit beispielloser Aufmerksamkeit diskutiert.

Bevor der OpenAI-Gründer und Chefwissenschaftler Ilya Sutskever und der Co-Leiter des OpenAI Super Alignment-Teams, Jan Leike, nacheinander OpenAI verließen, veröffentlichte Leike sogar eine Reihe von Beiträgen auf X, in denen er sagte, dass OpenAI und seine Führung die Sicherheit zugunsten des Glamours ignorierten . Brillantes Produkt. Dies hat in der Branche große Aufmerksamkeit erregt und die Ernsthaftigkeit der aktuellen KI-Sicherheitsprobleme in gewissem Maße verdeutlicht.

Am 21. Mai forderte ein im Science-Magazin veröffentlichter Artikel die Staats- und Regierungschefs der Welt auf, stärker gegen die Risiken künstlicher Intelligenz (KI) vorzugehen. In dem Artikel wurde darauf hingewiesen, dass maßgebliche Wissenschaftler und Gelehrte, darunter die Turing-Preisträger Yoshua Bengio, Geoffrey Hinton und Yao Qizhi, der Meinung sind, dass die in den letzten Monaten erzielten Fortschritte nicht ausreichen. Ihrer Ansicht nach entwickelt sich die Technologie der künstlichen Intelligenz rasant weiter, die Entwicklung und Anwendung von KI birgt jedoch viele potenzielle Risiken, darunter Datenschutz, Missbrauch von Waffen der künstlichen Intelligenz und die Auswirkungen künstlicher Intelligenz auf den Arbeitsmarkt. Daher müssen Regierungen die Aufsicht und Gesetzgebung stärken und geeignete Richtlinien formulieren, um die Entwicklung künstlicher Intelligenz zu steuern und zu steuern. Darüber hinaus enthält der Artikel auch

Wir glauben, dass die unkontrollierte Entwicklung der KI letztendlich wahrscheinlich zu einem großen Verlust an Leben und der Biosphäre sowie zur Marginalisierung oder Ausrottung von Menschen führen wird.

Aus ihrer Sicht sind die Sicherheitsprobleme von KI-Modellen auf ein Niveau gestiegen, das ausreicht, um das zukünftige Überleben der Menschheit zu gefährden.

Ebenso ist das Sicherheitsproblem von KI-Modellen zu einem Thema geworden, das jeden betreffen kann und über das sich jeder Sorgen machen muss.

Der 22. Mai wird ein wichtiger Moment in der Geschichte der künstlichen Intelligenz sein: OpenAI, Google, Microsoft und Zhipu AI sowie andere Unternehmen aus verschiedenen Ländern und Regionen haben gemeinsam die Frontier AI Safety Commitments unterzeichnet hat das Gesetz über künstliche Intelligenz (KI-Gesetz) verabschiedet und die weltweit ersten umfassenden KI-Regulierungsvorschriften stehen kurz vor dem Inkrafttreten.

Wieder einmal wird das Sicherheitsproblem der KI auf politischer Ebene erwähnt.

Auf dem „AI Seoul Summit“ mit dem Thema „Sicherheit, Innovation und Inklusion“ versammelten sich Menschen aus Nordamerika, Asien, Europa und dem Nahen Osten 16 Unternehmen in der Region einigten sich auf Sicherheitsverpflichtungen für die KI-Entwicklung und unterzeichneten gemeinsam das Frontier Artificial Intelligence Security Commitment, das die folgenden Punkte umfasst:

Turing-Award-Gewinner Yoshua Bengio glaubt, dass die Unterzeichnung des Frontier Artificial Intelligence Safety Commitment „einen wichtigen Schritt bei der Einrichtung eines internationalen Governance-Systems zur Förderung der Sicherheit künstlicher Intelligenz darstellt.“

Als großes Modellunternehmen aus China hat auch Zhipu AI diese neue Verpflichtung zur Sicherheit im Bereich der künstlichen Intelligenz unterzeichnet. Die vollständige Liste der Unterzeichner lautet wie folgt:

In diesem Zusammenhang OpenAI Vizepräsidentin für globale Angelegenheiten „Die Frontier AI Security Commitments sind ein wichtiger Schritt zur Förderung einer breiteren Implementierung fortschrittlicher KI-Systemsicherheitspraktiken“, sagte Präsidentin Anna Makanju. „Diese Verpflichtungen werden führenden Entwicklern dabei helfen, wichtige, hochmoderne Best Practices für die KI-Sicherheit zu etablieren.“ Zhang Peng, CEO von Zhipu AI, sagte: „Mit fortschrittlicher Technologie geht eine wichtige Verantwortung für die Gewährleistung der KI-Sicherheit einher.“ Kürzlich wurden Zhipu AI auch zur ICLR 2024, der führenden KI-Konferenz, eingeladen und stellten ihre spezifischen Ansätze für KI vor Sicherheit in einer Grundsatzrede mit dem Titel „The ChatGLM's Road to AGI“.

Sie glauben, dass die Superalignment-Technologie dazu beitragen wird, die Sicherheit großer Modelle zu verbessern, und haben einen Superalignment-Plan ähnlich wie OpenAI ins Leben gerufen, in der Hoffnung, dass Maschinen lernen, selbst zu lernen und zu urteilen, um sichere Inhalte zu lernen.

Sie enthüllten, dass in GLM-4V diese Sicherheitsmaßnahmen integriert sind, um schädliches oder unethisches Verhalten zu verhindern und gleichzeitig die Privatsphäre und Datensicherheit der Benutzer zu schützen; und die nachfolgende aktualisierte Version von GLM-4 ist GLM-4.5 und seine Verbesserte Modelle sollten auch auf Superintelligenz und Superausrichtungstechnologie basieren.

Sie enthüllten, dass in GLM-4V diese Sicherheitsmaßnahmen integriert sind, um schädliches oder unethisches Verhalten zu verhindern und gleichzeitig die Privatsphäre und Datensicherheit der Benutzer zu schützen; und die nachfolgende aktualisierte Version von GLM-4 ist GLM-4.5 und seine Verbesserte Modelle sollten auch auf Superintelligenz und Superausrichtungstechnologie basieren.

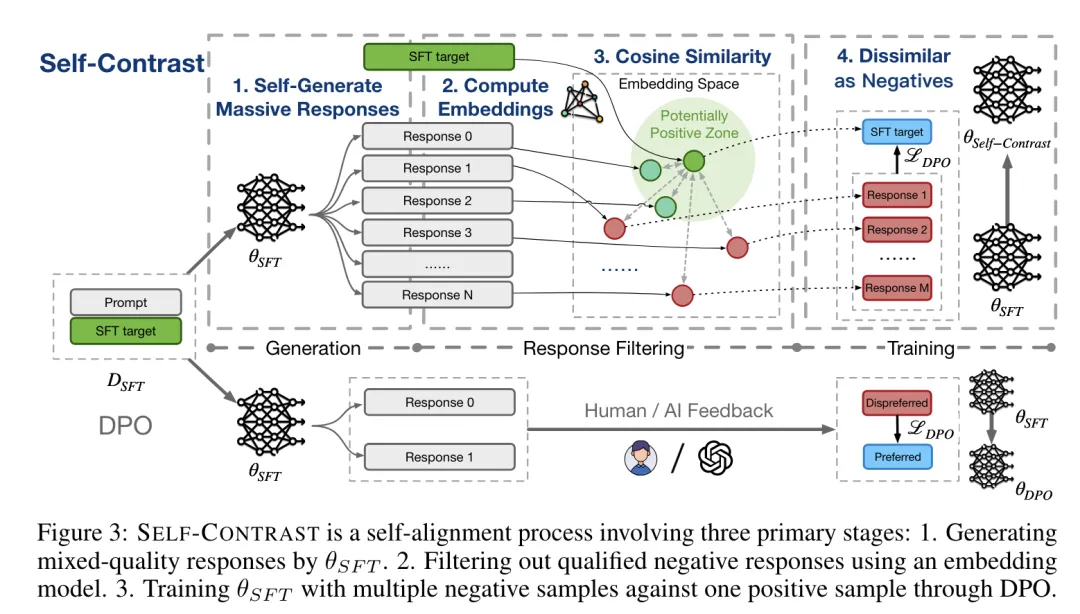

Wir haben außerdem herausgefunden, dass die Teams von Zhipu AI und Tsinghua in einem kürzlich veröffentlichten Artikel eine rückkopplungsfreie Methode zur Ausrichtung großer Sprachmodelle eingeführt haben, die eine große Anzahl selbst generierter negativer Wörter verwendet – Selbstkontrast.

Laut Papierbeschreibung kann Self-Contrast nur mit dem überwachten Feinabstimmungsziel (SFT) LLM selbst verwenden, um eine große Anzahl verschiedener Kandidatenwörter zu generieren, und das vorab trainierte Einbettungsmodell verwenden, um mehrere negative Wörter zu filtern Wörter basierend auf Textähnlichkeit.

Link zum Papier: https://arxiv.org/abs/2404.00604

Experimente zur direkten Präferenzoptimierung (DPO) an drei Datensätzen zeigen, dass Selbstkontrast nachhaltig über SFT und Standard-DPO hinausgehen kann Ausbildung. Darüber hinaus verbessert sich die Leistung von Self-Contrast weiter, wenn die Anzahl der selbst generierten negativen Proben zunimmt.

Insgesamt liefert diese Studie eine neue Methode zur Ausrichtung (z. B. die RLHF-Methode) bei fehlenden Präferenzdaten. Wenn die Annotation von Präferenzdaten teuer und schwer zu erhalten ist, können unbeschriftete SFT-Daten zur Erstellung grammatikalischer Präferenzdaten verwendet werden, um den durch unzureichende positive Stichproben verursachten Leistungsverlust durch Erhöhen der Anzahl negativer Stichproben auszugleichen.

Am selben Tag hat der Rat der Europäischen Union auch das Gesetz über künstliche Intelligenz (KI-Gesetz) offiziell verabschiedet, die weltweit erste umfassende Verordnung Die bahnbrechenden Vorschriften zur künstlichen Intelligenz, die nächsten Monat in Kraft treten und derzeit nur für Bereiche innerhalb des EU-Rechts gelten, könnten einen potenziellen globalen Maßstab für die in der Wirtschaft und im Alltag eingesetzte Technologie setzen.

„Diese wegweisende Verordnung, die erste ihrer Art weltweit, geht auf eine globale technologische Herausforderung ein und schafft gleichzeitig Chancen für unsere Gesellschaft und Wirtschaft“, sagte Mathieu Michel, Minister für Digitalisierung Belgiens, in einer Erklärung.

Diese umfassende KI-Gesetzgebung verfolgt einen „risikobasierten“ Ansatz, d. h. je höher das Risiko eines Schadens für die Gesellschaft, desto strenger die Regeln. Beispielsweise unterliegen allgemeine KI-Modelle, die keine systemischen Risiken bergen, einigen eingeschränkten Anforderungen, wohingegen Modelle, bei denen dies der Fall ist, strengeren Vorschriften unterliegen.

Bußgelder für Verstöße gegen das Gesetz über künstliche Intelligenz, die als Prozentsatz des weltweiten Jahresumsatzes des betreffenden Unternehmens im vorangegangenen Geschäftsjahr oder als vorher festgelegter Betrag festgesetzt werden, je nachdem, welcher Betrag höher ist.

Ob es sich nun um ein kleines Technologieunternehmen oder eine große Regierungsbehörde handelt, steht die Prävention und Lösung von KI-Sicherheitsproblemen auf der Tagesordnung. Wie Philip Torr, Professor für Ingenieurwissenschaften an der Universität Oxford, sagte:

„Auf dem letzten KI-Gipfel war sich die Welt einig, dass wir Maßnahmen ergreifen müssen, aber jetzt ist es an der Zeit, von vagen Empfehlungen zu konkreten Verpflichtungen überzugehen.“ ."

Das obige ist der detaillierte Inhalt vonOpenAI, Microsoft, Zhipu AI und weitere 16 Unternehmen auf der ganzen Welt haben das Frontier Artificial Intelligence Security Commitment unterzeichnet. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

Die übergeordnete Vue-Komponente ruft die Methode der untergeordneten Komponente auf

Die übergeordnete Vue-Komponente ruft die Methode der untergeordneten Komponente auf

http 400 Ungültige Anfrage

http 400 Ungültige Anfrage

Bildschirmsperre;

Bildschirmsperre;

So aktualisieren Sie Douyin

So aktualisieren Sie Douyin

So verwenden Sie die Nanosleep-Funktion

So verwenden Sie die Nanosleep-Funktion

Was bedeutet USB-Schnittstelle?

Was bedeutet USB-Schnittstelle?

Was sind die Oracle-Wildcards?

Was sind die Oracle-Wildcards?