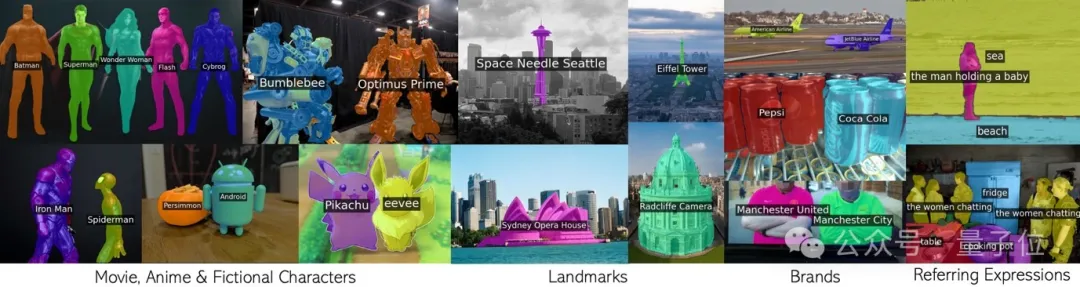

Rufen Sie CLIP in einer Schleife auf, um unzählige Konzepte ohne zusätzliche Schulung effektiv zu segmentieren.

Jede Phrase, einschließlich Filmfiguren, Sehenswürdigkeiten, Marken und allgemeine Kategorien.

Diese neue Errungenschaft des gemeinsamen Teams der Universität Oxford und Google Research wurde von CVPR 2024 akzeptiert und der Code wurde als Open Source bereitgestellt.

Das Team schlug eine neue Technologie namens CLIP as RNN (kurz CaR) vor, die mehrere Schlüsselprobleme im Bereich der Bildsegmentierung mit offenem Vokabular löst:

Um das Prinzip von CaR zu verstehen, müssen Sie zuerst das wiederkehrende neuronale Netzwerk RNN überprüfen.

RNN führt das Konzept des verborgenen Zustands ein, der wie ein „Gedächtnis“ ist, das Informationen aus vergangenen Zeitschritten speichert. Und jeder Zeitschritt hat den gleichen Satz an Gewichten, wodurch Sequenzdaten gut modelliert werden können.

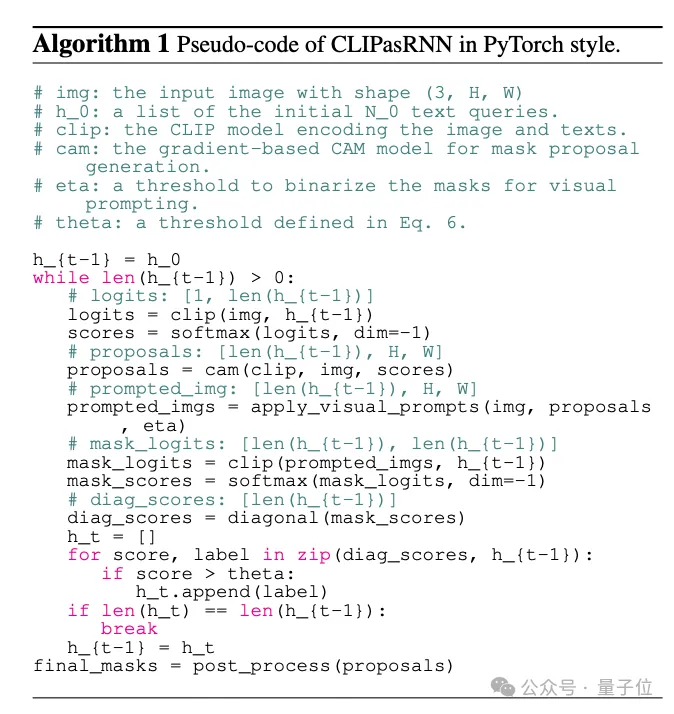

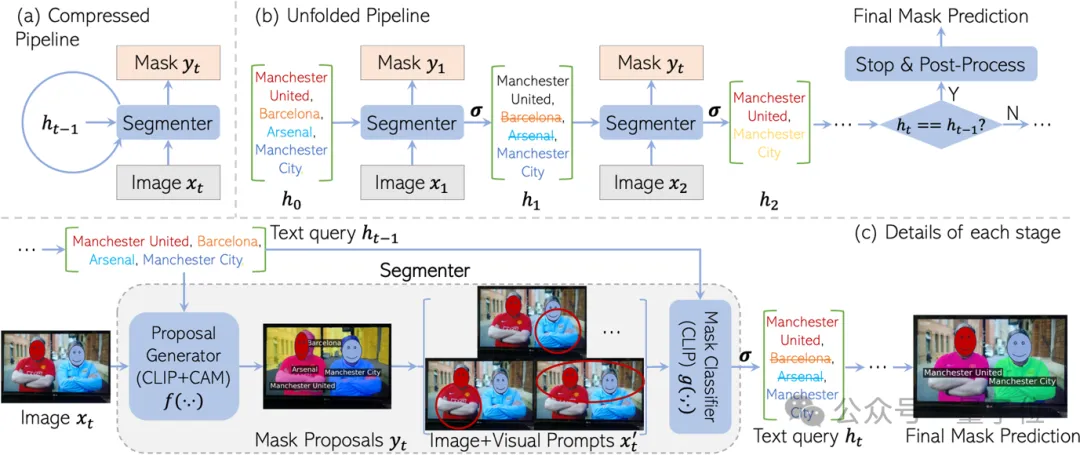

Inspiriert von RNN ist CaR auch als zyklisches Framework konzipiert, das aus zwei Teilen besteht:

Durch die weitere Iteration auf diese Weise wird die Textabfrage immer genauer und die Qualität der Maske wird immer höher.

Wenn sich der Abfragesatz schließlich nicht mehr ändert, kann das endgültige Segmentierungsergebnis ausgegeben werden.

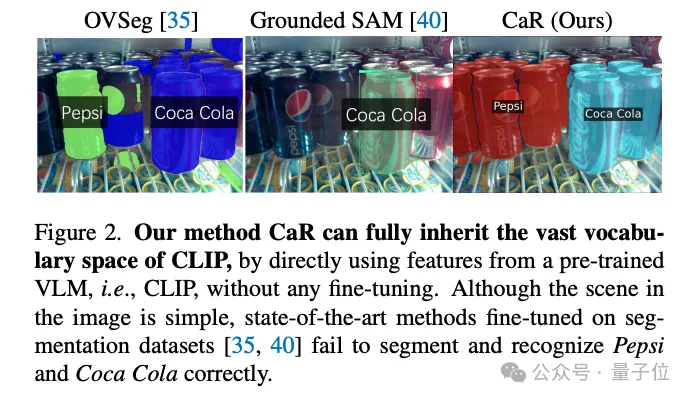

Der Grund für die Entwicklung dieses rekursiven Frameworks besteht darin, das „Wissen“ des CLIP-Vortrainings maximal beizubehalten.

Im CLIP-Vortraining sind viele Konzepte zu sehen, die alles abdecken, von Prominenten über Wahrzeichen bis hin zu Anime-Charakteren. Wenn Sie einen aufgeteilten Datensatz verfeinern, wird der Wortschatz zwangsläufig erheblich schrumpfen.

Zum Beispiel kann das SAM-Modell „Alles teilen“ nur eine Flasche Coca-Cola erkennen, aber nicht einmal eine Flasche Pepsi-Cola.

Aber wenn CLIP direkt zur Segmentierung verwendet wird, ist der Effekt nicht zufriedenstellend.

Das liegt daran, dass das Pre-Training-Ziel von CLIP ursprünglich nicht für eine dichte Vorhersage konzipiert war. Insbesondere wenn bestimmte Textabfragen im Bild nicht vorhanden sind, kann CLIP leicht falsche Masken generieren.

CaR löst dieses Problem geschickt durch Iteration im RNN-Stil. Durch wiederholtes Auswerten und Filtern von Abfragen bei gleichzeitiger Verbesserung der Maske wird schließlich eine qualitativ hochwertige Segmentierung des offenen Vokabulars erreicht.

Lassen Sie uns abschließend der Interpretation des Teams folgen und mehr über die Details des CaR-Frameworks erfahren.

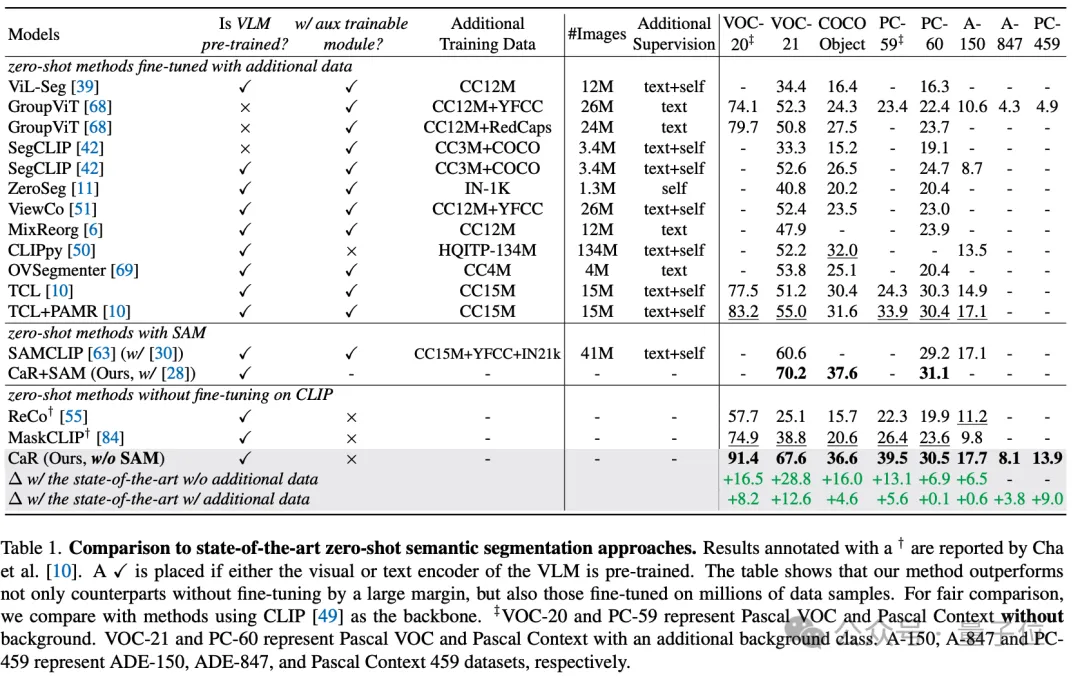

Durch diese technischen Mittel hat die CaR-Technologie erhebliche Leistungsverbesserungen bei mehreren Standarddatensätzen erzielt, die herkömmliche Zero-Shot-Lernmethoden übertreffen, und auch im Vergleich zu Modellen, die einer umfassenden Datenfeinabstimmung unterzogen wurden, eine überlegene Leistung gezeigt. Wie in der folgenden Tabelle gezeigt, ist zwar kein zusätzliches Training und keine Feinabstimmung erforderlich, CaR zeigt jedoch bei acht verschiedenen Indikatoren der semantischen Zero-Shot-Segmentierung eine bessere Leistung als frühere Methoden, die auf zusätzlichen Daten feinabgestimmt wurden.

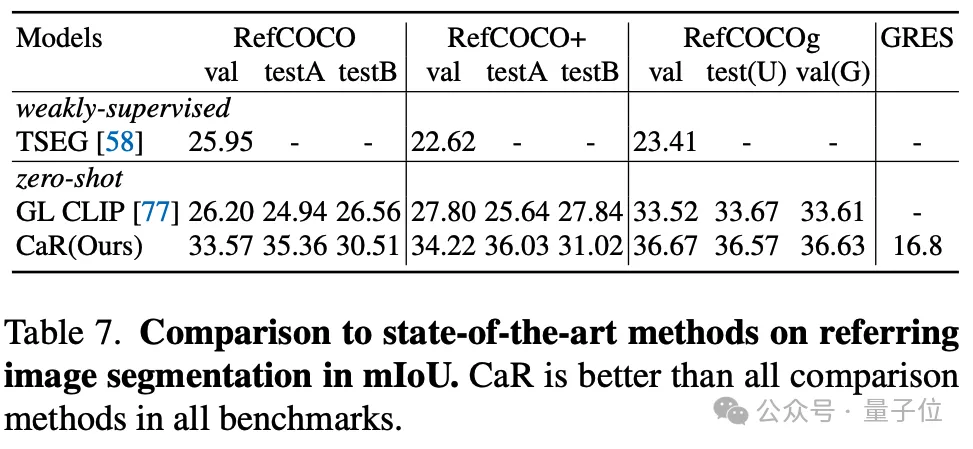

Der Autor testete auch die Wirkung von CaR auf die Nullstichproben-Referenzsegmentierung. Auch die Referenzsegmentierung zeigte eine stärkere Leistung als die vorherige Nullstichprobenmethode.

Zusammenfassend ist CaR (CLIP als RNN) ein innovatives wiederkehrendes neuronales Netzwerk-Framework, das semantische und referenzielle Bildsegmentierungsaufgaben ohne zusätzliche Trainingsdaten effektiv ausführen kann. Es verbessert die Segmentierungsqualität erheblich, indem der breite Vokabularraum vorab trainierter visueller Sprachmodelle erhalten bleibt und ein iterativer Prozess genutzt wird, um die Ausrichtung von Textabfragen mit Maskenvorschlägen kontinuierlich zu optimieren.

Die Vorteile von CaR sind seine Fähigkeit, komplexe Textabfragen ohne Feinabstimmung zu verarbeiten und seine Skalierbarkeit auf den Videobereich, was bahnbrechende Fortschritte im Bereich der Bildsegmentierung mit offenem Vokabular bringt.

Papierlink: https://arxiv.org/abs/2312.07661.

Projekthomepage: https://torrvision.com/clip_as_rnn/.

Das obige ist der detaillierte Inhalt vonCLIP wird als CVPR ausgewählt, wenn es als RNN verwendet wird: Es kann unzählige Konzepte ohne Schulung segmentieren | Oxford University & Google Research. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Wie man unter Linux mit verstümmelten chinesischen Schriftzeichen umgeht

Wie man unter Linux mit verstümmelten chinesischen Schriftzeichen umgeht

Empfohlene Reihenfolge zum Erlernen von C++ und der C-Sprache

Empfohlene Reihenfolge zum Erlernen von C++ und der C-Sprache

So lösen Sie verstümmelte Zeichen in PHP

So lösen Sie verstümmelte Zeichen in PHP

Methode zur Reparatur von Datenbankzweifeln

Methode zur Reparatur von Datenbankzweifeln

Timeout-Lösung für Serveranfragen

Timeout-Lösung für Serveranfragen

IIS unerwarteter Fehler 0x8ffe2740 Lösung

IIS unerwarteter Fehler 0x8ffe2740 Lösung

navigator.useragent

navigator.useragent

So erhalten Sie ein Token

So erhalten Sie ein Token