Die AIxiv-Kolumne ist eine Kolumne, in der diese Website akademische und technische Inhalte veröffentlicht. In den letzten Jahren sind in der AIxiv-Kolumne dieser Website mehr als 2.000 Berichte eingegangen, die Spitzenlabore großer Universitäten und Unternehmen auf der ganzen Welt abdecken und so den akademischen Austausch und die Verbreitung wirksam fördern. Wenn Sie hervorragende Arbeiten haben, die Sie teilen möchten, können Sie gerne einen Beitrag leisten oder uns für die Berichterstattung kontaktieren. E-Mail für die Einreichung: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

Im heutigen digitalen Zeitalter spielen 3D-Assets eine wichtige Rolle bei der Konstruktion des Metaversums, der Realisierung digitaler Zwillinge und der Anwendung von Virtual Reality und Augmented Reality Realität Fördert technologische Innovation und Verbesserung der Benutzererfahrung.

Bestehende 3D-Asset-Generierungsmethoden verwenden normalerweise generative Modelle, um die Materialeigenschaften von Oberflächenstandorten unter voreingestellten Lichtbedingungen auf der Grundlage der räumlich variierenden bidirektionalen Reflexionsverteilungsfunktion (SVBRDF) abzuleiten. Diese Methoden berücksichtigen jedoch selten das starke und reichhaltige Vorwissen, das durch die Wahrnehmung der Menschen über die Oberflächenmaterialien gewöhnlicher Objekte in ihrer Umgebung entsteht (z. B. sollten Autoreifen Metallräder sein, die an der Außenkante mit einem Gummiprofil umwickelt sind) und ignorieren das Material Sollte von der RGB-Farbe des Objekts selbst entkoppelt sein. Ohne die ursprüngliche Bedeutung zu ändern, nutzen die bestehenden 3D-Asset-Generierungsmethoden häufig generative Modelle, die auf der räumlich variierenden bidirektionalen Reflexionsverteilungsfunktion (SVBRDF) basieren, um Materialeigenschaften anhand der Oberflächenpositionen unter vordefinierten Lichtbedingungen abzuleiten. Diese Methoden berücksichtigen jedoch selten die starken und umfangreiches Vorwissen, das Menschen bei der Konstruktion der Oberflächenmaterialien gewöhnlicher Objekte um uns herum haben (z. B. die Tatsache, dass Autoreifen ein Gummiprofil haben sollten, das Metallfelgen an der Außenkante abdeckt), und sie ignorieren die Entkopplung zwischen Material und der RGB-Farbe von Objekte selbst.

Daher ist die Frage, wie das Vorwissen des Menschen über Objektoberflächenmaterialien effektiv in den Materialgenerierungsprozess integriert werden kann und dadurch die Gesamtqualität vorhandener 3D-Assets verbessert werden kann, zu einem wichtigen Thema der aktuellen Forschung geworden.

Kürzlich haben Forschungsteams aus Peking und Hongkong, darunter das Institut für Automatisierung der Chinesischen Akademie der Wissenschaften, die Universität für Post und Telekommunikation Peking und die Polytechnische Universität Hongkong, einen Artikel mit dem Titel „MaterialSeg3D: Segmentierung dichter Materialien aus“ veröffentlicht „2D Priors for 3D Assets“ Der Artikel erstellte den ersten 2D-Materialsegmentierungsdatensatz MIO für mehrere Arten komplexer Materialobjekte, der Materialbeschriftungen auf Pixelebene für einzelne Objekte und verschiedene Kamerawinkel unter mehreren semantischen Kategorien enthält. Diese Forschung schlägt ein Materialgenerierungsschema vor, das 2D-semantische Prioritäten nutzen kann, um auf das Oberflächenmaterial von 3D-Assets im UV-Raum zu schließen – MaterialSeg3D.

Papier: https://arxiv.org/pdf/2404.13923

Codeadresse: https://github.com/PROPHETE-pro/MaterialSeg3D_

Daher konzentriert sich dieser Artikel darauf, wie man Vorkenntnisse über Materialien in 2D-Bildern in die Aufgabe einbringen kann, die Definition von Materialinformationen für 3D-Assets zu lösen.

MIO-Datensatz

In diesem Artikel wird zunächst versucht, Vorkenntnisse zur Materialklassifizierung aus vorhandenen 3D-Asset-Datensätzen zu extrahieren. Aufgrund zu geringer Stichproben im Datensatz und einem einzigen Stil ist es für das Segmentierungsmodell jedoch schwierig, korrekte Vorkenntnisse zu erlernen.

Im Vergleich zu 3D-Assets sind 2D-Bilder häufiger auf öffentlichen Websites oder in Datensätzen verfügbar. Es besteht jedoch eine große Lücke in der Verteilung vorhandener annotierter 2D-Bilddatensätze und 3D-Asset-Renderings und kann nicht direkt ausreichende Vorkenntnisse über Materialien liefern.

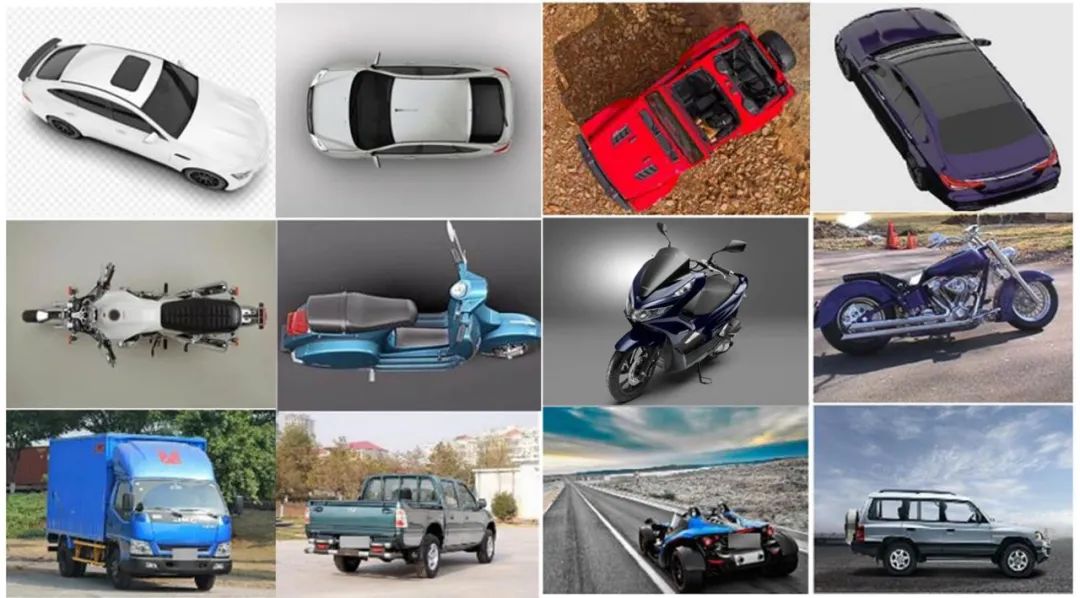

Daher wurde in diesem Artikel ein benutzerdefinierter Datensatz MIO (Materialized Individual Objects) erstellt, der derzeit der größte 2D-Materialsegmentierungsdatensatz für einzelne komplexe Materialressourcen mit mehreren Kategorien ist. Er enthält Bilder, die aus verschiedenen Kamerawinkeln aufgenommen wurden und von a zusammengestellt wurden Professionelles Team. Präzise Notizen.

PBR-Materialkugelkartierung.

Bei der Erstellung dieses Datensatzes folgt dieser Artikel den folgenden Regeln:

Jedes abgetastete Bild enthält nur ein markantes Vordergrundobjekt.

Sammeln Sie eine ähnliche Anzahl realer 2D-Szenenbilder und 3D-Asset-Renderings.

Sammeln Sie Bildbeispiele aus verschiedenen Kamerawinkeln, einschließlich spezieller Perspektiven wie Draufsicht und Unteransicht.

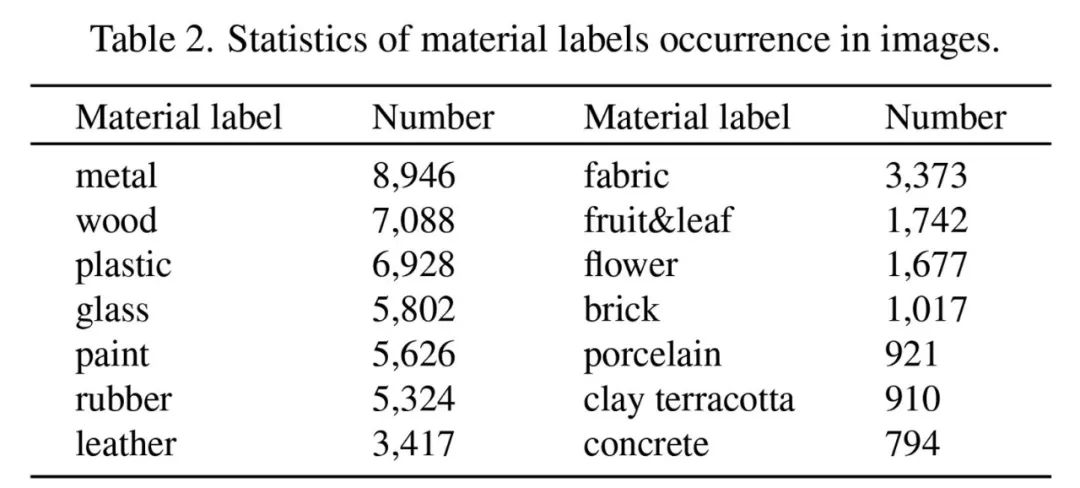

Die Einzigartigkeit des MIO-Datensatzes besteht darin, dass er nicht nur Beschriftungen auf Pixelebene für jede Materialkategorie erstellt, sondern diese auch separat erstellt eine Eins-zu-Eins-Zuordnungsbeziehung zwischen jeder Materialkategorie und dem PBR-Materialwert. Diese Zuordnungsbeziehungen wurden nach Diskussionen zwischen neun professionellen 3D-Modellierern ermittelt. In diesem Artikel wurden mehr als 1.000 echte PBR-Materialbälle aus der öffentlichen Materialbibliothek als Kandidatenmaterialien gesammelt und auf der Grundlage des Fachwissens des Modellierers überprüft und spezifiziert. Schließlich wurden 14 Materialkategorien bestimmt und ihre Zuordnungsbeziehung zum PBR-Material wie folgt ermittelt Der Beschriftungsbereich des Datensatzes.

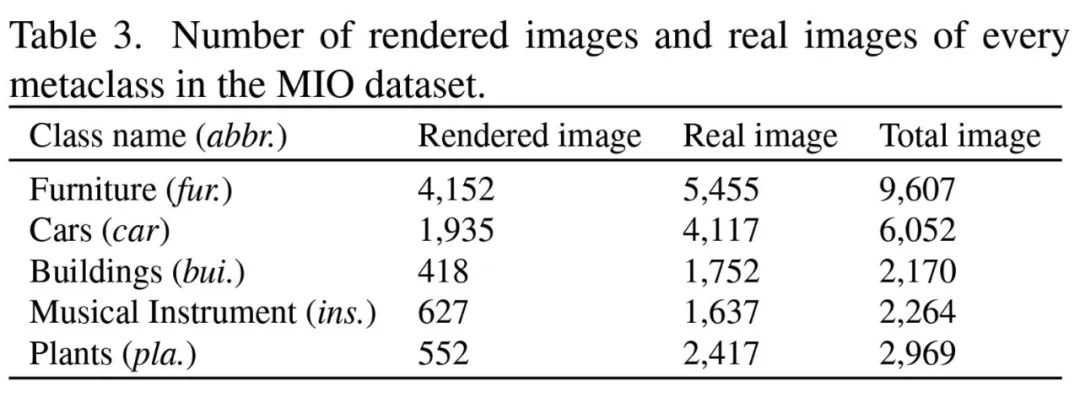

Der MIO-Datensatz enthält insgesamt 23.062 Mehrfachansichtsbilder einzelner komplexer Objekte, die in 5 große Metakategorien unterteilt werden können: Möbel, Autos, Gebäude, Musikinstrumente und Pflanzen in 20 spezifische Kategorien Es ist besonders erwähnenswert, dass der MIO-Datensatz etwa 4000 Draufsichtbilder enthält und eine einzigartige Perspektive bietet, die in vorhandenen 2D-Datensätzen selten zu finden ist. MaterialSeg3D PBR-Materialien auf der Asset-Oberfläche, um die physikalischen Eigenschaften des Objekts, einschließlich Beleuchtung, Schatten und Reflexionen, wirklich zu simulieren, sodass das 3D-Objekt in verschiedenen Umgebungen ein hohes Maß an Authentizität und Konsistenz zeigen kann und vorhandenen 3D-Assets ein hohes Maß an Authentizität und Konsistenz verleiht hohes Maß an Authentizität und Konsistenz Schlagen Sie wirksame Lösungen für das Problem des Mangels an materiellen Informationen vor.

MaterialSeg3D Der gesamte Verarbeitungsablauf umfasst drei Teile: Multi-View-Rendering von 3D-Assets, Materialvorhersage unter Multi-View und 3D-Material-UV-Generierung. In der Multi-View-Rendering-Phase wurden Kamerapositionen für die Draufsicht, Seitenansicht und 12 Rundumwinkel sowie zufällige Neigungswinkel zur Generierung von 2D-gerenderten Bildern bestimmt. In der Materialvorhersagephase wird das auf der Grundlage des MIO-Datensatzes trainierte Materialsegmentierungsmodell verwendet, um Materialbeschriftungen auf Pixelebene für Multi-View-Renderings vorherzusagen. In der Phase der Material-UV-Erzeugung werden die Materialvorhersageergebnisse auf die temporäre UV-Karte abgebildet, und die endgültige Materialetikett-UV wird durch einen gewichteten Abstimmungsmechanismus erhalten und in eine PBR-Materialkarte umgewandelt.

Visualisierte Effekte und Experimente

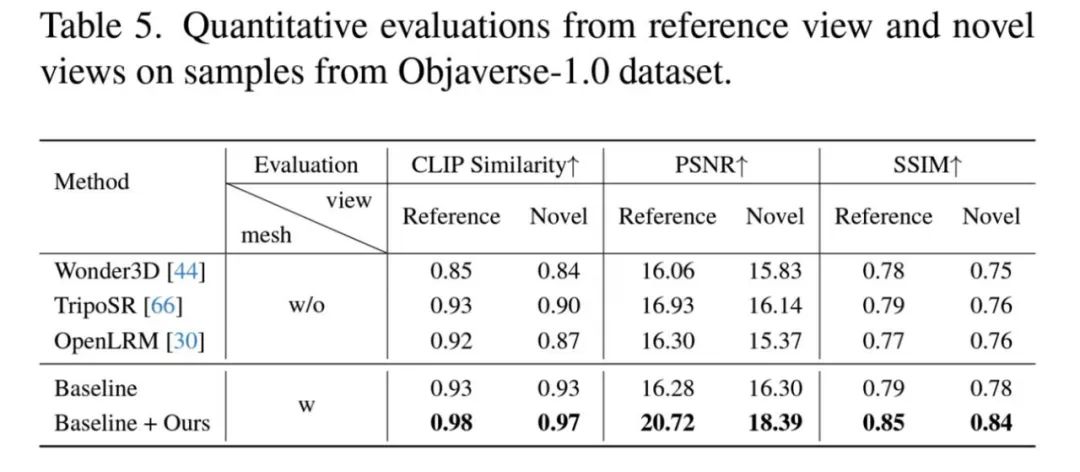

Um die Wirksamkeit von MaterialSeg3D zu bewerten, führt dieser Artikel eine quantitative und qualitative experimentelle Analyse ähnlich der jüngsten Arbeit durch und konzentriert sich dabei auf drei Aspekte: Einzelbild-zu-3D-Asset-Generierungsmethode, Texturgenerierung und öffentliche 3D-Assets. Für Methoden zur Generierung von Einzelbildern bis hin zu 3D-Assets wurden Vergleiche mit Wonder3D, TripoSR und OpenLRM durchgeführt, die eine bestimmte Referenzansicht des Assets als Eingabe verwenden und direkt 3D-Objekte mit Texturmerkmalen generieren. Anhand der visuellen Bilder lässt sich beobachten, dass die von MaterialSeg3D verarbeiteten Assets im Vergleich zu früheren Arbeiten eine deutliche Verbesserung in der realistischen Wiedergabe aufweisen. Der Artikel vergleicht auch bestehende Texturgenerierungsmethoden wie Fantasia3D, Text2Tex und die Online-Funktionalität der Meshy-Website, mit der Texturergebnisse basierend auf Texteingabeinformationen generiert werden können.

Auf dieser Grundlage kann MaterialSeg3D unter verschiedenen Lichtbedingungen genaue PBR-Materialinformationen generieren, wodurch der Rendering-Effekt realistischer wird.

Das quantitative Experiment verwendet CLIP-Ähnlichkeit, PSNR und SSIM als Bewertungsindikatoren, wählt Assets im Objaverse-1.0-Datensatz als Testbeispiele aus und wählt zufällig drei Kamerawinkel als neue Ansichten aus.

Diese Experimente beweisen die Wirksamkeit von MaterialSeg3D. Es kann PBR-Materialinformationen generieren, die in öffentlichen 3D-Assets fehlen, und so hochwertigere Assets für Modellierer und nachfolgende Forschungsarbeiten bereitstellen.

Zusammenfassung und Ausblick

Dieses Papier untersucht das Problem der Oberflächenmaterialgenerierung für 3D-Assets und erstellt einen maßgeschneiderten 2D-Materialsegmentierungsdatensatz MIO. Mit der Unterstützung dieses zuverlässigen Datensatzes wird ein neues Paradigma zur Generierung von 3D-Asset-Oberflächenmaterialien, MaterialSeg3D, vorgeschlagen, das entkoppelte unabhängige PBR-Materialinformationen für ein einzelnes 3D-Asset generieren kann, wodurch die Leistung vorhandener 3D-Assets unter verschiedenen Lichtbedingungen erheblich verbessert wird ist realistisch und vernünftig.

Der Autor weist darauf hin, dass sich die zukünftige Forschung darauf konzentrieren wird, die Anzahl der Objektmetaklassen im Datensatz zu erweitern, die Größe des Datensatzes durch die Generierung von Pseudoetiketten zu erweitern und das Materialsegmentierungsmodell selbst zu trainieren, damit dieses Generationsparadigma dies kann kann direkt auf die meisten Arten von Objekten angewendet werden.

Das obige ist der detaillierte Inhalt vonGute Nachrichten im Bereich der 3D-Asset-Generierung: Die Teams des Institute of Automation und der Beijing University of Posts and Telecommunications schaffen gemeinsam ein neues Paradigma der Materialgenerierung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Verwendung von uniqueResult

Verwendung von uniqueResult

Die PHPStudy-Datenbank kann die Lösung nicht starten

Die PHPStudy-Datenbank kann die Lösung nicht starten

So ermitteln Sie den Maximal- und Minimalwert eines Array-Elements in Java

So ermitteln Sie den Maximal- und Minimalwert eines Array-Elements in Java

Einführung in die Bedeutung von Javascript

Einführung in die Bedeutung von Javascript

So gehen Sie mit blockierten Dateidownloads in Windows 10 um

So gehen Sie mit blockierten Dateidownloads in Windows 10 um

Welche Fensterfunktionen gibt es?

Welche Fensterfunktionen gibt es?

Wie lösche ich den Speicherplatz für WPS-Cloud-Dokumente, wenn er voll ist?

Wie lösche ich den Speicherplatz für WPS-Cloud-Dokumente, wenn er voll ist?

Der Unterschied zwischen ROM und RAM

Der Unterschied zwischen ROM und RAM