Ein tiefer Einblick in das Cloud-Native AI Whitepaper von CNCF

Während der KubeCon EU 2024 veröffentlichte CNCF sein erstes Cloud-Native AI Whitepaper. Dieser Artikel bietet eine ausführliche Analyse des Inhalts dieses Whitepapers.

Im März 2024 veröffentlichte die Cloud-Native Computing Foundation (CNCF) während der KubeCon EU ihr erstes detailliertes Whitepaper zu Cloud-Native Artificial Intelligence (CNAI) 1. Dieser Bericht untersucht ausführlich den aktuellen Stand, die Herausforderungen und zukünftige Entwicklungsrichtungen der Integration von Cloud-nativen Technologien mit künstlicher Intelligenz. In diesem Artikel wird auf den Kerninhalt dieses Whitepapers eingegangen.

Dieser Artikel wird zuerst im mittleren MPP-Plan veröffentlicht. Wenn Sie ein mittlerer Benutzer sind, folgen Sie mir bitte auf mittlerem Niveau. Vielen Dank.

Was ist Cloud-native KI?

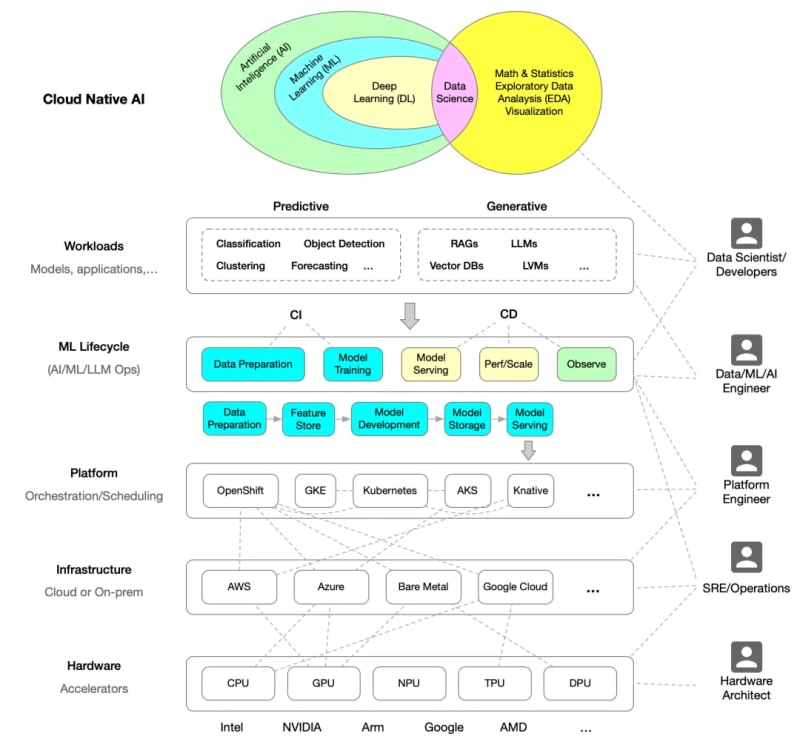

Cloud-native KI bezieht sich auf die Erstellung und Bereitstellung von Anwendungen und Workloads für künstliche Intelligenz unter Verwendung cloudnativer Technologieprinzipien. Dazu gehört die Nutzung von Microservices, Containerisierung, deklarativen APIs und Continuous Integration/Continuous Deployment (CI/CD) neben anderen Cloud-nativen Technologien, um die Skalierbarkeit, Wiederverwendbarkeit und Bedienbarkeit von KI-Anwendungen zu verbessern.

Das folgende Diagramm veranschaulicht die Architektur von Cloud-Native AI, neu gezeichnet auf Basis des Whitepapers.

Beziehung zwischen Cloud-nativer KI und Cloud-nativen Technologien

Cloud-native Technologien bieten eine flexible, skalierbare Plattform, die die Entwicklung und den Betrieb von KI-Anwendungen effizienter macht. Durch Containerisierung und Microservices-Architektur können Entwickler KI-Modelle schnell iterieren und bereitstellen und gleichzeitig eine hohe Verfügbarkeit und Skalierbarkeit des Systems gewährleisten. Kuuch wie Ressourcenplanung, automatische Skalierung und Serviceerkennung.

Das Whitepaper liefert zwei Beispiele, um die Beziehung zwischen Cloud-nativer KI und cloudnativen Technologien zu veranschaulichen, nämlich die Ausführung von KI auf einer cloudnativen Infrastruktur:

- Hugging Face arbeitet mit Microsoft zusammen, um den Hugging Face-Modellkatalog auf Azure zu starten2

- OpenAI skaliert Kubernetes auf 7.500 Knoten3

Herausforderungen der Cloud-Native AI

Obwohl eine solide Grundlage für KI-Anwendungen geschaffen wird, gibt es immer noch Herausforderungen bei der Integration von KI-Workloads in cloudnative Plattformen. Zu diesen Herausforderungen gehören die Komplexität der Datenvorbereitung, der Ressourcenbedarf für das Modelltraining sowie die Aufrechterhaltung der Modellsicherheit und -isolation in Umgebungen mit mehreren Mandanten. Darüber hinaus sind Ressourcenmanagement und -planung in Cloud-nativen Umgebungen für groß angelegte KI-Anwendungen von entscheidender Bedeutung und müssen weiter optimiert werden, um effizientes Modelltraining und Inferenz zu unterstützen.

Entwicklungspfad der Cloud-Native AI

Das Whitepaper schlägt mehrere Entwicklungspfade für Cloud-Native AI vor, darunter die Verbesserung von Ressourcenplanungsalgorithmen zur besseren Unterstützung von KI-Workloads, die Entwicklung neuer Service-Mesh-Technologien zur Verbesserung der Leistung und Sicherheit von KI-Anwendungen sowie die Förderung von Innovation und Standardisierung von Cloud-Native KI-Technologie durch Open-Source-Projekte und Community-Zusammenarbeit.

Cloud-native KI-Technologielandschaft

Cloud-Native AI umfasst verschiedene Technologien, die von Containern und Microservices bis hin zu Service Mesh und Serverless Computing reichen. Kubernetes spielt eine zentrale Rolle bei der Bereitstellung und Verwaltung von KI-Anwendungen, während Service-Mesh-Technologien wie Istio und Envoy robuste Verkehrsmanagement- und Sicherheitsfunktionen bieten. Darüber hinaus sind Überwachungstools wie Prometheus und Grafana von entscheidender Bedeutung für die Aufrechterhaltung der Leistung und Zuverlässigkeit von KI-Anwendungen.

Unten finden Sie das im Whitepaper bereitgestellte Cloud-Native-KI-Landschaftsdiagramm.

- Kubernetes

- Vulkan

- Armada

- Kuberay

- Nvidia NeMo

- Yunikorn

- Kueue

- Flamme

Verteiltes Training

- Kubeflow-Schulungsbetreiber

- Pytorch DDP

- TensorFlow Distributed

- Öffnen Sie MPI

- DeepSpeed

- Megatron

- Horowod

- Apla

- …

ML-Servieren

- Kserve

- Seldon

- VLLM

- TGT

- Skypilot

- …

CI/CD – Lieferung

- Kubeflow-Pipelines

- Mlflow

- TFX

- BentoML

- MLRun

- …

Datenwissenschaft

- Jupyter

- Kubeflow-Notizbücher

- PyTorch

- TensorFlow

- Apache Zeppelin

Beobachtbarkeit der Arbeitslast

- Prometheus

- Influxdb

- Grafana

- Gewichte und Verzerrungen (wandb)

- OpenTelemetry

- …

AutoML

- Hyperopt

- Optuna

- Kubeflow Katib

- NNI

- …

Governance und Politik

- Kyverno

- Kyverno-JSON

- OPA/Gatekeeper

- StackRox Minder

- …

Datenarchitektur

- ClickHouse

- Apache Pinot

- Apache-Druide

- Cassandra

- ScyllaDB

- Hadoop HDFS

- Apache HBase

- Presto

- Trino

- Apache Spark

- Apache Flink

- Kafka

- Pulsar

- Flüssigkeit

- Memcached

- Redis

- Alluxio

- Apache Superset

- …

Vektordatenbanken

- Chroma

- Weaviate

- Quadrant

- Tannenzapfen

- Erweiterungen

- Redis

- Postgres SQL

- ElasticSearch

- …

Modell/LLM-Beobachtbarkeit

- • Trulens

- Langfuse

- Deepchecks

- OpenLLMetry

- …

Abschluss

Abschließend werden die folgenden Kernpunkte zusammengefasst:

- Rolle der Open-Source-Community: Das Whitepaper zeigt die Rolle der Open-Source-Community bei der Weiterentwicklung der Cloud-nativen KI, einschließlich der Beschleunigung von Innovationen und der Kostensenkung durch Open-Source-Projekte und umfassende Zusammenarbeit.

- Bedeutung Cloud-nativer Technologien: Cloud-native KI, die nach Cloud-nativen Prinzipien aufgebaut ist, betont die Bedeutung von Wiederholbarkeit und Skalierbarkeit. Cloud-native Technologien bieten eine effiziente Entwicklungs- und Betriebsumgebung für KI-Anwendungen, insbesondere in Bezug auf Ressourcenplanung und Service-Skalierbarkeit.

- Bestehende Herausforderungen: Obwohl Cloud-Native AI viele Vorteile mit sich bringt, steht es immer noch vor Herausforderungen bei der Datenvorbereitung, den Ressourcenanforderungen für das Modelltraining sowie der Modellsicherheit und -isolation.

- Zukünftige Entwicklungsrichtungen: Das Whitepaper schlägt Entwicklungspfade vor, darunter die Optimierung von Ressourcenplanungsalgorithmen zur Unterstützung von KI-Workloads, die Entwicklung neuer Service-Mesh-Technologien zur Verbesserung von Leistung und Sicherheit sowie die Förderung von Technologieinnovation und Standardisierung durch Open-Source-Projekte und Community-Zusammenarbeit .

- Technologische Schlüsselkomponenten: Zu den Schlüsseltechnologien der Cloud-Native AI gehören unter anderem Container, Microservices, Service Mesh und serverloses Computing. Kubernetes spielt eine zentrale Rolle bei der Bereitstellung und Verwaltung von KI-Anwendungen, während Service-Mesh-Technologien wie Istio und Envoy für die notwendige Verkehrsverwaltung und Sicherheit sorgen.

Für weitere Informationen laden Sie bitte das Whitepaper „Cloud-Native AI“ herunter 4.

Referenzlinks

Whitepaper: ↩︎

Hugging Face arbeitet mit Microsoft zusammen, um den Hugging Face-Modellkatalog auf Azure zu starten ↩︎

OpenAI skaliert Kubernetes auf 7.500 Knoten: ↩︎

Cloud-Native AI Whitepaper: ↩︎

Das obige ist der detaillierte Inhalt vonEin tiefer Einblick in das Cloud-Native AI Whitepaper von CNCF. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1667

1667

14

14

1426

1426

52

52

1328

1328

25

25

1273

1273

29

29

1255

1255

24

24

Golang gegen Python: Leistung und Skalierbarkeit

Apr 19, 2025 am 12:18 AM

Golang gegen Python: Leistung und Skalierbarkeit

Apr 19, 2025 am 12:18 AM

Golang ist in Bezug auf Leistung und Skalierbarkeit besser als Python. 1) Golangs Kompilierungseigenschaften und effizientes Parallelitätsmodell machen es in hohen Parallelitätsszenarien gut ab. 2) Python wird als interpretierte Sprache langsam ausgeführt, kann aber die Leistung durch Tools wie Cython optimieren.

Golang und C: Parallelität gegen Rohgeschwindigkeit

Apr 21, 2025 am 12:16 AM

Golang und C: Parallelität gegen Rohgeschwindigkeit

Apr 21, 2025 am 12:16 AM

Golang ist in Gleichzeitigkeit besser als C, während C bei Rohgeschwindigkeit besser als Golang ist. 1) Golang erreicht durch Goroutine und Kanal eine effiziente Parallelität, die zum Umgang mit einer großen Anzahl von gleichzeitigen Aufgaben geeignet ist. 2) C über Compiler -Optimierung und Standardbibliothek bietet es eine hohe Leistung in der Nähe der Hardware, die für Anwendungen geeignet ist, die eine extreme Optimierung erfordern.

Erste Schritte mit Go: Ein Anfängerführer

Apr 26, 2025 am 12:21 AM

Erste Schritte mit Go: Ein Anfängerführer

Apr 26, 2025 am 12:21 AM

GoisidealforBeginersandSuitableforCloudandNetWorkServicesDuetoitsSimplicity, Effizienz und Konsumfeaturen.1) InstallgoFromTheofficialwebSiteAnDverifyWith'goversion'.2) CreateAneDrunyourFirstProgramwith'gorunhello.go.go.go.

Golang gegen C: Leistung und Geschwindigkeitsvergleich

Apr 21, 2025 am 12:13 AM

Golang gegen C: Leistung und Geschwindigkeitsvergleich

Apr 21, 2025 am 12:13 AM

Golang ist für schnelle Entwicklung und gleichzeitige Szenarien geeignet, und C ist für Szenarien geeignet, in denen extreme Leistung und Kontrolle auf niedriger Ebene erforderlich sind. 1) Golang verbessert die Leistung durch Müllsammlung und Parallelitätsmechanismen und eignet sich für die Entwicklung von Webdiensten mit hoher Konsequenz. 2) C erreicht die endgültige Leistung durch das manuelle Speicherverwaltung und die Compiler -Optimierung und eignet sich für eingebettete Systementwicklung.

Golangs Auswirkungen: Geschwindigkeit, Effizienz und Einfachheit

Apr 14, 2025 am 12:11 AM

Golangs Auswirkungen: Geschwindigkeit, Effizienz und Einfachheit

Apr 14, 2025 am 12:11 AM

GoimpactsDevelopmentPositivyThroughSpeed, Effizienz und DiasMlitication.1) Geschwindigkeit: Gocompilesquickandrunseffiction, idealforlargeProjects

C und Golang: Wenn die Leistung von entscheidender Bedeutung ist

Apr 13, 2025 am 12:11 AM

C und Golang: Wenn die Leistung von entscheidender Bedeutung ist

Apr 13, 2025 am 12:11 AM

C eignet sich besser für Szenarien, in denen eine direkte Kontrolle der Hardware -Ressourcen und hohe Leistungsoptimierung erforderlich ist, während Golang besser für Szenarien geeignet ist, in denen eine schnelle Entwicklung und eine hohe Parallelitätsverarbeitung erforderlich sind. 1.Cs Vorteil liegt in den nahezu Hardware-Eigenschaften und hohen Optimierungsfunktionen, die für leistungsstarke Bedürfnisse wie die Spieleentwicklung geeignet sind. 2. Golangs Vorteil liegt in seiner präzisen Syntax und der natürlichen Unterstützung, die für die Entwicklung einer hohen Parallelitätsdienste geeignet ist.

Golang gegen Python: Schlüsselunterschiede und Ähnlichkeiten

Apr 17, 2025 am 12:15 AM

Golang gegen Python: Schlüsselunterschiede und Ähnlichkeiten

Apr 17, 2025 am 12:15 AM

Golang und Python haben jeweils ihre eigenen Vorteile: Golang ist für hohe Leistung und gleichzeitige Programmierung geeignet, während Python für Datenwissenschaft und Webentwicklung geeignet ist. Golang ist bekannt für sein Parallelitätsmodell und seine effiziente Leistung, während Python für sein Ökosystem für die kurze Syntax und sein reiches Bibliothek bekannt ist.

Golang und C: Die Kompromisse bei der Leistung

Apr 17, 2025 am 12:18 AM

Golang und C: Die Kompromisse bei der Leistung

Apr 17, 2025 am 12:18 AM

Die Leistungsunterschiede zwischen Golang und C spiegeln sich hauptsächlich in der Speicherverwaltung, der Kompilierungsoptimierung und der Laufzeiteffizienz wider. 1) Golangs Müllsammlung Mechanismus ist praktisch, kann jedoch die Leistung beeinflussen.