System-Tutorial

System-Tutorial

LINUX

LINUX

So führen Sie eine stabile Diffusion mit einer leistungsstarken Schul-GPU ohne Root-Zugriff und Netzwerk durch

So führen Sie eine stabile Diffusion mit einer leistungsstarken Schul-GPU ohne Root-Zugriff und Netzwerk durch

So führen Sie eine stabile Diffusion mit einer leistungsstarken Schul-GPU ohne Root-Zugriff und Netzwerk durch

Wie wir alle wissen, kann Stablediffusion normalerweise nicht von Laptop-GPUs gesteuert werden. Es wird gesagt, dass mindestens 4 GB GPUVRAM benötigt werden, aber das reicht nicht aus, wenn man es mit „normaler Geschwindigkeit (1)“ nutzen möchte. Möchten Sie die Cloud nutzen? Einige Cloud-GPU-Mietpreise sind akzeptabel, und das Speichern von Dateien ist in der Regel nicht möglich. Das Öffnen eines Cloud-Speichers ist ein weiterer Kostenfaktor, und die Übertragung von Dateien dorthin und von dort ist mühsam. Deshalb habe ich (hauptsächlich mein Nachhilfelehrer) beschlossen, die GPU aus der Mittelschule zu verwenden, um Geld zu sparen.

(1) Ungefähre Referenz unabhängig von der Geschwindigkeit des GPU-Modells: Meine GPU2GB: 3 Minuten für ein Bild Linux verwendet einen Proxyserver Linux-Systemprogrammierung, Freund AGPU6GB: 50 Sekunden für ein Bild, Freund BGPU32GB: 2S für ein Bild...

Die GPU-Leistung in der Mittelschule ist ziemlich gut. Es ist das private Linux-Rezept von Bruder Niao und es gibt keine Root-Berechtigungen! Der Treiber möchte nicht aktualisiert werden, bevor er ihn für Sie aktualisieren kann! Was noch ärgerlicher ist, ist, dass der Computer, zu dem ich eine Verbindung herstelle, über einen Proxy mit dem Internet verbunden sein muss (das ist das größte Problem, das mir beim Herunterladen der SD begegnet ist).

Da ich noch niemanden gesehen habe, der SD mit Linuxconda installiert hat, um verschiedene Root-Berechtigungsprobleme + Proxy-Probleme zu umgehen, werde ich unten meine Erfahrungen mit der Stablediffusionwebui-Installation teilen. Diese Erfahrung sollte auch für Kollegen gelten, die Linuxconda ohne Berechtigungen und Proxy-Probleme benötigen.

*Mein Rechner ist LinuxCentOS (Redhat), NVidiaGPU

** Mit der Installation von SD meine ich die Installation der beliebten AUTOMATIC1111-Webgui auf Github:

***Ich bin in den Vereinigten Staaten

****Ich bin kein CS-Student, wenn es Ihnen nicht gefällt, kritisieren Sie mich bitte nicht

Installationsvoraussetzung:(1) Ist die GPU groß genug (mindestens 4 GB Videospeicher)? Wenn nicht, machen Sie sich nicht die Mühe, gehen Sie zu Huggingface und verwenden Sie die kostenlose Beggar-Version (mit freundlichen Grüßen).

(2) Bitte überprüfen Sie die CUDAdrive-Version Ihrer Maschine (da meiner Erfahrung nach 10 oder mehr verwendet werden sollten, egal welche Torchcuda-Kombination verwendet wird ... CUDA11 und höher sind gut kompatibel). Die von mir installierte Taschenlampe ist an cu117 angepasst, obwohl ich sie unter 11.2 verwenden kann. (Wenn Sie Torch früher installiert haben und Probleme mit der CUDA-Versionskompatibilität haben, können Sie verschiedene Versionskombinationen ausprobieren und den Download-Pfad in launch.py ändern)

<code class=" language-javascript"></code>

2. Da ich keine Root-Berechtigungen zum Herunterladen verschiedener Pakete habe, muss ich Conda verwenden (in meinem Fall muss ich Miniconda verwenden). Als konkrete Referenz geht es hier tatsächlich darum, das Anaconda/Miniconda-Installationspaket (wget oder so) automatisch herunterzuladen und zu installieren

3. Erstellen Sie nach dem Herunterladen Ihre Conda-Umgebung (Python3.10.6 ist erforderlich)

<code class=" language-javascript"></code>

4. (Partner, die keine Proxy-Netzwerkverbindung einrichten müssen, können diesen Schritt weglassen) Im Allgemeinen können Sie zu diesem Zeitpunkt mit dem Herunterladen beginnen, und Partner, die einen Netzwerk-Proxy einrichten müssen, müssen möglicherweise prüfen, ob dies der Fall ist Folgende Einstellungen an folgenden Stellen:

~/.bashrc (Einrichten der Umgebung, verantwortlich für die Vernetzung im üblichen Sinne ...)

<code class=" language-javascript"></code>

~/.condarc (verantwortlich für Netzwerke wie condainstall...normalerweise an diesem Ort)

<code class=" language-javascript"></code>

Git-Networking

<code class=" language-javascript"></code>

Außerdem muss pipinstall, das zum Herunterladen verschiedener Pakete benötigt wird, mit dem Internet verbunden sein. Sie befinden sich in der Datei launch.py:

Die erste Stelle, die geändert werden muss, ist über defrun_pip, etwa Zeile 129

<code class=" language-javascript"></code>

Der zweite Ort, der geändert werden muss, ist das Herunterladen des Torch in defprepare_environment, das sich etwa in Zeile 228 befindet

<code class=" language-javascript"></code>

5. Anschließend können Sie theoretisch mit dem Download beginnen, Sie benötigen jedoch nur:

<code class=" language-javascript"></code>

* Hinweis hier: Obwohl Sie zur Installation bashwenui.sh verwenden, verwenden Sie die virtuelle Umgebung von Python, um launch.py im selben Verzeichnis zu installieren. Früher dachte ich, da es bei Conda möglicherweise keinen großen Unterschied gibt, habe ich launch.py direkt ausgeführt und daneben sind viele seltsame Fehler aufgetreten, die dazu geführt haben, dass ich die Umgebung viele Male neu konfiguriert habe. Daher empfehle ich dringend, es auch in zu verwenden conda.bashwebui.sh ermöglicht die Installation in der virtuellen Python-Umgebung. Führen Sie launch.py nicht direkt aus

Aber für mich hat meine Reise in die Fallstricke gerade erst begonnen. . .Im Folgenden sind einige meiner Fallstricke und Problemumgehungen aufgeführt (nur Erfahrungsaustausch

Linux verwendet einen Proxyserver, meine Lösung macht keinen Sinn und funktioniert am Ende! Haha!)

1. Schwierig, gfpgan herunterzuladen„RuntimeError:Couldn'tinstallgfpgan.“

Ich fürchte, es ist ein Proxy-Problem, aber ich weiß nicht, was los ist. (Wer dieses Problem im Ausland hat, kann sich darauf beziehen. Es könnte sich um ein [Internet-]Problem handeln.)

Meine Lösung: Kommentieren Sie zuerst den gfpgan-Downloadcode in launch.py aus

<code class=" language-javascript"></code>

<code class=" language-javascript"></code>

Wenn es immer noch nicht funktioniert, werfen wir einen Blick auf den Fehlerbericht und ergänzen, was fehlt. Ich habe versucht, Numpy in Conda neu zu installieren, Pip, Git, Setuptools, Cython zu aktualisieren ... und schließlich hat es funktioniert (ich denke, Git ist besser als numpy) Wichtig), obwohl es immer noch automatisch installiert wird, ist es besser, als es nicht verwenden zu können.

Referenz:

2. Beim Herunterladen von StableDiffusion von Stabilityai ist ein Fehler aufgetreten

„RuntimeError:Couldn'tdetermineStableDiffusion'shash“bei der Installation

Meine Lösung: Git in Conda aktualisieren (ich habe früher 1.8 verwendet und es ist in Ordnung, wenn ich auf 2 aktualisiere.)

Referenz:

Zu diesem Zeitpunkt gibt es keine Probleme beim Herunterladen des Modells. Es folgen einige weitere einfache Fehler:

3. Da auf den Localhost der Maschine, die ich verwende, nicht zugegriffen werden kann, muss ich externe Links generieren

Wertfehler: Wenn auf den lokalen Host nicht zugegriffen werden kann, muss ein gemeinsam nutzbarer Link erstellt werden. Bitte setzen Sie share=True.

Meine Lösung: Entfernen Sie die Kommentare und fügen Sie --share in webui-user.sh hinzu und führen Sie webui-user.sh erneut aus

<code class=" language-javascript"></code>

Auf diese Weise können Sie den externen Link von Gradio verwenden, um auf die Webgui zuzugreifen

4. Die Weboberfläche kann geöffnet werden und es ist schwierig, Bilder zu generieren, und der Fehler SomethingwentwrongExpectingvalue: line1column1(char0)

Meine Lösung: Ich habe gehört, dass es gut wäre, den Agenten auszuschalten, aber ich kann ihn nicht ausschalten. . . Ähnlich wie bei der vorherigen Frage fügen Sie einfach --no-gradio-queue hinzu und führen Sie webui-user.sh

aus

<code class=" language-javascript"></code>

Referenz:

Du kannst dich gerne über deine Erfahrungen mit Stablediffusion und anderen Generativen austauschen!

Das obige ist der detaillierte Inhalt vonSo führen Sie eine stabile Diffusion mit einer leistungsstarken Schul-GPU ohne Root-Zugriff und Netzwerk durch. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Mastering Textmanipulation mit dem SED -Befehl

Mar 16, 2025 am 09:48 AM

Mastering Textmanipulation mit dem SED -Befehl

Mar 16, 2025 am 09:48 AM

Mastering Textmanipulation mit dem SED -Befehl

PILET: Ein modularer, tragbarer Mini-Computer von Raspberry Pi angetrieben

Mar 06, 2025 am 10:11 AM

PILET: Ein modularer, tragbarer Mini-Computer von Raspberry Pi angetrieben

Mar 06, 2025 am 10:11 AM

PILET: Ein modularer, tragbarer Mini-Computer von Raspberry Pi angetrieben

Linux -Kernel -Quellcode übertrifft 40 Millionen Zeilen

Mar 05, 2025 am 09:35 AM

Linux -Kernel -Quellcode übertrifft 40 Millionen Zeilen

Mar 05, 2025 am 09:35 AM

Linux -Kernel -Quellcode übertrifft 40 Millionen Zeilen

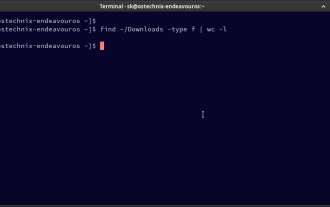

So zählen Sie Dateien und Verzeichnisse unter Linux: Ein Anfängerhandbuch

Mar 19, 2025 am 10:48 AM

So zählen Sie Dateien und Verzeichnisse unter Linux: Ein Anfängerhandbuch

Mar 19, 2025 am 10:48 AM

So zählen Sie Dateien und Verzeichnisse unter Linux: Ein Anfängerhandbuch

Die geheime Waffe, um Ihr Linux -System mit Liquorix -Kernel zu beenden

Mar 08, 2025 pm 12:12 PM

Die geheime Waffe, um Ihr Linux -System mit Liquorix -Kernel zu beenden

Mar 08, 2025 pm 12:12 PM

Die geheime Waffe, um Ihr Linux -System mit Liquorix -Kernel zu beenden

Erstellen Sie Ihre eigene Ubuntu Personal Cloud: eine Schritt-für-Schritt-Anleitung zum Erstellen eines sicheren Datenhauss

Mar 05, 2025 am 11:02 AM

Erstellen Sie Ihre eigene Ubuntu Personal Cloud: eine Schritt-für-Schritt-Anleitung zum Erstellen eines sicheren Datenhauss

Mar 05, 2025 am 11:02 AM

Erstellen Sie Ihre eigene Ubuntu Personal Cloud: eine Schritt-für-Schritt-Anleitung zum Erstellen eines sicheren Datenhauss

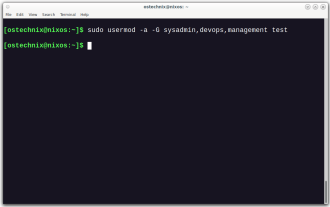

So fügen Sie einen Benutzer zu mehreren Gruppen unter Linux hinzu

Mar 18, 2025 am 11:44 AM

So fügen Sie einen Benutzer zu mehreren Gruppen unter Linux hinzu

Mar 18, 2025 am 11:44 AM

So fügen Sie einen Benutzer zu mehreren Gruppen unter Linux hinzu

System76 führt Meerkat Mini PC ein: Große Leistung in einem winzigen Paket

Mar 05, 2025 am 10:28 AM

System76 führt Meerkat Mini PC ein: Große Leistung in einem winzigen Paket

Mar 05, 2025 am 10:28 AM

System76 führt Meerkat Mini PC ein: Große Leistung in einem winzigen Paket