Die offene LLM-Community ist eine Ära, in der hundert Blumen blühen und konkurrieren. Sie können Llama-3-70B-Instruct, QWen2-72B-Instruct, Nemotron-4-340B-Instruct, Mixtral-8x22BInstruct-v0.1 und sehen viele weitere hervorragende Leistungen. Allerdings weisen offene Modelle im Vergleich zu den proprietären Großmodellen GPT-4-Turbo in vielen Bereichen noch deutliche Lücken auf.

Zusätzlich zu allgemeinen Modellen wurden einige offene Modelle entwickelt, die sich auf Schlüsselbereiche spezialisieren, wie z. B. DeepSeek-Coder-V2 für Programmierung und Mathematik, InternVL 1.5 für visuell-sprachliche Aufgaben (das in einigen Bereichen vergleichbar mit GPT ist). 4-Turbo-2024-04-09).

Als „Schaufelkönig der KI-Goldrausch-Ära“ leistet NVIDIA selbst auch Beiträge zum Bereich der offenen Modelle, wie zum Beispiel der von ihm entwickelten Modellreihe ChatQA. Bitte beachten Sie den Bericht auf dieser Seite “ NVIDIAs neues Dialog-QA-Modell ist genauer als GPT-4, aber ich wurde kritisiert: Ungewichteter Code hat wenig Bedeutung.》. Anfang dieses Jahres wurde ChatQA 1.5 veröffentlicht, das die RAG-Technologie (Retrieval-Augmented Generation) integriert und GPT-4 bei der Beantwortung von Konversationsfragen übertrifft.

Jetzt wurde ChatQA auf Version 2.0 weiterentwickelt. Die Hauptrichtung der Verbesserung besteht dieses Mal darin, das Kontextfenster zu erweitern.

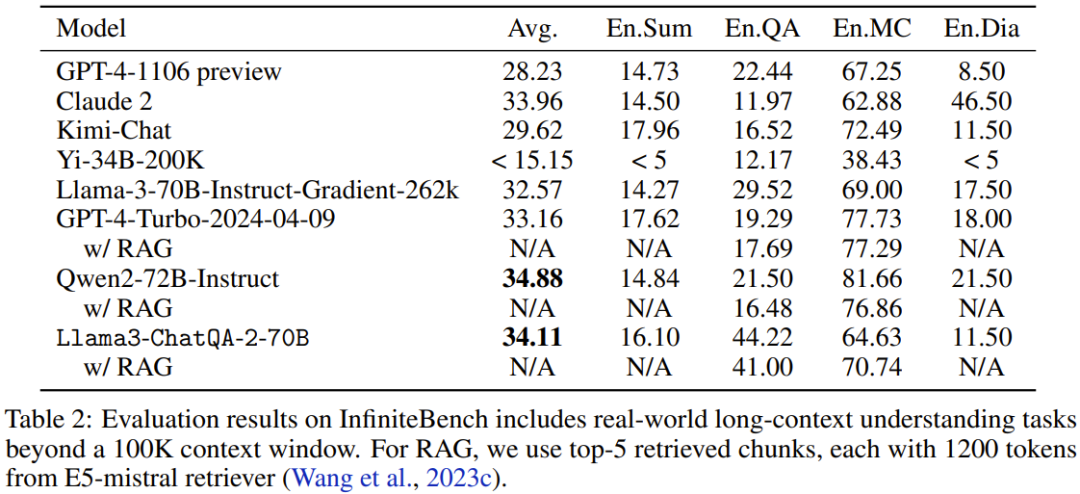

Papiertitel: ChatQA 2: Bridging the Gap to Proprietary LLMs in Long Context and RAG Capabilities

Papieradresse: https://arxiv.org/pdf/2407.14482

Vor Kurzem, Die Erweiterung der Kontextfensterlänge von LLM ist ein wichtiger Forschungs- und Entwicklungs-Hotspot. Diese Website berichtete beispielsweise einmal „Direkt auf unendliche Länge erweitern, Google Infini-Transformer beendet die Kontextlängendebatte“ .

Alle führenden proprietären LLMs unterstützen sehr große Kontextfenster – Sie können Hunderte von Textseiten in einer einzigen Eingabeaufforderung eingeben. Beispielsweise betragen die Kontextfenstergrößen von GPT-4 Turbo und Claude 3.5 Sonnet 128 KB bzw. 200 KB. Gemini 1.5 Pro kann einen Kontext mit einer Länge von 10 Mio. unterstützen, was erstaunlich ist.

Aber auch große Open-Source-Modelle holen auf. QWen2-72B-Instruct und Yi-34B unterstützen beispielsweise 128 KB bzw. 200 KB Kontextfenster. Allerdings sind die Trainingsdaten und technischen Details dieser Modelle nicht öffentlich verfügbar, was ihre Reproduktion erschwert. Darüber hinaus basiert die Bewertung dieser Modelle meist auf synthetischen Aufgaben und kann die Leistung bei realen Downstream-Aufgaben nicht genau darstellen. Mehrere Studien haben beispielsweise gezeigt, dass es immer noch eine erhebliche Lücke zwischen offenem LLM und führenden proprietären Modellen für reale Langzeitkontextverständnisaufgaben gibt.

Und dem NVIDIA-Team gelang es, die Leistung des offenen Llama-3 bei realen Langzeitkontextverständnisaufgaben mit dem proprietären GPT-4 Turbo gleichzuziehen.

In der LLM-Community werden Long-Context-Funktionen manchmal als eine Technologie angesehen, die mit RAG konkurriert. Aber realistisch gesehen können sich diese Technologien gegenseitig ergänzen.

Für LLM mit einem langen Kontextfenster können Sie abhängig von den nachgelagerten Aufgaben und dem Kompromiss zwischen Genauigkeit und Effizienz in Betracht ziehen, eine große Textmenge an die Eingabeaufforderung anzuhängen, oder Sie können Abrufmethoden verwenden, um relevante Informationen effizient daraus zu extrahieren eine große Textmenge. RAG hat klare Effizienzvorteile und kann für abfragebasierte Aufgaben problemlos relevante Informationen aus Milliarden von Token abrufen. Dies ist ein Vorteil, den lange Kontextmodelle nicht haben können. Andererseits eignen sich Modelle mit langem Kontext sehr gut für Aufgaben wie die Zusammenfassung von Dokumenten, für die RAG möglicherweise nicht gut geeignet ist.

Daher sind für ein fortgeschrittenes LLM beide Fähigkeiten erforderlich, sodass eine davon basierend auf den nachgelagerten Aufgaben und Genauigkeits- und Effizienzanforderungen berücksichtigt werden kann.

Zuvor konnte NVIDIAs Open-Source-Modell ChatQA 1.5 GPT-4-Turbo bei RAG-Aufgaben übertreffen. Aber das ist noch nicht alles. Jetzt verfügen sie über Open-Source-ChatQA 2, das auch Funktionen zum Verständnis langer Kontexte integriert, die mit GPT-4-Turbo vergleichbar sind!

Konkret basieren sie auf dem Llama-3-Modell, erweitern dessen Kontextfenster auf 128 KB (auf Augenhöhe mit GPT-4-Turbo) und statten es gleichzeitig mit dem besten derzeit verfügbaren Long Context Retriever aus.

Erweitern Sie das Kontextfenster auf 128K.

Wie hat NVIDIA also das Kontextfenster von Llama-3 von 8K auf 128K vergrößert? Zunächst erstellten sie ein langes Kontext-Pre-Training-Korpus auf der Grundlage von Slimpajama und verwendeten dabei die Methode aus dem Artikel „Data Engineering for scaling language models to 128k context“ von Fu et al.

Sie haben während des Trainingsprozesses auch eine interessante Entdeckung gemacht: Im Vergleich zur Verwendung der ursprünglichen Start- und End-Tokens zur Trennung verschiedener Dokumente eine bessere Wirkung. Sie spekulieren, dass der Grund darin liegt, dass die

Verwendung langer Kontextdaten zur Feinabstimmung von Anweisungen

Das Team hat außerdem eine Methode zur Feinabstimmung von Anweisungen entwickelt, die gleichzeitig die Fähigkeiten des Modells zum Verständnis langer Kontexte und die RAG-Leistung verbessern kann.

Konkret ist diese Methode zur Feinabstimmung der Anleitung in drei Phasen unterteilt. Die ersten beiden Phasen sind die gleichen wie in ChatQA 1.5, d. h. zuerst wird das Modell auf dem hochwertigen 128K-Datensatz zur Befehlskonformität trainiert und dann auf einer Mischung aus Gesprächs-Q&A-Daten und bereitgestelltem Kontext trainiert. Allerdings sind die in beiden Phasen beteiligten Kontexte relativ kurz – die maximale Sequenzlänge beträgt nicht mehr als 4K-Tokens. Um die Größe des Kontextfensters des Modells auf 128.000 Token zu erhöhen, sammelte das Team einen Long-Supervised-Fine-Tuning-Datensatz (SFT).

Es werden zwei Erfassungsmethoden angewendet:

1. Für SFT-Datensequenzen, die kürzer als 32.000 sind: Verwendung vorhandener langer Kontextdatensätze basierend auf LongAlpaca12k, GPT-4-Proben von Open Orca und Long Data Collections.

2. Für Daten mit Sequenzlängen zwischen 32k und 128k: Aufgrund der Schwierigkeit, solche SFT-Proben zu sammeln, wählten sie synthetische Datensätze. Sie verwendeten NarrativeQA, das sowohl die Grundwahrheit als auch semantisch relevante Absätze enthält. Sie stellten alle relevanten Absätze zusammen und fügten nach dem Zufallsprinzip echte Zusammenfassungen ein, um wirklich lange Dokumente für Frage- und Antwortpaare zu simulieren.

Dann werden der in den ersten beiden Phasen erhaltene SFT-Datensatz voller Länge und der kurze SFT-Datensatz miteinander kombiniert und dann trainiert. Hier ist die Lernrate auf 3e-5 und die Stapelgröße auf 32 eingestellt.

Long Context Retriever trifft auf Long Context LLM

Es gibt einige Probleme mit dem RAG-Prozess, der derzeit von LLM verwendet wird:

1 Um genaue Antworten zu generieren, führt der Top-k-Block-für-Block-Abruf nicht- vernachlässigbare Kontextfragmente. Beispielsweise unterstützten frühere hochmoderne Retriever, die auf dichter Einbettung basieren, nur 512 Token.

2. Ein kleiner Top-K (z. B. 5 oder 10) führt zu einer relativ niedrigen Rückrufrate, während ein großer Top-K (z. B. 100) zu schlechten Generierungsergebnissen führt, da das vorherige LLM nicht gut verwendet werden kann . Gestückelter Kontext.

Um dieses Problem zu lösen, schlägt das Team vor, den neuesten Long Context Retriever zu verwenden, der Tausende von Token unterstützt. Konkret entschieden sie sich für die Verwendung des E5-Mistral-Einbettungsmodells als Retriever.

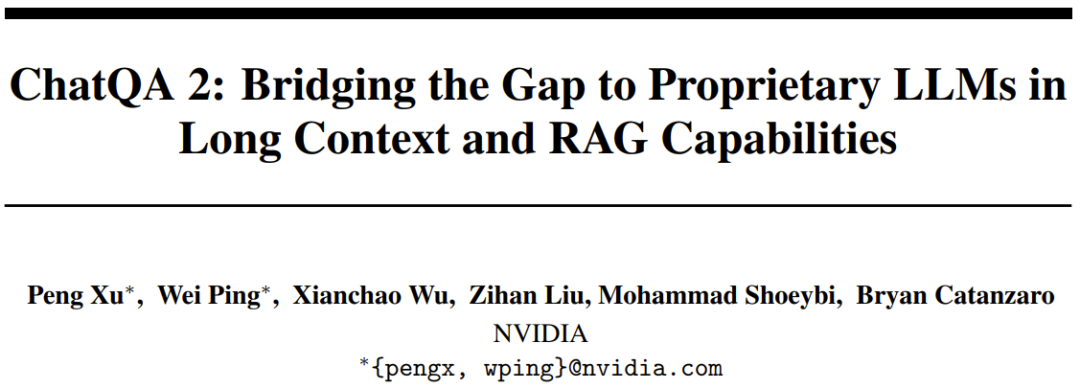

Tabelle 1 vergleicht den Top-K-Abruf für verschiedene Blockgrößen und die Gesamtzahl der Token im Kontextfenster.

Beim Vergleich der Änderungen in der Anzahl der Token von 3000 auf 12000 stellte das Team fest, dass die Ergebnisse umso besser waren, je mehr Token vorhanden waren, was bestätigte, dass die Langzeitkontextfähigkeit des neuen Modells tatsächlich gut ist. Sie fanden außerdem heraus, dass es einen besseren Kompromiss zwischen Kosten und Leistung gibt, wenn die Gesamtzahl der Token 6000 beträgt. Als die Gesamtzahl der Token auf 6000 festgelegt wurde, stellten sie fest, dass die Ergebnisse umso besser waren, je größer der Textblock war. Daher wählten sie in ihren Experimenten als Standardeinstellungen eine Blockgröße von 1200 und Top-5-Textblöcke.

Experimente

Bewertungsbenchmarks

Um eine umfassende Bewertung durchzuführen und verschiedene Kontextlängen zu analysieren, verwendete das Team drei Arten von Bewertungsbenchmarks:

1. Lange Kontextbenchmarks, mehr als 100.000 Token;

2. Mittellanger Kontext-Benchmark, weniger als 32.000 Token;

3. Kurzer Kontext-Benchmark, weniger als 4.000 Token.

Wenn eine Downstream-Aufgabe RAG verwenden kann, wird sie RAG verwenden.

Ergebnisse

Das Team führte zunächst einen „Nadel im Heuhaufen“-Test auf Basis synthetischer Daten durch und testete dann das reale Langzeitkontextverständnis und die RAG-Fähigkeiten des Modells.

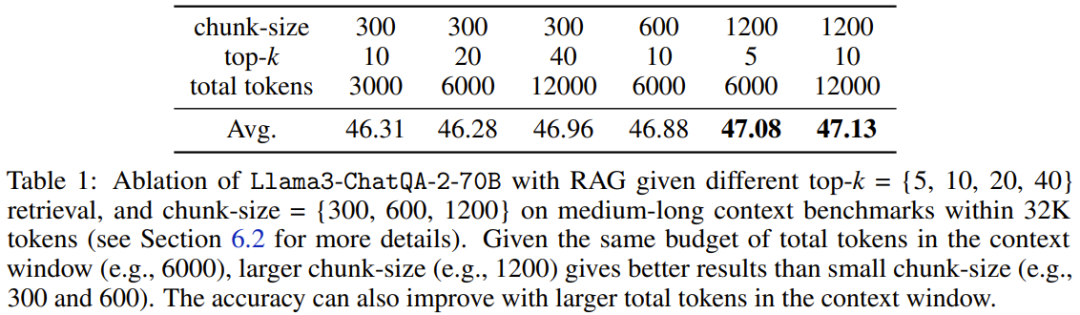

1. Die Nadel im Heuhaufen-Test

Llama3-ChatQA-2-70B Kannst du die Zielnadel im Textmeer finden? Dies ist eine synthetische Aufgabe, die üblicherweise zum Testen der Langkontextfähigkeit von LLM verwendet wird und als Beurteilung des Schwellenwerts von LLM angesehen werden kann. Abbildung 1 zeigt die Leistung des neuen Modells in 128.000 Token. Es ist ersichtlich, dass die Genauigkeit des neuen Modells 100 % erreicht. Dieser Test bestätigte, dass das neue Modell über perfekte Fähigkeiten zum Abrufen langer Kontexte verfügt.

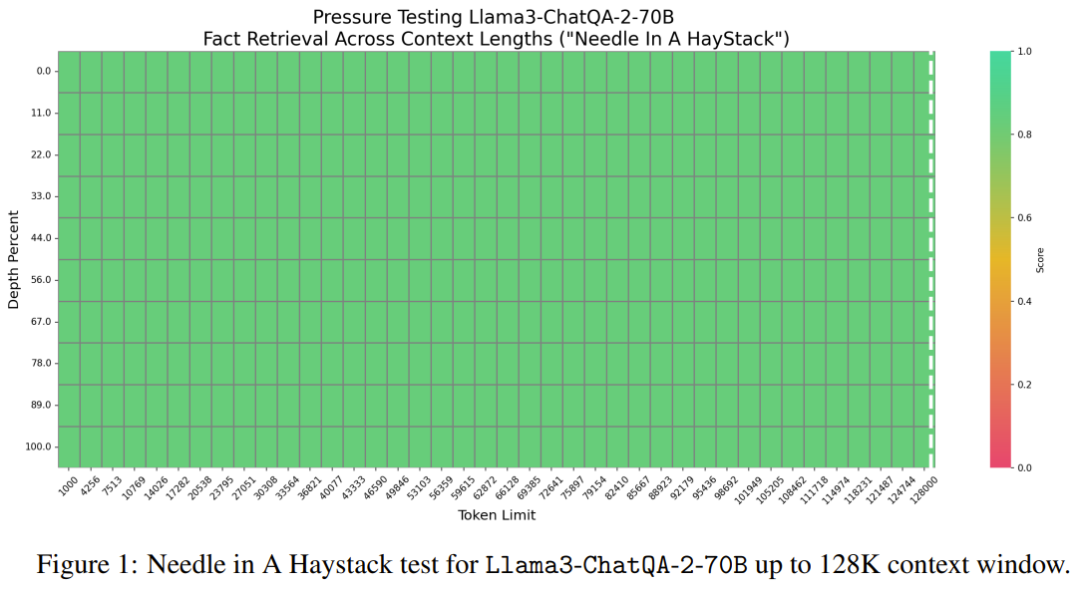

2. Lange Kontextauswertung über 100.000 Token

Bei realen Aufgaben von InfiniteBench bewertete das Team die Leistung des Modells, als die Kontextlänge 100.000 Token überschritt. Die Ergebnisse sind in Tabelle 2 dargestellt.

Es ist ersichtlich, dass das neue Modell eine bessere Leistung erbringt als viele derzeit beste Modelle, wie z. B. GPT4-Turbo-2024-04-09 (33,16), GPT4-1106 Vorschau (28,23), Llama-3-70B- Instruct -Gradient-262k (32,57) und Claude 2 (33,96). Darüber hinaus liegt die Punktzahl des neuen Modells sehr nahe an der Höchstpunktzahl von 34,88, die von Qwen2-72B-Instruct erzielt wurde. Insgesamt ist Nvidias neues Modell durchaus konkurrenzfähig.

3. Auswertung mittellanger Kontexte mit einer Anzahl von Tokens innerhalb von 32.000.

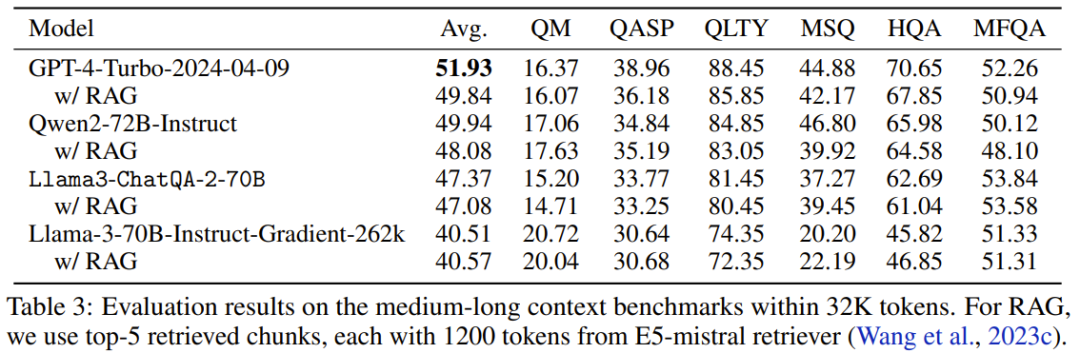

Tabelle 3 zeigt die Leistung jedes Modells, wenn die Anzahl der Token im Kontext innerhalb von 32.000 liegt.

Wie Sie sehen können, hat GPT-4-Turbo-2024-04-09 die höchste Punktzahl, 51,93. Die Punktzahl des neuen Modells beträgt 47,37, was höher ist als bei Llama-3-70B-Instruct-Gradient-262k, aber niedriger als bei Qwen2-72B-Instruct. Der Grund könnte sein, dass das Vortraining von Qwen2-72B-Instruct stark 32.000 Token verbraucht, während der vom Team verwendete kontinuierliche Vortrainingskorpus viel kleiner ist. Darüber hinaus stellten sie fest, dass alle RAG-Lösungen schlechter abschnitten als die Lösungen mit langem Kontext, was darauf hindeutet, dass alle diese hochmodernen LLMs mit langem Kontext 32.000 Token in ihrem Kontextfenster verarbeiten können.

4. ChatRAG Bench: Kurze Kontextbewertung mit einer Anzahl von Tokens von weniger als 4K.

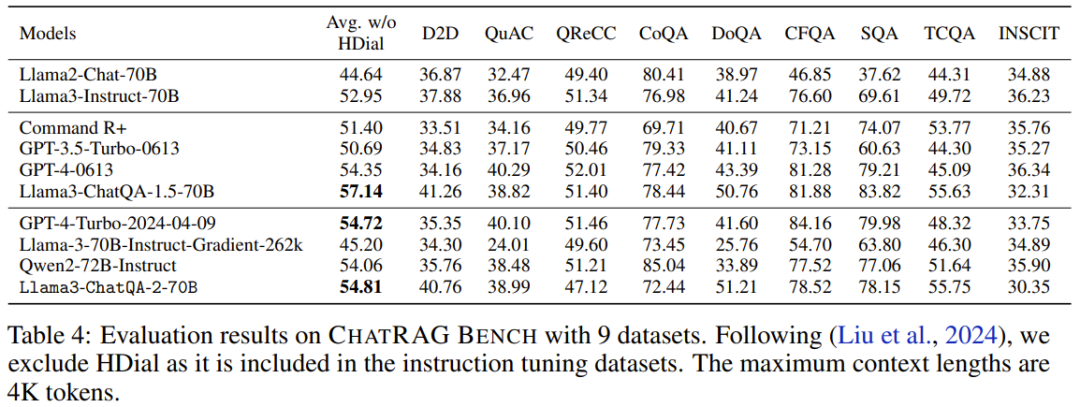

Auf ChatRAG Bench bewertete das Team die Leistung des Modells, wenn die Kontextlänge weniger als 4K Tokens beträgt, siehe Tabelle 4.

Die durchschnittliche Punktzahl des neuen Modells beträgt 54,81. Obwohl dieses Ergebnis nicht so gut ist wie Llama3-ChatQA-1.5-70B, ist es immer noch besser als GPT-4-Turbo-2024-04-09 und Qwen2-72B-Instruct. Dies beweist den Punkt: Die Erweiterung kurzer Kontextmodelle auf lange Kontextmodelle ist mit Kosten verbunden. Dies führt auch zu einer Forschungsrichtung, die es wert ist, untersucht zu werden: Wie kann das Kontextfenster weiter erweitert werden, ohne seine Leistung bei kurzen Kontextaufgaben zu beeinträchtigen?

5. Vergleich von RAG mit langen Kontexten

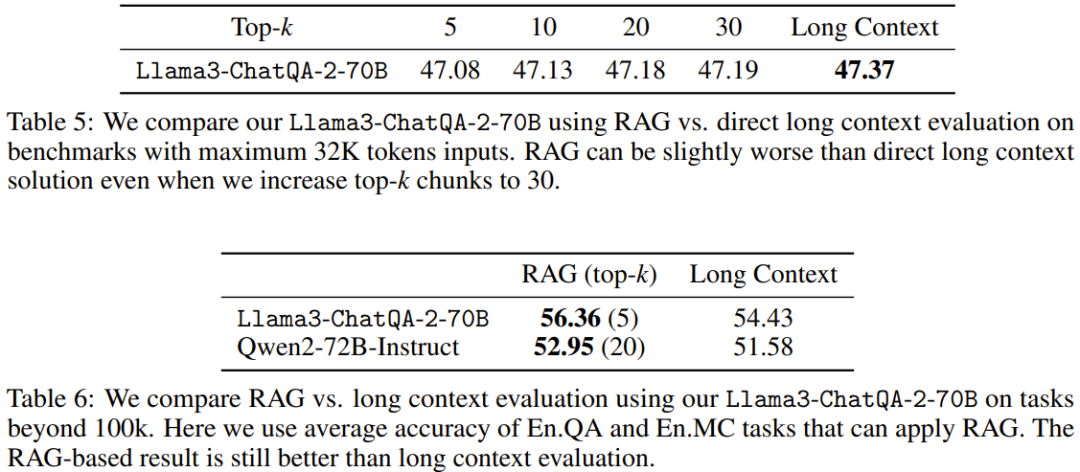

Tabellen 5 und 6 vergleichen die Leistung von RAG mit Lösungen mit langen Kontexten bei Verwendung unterschiedlicher Kontextlängen. Wenn die Sequenzlänge 100 KB überschreitet, werden nur die Durchschnittswerte für En.QA und En.MC gemeldet, da die RAG-Einstellungen für En.Sum und En.Dia nicht direkt verfügbar sind.

Es ist ersichtlich, dass die neu vorgeschlagene Lösung mit langem Kontext RAG übertrifft, wenn die Sequenzlänge der Downstream-Aufgabe weniger als 32 KB beträgt. Das bedeutet, dass der Einsatz von RAG zu Kosteneinsparungen führt, allerdings auf Kosten der Genauigkeit.

Andererseits übertrifft RAG (Top-5 für Llama3-ChatQA-2-70B und Top-20 für Qwen2-72B-Instruct) die Lösung mit langem Kontext, wenn die Kontextlänge 100 KB überschreitet. Das bedeutet, dass, wenn die Anzahl der Token 128.000 übersteigt, selbst das derzeit beste LLM mit langem Kontext möglicherweise Schwierigkeiten hat, ein effektives Verständnis und Argumentation zu erreichen. Das Team empfiehlt, in diesem Fall nach Möglichkeit RAG zu verwenden, da dies eine höhere Genauigkeit und geringere Inferenzkosten bringen kann.

Das obige ist der detaillierte Inhalt vonDas NVIDIA-Dialogmodell ChatQA wurde auf Version 2.0 weiterentwickelt, wobei die angegebene Kontextlänge 128 KB beträgt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Bitcoin-Kauf- und -Verkaufsprozess auf Huobi.com

Bitcoin-Kauf- und -Verkaufsprozess auf Huobi.com

Verwendung der Isalpha-Funktion

Verwendung der Isalpha-Funktion

Der Computer kann nicht kopieren und einfügen

Der Computer kann nicht kopieren und einfügen

Der Unterschied zwischen MySQL und SQL_Server

Der Unterschied zwischen MySQL und SQL_Server

Webservice-Aufrufmethode

Webservice-Aufrufmethode

So verweisen Sie auf CSS in HTML

So verweisen Sie auf CSS in HTML

Wie lösche ich den Speicherplatz für WPS-Cloud-Dokumente, wenn er voll ist?

Wie lösche ich den Speicherplatz für WPS-Cloud-Dokumente, wenn er voll ist?

So öffnen Sie eine APK-Datei

So öffnen Sie eine APK-Datei