Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Bekanntgabe der ACL 2024 Awards: Eines der besten Papers zum Thema Oracle Deciphering von HuaTech, GloVe Time Test Award

Bekanntgabe der ACL 2024 Awards: Eines der besten Papers zum Thema Oracle Deciphering von HuaTech, GloVe Time Test Award

Bekanntgabe der ACL 2024 Awards: Eines der besten Papers zum Thema Oracle Deciphering von HuaTech, GloVe Time Test Award

Die Mitwirkenden haben von dieser ACL-Konferenz viel profitiert.

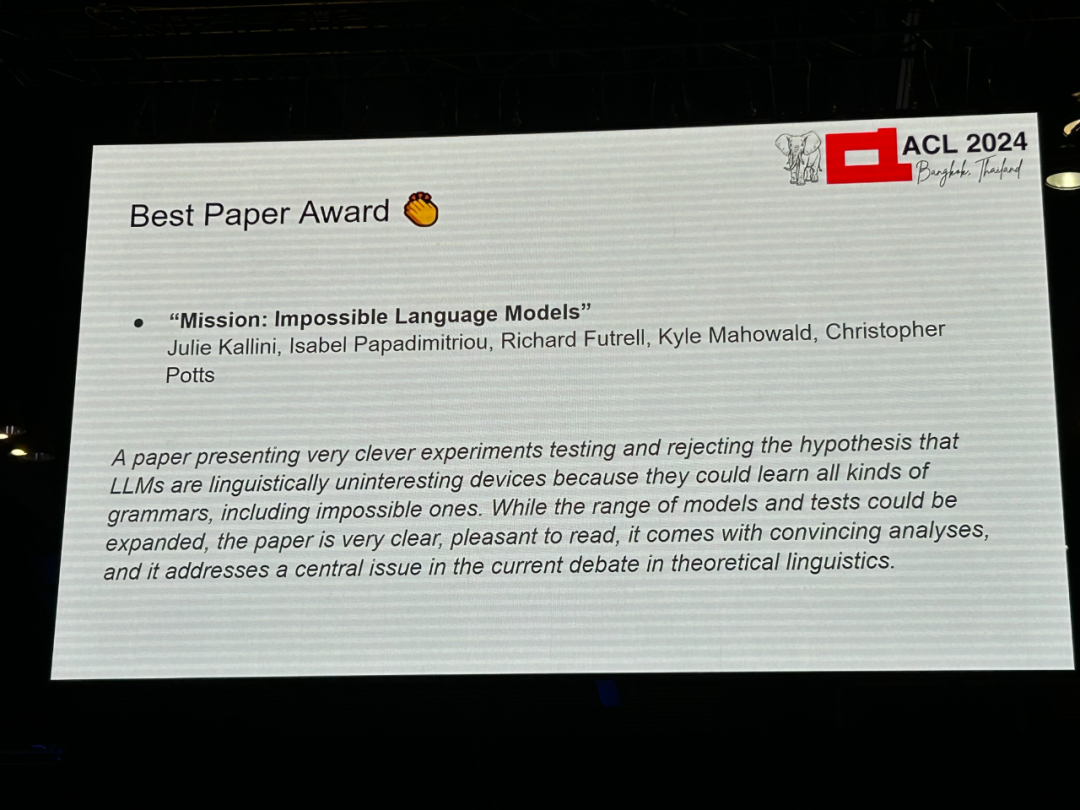

Autoren: Julie Kallini, Isabel Papadimitriou, Richard Futrell, Kyle Mahowald, Christopher Potts -

Institutionen: Stanford University, University of California, Irvine, University of Texas at Austin Papier-Link: https://arxiv.org/abs/2401.06416

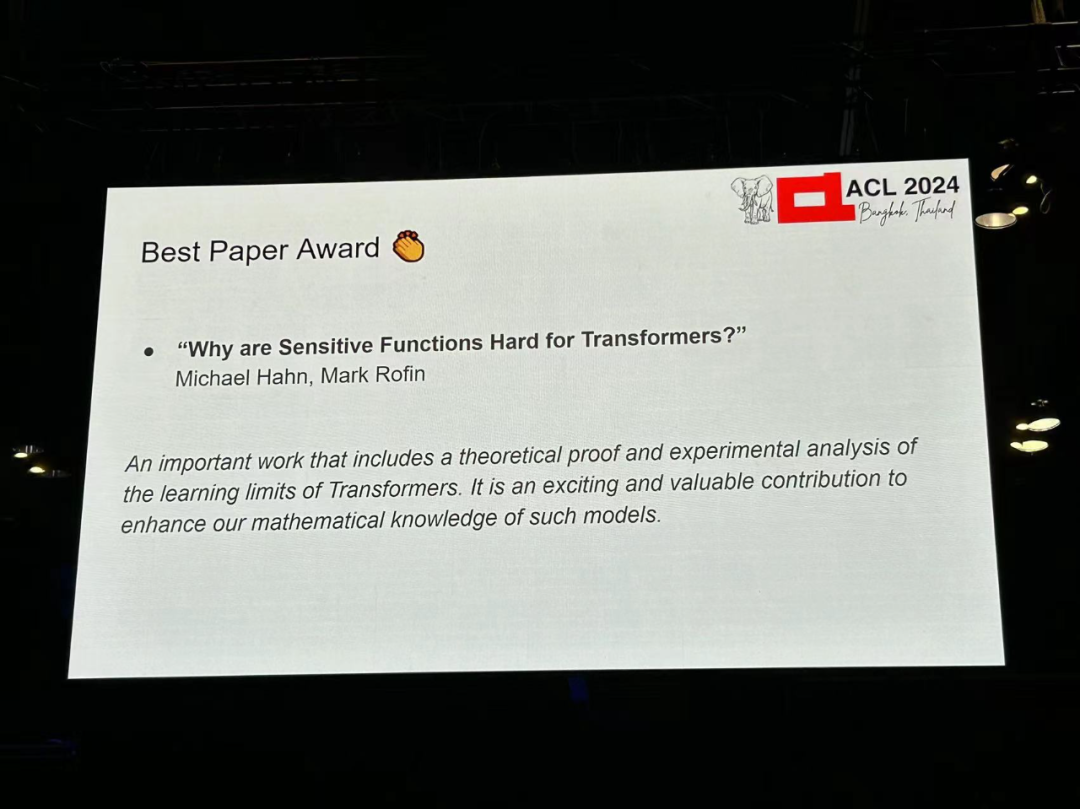

Autor: Michael Hahn, Mark Rofin Institution: Universität des Saarlandes Aufsatzlink: https://arxiv.org /abs/2402.09963

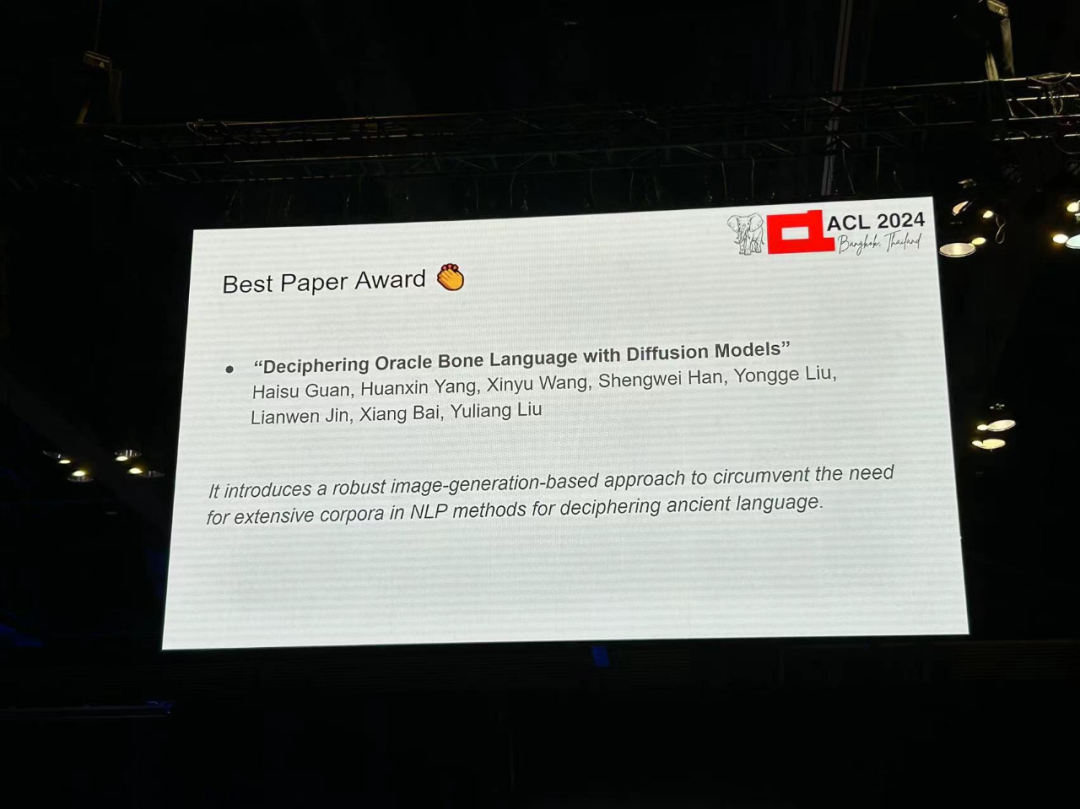

Autor: Haisu Guan, Huanxin Yang, ion: Huazhong Universität Wissenschaft und Technologie, A Adelaide University, Anyang Normal College, South China University of Technology Papierlink: https://arxiv.org/pdf/2406.00684

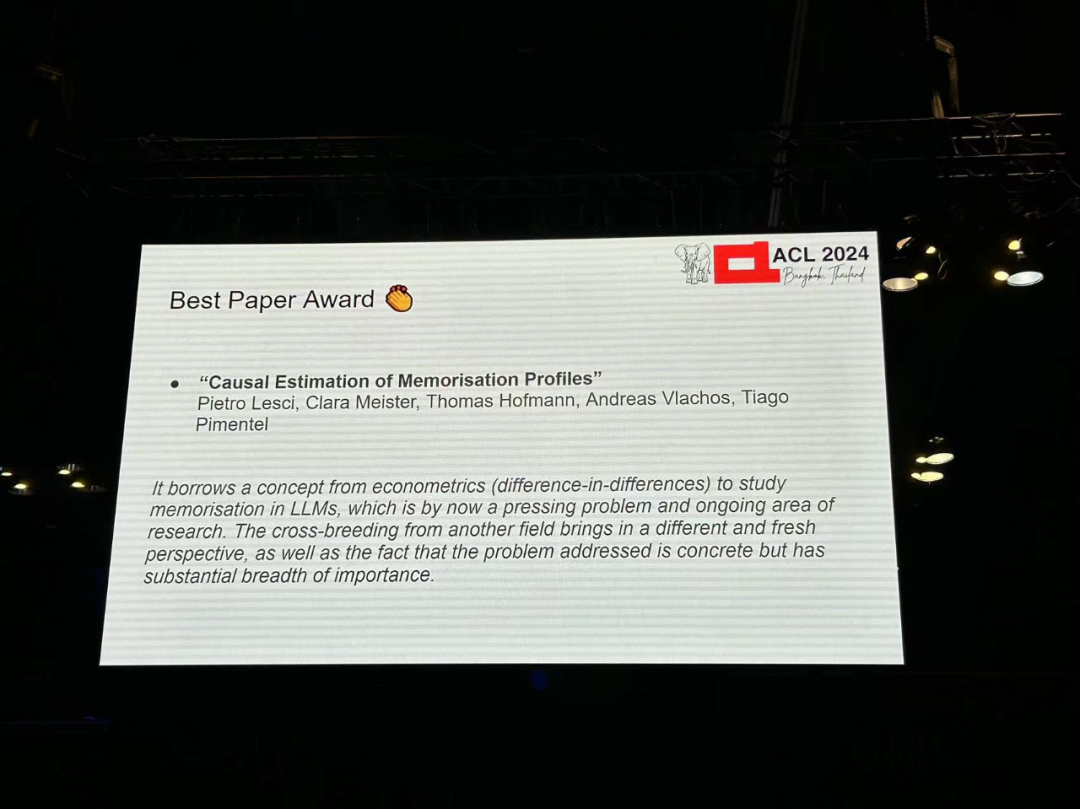

Aufsatz 4: Kausale Schätzung von Erinnerungsprofilen

Autor: Pietro Lesci, Clara Meister, Thomas Hofmann, Andreas Vlachos, Tiago Pimentel

Institution: University of Cambridge , ETH Zürich Akademie Link zum Papier: https://arxiv.org/pdf/2406.04327

Autor: Ahmet Üstün, Viraat Aryabumi, Zheng Xin Yong, Wei-Yin Ko usw. Institution: Cohere, Brown University et al Link zum Papier: https://arxiv.org/pdf/2402.07827

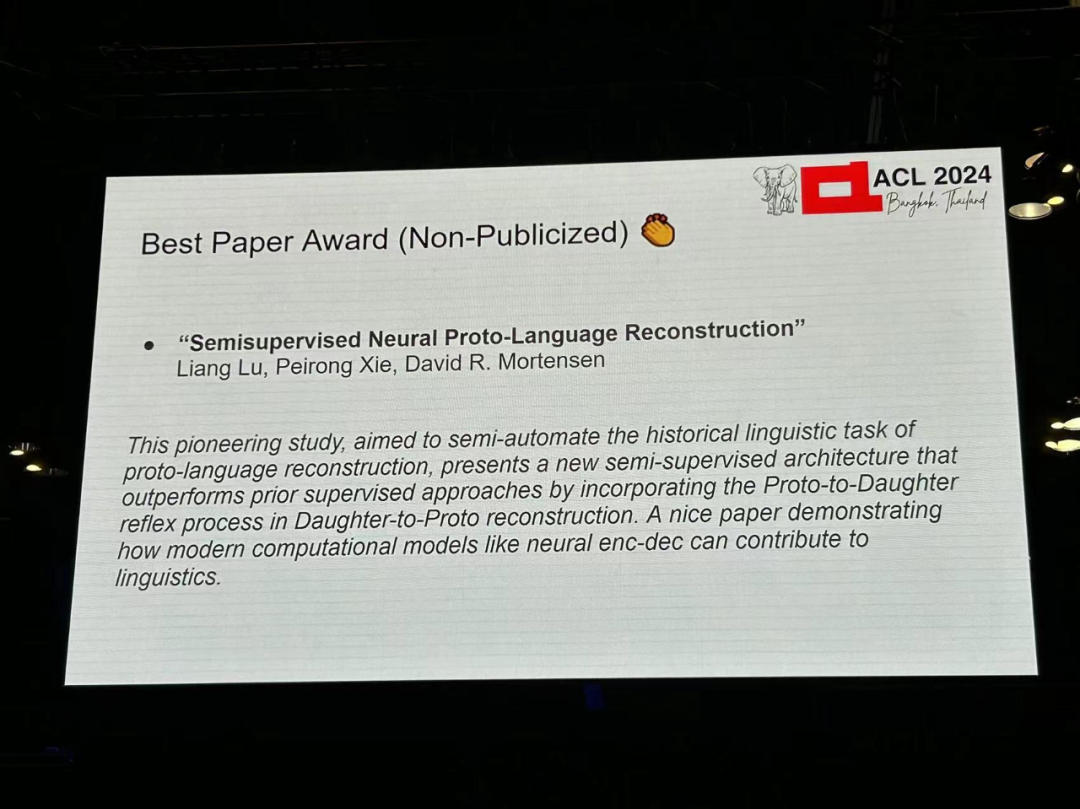

Autoren: Liang Lu, Peirong Xie, David R. Mortensen -

Institution: CMU, University of Südkalifornien -

Link zum Papier: https://arxiv.org/pdf/2406.05930

-

Autoren: Tharindu Madusanka, Ian Pratt-Hartmann, Riza

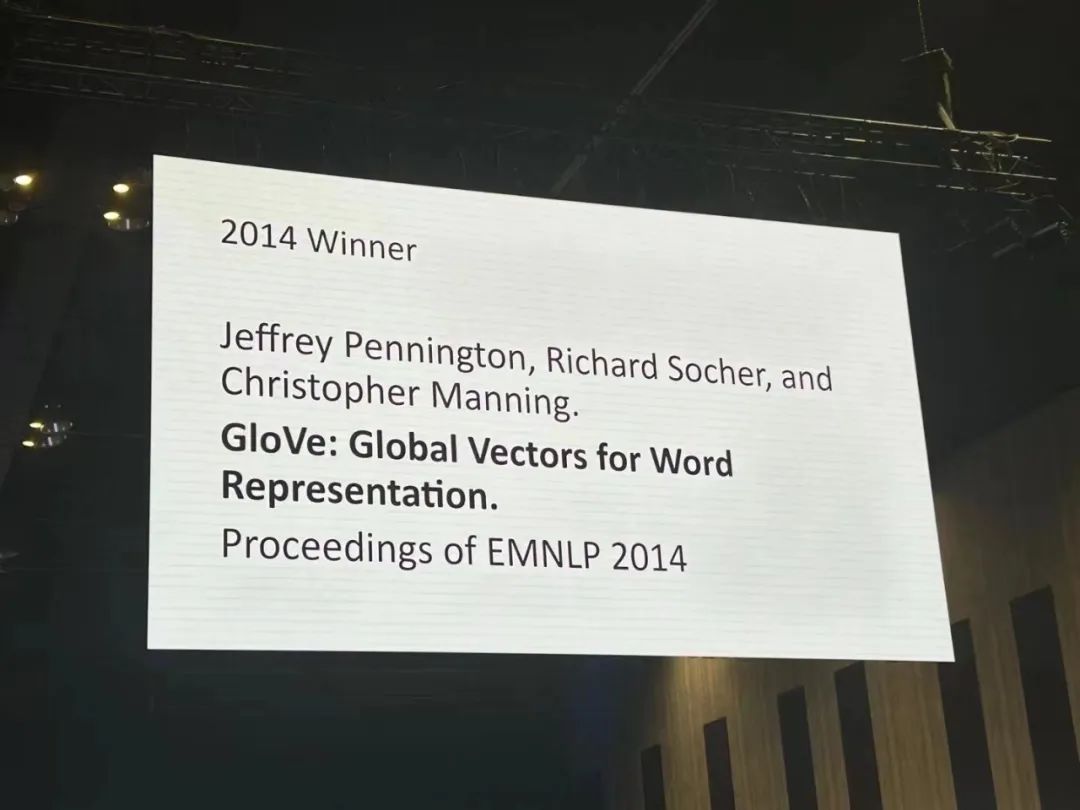

著者: Jeffrey Pennington、Richard Socher、Christopher D. Manning 機関: スタンフォード大学 論文リンク: https:/ /aclanthology.org/D14-1162.pdf

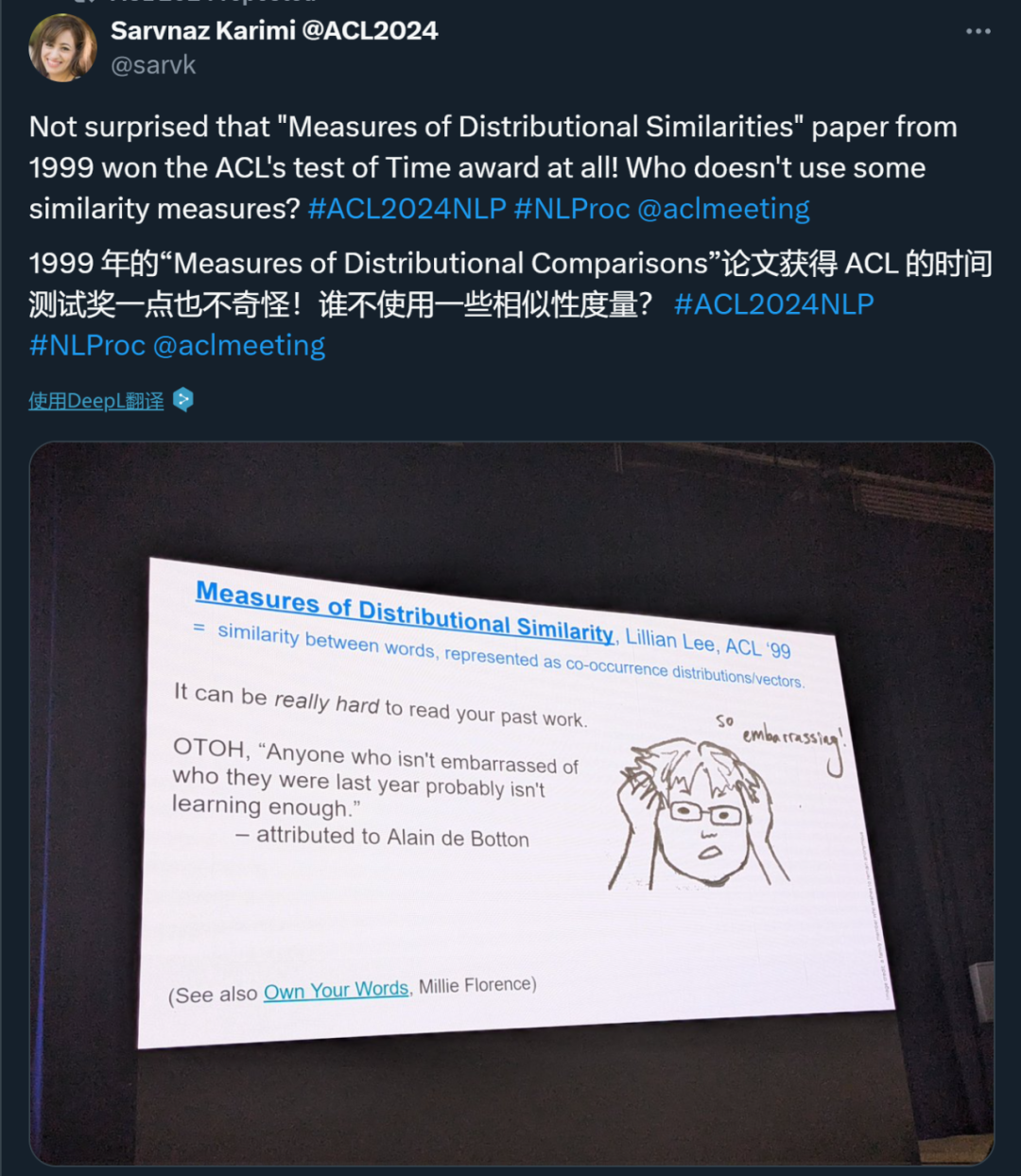

著者: Lillian Lee 機関: コーネル大学 -

論文リンク: https://aclanthology .org /P99-1004.pdf

論文 1: 量子化サイドチューニング: 量子化された大規模言語モデルの高速かつメモリ効率の高いチューニング 著者: Zhengxin Zhang、Dan Zハオ、シュペンミャオ、 Gabriele Oliaro、Zhihao Zhang、Qing Li、Yong Jiang、Zhihao Jia 機関: CMU、清華大学、彭城研究所など -

紙のリンク: https://arxiv.org/pdf/2401.07159

論文 2: L-Eval: 長いコンテキスト言語モデルの標準化された評価の確立 著者: Chenxin An、Shansan Gong、Ming Zhong、Xingjian Zhao、Mukai Li、Jun Zhang、Lingpeng Kong、Xipeng Qiu 機関:復旦大学、香港大学、イリノイ大学アーバナシャンペーン校、上海AIラボ 紙のリンク: https://arxiv.org/abs/2307.11088

論文 3: 大規模言語モデルのバイアスを除去するための因果ガイド型アクティブ学習 論文リンク: https://openreview.net/forum?id=idp_1Q6F-lC

論文 4: CausalGym: 言語タスクにおける因果解釈可能性手法のベンチマーク 著者: Aryaman Arora、Dan Jurafsky、Christopher Potts 機関: スタンフォード大学 -

論文リンク: https://arxiv.org/abs/2402.1 2560

論文 5: 幻覚を起こさず、禁欲する: 複数 LLM コラボレーションによる LLM 知識のギャップの特定 著者: Shangbin Feng、Weijia Shi、Yike Wang、Wenxuan Ding、Vidhisha Balachandran、Yulia Tsvetko v 機関: ワシントン大学、カリフォルニア大学バークレー校、香港科技大学、CMU 紙のリンク: https://arxiv.org/abs/2402.00367

論文 6: Speech Foundation モデルと大規模言語モデルを使用した音声翻訳: そこに何があり、何が欠けているのか? 著者: Marco Gaido、Sara Papi、Matteo Negri、Luisa Bentivogli -

機関: Bruno Kessler Foundation 、イタリア 論文リンク: https://arxiv.org/abs/2402.12025

論文 7: NLP は抽出的である必要がありますか? -

著者: Steven Bird 機関: Charles Darwin University 論文リンク: https://drive.google.com/file/d/1hvF7_WQrou6CWZydhymYFTYHnd3ZIljV/view

論文 8: IRCoder: 中間表現による言語モデルの作成堅牢な多言語コード生成者 著者: Indraneil Paul、Goran Glavaš、Iryna Gurevych 機関: TU Darmstadt、他 -

紙のリンク: https://arxiv.org/abs/2403.03894 -

論文 9: MultiLegalPile: 689 GB の多言語法的コーパス 著者: Matthias Stürmer、Veton Matoshi など 機関: ベルン大学、スタンフォード大学など 論文リンク: https: //arxiv.org/ pdf/2306.02069

論文 10: PsySafe: マルチエージェント システムの安全性の心理学に基づく攻撃、防御、評価のための包括的なフレームワーク 著者: Zaibin Zhang 、Yongting Zhang、Lijun Li、Hongzhi Gao、Lijun Wang、Huchuan Lu、Feng Zhao、Yu Qiao、Jing Shao 機関: 上海人工知能研究所、大連理工大学、中国科学技術大学 -

論文リンク: https://arxiv .org/pdf/2401.11880

論文 11: 大規模言語モデルは感情的サポートの会話における選好バイアスを軽減するのに適しているか? 著者: Dongjin Kang、Sunghwan Kim 他 機関: 延世大学など 論文リンク: https://arxiv.org/pdf/2402.13211

論文 12:ティカルコンパスそれとも大規模言語モデルにおける価値観と意見のより意味のある評価に向けて 著者: Paul Röttger、Valentin Hofmann など -

機関: ボッコーニ大学、アレン人工知能研究所など 紙のリンク: https://arxiv.org/pdf/ 2402.16786

論文 13: 同じタスク、より多くのトークン: 大規模言語モデルの推論パフォーマンスに対する入力長の影響 著者: Mosh Levy、Alon Jacoby、Yoav Goldberg 機関: パキスタンエラン大学、アレン人工知能研究所 論文リンク: https://arxiv.org/pdf/2402.14848

論文14: ラマは多言語の潜在言語について働くか?トランスフォーマー 著者: Chris Wendler、Veniamin Veselovsky、他 -

機関: EPFL - 論文 15: ユーモアについて真剣になる: 面白くない大規模言語モデルを使用したユーモア データセットの作成

- 機関: コロンビア大学、EPFL

- 論文リンク: https://arxiv.org/pdf/2403.00794

- 論文 16: レベルの推定方言複数方言のアラビア語データセットにおけるアノテーター間の合意を予測します

- 機関: エディンバラ大学

- ペーパーリンク: https://arxiv.org/pdf /2405.11282

- 論文 17: G-DlG: 機械翻訳のための勾配ベースの Dlverse と高品質な命令データの選択に向けて

- 機関: ByteDance Research

- 論文リンク: https: https://arxiv.org/pdf/2405.12915

-

- 論文 19: SPZ: アルツハイマー病検出のためのゾーンミキシングによるセマンティック摂動ベースのデータ拡張手法

- 論文 20: 必要なのは貪欲だけ: トークナイザー推論手法の評価

- 機関: Ben Guri、ネゲブ アン大学、MIT

- 論文リンク: https://arxiv.org/abs/2403.01289

- Author:Thihiro Taquchi、DavidChiang

- paperリンク:https://arxiv.org/abs/2406.09202

- 論文 22: 対照的活性化追加によるラマ 2 のステアリング

- 著者: Ninarimsky、Nick Gabrieli、 Julian Schulz、Meg Tong、Evan J Hubinger、Alexander Matt Turner

- 論文リンク: https://arxiv.org/abs/2312.06681

- 論文 23: EconAgent: 大規模言語モデルを活用したマクロ経済活動をシミュレートするエージェント

- 著者: Nian Li、Chen Gao、Mingyu Li、Yong Li、Qingmin Liao

- 紙のリンク: https: //arxiv.org/abs/2310.10436

- 論文 24: M4LE: 大規模言語モデル向けのマルチアビリティ、マルチレンジ、マルチタスク、マルチドメイン、ロングコンテキスト評価ベンチマーク

- 著者: Wai-Chung Kwan、Xingshan Zeng、Yufei Wang、Yusen Sun、Liangyou Li、Lifeng Shang、Qun Liu、Kam- Fai Wong

- 論文リンク: https://arxiv.org/abs/2310.19240

- 論文 25: CHECKWHY: 引数構造による因果関係の検証

- 論文 26: 効率と統計について。Apple Inc. ダルムシュタット

- 論文 27: エミュレートされた不整合: 安全性の調整大規模な言語モデルは逆効果になる可能性があります!

- 著者 : Zhanhui Zhou、Jie Liu、Zhichen Dong、Jiaheng Liu、Chao Yang、Wanli Ouyang、Yu Qiao

- 機関: Shanghai Artificial Intelligence Laboratory

- 論文 28: IndicLLMSuite: インド言語の事前トレーニングおよび微調整データセットを作成するためのブループリント

- 著者: Mohammed Safi Ur Rahman Khan、Priyam Mehta、Ananth Sankar など

- 機関: AI4Bharat の Nilekani Center、インド工科大学 (マドラス)、Microsoft など

- 論文 29: MultiPICo: 多言語パースペクティビスト lrony コーパス

- 著者: Silvia Casola、Simona Frenda、Soda Marem Lo、Erhan Sezerer など

- 機関: トリノ大学、 aequa-tech、Amazon Development Center (イタリア) など

- 論文 30: MMToM-QA: 心のマルチモーダル理論の質問応答

- 著者: Chuanyang Jin、Yutong Wu、Jing Cao、jiannan Xiang など

- 機関: ニューヨーク大学、ハーバード大学大学、MIT、カリフォルニア大学サンディエゴ校、バージニア大学、ジョンズ・ホプキンス大学

- 論文 31: MAP ではないDead Yet: Uncovering true language model modes byconditioning across degeneracy

- 著者: Davisよしだ、Kartik Goyal、Kevin Gimpel

- 機関: トヨタ工科大学シカゴ校、ジョージア工科大学

- 論文 32 : NounAtlas: 名目上の意味役割ラベル付けのギャップを埋める

- 著者: Roberto Navigli、Marco Lo Pinto、Pasquale Silvestri など。

- 論文 33: 地球は平らである理由...説得会話を介して誤った情報に対する LLM の信念を調査する

- 著者: Rongwu Xu、Brian S. Lin、Shujian Yang、Tiangi Zhang など。

- 機関: 清華大学、上海交通大学、スタンフォード大学、南洋理工大学

- 論文34: Let's Go Real Talk: 対面会話のための音声対話モデル

- 著者: Se Jin Park、Chae Won Kim、H Hyunsoop Rha、Minsu Kim 他

- 機関: 韓国科学技術研究院(KAIST)

- 論文 35 : Word の埋め込みは言語モデルの舵取りです

- 著者: Chi Han、JiアリアンXu、Manling Li、Yi Fung、Chenkai Sun、Nan Jiang、Tarek F. Abdelzaher、Heng Ji

- 所属機関: イリノイ大学アーバナ校 - シャンペーン

- 最優秀テーマ論文賞

著者: Dirk Groeneveld、Iz Beltagy、他 機関: Allen Institute for Artificial Intelligence、ワシントン大学、他 論文リンク: https://arxiv.org/pdf/2402.00838 著者: Julen Etxaniz、Oscar Sainz 、ナイアラペレス、イツィアル・アルダベ、ジャーマン・リガウ、エネコ・アギレ、アイトール・オルマザバル、ミケル・アルテクス、アイトール・ソロア リンク: https://arxiv.org/pdf/2403.20266 論文 3: AppWorld: インタラクティブ コーディング エージェントのベンチマークのためのアプリと人々の制御可能な世界 ソーシャル・インパクト賞 - 3件の論文がソーシャル・インパクト賞を受賞しました。

論文 2: DIALECTBENCH: 方言、品種、および密接に関連する言語の NLP ベンチマーク - 論文リンク: https://arxiv.org/pdf/2305.14456

- 受賞理由: この記事は、LLM 時代の重要な問題である文化的偏見を示しています。この論文では、アラビアの文化とロケールを調査し、その結果は、LLM を設計する際に文化の違いを考慮する必要があることを示しています。したがって、同じ研究を他の文化でも再現して、他の文化もこの問題の影響を受けるかどうかを一般化して評価することができます。

- 受賞理由: この論文は、準備時のデータ管理の重要性を示しています。大規模な言語モデルをトレーニングするためのデータセット。これは、コミュニティ内の幅広い人々に非常に貴重な洞察を提供します。

- 受賞理由: この研究は非常に重要かつ素晴らしいものですインタラクティブな環境のシミュレーションと評価作業の構築に。これにより、誰もがコミュニティ向けに、より本格的な動的ベンチマークを作成することが奨励されます。

- 理由受賞: この記事では、AI セキュリティのトピックであるジェイルブレイクについて考察し、社会科学研究の分野で開発された手法を検証します。この研究は非常に興味深いものであり、コミュニティに重大な影響を与える可能性があります。

- 賞の引用: 方言バリエーションNLP と人工知能の重要な領域であり、十分に研究されていない現象です。しかし、言語と社会の観点から見ると、その研究の価値は極めて高く、応用にも重要な意味を持っています。この論文では、LLM 時代のこの問題を研究するための非常に新しいベンチマークを提案します。 Paper 3:大規模な言語モデルでの祈りの後にビールを飲んでいます。ジョージア工科大学

Das obige ist der detaillierte Inhalt vonBekanntgabe der ACL 2024 Awards: Eines der besten Papers zum Thema Oracle Deciphering von HuaTech, GloVe Time Test Award. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1672

1672

14

14

1428

1428

52

52

1332

1332

25

25

1276

1276

29

29

1256

1256

24

24

Der DeepMind-Roboter spielt Tischtennis und seine Vor- und Rückhand rutschen in die Luft, wodurch menschliche Anfänger völlig besiegt werden

Aug 09, 2024 pm 04:01 PM

Der DeepMind-Roboter spielt Tischtennis und seine Vor- und Rückhand rutschen in die Luft, wodurch menschliche Anfänger völlig besiegt werden

Aug 09, 2024 pm 04:01 PM

Aber vielleicht kann er den alten Mann im Park nicht besiegen? Die Olympischen Spiele in Paris sind in vollem Gange und Tischtennis hat viel Aufmerksamkeit erregt. Gleichzeitig haben Roboter auch beim Tischtennisspielen neue Durchbrüche erzielt. Gerade hat DeepMind den ersten lernenden Roboteragenten vorgeschlagen, der das Niveau menschlicher Amateurspieler im Tischtennis-Wettkampf erreichen kann. Papieradresse: https://arxiv.org/pdf/2408.03906 Wie gut ist der DeepMind-Roboter beim Tischtennisspielen? Vermutlich auf Augenhöhe mit menschlichen Amateurspielern: Sowohl Vorhand als auch Rückhand: Der Gegner nutzt unterschiedliche Spielstile, und auch der Roboter hält aus: Aufschlagannahme mit unterschiedlichem Spin: Allerdings scheint die Intensität des Spiels nicht so intensiv zu sein wie Der alte Mann im Park. Für Roboter, Tischtennis

Die erste mechanische Klaue! Yuanluobao trat auf der Weltroboterkonferenz 2024 auf und stellte den ersten Schachroboter vor, der das Haus betreten kann

Aug 21, 2024 pm 07:33 PM

Die erste mechanische Klaue! Yuanluobao trat auf der Weltroboterkonferenz 2024 auf und stellte den ersten Schachroboter vor, der das Haus betreten kann

Aug 21, 2024 pm 07:33 PM

Am 21. August fand in Peking die Weltroboterkonferenz 2024 im großen Stil statt. Die Heimrobotermarke „Yuanluobot SenseRobot“ von SenseTime hat ihre gesamte Produktfamilie vorgestellt und kürzlich den Yuanluobot AI-Schachspielroboter – Chess Professional Edition (im Folgenden als „Yuanluobot SenseRobot“ bezeichnet) herausgebracht und ist damit der weltweit erste A-Schachroboter für heim. Als drittes schachspielendes Roboterprodukt von Yuanluobo hat der neue Guoxiang-Roboter eine Vielzahl spezieller technischer Verbesserungen und Innovationen in den Bereichen KI und Maschinenbau erfahren und erstmals die Fähigkeit erkannt, dreidimensionale Schachfiguren aufzunehmen B. durch mechanische Klauen an einem Heimroboter, und führen Sie Mensch-Maschine-Funktionen aus, z. B. Schach spielen, jeder spielt Schach, Überprüfung der Notation usw.

Claude ist auch faul geworden! Netizen: Lernen Sie, sich einen Urlaub zu gönnen

Sep 02, 2024 pm 01:56 PM

Claude ist auch faul geworden! Netizen: Lernen Sie, sich einen Urlaub zu gönnen

Sep 02, 2024 pm 01:56 PM

Der Schulstart steht vor der Tür und nicht nur die Schüler, die bald ins neue Semester starten, sollten auf sich selbst aufpassen, sondern auch die großen KI-Modelle. Vor einiger Zeit war Reddit voller Internetnutzer, die sich darüber beschwerten, dass Claude faul werde. „Sein Niveau ist stark gesunken, es kommt oft zu Pausen und sogar die Ausgabe wird sehr kurz. In der ersten Woche der Veröffentlichung konnte es ein komplettes 4-seitiges Dokument auf einmal übersetzen, aber jetzt kann es nicht einmal eine halbe Seite ausgeben.“ !

Auf der Weltroboterkonferenz wurde dieser Haushaltsroboter, der „die Hoffnung auf eine zukünftige Altenpflege' in sich trägt, umzingelt

Aug 22, 2024 pm 10:35 PM

Auf der Weltroboterkonferenz wurde dieser Haushaltsroboter, der „die Hoffnung auf eine zukünftige Altenpflege' in sich trägt, umzingelt

Aug 22, 2024 pm 10:35 PM

Auf der World Robot Conference in Peking ist die Präsentation humanoider Roboter zum absoluten Mittelpunkt der Szene geworden. Am Stand von Stardust Intelligent führte der KI-Roboterassistent S1 drei große Darbietungen mit Hackbrett, Kampfkunst und Kalligraphie auf Ein Ausstellungsbereich, der sowohl Literatur als auch Kampfkunst umfasst, zog eine große Anzahl von Fachpublikum und Medien an. Durch das elegante Spiel auf den elastischen Saiten demonstriert der S1 eine feine Bedienung und absolute Kontrolle mit Geschwindigkeit, Kraft und Präzision. CCTV News führte einen Sonderbericht über das Nachahmungslernen und die intelligente Steuerung hinter „Kalligraphie“ durch. Firmengründer Lai Jie erklärte, dass hinter den seidenweichen Bewegungen die Hardware-Seite die beste Kraftkontrolle und die menschenähnlichsten Körperindikatoren (Geschwindigkeit, Belastung) anstrebt. usw.), aber auf der KI-Seite werden die realen Bewegungsdaten von Menschen gesammelt, sodass der Roboter stärker werden kann, wenn er auf eine schwierige Situation stößt, und lernen kann, sich schnell weiterzuentwickeln. Und agil

Bekanntgabe der ACL 2024 Awards: Eines der besten Papers zum Thema Oracle Deciphering von HuaTech, GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

Bekanntgabe der ACL 2024 Awards: Eines der besten Papers zum Thema Oracle Deciphering von HuaTech, GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

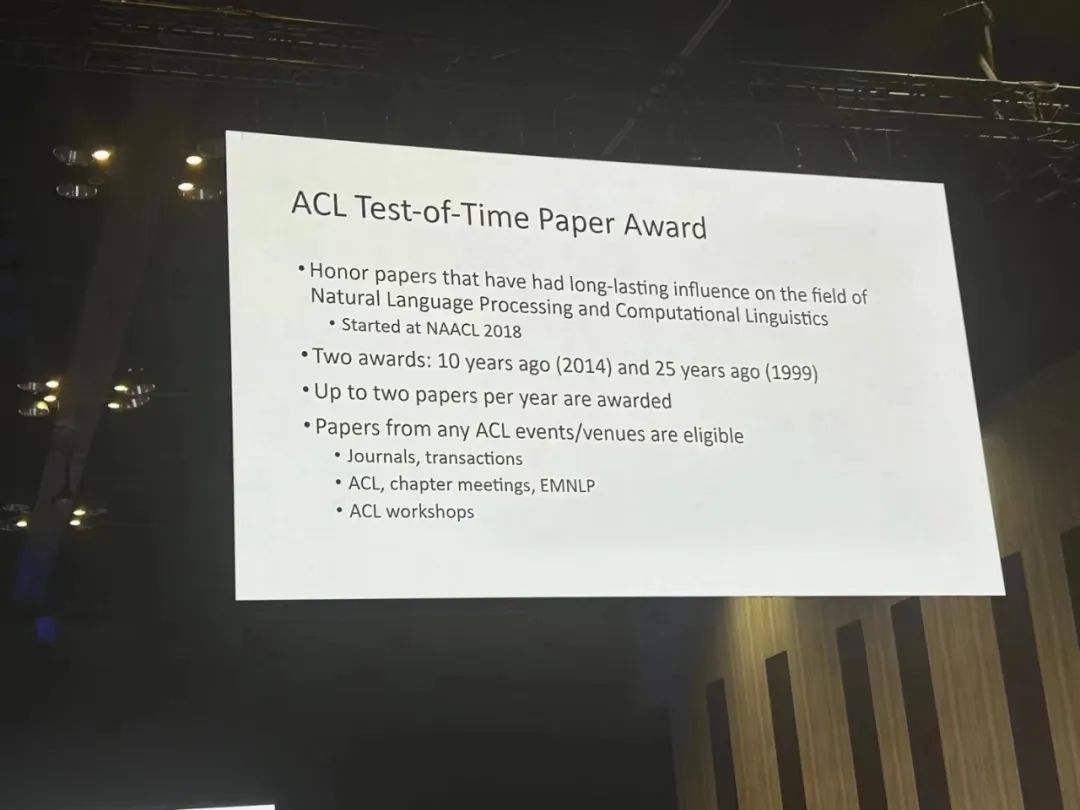

Bei dieser ACL-Konferenz haben die Teilnehmer viel gewonnen. Die sechstägige ACL2024 findet in Bangkok, Thailand, statt. ACL ist die führende internationale Konferenz im Bereich Computerlinguistik und Verarbeitung natürlicher Sprache. Sie wird von der International Association for Computational Linguistics organisiert und findet jährlich statt. ACL steht seit jeher an erster Stelle, wenn es um akademischen Einfluss im Bereich NLP geht, und ist außerdem eine von der CCF-A empfohlene Konferenz. Die diesjährige ACL-Konferenz ist die 62. und hat mehr als 400 innovative Arbeiten im Bereich NLP eingereicht. Gestern Nachmittag gab die Konferenz den besten Vortrag und weitere Auszeichnungen bekannt. Diesmal gibt es 7 Best Paper Awards (zwei davon unveröffentlicht), 1 Best Theme Paper Award und 35 Outstanding Paper Awards. Die Konferenz verlieh außerdem drei Resource Paper Awards (ResourceAward) und einen Social Impact Award (

Das Team von Li Feifei schlug ReKep vor, um Robotern räumliche Intelligenz zu verleihen und GPT-4o zu integrieren

Sep 03, 2024 pm 05:18 PM

Das Team von Li Feifei schlug ReKep vor, um Robotern räumliche Intelligenz zu verleihen und GPT-4o zu integrieren

Sep 03, 2024 pm 05:18 PM

Tiefe Integration von Vision und Roboterlernen. Wenn zwei Roboterhände reibungslos zusammenarbeiten, um Kleidung zu falten, Tee einzuschenken und Schuhe zu packen, gepaart mit dem humanoiden 1X-Roboter NEO, der in letzter Zeit für Schlagzeilen gesorgt hat, haben Sie vielleicht das Gefühl: Wir scheinen in das Zeitalter der Roboter einzutreten. Tatsächlich sind diese seidigen Bewegungen das Produkt fortschrittlicher Robotertechnologie + exquisitem Rahmendesign + multimodaler großer Modelle. Wir wissen, dass nützliche Roboter oft komplexe und exquisite Interaktionen mit der Umgebung erfordern und die Umgebung als Einschränkungen im räumlichen und zeitlichen Bereich dargestellt werden kann. Wenn Sie beispielsweise möchten, dass ein Roboter Tee einschenkt, muss der Roboter zunächst den Griff der Teekanne ergreifen und sie aufrecht halten, ohne den Tee zu verschütten, und ihn dann sanft bewegen, bis die Öffnung der Kanne mit der Öffnung der Tasse übereinstimmt , und neigen Sie dann die Teekanne in einem bestimmten Winkel. Das

Distributed Artificial Intelligence Conference DAI 2024 Call for Papers: Agent Day, Richard Sutton, der Vater des Reinforcement Learning, wird teilnehmen! Yan Shuicheng, Sergey Levine und DeepMind-Wissenschaftler werden Grundsatzreden halten

Aug 22, 2024 pm 08:02 PM

Distributed Artificial Intelligence Conference DAI 2024 Call for Papers: Agent Day, Richard Sutton, der Vater des Reinforcement Learning, wird teilnehmen! Yan Shuicheng, Sergey Levine und DeepMind-Wissenschaftler werden Grundsatzreden halten

Aug 22, 2024 pm 08:02 PM

Einleitung zur Konferenz Mit der rasanten Entwicklung von Wissenschaft und Technologie ist künstliche Intelligenz zu einer wichtigen Kraft bei der Förderung des sozialen Fortschritts geworden. In dieser Zeit haben wir das Glück, die Innovation und Anwendung der verteilten künstlichen Intelligenz (DAI) mitzuerleben und daran teilzuhaben. Verteilte Künstliche Intelligenz ist ein wichtiger Zweig des Gebiets der Künstlichen Intelligenz, der in den letzten Jahren immer mehr Aufmerksamkeit erregt hat. Durch die Kombination des leistungsstarken Sprachverständnisses und der Generierungsfähigkeiten großer Modelle sind plötzlich Agenten aufgetaucht, die auf natürlichen Sprachinteraktionen, Wissensbegründung, Aufgabenplanung usw. basieren. AIAgent übernimmt das große Sprachmodell und ist zu einem heißen Thema im aktuellen KI-Kreis geworden. Au

Hongmeng Smart Travel S9 und die umfassende Einführungskonferenz für neue Produkte wurden gemeinsam mit einer Reihe neuer Blockbuster-Produkte veröffentlicht

Aug 08, 2024 am 07:02 AM

Hongmeng Smart Travel S9 und die umfassende Einführungskonferenz für neue Produkte wurden gemeinsam mit einer Reihe neuer Blockbuster-Produkte veröffentlicht

Aug 08, 2024 am 07:02 AM

Heute Nachmittag begrüßte Hongmeng Zhixing offiziell neue Marken und neue Autos. Am 6. August veranstaltete Huawei die Hongmeng Smart Xingxing S9 und die Huawei-Konferenz zur Einführung neuer Produkte mit umfassendem Szenario und brachte die Panorama-Smart-Flaggschiff-Limousine Xiangjie S9, das neue M7Pro und Huawei novaFlip, MatePad Pro 12,2 Zoll, das neue MatePad Air und Huawei Bisheng mit Mit vielen neuen Smart-Produkten für alle Szenarien, darunter die Laserdrucker der X1-Serie, FreeBuds6i, WATCHFIT3 und der Smart Screen S5Pro, von Smart Travel über Smart Office bis hin zu Smart Wear baut Huawei weiterhin ein Smart-Ökosystem für alle Szenarien auf, um Verbrauchern ein Smart-Erlebnis zu bieten Internet von allem. Hongmeng Zhixing: Huawei arbeitet mit chinesischen Partnern aus der Automobilindustrie zusammen, um die Modernisierung der Smart-Car-Industrie voranzutreiben