Mamba ist gut, aber ihre Entwicklung steht noch am Anfang. Es gibt viele Deep-Learning-Architekturen, aber die erfolgreichste ist in den letzten Jahren keine. Transformer hat sich in mehreren Anwendungsbereichen eine führende Stellung erarbeitet.

Einer der Schlüsselfaktoren für diesen Erfolg ist der Aufmerksamkeitsmechanismus, der es Transformer-basierten Modellen ermöglicht, sich auf die Teile zu konzentrieren, die mit der Eingabesequenz und der Eingabesequenz zusammenhängen bessere Ergebnisse erzielen. Der Nachteil des Aufmerksamkeitsmechanismus besteht jedoch darin, dass der Rechenaufwand hoch ist, der quadratisch mit der Eingabegröße zunimmt, was die Verarbeitung sehr langer Texte erschwert.

Glücklicherweise wurde vor einiger Zeit eine neue Architektur mit großem Potenzial geboren: das Structured State Space Sequence Model (SSM). Diese Architektur kann komplexe Abhängigkeiten in Sequenzdaten effizient erfassen und ist damit ein leistungsstarker Gegner von Transformer.

Das Design dieses Modelltyps ist vom klassischen Zustandsraummodell inspiriert – wir können es uns als eine Kombination aus rekurrenten neuronalen Netzen und Faltung vorstellen Fusionsmodell neuronaler Netze. Sie können mithilfe von Schleifen- oder Faltungsoperationen effizient berechnet werden, wodurch der Rechenaufwand linear oder nahezu linear mit der Sequenzlänge skaliert werden kann, wodurch die Rechenkosten erheblich gesenkt werden.

Genauer gesagt können die Modellierungsfähigkeiten von Mamba, einer der erfolgreichsten Varianten von SSM, bereits mit denen von Transformer mithalten, wobei die Reihenfolge dennoch erhalten bleibt Länge. Lineare Skalierbarkeit.

Mamba führt zunächst einen einfachen, aber effektiven Auswahlmechanismus ein, der den SSM entsprechend der Eingabe neu parametrisieren kann, sodass das Modell Inkonsistenzen herausfiltern kann . Relevante Informationen unter Beibehaltung notwendiger und relevanter Daten auf unbestimmte Zeit. Mamba enthält dann einen hardwarebewussten Algorithmus, der das Modell iterativ mithilfe von Scans anstelle von Faltungen berechnet, was zu einer dreifachen Beschleunigung der A100-GPU führt.

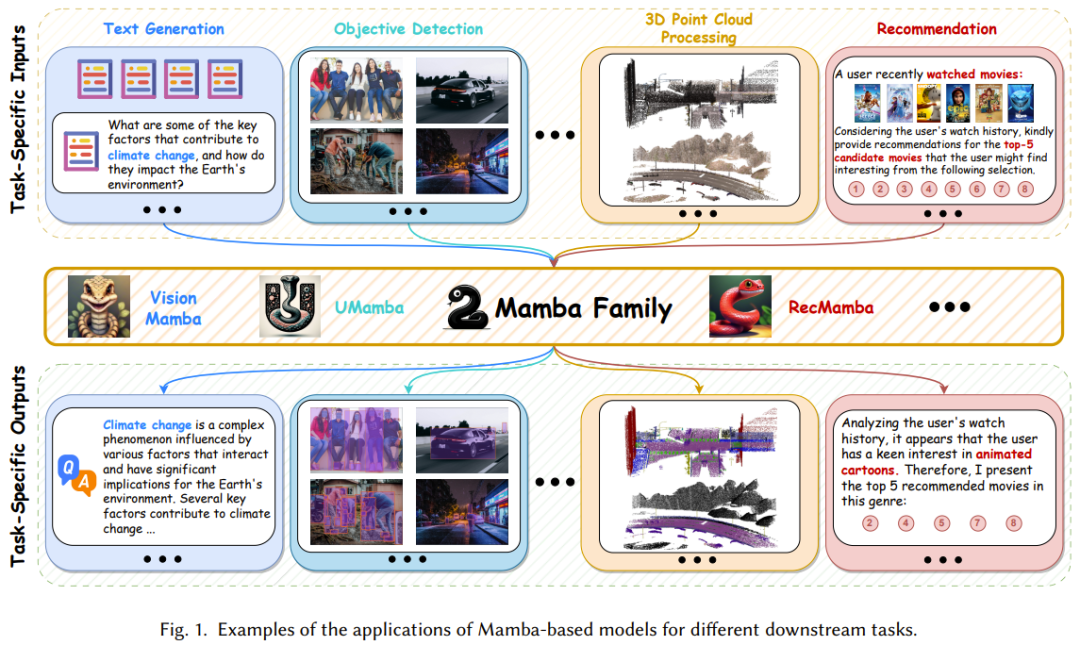

Wie in Abbildung 1 gezeigt, hat sich Mamba mit seiner leistungsstarken Fähigkeit zur Modellierung komplexer Langsequenzdaten und nahezu linearer Skalierbarkeit zu einem Es ist ein Grundmodell und wird voraussichtlich viele Forschungs- und Anwendungsbereiche wie Computer Vision, Verarbeitung natürlicher Sprache und medizinische Behandlung revolutionieren.

Daher wächst die Literatur zur Forschung und Anwendung von Mamba rasant und ein umfassender Übersichtsbericht wird von großem Nutzen sein. Kürzlich veröffentlichte ein Forschungsteam der Hong Kong Polytechnic University seinen Beitrag auf arXiv.

Papiertitel: A Survey of Mamba

Papiertitel: A Survey of Mamba

#🎜🎜 #Papieradresse: https://arxiv.org/pdf/2408.01129

-

Dieser Überprüfungsbericht basiert auf mehreren Gesichtspunkten fasst Mamba zusammen, was nicht nur Anfängern helfen kann, den grundlegenden Arbeitsmechanismus von Mamba zu erlernen, sondern auch erfahrenen Praktikern helfen kann, die neuesten Entwicklungen zu verstehen.

Mamba ist eine beliebte Forschungsrichtung, und daher versuchen viele Teams, zusätzlich zu dem in diesem Artikel vorgestellten, Rezensionsberichte zu schreiben Auch andere Rezensionen konzentrieren sich auf Zustandsraummodelle oder visuelle Mamba. Einzelheiten finden Sie im entsprechenden Artikel:

Mamba-360: Übersicht über Zustandsraummodelle als Transformatoralternative für die Modellierung langer Sequenzen: Methoden, Anwendungen und Herausforderungen arXiv:2404.16112

Zustandsraummodell für Netzwerkalternativen der neuen Generation arXiv:2404.09516# 🎜🎜## Eine Umfrage zu Vision Mamba: Modelle, Anwendungen und Herausforderungen. arXiv:2404.18861Eine Umfrage zu Visual Mamba. 🎜 🎜#

Mamba konzentriert sich auf das zyklische Gerüst des Recurrent Neural Network (RNN), den parallelen Rechen- und Aufmerksamkeitsmechanismus des Transformers und die linearen Eigenschaften des State Space Model (SSM). Um Mamba vollständig zu verstehen, ist es daher notwendig, zunächst diese drei Architekturen zu verstehen. Rekurrentes neuronales Netzwerk Rekurrentes neuronales Netzwerk (RNN) hat die Fähigkeit, den internen Speicher beizubehalten, sodass es Sequenzdaten sehr gut verarbeiten kann. Insbesondere verarbeitet das Standard-RNN bei jedem diskreten Zeitschritt k einen Vektor zusammen mit dem verborgenen Zustand des vorherigen Zeitschritts, gibt dann einen anderen Vektor aus und aktualisiert den verborgenen Zustand. Dieser verborgene Zustand kann als Speicher des RNN verwendet werden, der Informationen über in der Vergangenheit gesehene Eingaben speichern kann. Dieser dynamische Speicher ermöglicht es RNNs, Sequenzen unterschiedlicher Länge zu verarbeiten. Das heißt, RNN ist ein nichtlineares wiederkehrendes Modell, das zeitliche Muster effektiv erfassen kann, indem es historisches Wissen nutzt, das in verborgenen Zuständen gespeichert ist. Der Selbstaufmerksamkeitsmechanismus von Transformer hilft dabei, globale Abhängigkeiten zwischen Eingaben zu erfassen. Dies erfolgt durch die Zuweisung von Gewichtungen zu jeder Position basierend auf ihrer Bedeutung im Verhältnis zu anderen Positionen. Genauer gesagt wird zunächst eine lineare Transformation an der ursprünglichen Eingabe durchgeführt, um die Folge x von Eingabevektoren in drei Arten von Vektoren umzuwandeln: Abfrage Q, Schlüssel K und Wert V. Berechnen Sie dann den normalisierten Aufmerksamkeitswert S und berechnen Sie das Aufmerksamkeitsgewicht. Zusätzlich zur Ausführung einer Einzelaufmerksamkeitsfunktion können wir auch Mehrkopfaufmerksamkeit ausführen. Dadurch kann das Modell verschiedene Arten von Beziehungen erfassen und Eingabesequenzen aus mehreren Perspektiven verstehen. Multi-Head-Aufmerksamkeit verwendet mehrere Sätze von Selbstaufmerksamkeitsmodulen, um Eingabesequenzen parallel zu verarbeiten. Jeder dieser Köpfe arbeitet unabhängig und führt die gleichen Berechnungen durch wie Standardmechanismen der Selbstaufmerksamkeit. Danach werden die Aufmerksamkeitsgewichte jedes Kopfes aggregiert und kombiniert, um die gewichtete Summe der Wertvektoren zu erhalten. Dieser Aggregationsschritt ermöglicht es dem Modell, Informationen aus mehreren Köpfen zu nutzen und viele verschiedene Muster und Beziehungen in der Eingabesequenz zu erfassen. Das Zustandsraummodell (SSM) ist ein traditionelles mathematisches Framework, das zur Beschreibung des dynamischen Verhaltens eines Systems über die Zeit verwendet werden kann. In den letzten Jahren wurde SSM in so unterschiedlichen Bereichen wie Kybernetik, Robotik und Wirtschaft häufig eingesetzt. Im Kern spiegelt SSM das Verhalten des Systems durch eine Reihe versteckter Variablen namens „Zustand“ wider und ermöglicht so die effektive Erfassung der Abhängigkeiten von Zeitdaten. Im Gegensatz zu RNN ist SSM ein lineares Modell mit assoziativen Eigenschaften. Insbesondere erstellt das klassische Zustandsraummodell zwei Schlüsselgleichungen (Zustandsgleichung und Beobachtungsgleichung), um die Beziehung zwischen Eingabe x und Ausgabe y zum aktuellen Zeitpunkt t durch einen N-dimensionalen verborgenen Zustand h (t) zu modellieren.

Um den Anforderungen des maschinellen Lernens gerecht zu werden, muss SSM einen Diskretisierungsprozess durchlaufen – die Umwandlung kontinuierlicher Parameter in diskrete Parameter. Im Allgemeinen besteht das Ziel von Diskretisierungsverfahren darin, kontinuierliche Zeit in K diskrete Intervalle mit möglichst gleicher Integralfläche zu unterteilen. Um dieses Ziel zu erreichen, ist eine der repräsentativsten Lösungen von SSM Zero-Order Hold (ZOH), die davon ausgeht, dass der Funktionswert im Intervall Δ = [?_{?−1}, ?_? ] konstant bleibt. Diskretes SSM hat eine ähnliche Struktur wie ein wiederkehrendes neuronales Netzwerk, sodass es den Inferenzprozess effizienter durchführen kann als transformatorbasierte Modelle.

Diskretes SSM ist ein lineares System mit assoziativen Eigenschaften, sodass es nahtlos in Faltungsberechnungen integriert werden kann. Beziehung zwischen RNN, Transformer und SSMAbbildung 2 zeigt den Berechnungsalgorithmus von RNN, Transformer und SSM.

Einerseits basiert das herkömmliche RNN auf einem nichtlinearen wiederkehrenden Rahmen, bei dem jede Berechnung nur vom vorherigen verborgenen Zustand und der aktuellen Eingabe abhängt. Obwohl diese Form es RNN ermöglicht, während der autoregressiven Inferenz schnell eine Ausgabe zu generieren, erschwert sie es RNN auch, die parallele Rechenleistung der GPU vollständig zu nutzen, was zu einem langsameren Modelltraining führt. Andererseits führt die Transformer-Architektur die Matrixmultiplikation parallel für mehrere „Abfrage-Schlüssel“-Paare durch, und die Matrixmultiplikation kann effizient Hardwareressourcen zugewiesen werden, was ein schnelleres Training aufmerksamkeitsbasierter Modelle ermöglicht. Wenn Sie jedoch möchten, dass ein Transformer-basiertes Modell Antworten oder Vorhersagen generiert, kann der Inferenzprozess sehr zeitaufwändig sein. Im Gegensatz zu RNN und Transformer, die nur einen Berechnungstyp unterstützen, ist diskretes SSM dank seiner linearen Natur sehr flexibel und kann sowohl Schleifenberechnung als auch Faltungsberechnung unterstützen. Diese Funktion ermöglicht SSM nicht nur eine effiziente Inferenz, sondern auch ein paralleles Training. Es ist jedoch zu beachten, dass das gängigste SSM zeitinvariant ist, d. h. seine A, B, C und Δ sind unabhängig von der Modelleingabe x. Dadurch werden seine kontextsensitiven Modellierungsfunktionen eingeschränkt, was dazu führt, dass SSM bei einigen spezifischen Aufgaben, wie z. B. selektivem Kopieren, eine schlechte Leistung erbringt. Mamba Modell. Bitte beziehen Sie sich auf diesen Site-Bericht „Fünffacher Durchsatz, umfassende Leistung umgibt Transformer: Neue Architektur Mamba sprengt den KI-Kreis

Danach schlugen die beiden Mamba-2 vor, in dem die Structured Space-State Duality (SSD/Structured Space-State Duality) eine Struktur aufbaute, die strukturiertes SSM mit mehreren Formen der Aufmerksamkeit verbindet Der theoretische Rahmen ermöglicht es uns, die ursprünglich für Transformer entwickelten Algorithmen und Systemoptimierungstechnologien auf SSM zu übertragen. Sie können sich auch auf den Bericht auf dieser Website „Fighting Transformer Again!“ beziehen. Mamba 2 unter der Leitung des ursprünglichen Autors ist da und die Trainingseffizienz der neuen Architektur wurde erheblich verbessert

Mamba-1: Selektives Zustandsraummodell unter Verwendung hardwarebewusster Algorithmen

Mamba-1 führt drei innovative Technologien ein, die auf dem strukturierten Zustandsraummodell basieren, nämlich auf der Grundlage der Speicherpolynomprojektionsberechnung hoher Ordnung Initialisierung, Auswahlmechanismus und hardwarebewusste Berechnung von HiPPO. Wie in Abbildung 3 dargestellt. Das Ziel dieser Techniken besteht darin, die langfristigen linearen Zeitreihenmodellierungsfunktionen von SSM zu verbessern. Konkret kann die Initialisierungsstrategie eine kohärente Matrix für verborgene Zustände erstellen, um das Langzeitgedächtnis effektiv zu fördern. Der Auswahlmechanismus gibt SSM dann die Möglichkeit, Darstellungen wahrnehmbarer Inhalte zu erhalten. Um die Trainingseffizienz zu verbessern, enthält Mamba schließlich auch zwei hardwarebewusste Computeralgorithmen: Parallel Associative Scan (Parallel Associative Scan) und Memory Recomputation ( Speicherneuberechnung). Mamba-2: State Space Dual Transformer hat die Entwicklung vieler verschiedener Technologien inspiriert, wie etwa Parameter-effiziente Feinabstimmung, Minderung katastrophalen Vergessens und Modellquantisierung. Damit Zustandsraummodelle auch von diesen ursprünglich für Transformer entwickelten Techniken profitieren können, führt Mamba-2 ein neues Framework ein: Structured State Space Duality (SSD). Dieser Rahmen verbindet theoretisch SSM und verschiedene Formen der Aufmerksamkeit.

Im Wesentlichen zeigt SSD, dass sowohl der von Transformer verwendete Aufmerksamkeitsmechanismus als auch das in SSM verwendete lineare zeitinvariante System als semi-transformierbar betrachtet werden können Matrixtransformationen.

Darüber hinaus haben Albert Gu und Tri Dao auch bewiesen, dass selektives SSM einer strukturierten linearen Aufmerksamkeit entspricht, die mithilfe eines halbtrennbaren Maskenmatrix-Kraftmechanismus implementiert wird.

Mamba-2 entwirft eine auf SSD basierende Rechenmethode, die Hardware effizienter nutzen kann und einen Blockzerlegungsmatrix-Multiplikationsalgorithmus verwendet.

Insbesondere wird das Zustandsraummodell durch diese Matrixtransformation als halbseparierbare Matrix behandelt, und Mamba-2 kann diese Berechnung in a zerlegen Matrixblöcke, wobei diagonale Blöcke Intra-Block-Berechnungen darstellen. Während Off-Diagonal-Blöcke eine Inter-Block-Berechnung durch versteckte Zustandszerlegung von SSM darstellen. Mit dieser Methode kann Mamba-2 zwei- bis achtmal schneller trainieren als der parallele Korrelationsscan von Mamba-1 und dennoch eine mit Transformer vergleichbare Leistung erzielen.

Mamba # Werfen wir einen Blick auf die Blockdesigns von Mamba-1 und Mamba-2. Abbildung 4 vergleicht die beiden Architekturen. Das Design von Mamba-1 ist SSM-zentriert, wobei die selektive SSM-Schicht die Aufgabe hat, die Zuordnung von der Eingabesequenz X zu Y durchzuführen. In diesem Entwurf wird nach der anfänglichen Erstellung einer linearen Projektion von X eine lineare Projektion von (A, B, C) verwendet. Anschließend werden das Eingabe-Token und die Zustandsmatrix mithilfe der Parallelkorrelation durch die selektive SSM-Einheit gescannt, um die Ausgabe Y zu erhalten. Anschließend übernimmt Mamba-1 eine Skip-Verbindung, um die Wiederverwendung von Funktionen zu fördern und Leistungseinbußen abzumildern, die häufig während des Modelltrainings auftreten. Schließlich wird das Mamba-Modell erstellt, indem dieses Modul abwechselnd mit Standardnormalisierung und Restverbindungen gestapelt wird.

Wie bei Mamba-2 wird eine SSD-Schicht eingeführt, um eine Zuordnung von [X, A, B, C] zu Y zu erstellen. Dies wird erreicht, indem eine einzelne Projektion am Anfang des Blocks verwendet wird, um [X, A, B, C] gleichzeitig zu verarbeiten, ähnlich wie Standard-Aufmerksamkeitsarchitekturen Q-, K- und V-Projektionen parallel generieren.  Das heißt, der Mamba-2-Block wird basierend auf dem Mamba-1-Block vereinfacht, indem die lineare Sequenzprojektion entfernt wird. Dadurch kann die SSD-Fabric schneller berechnet werden als der parallele selektive Scan von Mamba-1. Um die Trainingsstabilität zu verbessern, fügt Mamba-2 außerdem eine Normalisierungsschicht nach der Sprungverbindung hinzu.

Das heißt, der Mamba-2-Block wird basierend auf dem Mamba-1-Block vereinfacht, indem die lineare Sequenzprojektion entfernt wird. Dadurch kann die SSD-Fabric schneller berechnet werden als der parallele selektive Scan von Mamba-1. Um die Trainingsstabilität zu verbessern, fügt Mamba-2 außerdem eine Normalisierungsschicht nach der Sprungverbindung hinzu.

Mamba-Modell entwickelt sich und macht Fortschritte

# 🎜🎜#State Space Model und Mamba haben sich in letzter Zeit rasant weiterentwickelt und sind zu einer potenziellen Wahl für das Grundmodell eines Backbone-Netzwerks geworden. Obwohl Mamba bei der Verarbeitung natürlicher Sprache eine gute Leistung erbringt, weist es dennoch einige Probleme auf, z. B. Gedächtnisverlust, Schwierigkeiten bei der Verallgemeinerung auf verschiedene Aufgaben, und seine Leistung bei komplexen Mustern ist nicht so gut wie bei Transformer-basierten Sprachmodellen. Um diese Probleme zu lösen, hat die Forschungsgemeinschaft viele Verbesserungen der Mamba-Architektur vorgeschlagen. Die bestehende Forschung konzentriert sich hauptsächlich auf das Design von Modifikationsblöcken, Scanmuster und Speicherverwaltung. Tabelle 1 fasst relevante Studien nach Kategorien zusammen.

Das Design und die Struktur des Mamba-Blocks haben einen großen Einfluss auf die Gesamtleistung des Mamba-Modells und sind daher zu einem wichtigen Forschungsschwerpunkt geworden.

Wie in Abbildung 5 dargestellt, kann die bestehende Forschung basierend auf verschiedenen Methoden zum Aufbau neuer Mamba-Module in drei Kategorien unterteilt werden:

Wie in Abbildung 5 dargestellt, kann die bestehende Forschung basierend auf verschiedenen Methoden zum Aufbau neuer Mamba-Module in drei Kategorien unterteilt werden:

- Integrationsmethode: Integrieren Sie Mamba-Blöcke mit anderen Modellen, um bessere Ergebnisse und Effizienz zu erzielen. Balance;

- Ersetzungsmethode: Ersetzen Sie die Hauptebenen in anderen Modell-Frameworks durch Mamba-Blöcke.

- Modifikationsmethode: Ändern Sie die Komponenten innerhalb des klassischen Mamba-Blocks.

Parallelkorrelationsscan ist eine Schlüsselkomponente innerhalb des Mamba-Modells. Sein Ziel ist es, die durch den Auswahlmechanismus verursachten Rechenprobleme zu lösen, die Geschwindigkeit des Trainingsprozesses zu verbessern, und den Speicherbedarf reduzieren. Dies wird erreicht, indem die lineare Natur zeitlich variierender SSMs ausgenutzt wird, um Kernfusion und Neuberechnung auf Hardwareebene zu entwerfen. Das einseitige Sequenzmodellierungsparadigma von Mamba eignet sich jedoch nicht für das umfassende Lernen verschiedener Daten wie Bilder und Videos.

Um dieses Problem zu lindern, haben einige Forscher neue effiziente Scanmethoden erforscht, um die Leistung des Mamba-Modells zu verbessern und seinen Trainingsprozess zu erleichtern. Wie in Abbildung 6 dargestellt, lassen sich die vorhandenen Forschungsergebnisse im Hinblick auf die Entwicklung von Scan-Modi in zwei Kategorien einteilen:

- Flache Scan-Methode: Betrachten Sie die Token-Sequenz aus einer abgeflachten Perspektive und verarbeiten Sie das Modell darauf basierend Eingabe;

- Stereoskopische Scanmethode: Scannen von Modelleingaben über Dimensionen, Kanäle oder Maßstäbe hinweg, die weiter in drei Kategorien unterteilt werden können: geschichtetes Scannen, räumlich-zeitliches Scannen und Hybrid-Scannen.

Ähnlich wie bei RNN speichert der Speicher verborgener Zustände im Zustandsraummodell effektiv die Informationen vorheriger Schritte und ist daher für die Gesamtleistung von SSM Influence von entscheidender Bedeutung . Obwohl Mamba HiPPO-basierte Methoden zur Speicherinitialisierung einführt, ist die Speicherverwaltung in SSM-Einheiten immer noch schwierig, einschließlich der Übertragung versteckter Informationen vor Schichten und der Erzielung einer verlustfreien Speicherkomprimierung. Zu diesem Zweck haben einige bahnbrechende Forschungen eine Reihe verschiedener Lösungen vorgeschlagen, darunter Speicherinitialisierung, Komprimierung und Verkettung. Lassen Sie Mamba sich an verschiedene Daten anpassenDie Mamba-Architektur ist eine Erweiterung des selektiven Zustandsraummodells. Sie verfügt über die grundlegenden Eigenschaften des zyklischen Modells und eignet sich daher sehr gut für die Verarbeitung von Text und Zeit Serie, Ein universelles Basismodell für Sequenzdaten wie Sprache. Darüber hinaus haben einige aktuelle Pionierforschungen die Anwendungsszenarien der Mamba-Architektur erweitert, sodass sie nicht nur Sequenzdaten verarbeiten, sondern auch in Bereichen wie Bildern und Karten verwendet werden kann, wie in Abbildung 7 dargestellt .

Das Ziel dieser Studien besteht darin, die hervorragende Fähigkeit von Mamba, langfristige Abhängigkeiten zu erlangen, voll auszunutzen und gleichzeitig ihre Effizienz im Lern- und Argumentationsprozess auszunutzen. Tabelle 2 fasst diese Ergebnisse kurz zusammen.

Sequenzdaten beziehen sich auf Daten, die in einer bestimmten Reihenfolge gesammelt und organisiert werden, wobei die Reihenfolge der Datenpunkte von Bedeutung ist. Dieser Übersichtsbericht fasst umfassend die Anwendung von Mamba auf eine Vielzahl von Sequenzdaten zusammen, darunter natürliche Sprach-, Video-, Zeitreihen-, Sprach- und menschliche Bewegungsdaten. Einzelheiten finden Sie im Originalpapier. Im Gegensatz zu Sequenzdaten folgen nicht sequentielle Daten keiner bestimmten Reihenfolge. Seine Datenpunkte können in beliebiger Reihenfolge organisiert werden, ohne dass die Bedeutung der Daten wesentlich beeinträchtigt wird. Dieser Mangel an inhärenter Ordnung kann für wiederkehrende Modelle (RNN, SSM usw.), die speziell auf die Erfassung zeitlicher Abhängigkeiten in Daten ausgelegt sind, schwierig sein. Überraschenderweise haben einige neuere Forschungsergebnisse Mamba (einen repräsentativen SSM) erfolgreich in die Lage versetzt, nicht sequentielle Daten, einschließlich Bilder, Karten und Punktwolkendaten, effizient zu verarbeiten. Um die Wahrnehmungs- und Szenenverständnisfähigkeiten der KI zu verbessern, können mehrere modale Daten integriert werden, wie z. B. Sprache (sequentielle Daten) und Bilder (nicht sequentielle Daten). Eine solche Integration kann sehr wertvolle und ergänzende Informationen liefern. In jüngster Zeit waren multimodale große Sprachmodelle (MLLM) der beliebteste Forschungsschwerpunkt. Diese Art von Modell erbt die leistungsstarken Fähigkeiten großer Sprachmodelle (LLM), einschließlich leistungsstarker Sprachausdrücke und logischer Denkfähigkeit. Obwohl sich Transformer zur dominierenden Methode auf diesem Gebiet entwickelt hat, entwickelt sich Mamba auch zu einem starken Konkurrenten. Seine Leistung bei der Ausrichtung gemischter Quelldaten und der Erzielung einer linearen Komplexitätsskalierung mit der Sequenzlänge macht Mamba zu einem vielversprechenden Ersatz für Transformer. Hier sind einige bemerkenswerte Anwendungen von Mamba-basierten Modellen. Das Team teilte diese Anwendungen in die folgenden Kategorien ein: Verarbeitung natürlicher Sprache, Computer Vision, Sprachanalyse, Arzneimittelentwicklung, Empfehlungssysteme sowie Robotik und autonome Systeme. Wir werden es hier nicht zu sehr vorstellen. Einzelheiten finden Sie im Originalpapier. Herausforderungen und ChancenMamba Obwohl die Mamba-Forschung in einigen Bereichen herausragende Leistungen erbracht hat, steckt sie insgesamt noch in den Kinderschuhen und es müssen noch einige Herausforderungen bewältigt werden. Natürlich sind diese Herausforderungen auch Chancen.

- Wie man auf Mamba basierende Basismodelle entwickelt und verbessert;

- Wie man hardwarebewusstes Computing vollständig implementiert, um die Nutzung von Hardware wie GPU und TPU zu maximieren, um die Modelleffizienz zu verbessern; Wie man Mamba verbessert. Die Glaubwürdigkeit des Modells erfordert weitere Forschung zu Sicherheit und Robustheit, Fairness, Erklärbarkeit und Datenschutz und katastrophales Vergessen Mitigation, Retrieval Augmented Generation (RAG).

-

Das obige ist der detaillierte Inhalt vonEin Artikel zum Verständnis von Mamba, dem stärksten Konkurrenten von Transformer. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Papiertitel: A Survey of Mamba

Papiertitel: A Survey of Mamba

Das heißt, der Mamba-2-Block wird basierend auf dem Mamba-1-Block vereinfacht, indem die lineare Sequenzprojektion entfernt wird. Dadurch kann die SSD-Fabric schneller berechnet werden als der parallele selektive Scan von Mamba-1. Um die Trainingsstabilität zu verbessern, fügt Mamba-2 außerdem eine Normalisierungsschicht nach der Sprungverbindung hinzu.

Das heißt, der Mamba-2-Block wird basierend auf dem Mamba-1-Block vereinfacht, indem die lineare Sequenzprojektion entfernt wird. Dadurch kann die SSD-Fabric schneller berechnet werden als der parallele selektive Scan von Mamba-1. Um die Trainingsstabilität zu verbessern, fügt Mamba-2 außerdem eine Normalisierungsschicht nach der Sprungverbindung hinzu.

So lesen Sie Py-Dateien in Python

So lesen Sie Py-Dateien in Python

Warum kann ich nicht auf den Ethereum-Browser zugreifen?

Warum kann ich nicht auf den Ethereum-Browser zugreifen?

So verwenden Sie die Insert-Anweisung in MySQL

So verwenden Sie die Insert-Anweisung in MySQL

div-Bildlaufleiste

div-Bildlaufleiste

So exportieren Sie Word aus Powerdesigner

So exportieren Sie Word aus Powerdesigner

Was ist der Unterschied zwischen Webstorm und Idee?

Was ist der Unterschied zwischen Webstorm und Idee?

So registrieren Sie sich bei Matcha Exchange

So registrieren Sie sich bei Matcha Exchange

Localstorage-Nutzung

Localstorage-Nutzung

Was soll ich tun, wenn mein iPad nicht aufgeladen werden kann?

Was soll ich tun, wenn mein iPad nicht aufgeladen werden kann?