NULL vs. 0 in C: Welcher ist der bessere Nullzeiger?

Zeiger in C: NULL vs. 0

In den Annalen der C-Programmierung tobt die Debatte darüber: Sollten Sie NULL oder 0 verwenden? (Null) für Nullzeiger? Während einige Programmierer an der Tradition der Verwendung von 0 festhalten, schwören andere auf NULL. Doch welcher Ansatz ist wirklich überlegen?

Ursprünglich war NULL in C aufgrund seiner Definition als (void*)0 unbrauchbar. Mit der Einführung von C 11 änderte sich das Spiel jedoch. Jetzt wird NULL explizit als 0 definiert, wodurch es funktional mit seinem numerischen Gegenstück identisch ist.

Befürworter von 0 argumentieren, dass es eine logischere Wahl zum Testen von Wahrheitswerten ist. Wie der bereitgestellte Codeausschnitt zeigt, passt Null natürlich in logische Vergleiche mit Operatoren wie if (p && !q). Die Verwendung von NULL hingegen erfordert explizite Vergleiche mit NULL, es sei denn, Sie gehen ohnehin davon aus, dass NULL gleich 0 ist, was den Zweck der Benennung zunichte macht.

Bjarne Stroustrup, der Erfinder von C, hat sich zu dieser Angelegenheit geäußert: Daraus geht hervor, dass die Wahl zwischen NULL und 0 weitgehend ästhetischer Natur ist. Allerdings bevorzugt er 0, da er Makros lieber vermeidet und mögliche Fehlinterpretationen im Zusammenhang mit NULL zulassen.

Letztendlich ist die Entscheidung zwischen NULL und 0 eine Frage der persönlichen Präferenz. Beide Ansätze haben ihre Vorzüge. Wählen Sie daher denjenigen aus, der am besten zu Ihrem Codierungsstil passt. Es ist jedoch erwähnenswert, dass C 11 das Schlüsselwort nullptr speziell für diesen Zweck eingeführt hat, sodass es aus Gründen der Klarheit und Konsistenz eine Überlegung wert ist.

Das obige ist der detaillierte Inhalt vonNULL vs. 0 in C: Welcher ist der bessere Nullzeiger?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1655

1655

14

14

1414

1414

52

52

1307

1307

25

25

1253

1253

29

29

1227

1227

24

24

C Sprachdatenstruktur: Datenrepräsentation und Betrieb von Bäumen und Grafiken

Apr 04, 2025 am 11:18 AM

C Sprachdatenstruktur: Datenrepräsentation und Betrieb von Bäumen und Grafiken

Apr 04, 2025 am 11:18 AM

C Sprachdatenstruktur: Die Datenrepräsentation des Baumes und des Diagramms ist eine hierarchische Datenstruktur, die aus Knoten besteht. Jeder Knoten enthält ein Datenelement und einen Zeiger auf seine untergeordneten Knoten. Der binäre Baum ist eine besondere Art von Baum. Jeder Knoten hat höchstens zwei Kinderknoten. Die Daten repräsentieren structTreenode {intdata; structTreenode*links; structTreenode*rechts;}; Die Operation erstellt einen Baumtraversalbaum (Vorbereitung, in Ordnung und späterer Reihenfolge) Suchbauminsertion-Knoten Lösches Knotendiagramm ist eine Sammlung von Datenstrukturen, wobei Elemente Scheitelpunkte sind, und sie können durch Kanten mit richtigen oder ungerechten Daten miteinander verbunden werden, die Nachbarn darstellen.

Die Wahrheit hinter dem Problem der C -Sprachdatei

Apr 04, 2025 am 11:24 AM

Die Wahrheit hinter dem Problem der C -Sprachdatei

Apr 04, 2025 am 11:24 AM

Die Wahrheit über Probleme mit der Dateibetrieb: Dateiöffnung fehlgeschlagen: unzureichende Berechtigungen, falsche Pfade und Datei besetzt. Das Schreiben von Daten fehlgeschlagen: Der Puffer ist voll, die Datei ist nicht beschreibbar und der Speicherplatz ist nicht ausreichend. Andere FAQs: Langsame Dateitraversal, falsche Textdateicodierung und Binärdatei -Leser -Fehler.

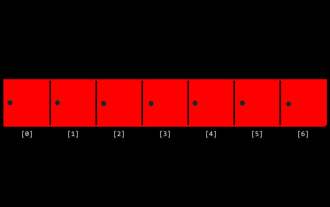

CS-Woche 3

Apr 04, 2025 am 06:06 AM

CS-Woche 3

Apr 04, 2025 am 06:06 AM

Algorithmen sind die Anweisungen zur Lösung von Problemen, und ihre Ausführungsgeschwindigkeit und Speicherverwendung variieren. Bei der Programmierung basieren viele Algorithmen auf der Datensuche und Sortierung. In diesem Artikel werden mehrere Datenabruf- und Sortieralgorithmen eingeführt. Die lineare Suche geht davon aus, dass es ein Array gibt [20.500,10,5,100, 1,50] und die Nummer 50 ermitteln muss. Der lineare Suchalgorithmus prüft jedes Element im Array Eins nach eins nach dem anderen, bis der Zielwert gefunden oder das vollständige Array durchquert wird. Der Algorithmus-Flussdiagramm lautet wie folgt: Der Pseudo-Code für die lineare Suche lautet wie folgt: Überprüfen Sie jedes Element: Wenn der Zielwert gefunden wird: Return Return Falsch C-Sprache Implementierung: #includeIntmain (void) {i

C# gegen C: Geschichte, Evolution und Zukunftsaussichten

Apr 19, 2025 am 12:07 AM

C# gegen C: Geschichte, Evolution und Zukunftsaussichten

Apr 19, 2025 am 12:07 AM

Die Geschichte und Entwicklung von C# und C sind einzigartig, und auch die Zukunftsaussichten sind unterschiedlich. 1.C wurde 1983 von Bjarnestrustrup erfunden, um eine objektorientierte Programmierung in die C-Sprache einzuführen. Sein Evolutionsprozess umfasst mehrere Standardisierungen, z. B. C 11 Einführung von Auto-Keywords und Lambda-Ausdrücken, C 20 Einführung von Konzepten und Coroutinen und sich in Zukunft auf Leistung und Programme auf Systemebene konzentrieren. 2.C# wurde von Microsoft im Jahr 2000 veröffentlicht. Durch die Kombination der Vorteile von C und Java konzentriert sich seine Entwicklung auf Einfachheit und Produktivität. Zum Beispiel führte C#2.0 Generics und C#5.0 ein, die eine asynchrone Programmierung eingeführt haben, die sich in Zukunft auf die Produktivität und das Cloud -Computing der Entwickler konzentrieren.

C Sprach -Multithread -Programmierung: Ein Anfängerleitfaden und Fehlerbehebung

Apr 04, 2025 am 10:15 AM

C Sprach -Multithread -Programmierung: Ein Anfängerleitfaden und Fehlerbehebung

Apr 04, 2025 am 10:15 AM

C Sprachmultithreading -Programmierhandbuch: Erstellen von Threads: Verwenden Sie die Funktion pThread_create (), um Thread -ID, Eigenschaften und Threadfunktionen anzugeben. Threadsynchronisation: Verhindern Sie den Datenwettbewerb durch Mutexes, Semaphoren und bedingte Variablen. Praktischer Fall: Verwenden Sie Multi-Threading, um die Fibonacci-Nummer zu berechnen, mehrere Threads Aufgaben zuzuweisen und die Ergebnisse zu synchronisieren. Fehlerbehebung: Lösen Sie Probleme wie Programmabstürze, Thread -Stop -Antworten und Leistungs Engpässe.

Wie man einen Countdown in der C -Sprache ausgibt

Apr 04, 2025 am 08:54 AM

Wie man einen Countdown in der C -Sprache ausgibt

Apr 04, 2025 am 08:54 AM

Wie gibt ich einen Countdown in C aus? Antwort: Verwenden Sie Schleifenanweisungen. Schritte: 1. Definieren Sie die Variable N und speichern Sie die Countdown -Nummer in der Ausgabe. 2. Verwenden Sie die while -Schleife, um n kontinuierlich zu drucken, bis n weniger als 1 ist; 3. Drucken Sie im Schleifenkörper den Wert von n aus; 4. Am Ende der Schleife subtrahieren Sie N um 1, um den nächsten kleineren gegenseitigen gegenseitigen gegenseitigen gegenseitig auszugeben.

So erhalten Sie das Format der Anruferklärung der Definition der C -Sprachfunktion

Apr 04, 2025 am 06:03 AM

So erhalten Sie das Format der Anruferklärung der Definition der C -Sprachfunktion

Apr 04, 2025 am 06:03 AM

C -Sprachfunktionen umfassen Definitionen, Anrufe und Erklärungen. Funktionsdefinition Gibt den Funktionsnamen, Parametern und Rückgabetyp an, Funktionskörper implementiert Funktionen. Funktionsaufrufe führen Funktionen aus und geben Parameter an. Funktionserklärungen informieren den Compiler des Funktionstyps. Der Wertpass wird für den Parameterpass verwendet, den Rückgabetyp achten, einen konsistenten Codestil beibehalten und Fehler in Funktionen behandeln. Das Beherrschen dieses Wissens kann dazu beitragen, elegante, robuste C -Code zu schreiben.

Ganzzahlen in C: Eine kleine Geschichte

Apr 04, 2025 am 06:09 AM

Ganzzahlen in C: Eine kleine Geschichte

Apr 04, 2025 am 06:09 AM

Ganzzahlen sind der grundlegendste Datentyp in der Programmierung und können als Eckpfeiler der Programmierung angesehen werden. Die Aufgabe eines Programmierers besteht darin, diesen Zahlen Bedeutungen zu geben. Unabhängig davon, wie komplex die Software ist, ist sie letztendlich auf ganzzahlige Operationen ankommt, da der Prozessor nur Ganzzahlen versteht. Um negative Zahlen darzustellen, haben wir Two's Komplement eingeführt. Um Dezimalzahlen darzustellen, haben wir wissenschaftliche Notation erstellt, sodass es schwimmende Punktzahlen gibt. Letztendlich ist alles noch untrennbar mit 0 und 1. Eine kurze Geschichte von Ganzzahlen in C, INT, fast der Standardtyp. Obwohl der Compiler eine Warnung ausgibt, können Sie in vielen Fällen immer noch Code wie diesen schreiben: Main (void) {return0;} aus technischer Sicht, dies entspricht dem folgenden Code: Intmain (void) {return0;}