Vor kurzem habe ich beschlossen, dass ich gerne ein schnelles Web-Scraping- und Datenanalyseprojekt durchführen möchte. Da mein Gehirn gerne große Ideen entwickelt, die viel Zeit in Anspruch nehmen würden, beschloss ich, mich der Herausforderung zu stellen, etwas Einfaches zu finden, das in ein paar Stunden realisierbar wäre.

Hier ist, was ich mir ausgedacht habe:

Da mein Bachelor-Abschluss ursprünglich Fremdsprachen (Französisch und Spanisch) war, dachte ich, es würde Spaß machen, ein paar sprachbezogene Daten im Web zu sammeln. Ich wollte die BeautifulSoup-Bibliothek verwenden, die statisches HTML analysieren kann, aber nicht mit dynamischen Webseiten umgehen kann, die Onclick-Ereignisse benötigen, um den gesamten Datensatz anzuzeigen (z. B. Klicken auf die nächste Datenseite, wenn die Seite paginiert ist).

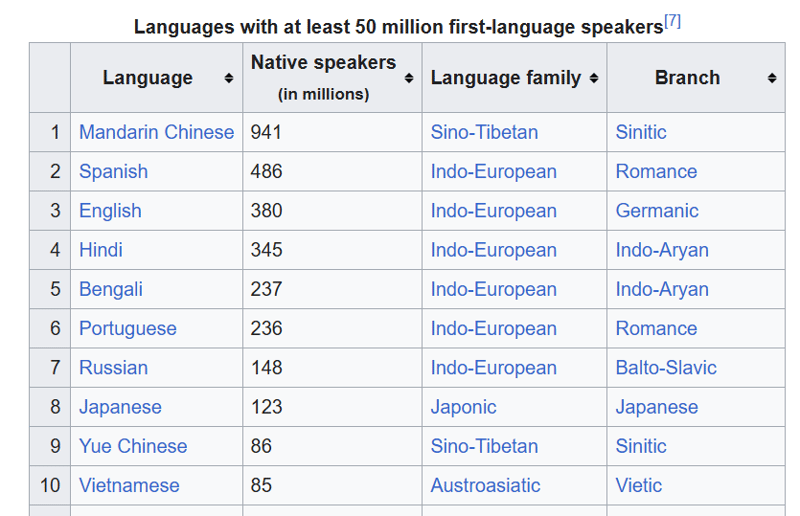

Ich habe mich für diese Wikipedia-Seite der am häufigsten gesprochenen Sprachen entschieden.

Ich wollte Folgendes tun:

Ich habe beschlossen, das Projekt aus Gründen der Interessenstrennung in diese Schritte aufzuteilen, wollte aber auch vermeiden, mehrere unnötige Anfragen zum Abrufen des HTML-Codes von Wikipedia zu stellen, indem ich das Skript erneut ausführe. Wenn Sie die HTML-Datei speichern und dann in einem separaten Skript damit arbeiten, müssen Sie die Daten nicht ständig erneut anfordern, da Sie sie bereits haben.

Der Link zu meinem Github-Repo für dieses Projekt ist: https://github.com/gabrielrowan/Foreign-Languages-Analysis

Zuerst habe ich den HTML-Code abgerufen und ausgegeben. Nachdem ich mit C# und C gearbeitet habe, ist es für mich immer wieder neu, wie kurz und prägnant Python-Code ist?

url = 'https://en.wikipedia.org/wiki/List_of_languages_by_number_of_native_speakers'

response = requests.get(url)

html = response.text

with open("languages_html.txt", "w", encoding="utf-8") as file:

file.write(html)

Um den HTML-Code mit Beautiful Soup zu analysieren und den Tisch auszuwählen, an dem ich interessiert war, habe ich Folgendes getan:

with open("languages_html.txt", "r", encoding="utf-8") as file:

soup = BeautifulSoup(file, 'html.parser')

# get table

top_languages_table = soup.select_one('.wikitable.sortable.static-row-numbers')

Dann habe ich den Tabellenkopftext erhalten, um die Spaltennamen für meinen Pandas-Datenrahmen zu erhalten:

# get column names

columns = top_languages_table.find_all("th")

column_titles = [column.text.strip() for column in columns]

Danach habe ich den Datenrahmen erstellt, die Spaltennamen festgelegt, jede Tabellenzeile abgerufen und jede Zeile in den Datenrahmen geschrieben:

# get table rows

table_data = top_languages_table.find_all("tr")

# define dataframe

df = pd.DataFrame(columns=column_titles)

# get table data

for row in table_data[1:]:

row_data = row.find_all('td')

row_data_txt = [row.text.strip() for row in row_data]

print(row_data_txt)

df.loc[len(df)] = row_data_txt

Hinweis: Ohne die Verwendung von strip() gab es n Zeichen im Text, die nicht benötigt wurden.

Zuletzt habe ich den Datenrahmen in eine CSV-Datei geschrieben.

Im Vorfeld habe ich mir diese Fragen ausgedacht, die ich anhand der Daten beantworten wollte:

Während ich nicht auf den Code eingehen werde, um alle diese Fragen zu beantworten, werde ich auf die beiden Fragen eingehen, bei denen es um Diagramme ging.

Zuerst habe ich einen Datenrahmen erstellt, der nur Zeilen enthielt, deren Zweigname „Romance“ oder „Germanic“ war

url = 'https://en.wikipedia.org/wiki/List_of_languages_by_number_of_native_speakers'

response = requests.get(url)

html = response.text

with open("languages_html.txt", "w", encoding="utf-8") as file:

file.write(html)

Dann habe ich die x-Achse, die y-Achse und die Farbe der Balken angegeben, die ich für das Diagramm haben wollte:

with open("languages_html.txt", "r", encoding="utf-8") as file:

soup = BeautifulSoup(file, 'html.parser')

# get table

top_languages_table = soup.select_one('.wikitable.sortable.static-row-numbers')

Dies wurde erstellt:

Um das Kreisdiagramm zu erstellen, habe ich die drei häufigsten Sprachfamilien abgerufen und diese in einen Datenrahmen eingefügt.

Diese Codegruppe ermittelt die Gesamtsumme der Muttersprachler pro Sprachfamilie, sortiert sie in absteigender Reihenfolge und extrahiert die drei besten Einträge.

# get column names

columns = top_languages_table.find_all("th")

column_titles = [column.text.strip() for column in columns]

Dann trage ich die Daten in ein Kreisdiagramm ein und gebe dabei die Y-Achse von „Muttersprachlern“ und eine Legende an, die farbcodierte Beschriftungen für jede im Diagramm angezeigte Sprachfamilie erstellt.

# get table rows

table_data = top_languages_table.find_all("tr")

# define dataframe

df = pd.DataFrame(columns=column_titles)

# get table data

for row in table_data[1:]:

row_data = row.find_all('td')

row_data_txt = [row.text.strip() for row in row_data]

print(row_data_txt)

df.loc[len(df)] = row_data_txt

Der Code und die Antworten für die restlichen Fragen finden Sie hier. Ich habe Markdown im Notizbuch verwendet, um die Fragen und ihre Antworten aufzuschreiben.

Für meine nächste Iteration eines Web-Scraping- und Datenanalyseprojekts möchte ich die Dinge komplizierter machen mit:

Auch wenn es schnell ging, hat es mir Spaß gemacht, dieses Projekt zu machen. Es hat mich daran erinnert, wie nützlich kurze, überschaubare Projekte sein können, um die Praxisvertreter einzubeziehen? Außerdem macht es Spaß, Daten aus dem Internet zu extrahieren und daraus Diagramme zu erstellen, selbst mit einem kleinen Datensatz?

Das obige ist der detaillierte Inhalt vonWeb Scraping und Analyse fremdsprachiger Daten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Eine vollständige Liste häufig verwendeter öffentlicher DNS

Eine vollständige Liste häufig verwendeter öffentlicher DNS

Tastenkombinationen für Python-Kommentare

Tastenkombinationen für Python-Kommentare

Was sind die Unterschiede zwischen Hibernate und Mybatis?

Was sind die Unterschiede zwischen Hibernate und Mybatis?

So verwenden Sie Left Join

So verwenden Sie Left Join

vcruntime140.dll kann nicht gefunden werden und die Codeausführung kann nicht fortgesetzt werden

vcruntime140.dll kann nicht gefunden werden und die Codeausführung kann nicht fortgesetzt werden

So fügen Sie Seitenzahlen in ppt ein

So fügen Sie Seitenzahlen in ppt ein

So finden Sie den Median eines Arrays in PHP

So finden Sie den Median eines Arrays in PHP

So lösen Sie das Problem, dass Apple nicht mehr als 200 Dateien herunterladen kann

So lösen Sie das Problem, dass Apple nicht mehr als 200 Dateien herunterladen kann