Dieser Artikel untersucht die Verheißungen und Realitäten der Abruf Generation (LAG) in AI. Wir werden die Funktionalität, die potenziellen Vorteile und die realen Herausforderungen von Rag während der Implementierung sowie die entwickelten Lösungen und verbleibenden Fragen untersuchen. Dies liefert ein umfassendes Verständnis der Fähigkeiten von Rag und seiner sich entwickelnden Rolle in AI.

traditionelle generative KI leiden oft unter Verlassenheit auf veraltete Informationen und "halluzinierende" Fakten. Lag befasst sich mit der Bereitstellung der KI mit Echtzeit-Datenzugriff und Verbesserung der Genauigkeit und Relevanz. Es ist jedoch keine universelle Lösung und erfordert eine Anpassung an der spezifischen Anwendung.

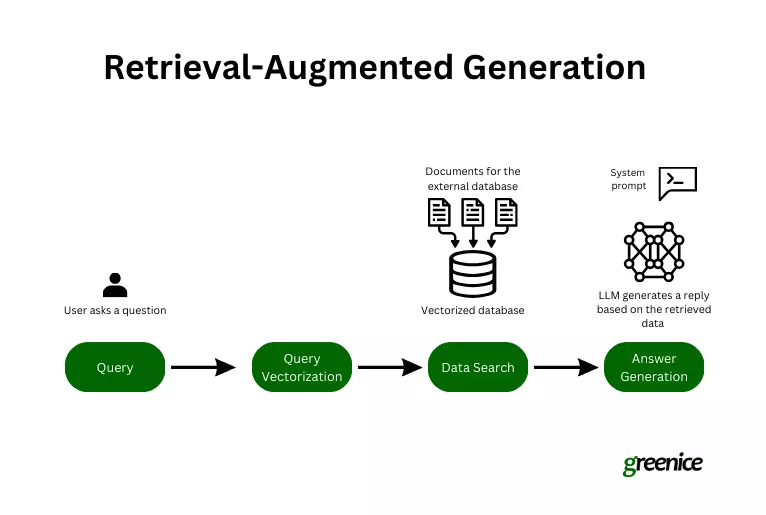

Wie Lag funktioniert:

RAG verbessert generative Modelle, indem externe, aktuelle Informationen während der Reaktionserzeugung einbezogen werden. Der Prozess beinhaltet:

- Abfrage -Initiierung: Der Benutzer stellt eine Frage.

- Codierung zum Abrufen: Die Abfrage wird in Texteinbettungen (digitale Darstellungen) umgewandelt.

- Relevante Datenab Abrufen: Semantische Suche verwendet die Einbettungsdings, um relevante Daten aus einem Datensatz zu finden, wobei sie sich auf Absicht konzentrieren, nicht nur Schlüsselwörter.

- Antwortgenerierung: Das Lag -System kombiniert das Wissen der KI mit den abgerufenen Daten, um eine kontextbezogene Antwort zu erstellen.

Bildquelle

RAG -Entwicklung:

Aufbau eines Lappensystems beinhaltet:

- Datenerfassung: Sammeln relevanter externer Daten (Lehrbücher, Handbücher usw.).

- Datenchunking und Formatierung: Große Datensätze in kleinere, überschaubare Stücke zerlegen.

- Dateneinbettung: Datenbrocken in numerische Vektoren für eine effiziente Analyse konvertieren.

- Datensucheentwicklung: Implementierung der semantischen Suche, um Abfrageabsicht zu verstehen.

- Eingabeaufforderung vorbereiten: Erstellungsaufforderungen, um die Verwendung von abgerufenen Daten durch das LLM zu leiten.

Dieser Prozess erfordert jedoch häufig Anpassungen, um projektspezifische Herausforderungen zu bewältigen.

RAGS Versprechen:

RAG zielt darauf ab, das Abrufen des Informationen zu vereinfachen, indem genauere und relevantere Antworten bereitgestellt werden und die Benutzererfahrung verbessert werden. Es ermöglicht Unternehmen auch, ihre Daten für eine bessere Entscheidungsfindung zu nutzen. Zu den wichtigsten Vorteilen gehören:

- Genauigkeitssteigerung: Verringern falscher Informationen, veraltete Antworten und Vertrauen in unzuverlässige Quellen.

- Konversationssuche: Ermöglichen natürliche, menschliche Interaktionen, um Informationen zu finden.

reale Herausforderungen:

Während er vielversprechend ist, ist Rag keine perfekte Lösung. Unsere Erfahrungen unterstreichen verschiedene Herausforderungen:

- Genauigkeit ist nicht garantiert: Die KI kann Informationen falsch interpretieren oder falsch anrufen.

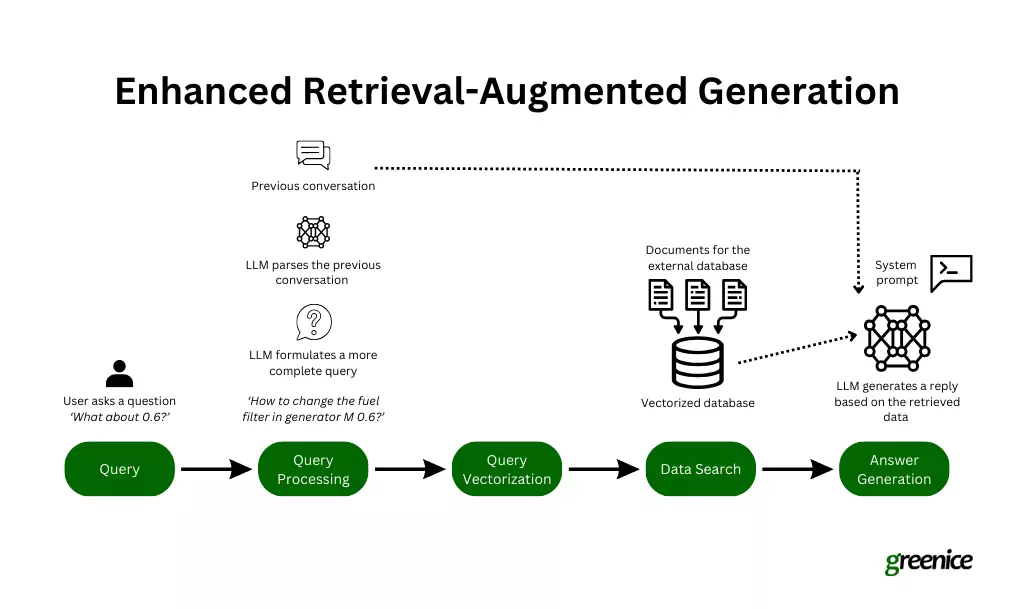

- Nuancen der Konversationssuche: Es ist schwierig

- Datenbanknavigation: effizient durch große Datenbanken suchen ist entscheidend.

- Halluzinationen: Die KI kann Informationen erfinden, wenn Daten nicht verfügbar sind.

- Finden des "Rechten" -Ansatzes: Ein einzelner Lag -Ansatz funktioniert möglicherweise nicht über verschiedene Projekte und Datensätze hinweg.

Key Takeaways und die Zukunft von Lappen:

wichtige Imbissbuden umfassen die Notwendigkeit von Anpassungsfähigkeit, kontinuierlicher Verbesserung und effektives Datenmanagement. Die Zukunft des Rags beinhaltet wahrscheinlich:

Verbessertes kontextbezogenes Verständnis: - Verbessertes NLP, um Konversationsnuancen besser zu handhaben.

umfassendere Implementierung: - breitere Einführung in verschiedenen Branchen.

Innovative Lösungen für bestehende Herausforderungen: - Probleme wie Halluzinationen.

Abschließend bietet RAG ein erhebliches Potenzial, erfordert jedoch eine kontinuierliche Entwicklung und Anpassung, um seine Vorteile vollständig zu nutzen.

Das obige ist der detaillierte Inhalt vonRetrieval-Augmented-Generation: Revolution oder Überverpelz?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!