Solar-10.7b: Ein tiefes Eintauchen in ein hocheffizientes Großsprachmodell

Das Solar-10.7b-Projekt markiert einen signifikanten Fortschritt in der LLM-Entwicklung (Language Model Model). In diesem Artikel wird der innovative Skalierungsansatz, die Leistungsbenchmarks, die praktische Nutzung und potenzielle Anwendungen untersucht und gleichzeitig seine Einschränkungen anerkannt.

entwickelt von Upstage AI in Südkorea, Solar-10.7b ist ein Parametermodell von 10,7 Milliarden Parametern, das auf der LLAMA-2-Architektur basiert. Bemerkenswerterweise übertrifft es andere LLMs mit signifikant größeren Parameterzahlen, einschließlich des Mixtral 8x7b. Für ein umfassendes Verständnis von LLAMA-2 finden Sie in unserem Leitfaden zur Feinabstimmung dieses Modells.

Die Solar-10.7b-Instruct-Variante, eine fein abgestimmte Version, zeichnet sich bei den folgenden komplexen Anweisungen aus. Dies unterstreicht die Leistung der Feinabstimmung, um LLMs für bestimmte Aufgaben zu maßnen. Die Kerninnovation hinter Solar-10.7b ist die Methode der Tiefe Up-Scaling (DUS), die unten beschrieben ist.

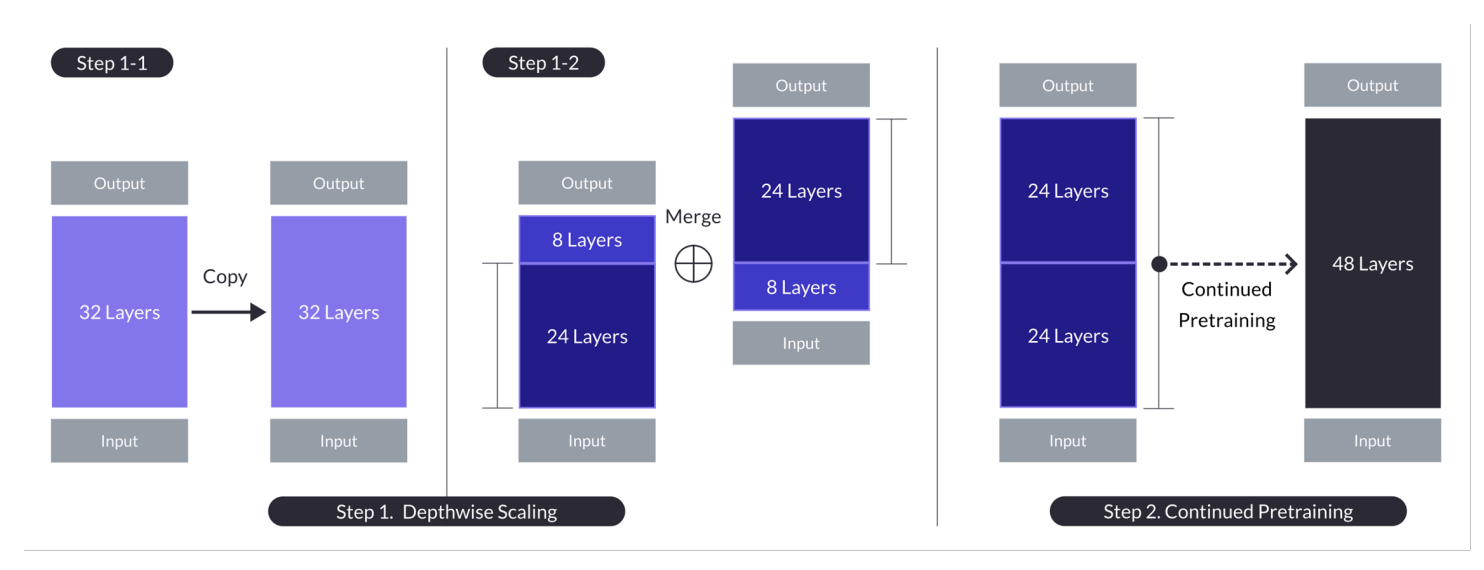

dus ermöglicht die Erhöhung der Tiefe des Modells ohne proportionaler Anstieg der Rechenressourcen. Dies verbessert sowohl Effizienz als auch Leistung. Die Methode basiert auf drei Schlüsselkomponenten: Mistral 7B-Gewichte, das Lama 2-Framework und kontinuierliche Vorversion.

Tiefe Up-Scaling-Abbildung für n = 32, S = 48 und M = 8. Ein zweistufiger Prozess kombiniert die Tiefenskalierung und fortgesetzte Vorausbildung. (Quelle)

Der Prozess beinhaltet:

Dieser mehrstufige Ansatz ermöglicht es Solar-10.7b, die Funktionen weitaus größerer Modelle zu entsprechen oder zu übertreffen, was ihn zu einer kostengünstigen und leistungsstarken Option macht.

Solar-10.7b-Instruktur ist speziell für die komplexe Unterrichtsinterpretation abgestimmt. Dies wird durch Feinabstimmung mithilfe von Open-Source-Datensätzen und synthetisierten mathematischen QA-Datensätzen erreicht, um die mathematische Argumentation zu verbessern. Die Grundlage des Modells in der Lama-2-Architektur bietet ein Gleichgewicht zwischen Geschwindigkeit und Genauigkeit.

Das fein abgestimmte Solar-10.7b-Modell bietet verschiedene Anwendungen:

Dieser Abschnitt enthält eine Schritt-für-Schritt-Anleitung zur Verwendung des Solar-10.7b-Instruct V1.0 GGUF-Modells.

1. Installation:

pip -q install transformers==4.35.2 pip -q install accelerate

2. Bibliotheken importieren:

import torch from transformers import AutoModelForCausalLM, AutoTokenizer

3. GPU -Konfiguration: Stellen Sie sicher, dass eine GPU aktiviert ist (z. B. mit den Laufzeiteinstellungen von Google Colab). Überprüfen Sie mit !nvidia-smi.

4. Modelldefinition:

model_ID = "Upstage/SOLAR-10.7B-Instruct-v1.0" tokenizer = AutoTokenizer.from_pretrained(model_ID) model = AutoModelForCausalLM.from_pretrained(model_ID, device_map="auto", torch_dtype=torch.float16)

5. Modellinferenz und Ergebniserzeugung:

user_request = "What is the square root of 24?"

conversation = [{'role': 'user', 'content': user_request}]

prompt = tokenizer.apply_chat_template(conversation, tokenize=False, add_generation_prompt=True)

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, use_cache=True, max_length=4096)

output_text = tokenizer.decode(outputs[0])

print(output_text)während mächtig, solar-10.7b hat Einschränkungen:

Solar-10.7b stellt einen signifikanten Schritt nach vorne bei der effizienten LLM-Skalierung dar. Die innovative DUS -Methode in Verbindung mit seiner starken Leistung und unterschiedlichen Anwendungen positioniert sie als wertvolles Werkzeug. Die Einschränkungen sollten jedoch berücksichtigt werden. Weitere Erkundungen von LLM-Feinabstimmungen finden Sie in unseren Tutorials zu Flan-T5 und GPT-3.5.

Das obige ist der detaillierte Inhalt vonSolar-10.7b Fine-abgestimmte Modell-Tutorial. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Der Unterschied zwischen PD-Schnellladen und allgemeinem Schnellladen

Der Unterschied zwischen PD-Schnellladen und allgemeinem Schnellladen

So geben Sie den Drucker in Win10 frei

So geben Sie den Drucker in Win10 frei

WAN-Zugriffseinstellungen

WAN-Zugriffseinstellungen

Java-Export Excel

Java-Export Excel

Virtuelle Mobiltelefonnummer, um den Bestätigungscode zu erhalten

Virtuelle Mobiltelefonnummer, um den Bestätigungscode zu erhalten

Der Unterschied zwischen leichtgewichtigen Anwendungsservern und Cloud-Servern

Der Unterschied zwischen leichtgewichtigen Anwendungsservern und Cloud-Servern

Vollständige Sammlung von HTML-Tags

Vollständige Sammlung von HTML-Tags

Die Rolle des Index

Die Rolle des Index