Entsperren Sie die Kraft des systematischen KI -Argumentierens mit Sprachagentenbaumsuche (LATS)

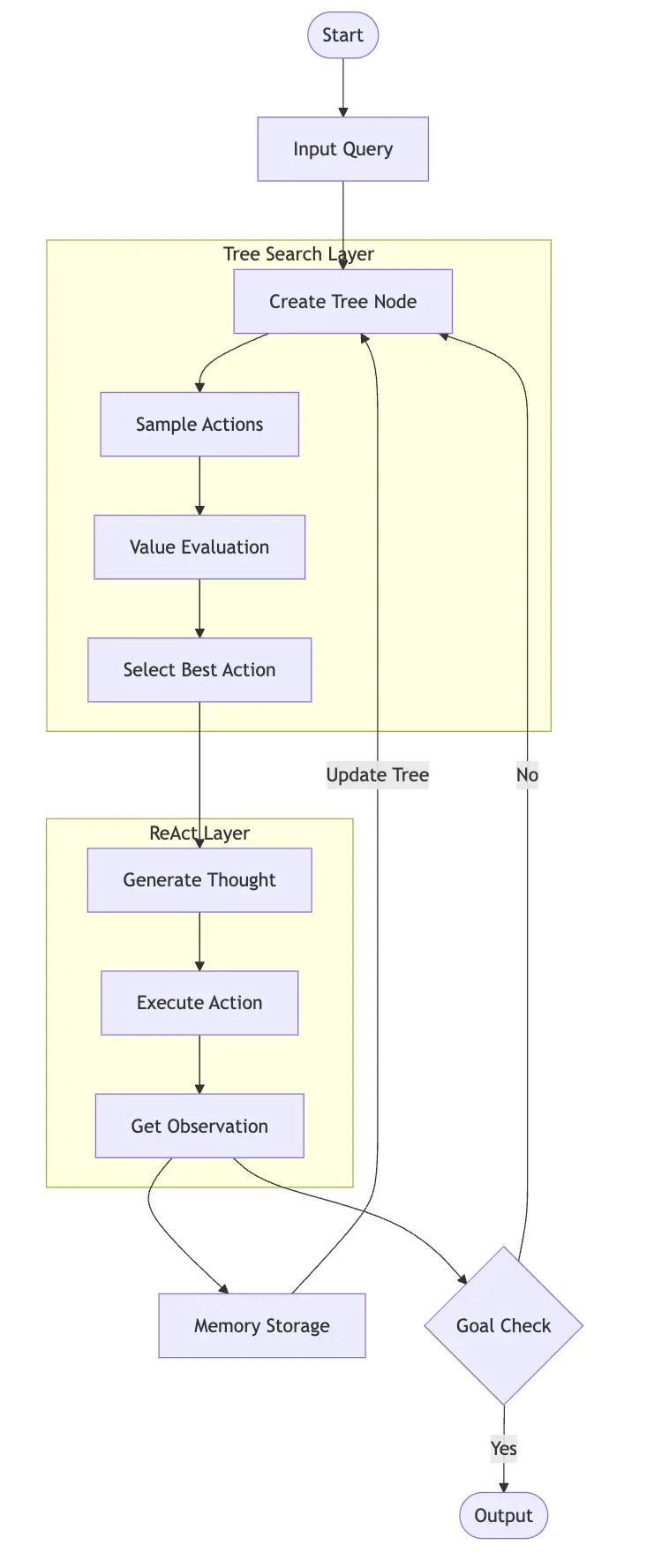

Stellen Sie sich einen KI -Assistenten vor, der nicht nur Ihre Fragen beantwortet, sondern auch systematisch Probleme löst, aus seinen Erfahrungen lernt und strategisch mehrere Schritte vor sich plant. Sprachagenten-Baumsuche (LATS) ist ein hochmodernes AI-Framework, das die methodische Begründung der Reaktionsanforderung mit den strategischen Planungsfunktionen der Monte-Carlo-Baumsuche (MCTs) kombiniert.

lats baut einen umfassenden Entscheidungsbaum auf, untersucht mehrere Lösungen gleichzeitig und verfeinert seinen Entscheidungsprozess durch kontinuierliches Lernen. In diesem Artikel konzentriert sich auf vertikale AI -Agenten und untersucht die praktische Umsetzung von LATS -Agenten unter Verwendung von Llamaindex und Sambanova.ai.

Schlüssellernziele:

(Dieser Artikel ist Teil des Datenwissenschaftsblogathons.)

Inhaltsverzeichnis:

React -Agenten erklärten

React (Argumenting Acting) ist ein Aufforderung, Sprachmodelle zu ermöglichen, Aufgaben durch einen zyklischen Prozess, Handeln und Beobachtung durchzuführen. Stellen Sie sich einen Assistenten vor, der laut nachdenkt, Maßnahmen ergriffen und aus dem Feedback lernt. Der Zyklus ist:

Dieser strukturierte Ansatz ermöglicht es Sprachmodellen, komplexe Probleme zu lösen, fundierte Entscheidungen zu treffen und ihre Strategien anhand der Ergebnisse anzupassen. Beispielsweise kann das Modell in einem mehrstufigen mathematischen Problem relevante Konzepte identifizieren, eine Formel anwenden, die Logik des Ergebnisses bewerten und seinen Ansatz entsprechend anpassen. Dies spiegelt die menschliche Problemlösung wider, was zu zuverlässigeren Ergebnissen führt.

(zuvor abgedeckt: Implementierung des React -Agenten mit Lamaindex und Gemini)

Sprachagenten -Baum -Suchmittel verstehen

Sprachagentsuche (LATS) ist ein erweitertes Framework, das MCTs mit Sprachmodellfunktionen für ausgefeilte Entscheidungsfindung und -planung verschmelzen.

lats arbeitet durch kontinuierliche Erkundung, Bewertung und Lernen, die durch eine Eingabebestandung initiiert werden. Es behält ein Langzeitgedächtnis bei, der einen Suchbaum vergangener Erkundungen und Reflexionen umfasst und zukünftige Entscheidungen leitet.

lats wählt systematisch vielversprechende Pfade aus, tastet an jedem Entscheidungspunkt potenzielle Aktionen ab, bewertet ihren Verdienst anhand einer Wertfunktion und simuliert sie in einen Terminalzustand, um die Wirksamkeit zu messen. Die Codedemonstration veranschaulicht die Baumerweiterung und Bewertung der Bewertung.

Lats und React: Ein synergistischer Ansatz

lats integriert Reacts Gedankenbeobachtungszyklus von React in seine Baumsuche:

Dieser Ansatz ist jedoch rechenintensiv. Lassen Sie uns untersuchen, wann Lats am vorteilhaftesten ist.

Kostenüberlegungen: Wann kann Lats

verwendet werdenWährend Lats übertrifft Cot, React und andere Methoden in Benchmarks, sind seine Rechenkosten erheblich. Komplexe Aufgaben erzeugen zahlreiche Knoten, die zu mehreren LLM -Aufrufen führen, die für Produktionsumgebungen nicht geeignet sind. Echtzeitanwendungen sind aufgrund der Latenz jeder API-Aufruf besonders schwierig. Organisationen müssen sorgfältig die überlegene Entscheidungsfindung gegen Infrastrukturkosten abwägen, insbesondere beim Skalieren.

Verwenden Sie Lats, wenn:

Vermeiden Sie Lats, wenn:

Erstellen eines Empfehlungssystems mit Llamaindex und Lats

Erstellen wir ein Empfehlungssystem mit Lats und LlamaNdex.

Schritt 1: Umgebungsaufbau

Installieren Sie die erforderlichen Pakete:

!pip install llama-index-agent-lats llama-index-core llama-index-readers-file duckduckgo-search llama-index-llms-sambanovasystems import nest_asyncio; nest_asyncio.apply()

Schritt 2: Konfiguration und API -Setup

Richten Sie Ihre Sambanova LLM -API -Taste ein (Ersetzen Sie <your-api-key></your-api-key>):

import os os.environ["SAMBANOVA_API_KEY"] = "<your-api-key>" from llama_index.core import Settings from llama_index.llms.sambanovasystems import SambaNovaCloud llm = SambaNovaCloud(model="Meta-Llama-3.1-70B-Instruct", context_window=100000, max_tokens=1024, temperature=0.7, top_k=1, top_p=0.01) Settings.llm = llm</your-api-key>

Schritt 3: Definieren von Werkzeugsuche (DuckDuckgo)

from duckduckgo_search import DDGS

from llama_index.core.tools import FunctionTool

def search(query:str) -> str:

"""Searches DuckDuckGo for the given query."""

req = DDGS()

response = req.text(query,max_results=4)

context = ""

for result in response:

context += result['body']

return context

search_tool = FunctionTool.from_defaults(fn=search)Schritt 4: llamaindex Agent Runner - Lats

from llama_index.agent.lats import LATSAgentWorker from llama_index.core.agent import AgentRunner agent_worker = LATSAgentWorker(tools=[search_tool], llm=llm, num_expansions=2, verbose=True, max_rollouts=3) agent = AgentRunner(agent_worker)

Schritt 5: Agent

ausführenquery = "Looking for a mirrorless camera under 00 with good low-light performance" response = agent.chat(query) print(response.response)

Schritt 6: Fehlerbehandlung (Beispiel mit agent.list_tasks()) - Dieser Abschnitt enthält eine Methode, um Fälle zu verarbeiten, in denen der Agent "Ich denke immer noch". Der Code ist in der ursprünglichen Eingabe bereitgestellt.

Schlussfolgerung

Lats fährt die AI -Agentenarchitekturen erheblich vor. Obwohl er leistungsstark ist, müssen seine rechnerischen Anforderungen sorgfältig berücksichtigt werden.

häufig gestellte Fragen

Der FAQS -Abschnitt ist im ursprünglichen Eingang enthalten. (Hinweis: Die Erklärung zum Medienbesitz bleibt unverändert.)

Das obige ist der detaillierte Inhalt vonLATS: AI Agent mit Lamaindex für Empfehlungssysteme. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Was ist ein Servomotor?

Was ist ein Servomotor?

Einführung in SEO-Diagnosemethoden

Einführung in SEO-Diagnosemethoden

Was beinhaltet die Datenverschlüsselungsspeicherung?

Was beinhaltet die Datenverschlüsselungsspeicherung?

Was sind die Hauptunterschiede zwischen Linux und Windows?

Was sind die Hauptunterschiede zwischen Linux und Windows?

Ein Speicher, der Informationen direkt mit der CPU austauschen kann, ist ein

Ein Speicher, der Informationen direkt mit der CPU austauschen kann, ist ein

So öffnen Sie eine MDS-Datei

So öffnen Sie eine MDS-Datei

Ändern Sie die Hintergrundfarbe des Wortes in Weiß

Ändern Sie die Hintergrundfarbe des Wortes in Weiß

Welche Entwicklungstools gibt es?

Welche Entwicklungstools gibt es?