Lightrag: Ein leichtes Abruf-Generierungssystem

große Sprachmodelle (LLMs) entwickeln sich schnell weiter, aber die effektive Integration externer Wissen bleibt eine signifikante Hürde. Abrufen-Techniken (Abruf-Augmented Generation) zielen darauf ab, die LLM-Leistung zu verbessern, indem relevante Informationen während der Erzeugung einbezogen werden. Traditionelle Lappensysteme können jedoch komplex und ressourcenintensiv sein. Das HKU Data Science Lab befasst sich mit Lightrag, einer effizienteren Alternative. Lightrag kombiniert die Kraft von Wissensgraphen mit dem Abruf von Vektors und ermöglicht eine effiziente Verarbeitung von Textinformationen gleichzeitig gleichzeitig die strukturierten Beziehungen innerhalb der Daten.

Schlüssellernen:

Warum Lightrag den traditionellen Lappen übertrifft:

traditionelle Lappensysteme haben häufig mit komplexen Beziehungen zwischen Datenpunkten zu kämpfen, was zu fragmentierten Reaktionen führt. Sie verwenden einfache, flache Datendarstellungen, ohne das kontextbezogene Verständnis. Beispielsweise kann eine Abfrage über die Auswirkungen von Elektrofahrzeugen auf die Luftqualität und den öffentlichen Verkehr zu separaten Ergebnissen zu jedem Thema führen und sie nicht sinnvoll anschließen. Lightrag befasst sich mit dieser Einschränkung.

Wie Lightrag funktioniert:

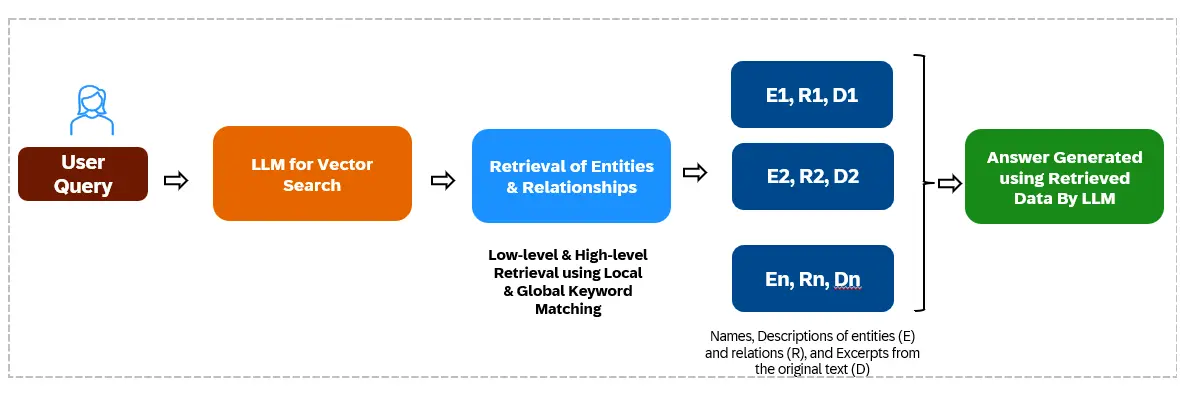

lightag verwendet eine graphbasierte Indexierung und einen Abrufmechanismus auf zwei Ebenen für effiziente und kontextreiche Antworten auf komplexe Abfragen.

Graph-basierte Textindexierung:

Dieser Prozess beinhaltet:

Abruf mit zwei Ebenen:

Lightrag verwendet zwei Abruflevel:

Lightrag vs. GraphRag:

Graphrag leidet aufgrund seiner Community-basierten Durchfahrtsmethode unter einem hohen Tokenverbrauch und zahlreichen LLM-API-Aufrufen. Lightrag, der vektorbasierte Such- und Abzweig-Entitäten/-beziehungen anstelle von Stücken verwendet, reduziert diesen Overhead erheblich.

LightRag Performance Benchmarks:

Lightrag wurde gegen andere Lag-Systeme unter Verwendung von GPT-4O-Mini zur Bewertung in vier Domänen (landwirtschaftliche, Informatik, legale und gemischte) untersucht. Lightrag übertraf die Baselines durchweg, insbesondere in der Vielfalt, insbesondere im größeren rechtlichen Datensatz. Dies unterstreicht die Fähigkeit, verschiedene und reichhaltige Antworten zu erzeugen.

Python-Implementierung von Python (Google Colab):

In den folgenden Schritten wird eine grundlegende Implementierung unter Verwendung von OpenAI -Modellen vorhanden:

Schritt 1: Installieren Sie Bibliotheken

!pip install lightrag-hku aioboto3 tiktoken nano_vectordb !sudo apt update !sudo apt install -y pciutils !pip install langchain-ollama !curl -fsSL https://ollama.com/install.sh | sh !pip install ollama==0.4.2

Schritt 2: Bibliotheken importieren und den API -Schlüssel

festlegenfrom lightrag import LightRAG, QueryParam from lightrag.llm import gpt_4o_mini_complete import os os.environ['OPENAI_API_KEY'] = '' # Replace with your key import nest_asyncio nest_asyncio.apply()

Schritt 3: Lightrag initialisieren und Daten laden

WORKING_DIR = "./content"

if not os.path.exists(WORKING_DIR):

os.mkdir(WORKING_DIR)

rag = LightRAG(working_dir=WORKING_DIR, llm_model_func=gpt_4o_mini_complete)

with open("./Coffe.txt") as f: # Replace with your data file

rag.insert(f.read())Schritt 4 & 5: Abfrage (Hybrid- und naive Modi) (Beispiele im Originaltext angegeben)

Schlussfolgerung:

lightag verbessert das traditionelle Lappensystem erheblich, indem sie ihre Einschränkungen bei der Behandlung komplexer Beziehungen und des kontextuellen Verständnisses angeht. Seine graphbasierte Indexierung und Abruf auf zwei Ebenen führen zu umfassenderen und relevanteren Antworten, was es zu einem wertvollen Fortschritt in diesem Bereich macht.

Key Takeaways:

häufig gestellte Fragen: (ähnlich dem Originaltext, aber für die Selbstverständlichkeit umformuliert) (dieser Abschnitt würde hier enthalten, ähnlich wie das Original.)

(Hinweis: Die Bild -URLs bleiben unverändert.)

Das obige ist der detaillierte Inhalt vonLightrag: Einfache und schnelle Alternative zu Graphrag. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Grundlegende Verwendung der Insert-Anweisung

Grundlegende Verwendung der Insert-Anweisung

So verwenden Sie Return in der C-Sprache

So verwenden Sie Return in der C-Sprache

So ändern Sie element.style

So ändern Sie element.style

So lesen Sie Daten in einer Excel-Datei in Python

So lesen Sie Daten in einer Excel-Datei in Python

Xiaomi-Methode zur Computerdatenwiederherstellung

Xiaomi-Methode zur Computerdatenwiederherstellung

So wechseln Sie auf dem Laptop in den abgesicherten Modus

So wechseln Sie auf dem Laptop in den abgesicherten Modus

So löschen Sie den Index in MySQL

So löschen Sie den Index in MySQL

Verwendung des Python-Re-Moduls

Verwendung des Python-Re-Moduls