Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Umarme Face's Text Generation Inference Toolkit für LLMs - Ein Game Changer in AI

Umarme Face's Text Generation Inference Toolkit für LLMs - Ein Game Changer in AI

Umarme Face's Text Generation Inference Toolkit für LLMs - Ein Game Changer in AI

Nutzen Sie die Kraft des Umarmungsgezwidr -Inferenz (TGI): Ihr lokaler LLM -Server

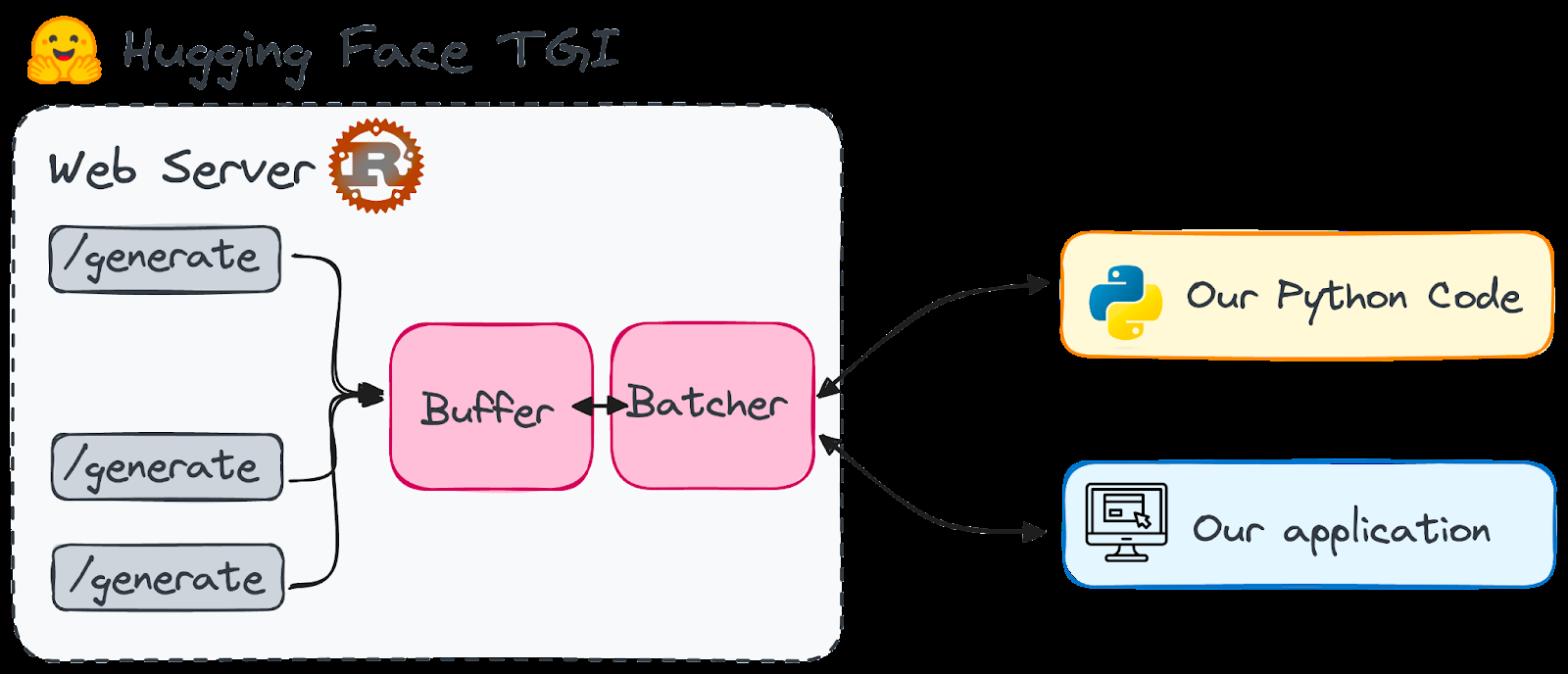

große Sprachmodelle (LLMs) revolutionieren KI, insbesondere in der Textgenerierung. Dies hat zu einem Anstieg der Tools geführt, mit denen die LLM -Bereitstellung vereinfacht wurde. Die Umarmung von Face's Text Generation Inference (TGI) fällt auf und bietet einen leistungsstarken, produktionsbereiten Rahmen für das lokale Ausführen von LLMs als Service. Dieser Leitfaden untersucht die Funktionen von TGI und zeigt, wie man sie für eine ausgefeilte KI -Textgenerierung nutzt.

Umarmung des Gesichts Tgi

verstehen

TGI, ein Rost- und Python -Framework, ermöglicht die Bereitstellung und das Servieren von LLMs auf Ihrer lokalen Maschine. Im Rahmen von HFoilv1.0 lizenziert es für die kommerzielle Verwendung als ergänzendes Instrument. Die wichtigsten Vorteile sind:

- Hochleistungs-Textgenerierung: TGI optimiert die Leistung mithilfe von Tensor-Parallelität und dynamischer Charge für Modelle wie StarCoder, Bloom, GPT-Neox, Lama und T5.

- Effiziente Ressourcenverbrauch: kontinuierliches Batching und optimierter Code minimieren den Ressourcenverbrauch, während mehrere Anforderungen gleichzeitig bearbeitet werden.

- Flexibilität: Es unterstützt Sicherheitsmerkmale wie Wasserzeichen, Logit -Verziehen gegen Vorspannungssteuerung und Stoppsequenzen.

tgi verfügt über optimierte Architekturen für eine schnellere Ausführung von LLMs wie LLAMA, Falcon7b und Mistral (siehe Dokumentation für die vollständige Liste).

Warum wobei ich das Gesicht tgi entscheiden möchte?

Umarmung ist ein zentraler Hub für Open-Source-LLMs. Bisher waren viele Modelle zu ressourcenintensiv für die lokale Nutzung und erforderten Cloud-Dienste. Fortschritte wie Qlora und GPTQ -Quantisierung haben jedoch einige LLMs auf lokalen Maschinen überschaubar gemacht.

TGI löst das Problem der LLM -Startzeit. Indem es das Modell vorbereitet, bietet es sofortige Antworten und beseitigt lange Wartezeiten. Stellen Sie sich vor, Sie hätten einen Endpunkt, der für eine Reihe von erstklassigen Sprachmodellen leicht zugänglich ist.

Die Einfachheit von

TGI ist bemerkenswert. Es ist für den nahtlosen Einsatz von optimierten Modellarchitekturen und Durchführungen mehrere Live -Projekte ausgelegt, darunter:

- Umarmung Chat

- OpenStIssistant

- nat.dev

Wichtiger Hinweis:

TGI ist derzeit nicht mit ARM-basierten GPU-Macs (M1 und später) inkompatibel.Einrichten des umarmenden Gesichts TGI

Es werden zwei Methoden vorgestellt: von Grund auf neu und mit Docker (für den Einfachheit halber empfohlen).

Methode 1: Von Grund auf (komplexer)

- Rost installieren:

curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | sh - Erstellen Sie eine virtuelle Python -Umgebung:

conda create -n text-generation-inference python=3.9 && conda activate text-generation-inference - Protoc Installieren (Version 21.12 Empfohlen): (erfordert

sudo) Anweisungen, die für die Kürze weggelassen werden, siehe den Originaltext. - klonen Sie das Github -Repository:

git clone https://github.com/huggingface/text-generation-inference.git - TGI installieren:

cd text-generation-inference/ && BUILD_EXTENSIONS=False make install

Methode 2: Verwenden von Docker (empfohlen)

- Stellen Sie sicher, dass Docker installiert und ausgeführt wird.

- (Überprüfen Sie zuerst die Kompatibilität) Führen Sie den Befehl Docker aus (Beispiel mit Falcon-7b):

volume=$PWD/data && sudo docker run --gpus all --shm-size 1g -p 8080:80 -v $volume:/data ghcr.io/huggingface/text-generation-inference:0.9 --model-id tiiuae/falcon-7b-instruct --num-shard 1 --quantize bitsandbytesErsetzen Sie"all"durch"0"Wenn Sie eine einzelne GPU verwenden.

Verwenden von TGI in Anwendungen

Interagieren Sie nach dem Start von TGI mit der Postanforderung in den Endpunkt /generate (oder /stream zum Streaming). Beispiele mit Python und Curl finden Sie im Originaltext. Die text-generation Python -Bibliothek (pip install text-generation) vereinfacht die Interaktion.

Praktische Tipps und weiteres Lernen

- Verstehen Sie die Grundlagen der LLM: Machen Sie sich mit Tokenisierung, Aufmerksamkeitsmechanismen und der Transformer -Architektur vertraut.

- Modelloptimierung: Erfahren Sie, wie Sie Modelle vorbereiten und optimieren, einschließlich der Auswahl des richtigen Modells, der Anpassung von Tokenizern und Feinabstimmung.

- Generationsstrategien: Erforschen Sie verschiedene Strategien zur Erzeugung von Text (Gierige Suche, Strahlsuche, Top-K-Stichprobene).

Schlussfolgerung

Umarmung Face TGI bietet eine benutzerfreundliche Möglichkeit zum Bereitstellen und Host-LLMs lokal und bietet Vorteile wie Datenschutz und Kostenkontrolle. Die jüngsten Fortschritte machen es für viele Benutzer möglich. Weitere Untersuchungen fortschrittlicher LLM -Konzepte und -Ressourcen (im Originaltext genannt) wird für das fortgesetzte Lernen sehr empfohlen.

Das obige ist der detaillierte Inhalt vonUmarme Face's Text Generation Inference Toolkit für LLMs - Ein Game Changer in AI. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1653

1653

14

14

1413

1413

52

52

1306

1306

25

25

1251

1251

29

29

1224

1224

24

24

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Metas Lama 3.2: Ein Sprung nach vorne in der multimodalen und mobilen KI Meta hat kürzlich Lama 3.2 vorgestellt, ein bedeutender Fortschritt in der KI mit leistungsstarken Sichtfunktionen und leichten Textmodellen, die für mobile Geräte optimiert sind. Aufbau auf dem Erfolg o

10 generative AI -Codierungsweiterungen im VS -Code, die Sie untersuchen müssen

Apr 13, 2025 am 01:14 AM

10 generative AI -Codierungsweiterungen im VS -Code, die Sie untersuchen müssen

Apr 13, 2025 am 01:14 AM

Hey da, codieren Ninja! Welche Codierungsaufgaben haben Sie für den Tag geplant? Bevor Sie weiter in diesen Blog eintauchen, möchte ich, dass Sie über all Ihre Coding-Leiden nachdenken-die Auflistung auflisten diese auf. Erledigt? - Lassen Sie ’

Verkauf von KI -Strategie an Mitarbeiter: Shopify -CEO Manifesto

Apr 10, 2025 am 11:19 AM

Verkauf von KI -Strategie an Mitarbeiter: Shopify -CEO Manifesto

Apr 10, 2025 am 11:19 AM

Das jüngste Memo von Shopify -CEO Tobi Lütke erklärt kühn für jeden Mitarbeiter eine grundlegende Erwartung und kennzeichnet eine bedeutende kulturelle Veränderung innerhalb des Unternehmens. Dies ist kein flüchtiger Trend; Es ist ein neues operatives Paradigma, das in P integriert ist

AV -Bytes: META ' S Lama 3.2, Googles Gemini 1.5 und mehr

Apr 11, 2025 pm 12:01 PM

AV -Bytes: META ' S Lama 3.2, Googles Gemini 1.5 und mehr

Apr 11, 2025 pm 12:01 PM

Die KI -Landschaft dieser Woche: Ein Wirbelsturm von Fortschritten, ethischen Überlegungen und regulatorischen Debatten. Hauptakteure wie OpenAI, Google, Meta und Microsoft haben einen Strom von Updates veröffentlicht, von bahnbrechenden neuen Modellen bis hin zu entscheidenden Verschiebungen in LE

GPT-4O gegen OpenAI O1: Ist das neue OpenAI-Modell den Hype wert?

Apr 13, 2025 am 10:18 AM

GPT-4O gegen OpenAI O1: Ist das neue OpenAI-Modell den Hype wert?

Apr 13, 2025 am 10:18 AM

Einführung OpenAI hat sein neues Modell auf der Grundlage der mit Spannung erwarteten „Strawberry“ -Scharchitektur veröffentlicht. Dieses innovative Modell, bekannt als O1

Ein umfassender Leitfaden zu Vision Language Models (VLMs)

Apr 12, 2025 am 11:58 AM

Ein umfassender Leitfaden zu Vision Language Models (VLMs)

Apr 12, 2025 am 11:58 AM

Einführung Stellen Sie sich vor, Sie gehen durch eine Kunstgalerie, umgeben von lebhaften Gemälden und Skulpturen. Was wäre, wenn Sie jedem Stück eine Frage stellen und eine sinnvolle Antwort erhalten könnten? Sie könnten fragen: „Welche Geschichte erzählst du?

Wie füge ich eine Spalte in SQL hinzu? - Analytics Vidhya

Apr 17, 2025 am 11:43 AM

Wie füge ich eine Spalte in SQL hinzu? - Analytics Vidhya

Apr 17, 2025 am 11:43 AM

SQL -Änderungstabellanweisung: Dynamisches Hinzufügen von Spalten zu Ihrer Datenbank Im Datenmanagement ist die Anpassungsfähigkeit von SQL von entscheidender Bedeutung. Müssen Sie Ihre Datenbankstruktur im laufenden Flug anpassen? Die Änderungstabelleerklärung ist Ihre Lösung. Diese Anleitung Details Hinzufügen von Colu

Lesen des AI-Index 2025: Ist AI Ihr Freund, Feind oder Co-Pilot?

Apr 11, 2025 pm 12:13 PM

Lesen des AI-Index 2025: Ist AI Ihr Freund, Feind oder Co-Pilot?

Apr 11, 2025 pm 12:13 PM

Der Bericht des Stanford University Institute for Human-orientierte künstliche Intelligenz bietet einen guten Überblick über die laufende Revolution der künstlichen Intelligenz. Interpretieren wir es in vier einfachen Konzepten: Erkenntnis (verstehen, was geschieht), Wertschätzung (Sehenswürdigkeiten), Akzeptanz (Gesichtsherausforderungen) und Verantwortung (finden Sie unsere Verantwortlichkeiten). Kognition: Künstliche Intelligenz ist überall und entwickelt sich schnell Wir müssen uns sehr bewusst sein, wie schnell künstliche Intelligenz entwickelt und ausbreitet. Künstliche Intelligenzsysteme verbessern sich ständig und erzielen hervorragende Ergebnisse bei mathematischen und komplexen Denktests, und erst vor einem Jahr haben sie in diesen Tests kläglich gescheitert. Stellen Sie sich vor, KI zu lösen komplexe Codierungsprobleme oder wissenschaftliche Probleme auf Graduiertenebene-seit 2023-