Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

So erstellen Sie einen Chatbot mithilfe der OpenAI -API & Pinecone

So erstellen Sie einen Chatbot mithilfe der OpenAI -API & Pinecone

So erstellen Sie einen Chatbot mithilfe der OpenAI -API & Pinecone

llm Chatbots: revolutionieren Konversations -KI mit Abruf Augmented Generation (RAG)

Seit dem Start von Chatgpt November 2022 sind Chatbots mit großer Sprachmodell (LLM) allgegenwärtig geworden und transformiert verschiedene Anwendungen. Während das Konzept der Chatbots nicht neu ist - viele ältere Chatbots waren übermäßig komplex und frustrierend -, haben die Plms das Feld wiederbelebt. Dieser Blog untersucht die Leistung von LLMs, die RAG -Technik (Abruf Augmented Generation) und wie Sie Ihren eigenen Chatbot mit OpenAIs GPT -API und Tinecone erstellen.

Diese Anleitung deckt:

- Abruf Augmented Generation (RAG)

- große Sprachmodelle (LLMs)

- unter Verwendung von OpenAI GPT und anderen APIs

- Vektordatenbanken und ihre Notwendigkeit

- Erstellen eines Chatbots mit Pinecone und Openai in Python

Erforschen Sie für einen tieferen Tauchgang unsere Kurse in Vektordatenbanken für Einbettungen mit PineCone und dem Code-Along auf Chatbots mit OpenAI-API und Pinecone

.

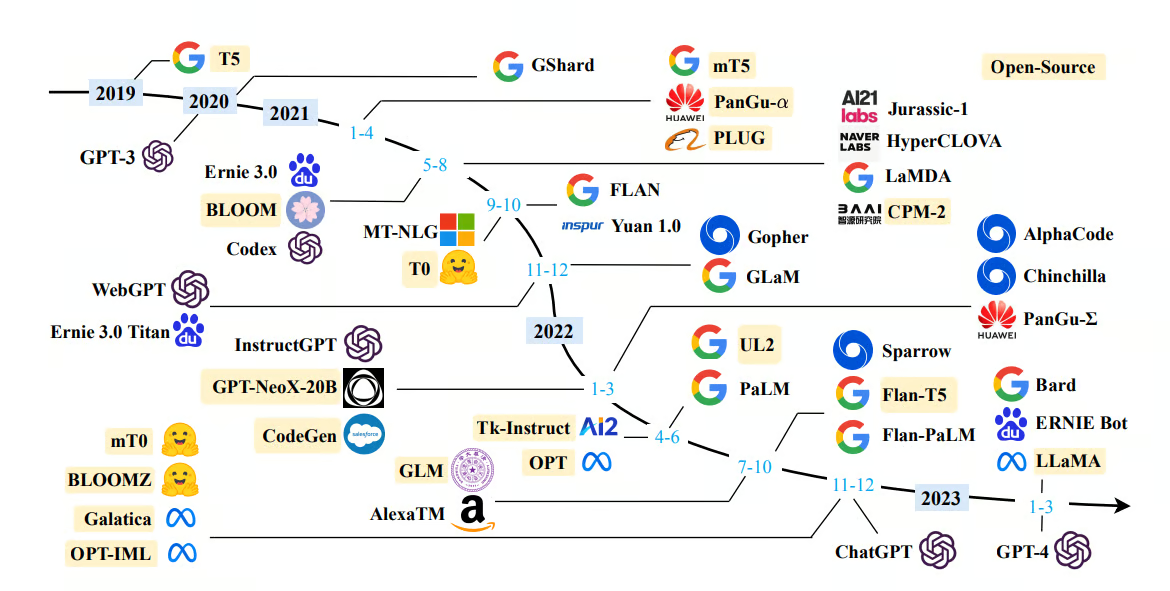

große Sprachmodelle (LLMs)

Bildquelle

llms wie GPT-4 sind ausgefeilte Algorithmen für maschinelles Lernen, die tiefes Lernen (insbesondere Transformer-Architektur) verwenden, um menschliche Sprache zu verstehen und zu generieren. Auf massiven Datensätze (Billionen von Wörtern aus verschiedenen Online -Quellen) erledigen sie komplexe Sprachaufgaben.

llms excel bei der Textgenerierung in verschiedenen Stilen und Formaten, vom kreativen Schreiben bis zur technischen Dokumentation. Zu ihren Fähigkeiten zählen Summarisierung, Konversations -KI und Sprachübersetzung, die häufig differenzierte Sprachmerkmale erfassen.

LLMs haben jedoch Einschränkungen. "Halluzinationen" - generierende plausible, aber falsche Informationen - und Verzerrungen aus Trainingsdaten sind erhebliche Herausforderungen. Während LLMs einen großen KI -Fortschritt darstellen, ist das sorgfältige Management von entscheidender Bedeutung, um Risiken zu mildern.

Abruf Augmented Generation (RAG)

Bildquelle

llms 'Einschränkungen (veraltete, generische oder falsche Informationen aufgrund von Datenbeschränkungen oder "Halluzinationen") werden von RAG behandelt. RAG verbessert die Genauigkeit und Vertrauenswürdigkeit, indem sie LLMs anweisen, relevante Informationen aus bestimmten Quellen abzurufen. Dies gibt Entwicklern mehr Kontrolle über LLM -Antworten.

Der Lag -Prozess (vereinfacht)

(Ein detailliertes Lag -Tutorial ist separat erhältlich.)

- Datenvorbereitung: externe Daten (z. B. aktuelle Forschung, Nachrichten) werden vorbereitet und in ein von der LLM verwendete Format (Einbettungen) umgewandelt.

- Einbettungspeicher: Einbettungen werden in einer Vektordatenbank (wie Pinecone) gespeichert, die für ein effizientes Abrufen von Vektordaten optimiert ist.

- Informationsab Abrufen: Eine semantische Suche mit der Abfrage des Benutzers (in einen Vektor konvertiert) ruft die relevantesten Informationen aus der Datenbank ab.

- Einheitliche Augmentation: Abgerufene Daten und die Benutzerabfrage erweitern die LLM -Eingabeaufforderung, was zu genaueren Antworten führt.

- Datenaktualisierungen: externe Daten werden regelmäßig aktualisiert, um die Genauigkeit zu erhalten.

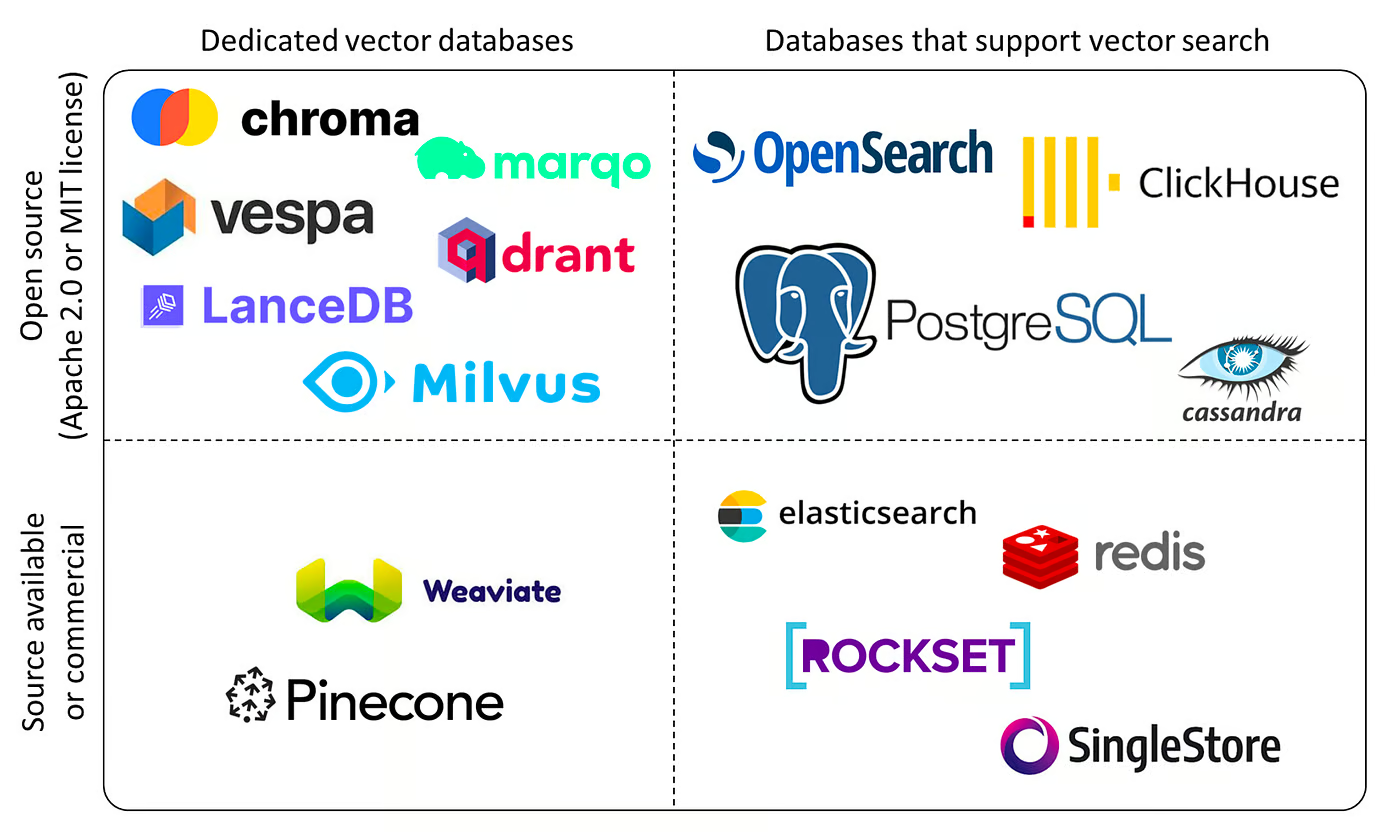

Vektordatenbanken

Bildquelle

Vektordatenbanken verwalten hochdimensionale Vektoren (mathematische Datendarstellungen). Sie zeichnen sich bei Ähnlichkeitssuche auf der Grundlage der Vektorentfernung aus und ermöglichen eine semantische Abfrage. Zu den Anwendungen gehören ähnliche Bilder, Dokumente oder Produkte. PineCone ist ein beliebtes, effizientes und benutzerfreundliches Beispiel. Die fortschrittlichen Indexierungstechniken sind ideal für RAG -Anwendungen.

openai api

Die API von OpenAI bietet Zugriff auf Modelle wie GPT, Dall-E und Whisper. Über HTTP -Anforderungen (oder mit der openai -Bibliothek von Python vereinfacht) zugänglich und ist leicht in verschiedene Programmiersprachen integriert.

Python Beispiel:

import os

os.environ["OPENAI_API_KEY"] = "YOUR_API_KEY"

from openai import OpenAI

client = OpenAI()

completion = client.chat.completions.create(

model="gpt-4",

messages=[

{"role": "system", "content": "You are expert in Machine Learning."},

{"role": "user", "content": "Explain how does random forest works?."}

]

)

print(completion.choices[0].message)Langchain (Framework -Übersicht)

Langchain vereinfacht die LLM -Anwendungsentwicklung. Obwohl es mächtig ist, steht es immer noch unter aktiver Entwicklung, sodass API -Änderungen möglich sind.

End-to-End-Python-Beispiel: Erstellen eines LLM-Chatbots

Dieser Abschnitt erstellt einen Chatbot mit OpenAI GPT-4 und Tinecone. (Hinweis: Ein Großteil dieses Code ist aus dem offiziellen Tinecone Langchain -Handbuch angepasst.)

1. OpenAI und Tinecone Setup: API -Schlüssel erhalten.

2. Installieren Sie Bibliotheken: Verwenden Sie PIP, um langchain, langchain-community, openai, tiktoken, pinecone-client und pinecone-datasets zu installieren.

3. Beispieldatensatz: Laden Sie einen voreingebetteten Datensatz (z. B. wikipedia-simple-text-embedding-ada-002-100K von pinecone-datasets). (Eine Untergruppe abtastet wird für eine schnellere Verarbeitung empfohlen.)

4. Pinecone Index Setup: Erstellen Sie einen Pinecone -Index (langchain-retrieval-augmentation-fast in diesem Beispiel).

5. Dateninsertion: Verbinden Sie die abgetasteten Daten in den Pinecone -Index.

6. Langchain -Integration: Initialisieren Sie einen Langchain -Vektorspeicher mit dem Pinecone Index und OpenAI -Einbettungen.

7. Abfrage: Verwenden Sie den Vektor Store, um Ähnlichkeitssuche durchzuführen.

8. LLM -Integration: Verwenden Sie ChatOpenAI und RetrievalQA (oder RetrievalQAWithSourcesChain für die Quellzuordnung), um das LLM in den Vektorspeicher zu integrieren.

Schlussfolgerung

Dieser Blog demonstrierte die Kraft von Lappen für den Aufbau zuverlässiger und relevanter LLM-Chatbots. Die Kombination von LLMs, Vector -Datenbanken (wie Pinecone) und Frameworks wie Langchain ermöglicht Entwickler, anspruchsvolle Konversations -KI -Anwendungen zu erstellen. Unsere Kurse bieten weitere Lernmöglichkeiten in diesen Bereichen.

Das obige ist der detaillierte Inhalt vonSo erstellen Sie einen Chatbot mithilfe der OpenAI -API & Pinecone. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1653

1653

14

14

1413

1413

52

52

1306

1306

25

25

1251

1251

29

29

1224

1224

24

24

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Metas Lama 3.2: Ein Sprung nach vorne in der multimodalen und mobilen KI Meta hat kürzlich Lama 3.2 vorgestellt, ein bedeutender Fortschritt in der KI mit leistungsstarken Sichtfunktionen und leichten Textmodellen, die für mobile Geräte optimiert sind. Aufbau auf dem Erfolg o

10 generative AI -Codierungsweiterungen im VS -Code, die Sie untersuchen müssen

Apr 13, 2025 am 01:14 AM

10 generative AI -Codierungsweiterungen im VS -Code, die Sie untersuchen müssen

Apr 13, 2025 am 01:14 AM

Hey da, codieren Ninja! Welche Codierungsaufgaben haben Sie für den Tag geplant? Bevor Sie weiter in diesen Blog eintauchen, möchte ich, dass Sie über all Ihre Coding-Leiden nachdenken-die Auflistung auflisten diese auf. Erledigt? - Lassen Sie ’

Verkauf von KI -Strategie an Mitarbeiter: Shopify -CEO Manifesto

Apr 10, 2025 am 11:19 AM

Verkauf von KI -Strategie an Mitarbeiter: Shopify -CEO Manifesto

Apr 10, 2025 am 11:19 AM

Das jüngste Memo von Shopify -CEO Tobi Lütke erklärt kühn für jeden Mitarbeiter eine grundlegende Erwartung und kennzeichnet eine bedeutende kulturelle Veränderung innerhalb des Unternehmens. Dies ist kein flüchtiger Trend; Es ist ein neues operatives Paradigma, das in P integriert ist

AV -Bytes: META ' S Lama 3.2, Googles Gemini 1.5 und mehr

Apr 11, 2025 pm 12:01 PM

AV -Bytes: META ' S Lama 3.2, Googles Gemini 1.5 und mehr

Apr 11, 2025 pm 12:01 PM

Die KI -Landschaft dieser Woche: Ein Wirbelsturm von Fortschritten, ethischen Überlegungen und regulatorischen Debatten. Hauptakteure wie OpenAI, Google, Meta und Microsoft haben einen Strom von Updates veröffentlicht, von bahnbrechenden neuen Modellen bis hin zu entscheidenden Verschiebungen in LE

GPT-4O gegen OpenAI O1: Ist das neue OpenAI-Modell den Hype wert?

Apr 13, 2025 am 10:18 AM

GPT-4O gegen OpenAI O1: Ist das neue OpenAI-Modell den Hype wert?

Apr 13, 2025 am 10:18 AM

Einführung OpenAI hat sein neues Modell auf der Grundlage der mit Spannung erwarteten „Strawberry“ -Scharchitektur veröffentlicht. Dieses innovative Modell, bekannt als O1

Ein umfassender Leitfaden zu Vision Language Models (VLMs)

Apr 12, 2025 am 11:58 AM

Ein umfassender Leitfaden zu Vision Language Models (VLMs)

Apr 12, 2025 am 11:58 AM

Einführung Stellen Sie sich vor, Sie gehen durch eine Kunstgalerie, umgeben von lebhaften Gemälden und Skulpturen. Was wäre, wenn Sie jedem Stück eine Frage stellen und eine sinnvolle Antwort erhalten könnten? Sie könnten fragen: „Welche Geschichte erzählst du?

Wie füge ich eine Spalte in SQL hinzu? - Analytics Vidhya

Apr 17, 2025 am 11:43 AM

Wie füge ich eine Spalte in SQL hinzu? - Analytics Vidhya

Apr 17, 2025 am 11:43 AM

SQL -Änderungstabellanweisung: Dynamisches Hinzufügen von Spalten zu Ihrer Datenbank Im Datenmanagement ist die Anpassungsfähigkeit von SQL von entscheidender Bedeutung. Müssen Sie Ihre Datenbankstruktur im laufenden Flug anpassen? Die Änderungstabelleerklärung ist Ihre Lösung. Diese Anleitung Details Hinzufügen von Colu

Lesen des AI-Index 2025: Ist AI Ihr Freund, Feind oder Co-Pilot?

Apr 11, 2025 pm 12:13 PM

Lesen des AI-Index 2025: Ist AI Ihr Freund, Feind oder Co-Pilot?

Apr 11, 2025 pm 12:13 PM

Der Bericht des Stanford University Institute for Human-orientierte künstliche Intelligenz bietet einen guten Überblick über die laufende Revolution der künstlichen Intelligenz. Interpretieren wir es in vier einfachen Konzepten: Erkenntnis (verstehen, was geschieht), Wertschätzung (Sehenswürdigkeiten), Akzeptanz (Gesichtsherausforderungen) und Verantwortung (finden Sie unsere Verantwortlichkeiten). Kognition: Künstliche Intelligenz ist überall und entwickelt sich schnell Wir müssen uns sehr bewusst sein, wie schnell künstliche Intelligenz entwickelt und ausbreitet. Künstliche Intelligenzsysteme verbessern sich ständig und erzielen hervorragende Ergebnisse bei mathematischen und komplexen Denktests, und erst vor einem Jahr haben sie in diesen Tests kläglich gescheitert. Stellen Sie sich vor, KI zu lösen komplexe Codierungsprobleme oder wissenschaftliche Probleme auf Graduiertenebene-seit 2023-