In diesem Artikel wird beschrieben, dass ein RAG-System (Abruf-Augmented Generation) für eine effiziente Abfrageauflösung unter Verwendung von Langchain, Chromadb und Crewai verwendet wird. Es ist ineffizient, das große Volumen der Anfragen, die moderne Unternehmen ausgesetzt sind, manuell umzugehen. Diese KI-betriebene Lösung bietet schnelle, genaue und skalierbare Antworten.

Inhaltsverzeichnis

Warum ein KI-angetanter Abfrageauflösungssystem?

Manuelle Abfragantworten sind langsam und inkonsistent. Unternehmen benötigen schnelle, genaue Informationen zu Zugang zur Erfüllung der Kundenerwartungen. Ein KI-System automatisiert diesen Prozess, steigert die Produktivität und Entscheidungsfindung in verschiedenen Sektoren (Kundenunterstützung, Vertrieb, Finanzen, Gesundheitswesen, E-Commerce).

Den Lag -Workflow verstehen

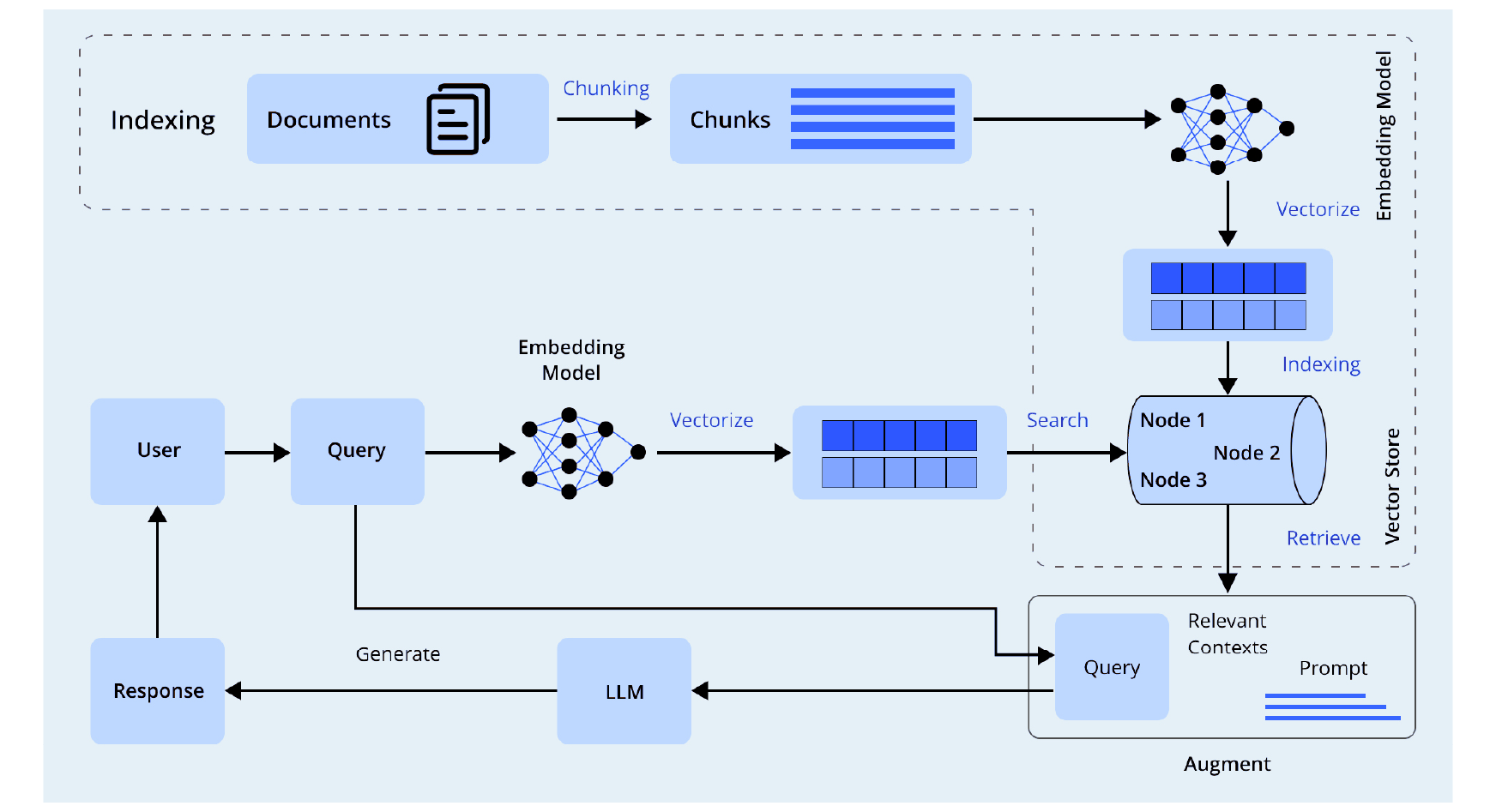

Das Lappensystem arbeitet in drei Phasen:

Aufbau eines Systems zur Auflösung von Abfragen auf Lappen basierend

Dieser Artikel zeigt ein vereinfachtes Lappensystem für die Beantwortung von Abfragen der Lernenden mit einem AI -Agenten. Die Datenauswahl ist von entscheidender Bedeutung. Der Autor experimentierte mit verschiedenen Datentypen (PowerPoint -Folien, FAQs, frühere Diskussionen, Kursvideountertitel), bevor sie sich für Untertitel als effektivste Quelle für die Bereitstellung relevanter, strukturierter Inhalte entschieden.

Das System umfasst drei Komponenten:

Implementierungsdetails

Bibliotheksimporte: pysrt , langchain (Textaufteilung, Einbettung, Vector -Stores), crewai , pandas , ast , os , tqdm werden importiert.

Umgebungsaufbau: Der OpenAI -API -Schlüssel und der Modellname werden als Umgebungsvariablen festgelegt.

Extrahieren und Speichern von Untertiteldaten: Das System iteriert durch Kursordner, extrahiert Text aus SRT -Dateien mithilfe von pysrt , stößt den Text mit RecursiveCharacterTextSplitter , erzeugt Einbettung mit OpenAIEmbeddings und speichert sie in Chromadb. Die Kostenschätzung für die Nutzung der Token ist enthalten.

Abfragen und Antworten auf Abfragen der Lernenden: Eine Funktion retrieve_course_materials verwendet die Ähnlichkeitssuche in Chromadb, um relevante Inhalte abzurufen, die nach Kurs gefiltert werden.

Implementierung des Beantworters der KI -Abfrage: Ein Crewai -Agent ("Learning Support Specialist") ist mit einer bestimmten Rolle und Hintergrundgeschichte definiert. Eine Aufgabe wird definiert, um Abfragen zu behandeln und einen abgerufenen Kontext und frühere Diskussionen einzubeziehen. Die Crewai -Instanz wird initialisiert, und eine Funktion ( reply_to_query ) durch Lernende in einer CSV -Datei durch Lernenden durch die Generierung von Antworten mit dem Agenten. Fehlerbehandlung ist enthalten.

Zukünftige Verbesserungen

Abschluss

Dieses Lag -System, das mit Langchain, Chromadb und Crewai gebaut wurde, automatisiert effizient die Unterstützung der Lernenden. Es verbessert Skalierbarkeit, Abruf und Reaktionsqualität. Zukünftige Verbesserungen werden seine Funktionalität und Genauigkeit verbessern.

Häufig gestellte Fragen

Der FAQS -Abschnitt beantwortet Fragen zu Langchain, Chromadb, Crewai, OpenAI -Einbettungen, Untertitelverarbeitung, Umgang mit mehreren Abfragen und zukünftigen Verbesserungen, die den ursprünglichen Inhalt widerspiegeln.

Das obige ist der detaillierte Inhalt vonAufbau eines Abfrageauflösungssystems auf Lappenbasis mit Langchain. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So exportieren Sie Excel-Dateien aus Kingsoft Documents

So exportieren Sie Excel-Dateien aus Kingsoft Documents

Laptop-Leistung

Laptop-Leistung

So lösen Sie das Problem, dass JS-Code nach der Formatierung nicht ausgeführt werden kann

So lösen Sie das Problem, dass JS-Code nach der Formatierung nicht ausgeführt werden kann

Der Unterschied zwischen Git und SVN

Der Unterschied zwischen Git und SVN

Ist ein Upgrade von Windows 11 notwendig?

Ist ein Upgrade von Windows 11 notwendig?

Der Unterschied zwischen Sass und weniger

Der Unterschied zwischen Sass und weniger

So verbinden Sie HTML-Dateien und CSS-Dateien

So verbinden Sie HTML-Dateien und CSS-Dateien

Einführung in die Online-Rechnersoftware

Einführung in die Online-Rechnersoftware

Der Unterschied zwischen vscode und vs

Der Unterschied zwischen vscode und vs