Wann soll Grus über LSTMs verwendet werden?

Wiederkehrende neuronale Netzwerke: LSTM vs. Gru - ein praktischer Leitfaden

Ich erinnere mich lebhaft daran, dass ich während meiner Kursarbeit wiederkehrende neuronale Netzwerke (RNNs) getroffen habe. Während mich die Sequenzdaten anfänglich faszinierten, wurden die unzähligen Architekturen schnell verwirrend. Die gemeinsame Reaktion des Beraters "Es hängt davon ab", verstärkte meine Unsicherheit nur. Umfangreiche Experimente und zahlreiche Projekte später, mein Verständnis, wann LSTMS gegenüber Grus verwendet werden soll, hat sich erheblich verbessert. Dieser Leitfaden zielt darauf ab, den Entscheidungsprozess für Ihr nächstes Projekt zu klären. Wir werden uns mit den Details von LSTMS und Grus befassen, um Ihnen eine fundierte Wahl zu treffen.

Inhaltsverzeichnis

- LSTM -Architektur: präzise Speicherkontrolle

- Gru Architektur: optimiertes Design

- Leistungsvergleich: Stärken und Schwächen

- Anwendungsspezifische Überlegungen

- Ein praktischer Entscheidungsrahmen

- Hybridansätze und moderne Alternativen

- Abschluss

LSTM -Architektur: präzise Speicherkontrolle

Das 1997 eingeführte lange Kurzzeitgedächtnis (LSTM) -Netzwerke befassen sich mit dem mit traditionellen RNNs inhärenten verschwindenden Gradientenproblem. Ihr Kern ist eine Speicherzelle, die in der Lage ist, Informationen über längere Zeiträume zu erhalten, die von drei Toren verwaltet werden:

- Gate vergessen: Bestimmt, welche Informationen vom Zellzustand abwerfen sollen.

- Eingabetor: Wählt aus, welche Werte im Zellzustand aktualisiert werden sollen.

- Ausgangstor: Steuert, welche Teile des Zellzustands ausgegeben werden.

Diese granulare Kontrolle über den Informationsfluss ermöglicht es LSTMs, Langstreckenabhängigkeiten innerhalb von Sequenzen zu erfassen.

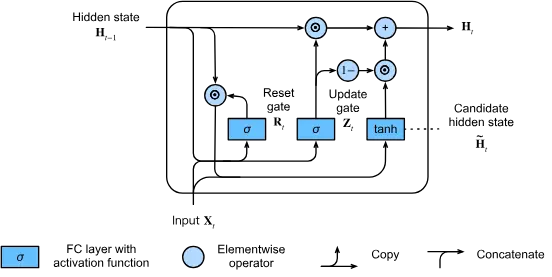

Gru Architektur: optimiertes Design

Die 2014 vorgestellten Gated Recurrent Units (GRUS) vereinfachen die LSTM -Architektur und behalten gleichzeitig einen Großteil seiner Wirksamkeit bei. Grus verwenden nur zwei Tore:

- RESET GATE: Definiert, wie neue Eingaben mit vorhandenem Speicher integriert werden.

- Update Gate: regelt, welche Informationen aus früheren Schritten und was aktualisiert werden soll.

Dieses optimierte Design führt zu einer verbesserten Recheneffizienz und mildern gleichzeitig das Problem der Fluchtgradienten.

Leistungsvergleich: Stärken und Schwächen

Recheneffizienz

Grus Excel In:

- Projekte für Ressourcen.

- Echtzeit-Anwendungen, die schnelle Schlussfolgerung fordern.

- Bereitstellungen für mobile oder Edge Computing.

- Verarbeitung größerer Stapel und längere Sequenzen auf begrenzter Hardware.

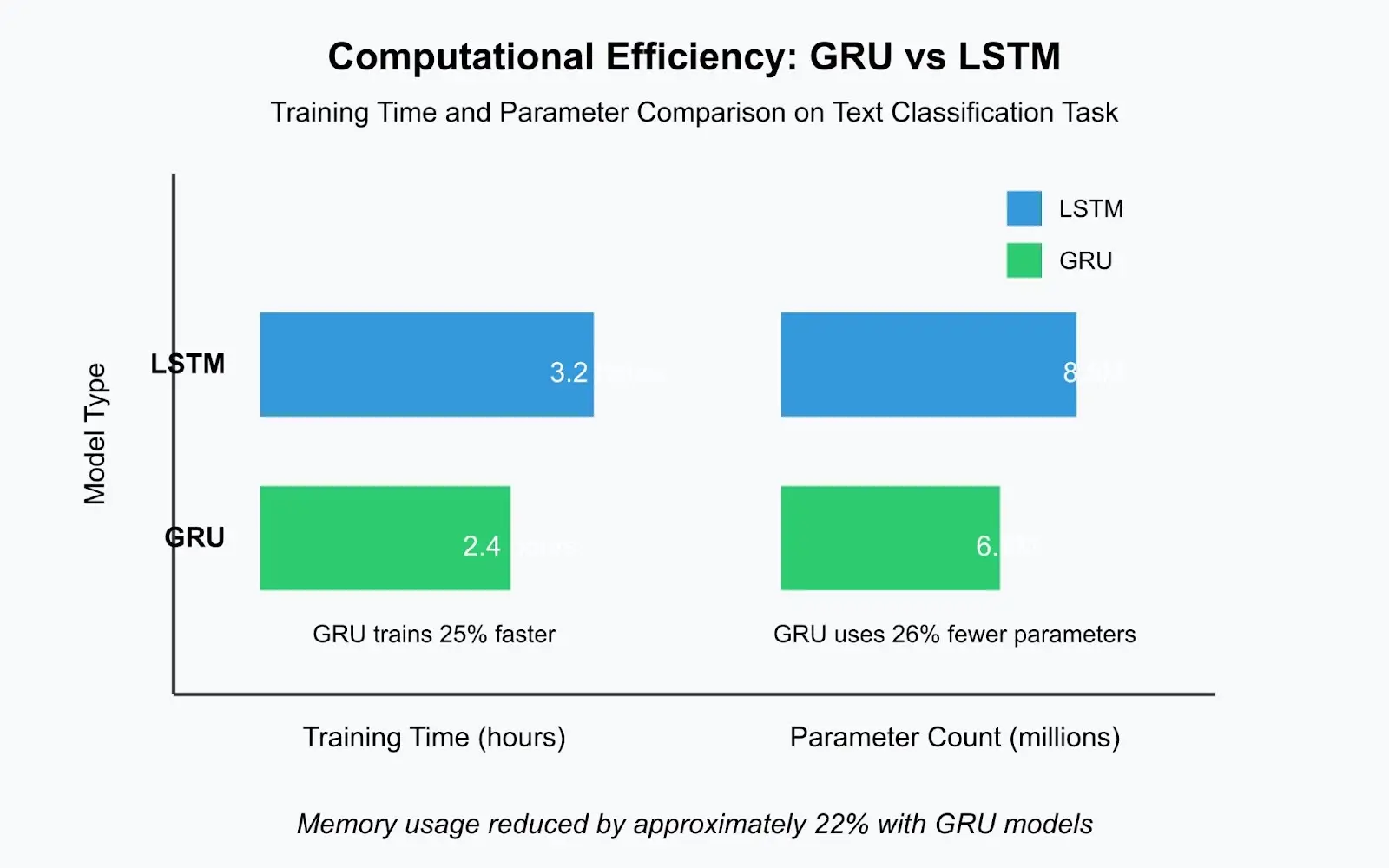

Grus trainiert aufgrund ihrer einfacheren Struktur und weniger Parametern typischerweise 20-30% schneller als vergleichbare LSTMs. In einem kürzlich durchgeführten Textklassifizierungsprojekt wurde ein GRU -Modell in 2,4 Stunden im Vergleich zu 3,2 Stunden eines LSTM ausgebildet - ein wesentlicher Unterschied während der iterativen Entwicklung.

Umgang mit langen Sequenzen

LSTMs sind überlegen für:

- Extrem lange Sequenzen mit komplizierten Abhängigkeiten.

- Aufgaben, die eine präzise Speicherverwaltung erfordern.

- Situationen, in denen das Vergessen von selektiven Informationen entscheidend ist.

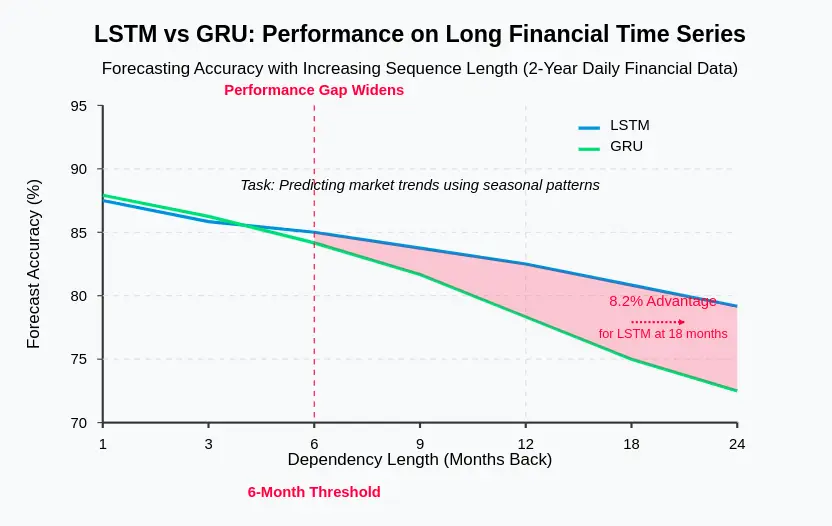

Bei der Prognose für die Finanzzeitreihen, die unter Verwendung jahrelanger täglicher Daten prognostiziert, übertrafen LSTMs den Grus durch konsequent übertroffene Trends, die von mehreren Monaten zuvor auf saisonale Muster abhielten. Die dedizierte Speicherzelle in LSTMS bietet die erforderliche Kapazität für die Aufbewahrung von Langzeitinformationen.

Trainingsstabilität

Gruppe demonstrieren oft:

- Schnellere Konvergenz.

- Reduzierte Überanpassung auf kleinere Datensätze.

- Verbesserte Effizienz bei Hyperparameter -Tuning.

Grus konvergieren häufig schneller und erreicht manchmal eine zufriedenstellende Leistung mit 25% weniger Epochen als LSTMs. Dies beschleunigt das Experimentieren und erhöht die Produktivität.

Modellgröße und Bereitstellung

Grus sind vorteilhaft für:

- Speicherbegrenzte Umgebungen.

- Kundenmodelle Modelle.

- Anwendungen mit strengen Latenzbeschränkungen.

Ein Produktions -LSTM -Sprachmodell für eine Kundendienstanwendung erforderte 42 MB Speicher, während das GRU -Äquivalent nur 31 MB benötigte - eine 26% ige Reduktion, die die Bereitstellung für Edge -Geräte vereinfacht.

Anwendungsspezifische Überlegungen

Verarbeitung natürlicher Sprache (NLP)

Bei den meisten NLP-Aufgaben mit moderaten Sequenzlängen (20-100 Token) führen Grus beim schnelleren Training häufig vergleichsweise oder besser als LSTMs durch. Bei Aufgaben mit sehr langen Dokumenten oder kompliziertem Sprachverständnis können LSTMs jedoch einen Vorteil bieten.

Zeitreihenprognose

Für die Vorhersage mit mehreren saisonalen Mustern oder sehr langfristigen Abhängigkeiten exponieren LSTMS im Allgemeinen. Ihre explizite Gedächtniszelle erfasst komplexe zeitliche Muster effektiv.

Spracherkennung

Bei der Spracherkennung mit moderaten Sequenzlängen übertrifft Grus LSTMs häufig in Bezug auf die Recheneffizienz und bei der Aufrechterhaltung einer vergleichbaren Genauigkeit.

Praktischer Entscheidungsrahmen

Betrachten Sie bei der Auswahl zwischen LSTMS und GRUS die folgenden Faktoren:

- Ressourcenbeschränkungen: Sind Rechenressourcen, Speicher oder Bereitstellungsbeschränkungen ein Problem? (Ja → Grus; Nein →)

- Sequenzlänge: Wie lange dauern Ihre Eingangssequenzen? (Kurzmedium → Grus; sehr lang → LSTMs)

- Problemkomplexität: Bietet die Aufgabe hochkomplexe zeitliche Abhängigkeiten? (Einfach-mittelschwerer → Grus; Komplex → LSTMs)

- Datensatzgröße: Wie viel Trainingsdaten sind verfügbar? (Limited → Grus; reichlich vorhanden → entweder)

- Experimentierzeit: Wie viel Zeit wird für die Modellentwicklung zugewiesen? (Limited → Grus; reichlich → Test beides)

Hybridansätze und moderne Alternativen

Berücksichtigen Sie hybride Ansätze: Verwenden von Grus für Codierung und LSTMS zum Dekodieren, Stapeln verschiedener Schichttypen oder Ensemble -Methoden. Transformator-basierte Architekturen haben LSTMS und GRUS für viele NLP-Aufgaben weitgehend ersetzt, aber wiederkehrende Modelle sind für Zeitreihenanalysen und Szenarien, in denen Aufmerksamkeitsmechanismen rechnerisch teuer sind, wertvoll.

Abschluss

Das Verständnis der Stärken und Schwächen von LSTMS und Grus ist der Schlüssel zur Auswahl der entsprechenden Architektur. Im Allgemeinen sind Grus aufgrund ihrer Einfachheit und Effizienz ein guter Ausgangspunkt. Wechseln Sie nur zu LSTMS, wenn Nachweise auf eine Leistungsverbesserung für Ihre spezifische Anwendung hinweisen. Denken Sie daran, dass effektive Feature -Engineering, Datenvorverarbeitung und Regularisierung häufig einen größeren Einfluss auf die Modellleistung haben als die Auswahl zwischen LSTMS und GRU. Dokumentieren Sie Ihren Entscheidungsprozess und Ihre experimentellen Ergebnisse als zukünftige Referenz.

Das obige ist der detaillierte Inhalt vonWann soll Grus über LSTMs verwendet werden?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1670

1670

14

14

1428

1428

52

52

1329

1329

25

25

1273

1273

29

29

1256

1256

24

24

Wie baue ich multimodale KI -Agenten mit AGNO -Framework auf?

Apr 23, 2025 am 11:30 AM

Wie baue ich multimodale KI -Agenten mit AGNO -Framework auf?

Apr 23, 2025 am 11:30 AM

Während der Arbeit an Agentic AI navigieren Entwickler häufig die Kompromisse zwischen Geschwindigkeit, Flexibilität und Ressourceneffizienz. Ich habe den Agenten-KI-Framework untersucht und bin auf Agno gestoßen (früher war es phi-

Wie füge ich eine Spalte in SQL hinzu? - Analytics Vidhya

Apr 17, 2025 am 11:43 AM

Wie füge ich eine Spalte in SQL hinzu? - Analytics Vidhya

Apr 17, 2025 am 11:43 AM

SQL -Änderungstabellanweisung: Dynamisches Hinzufügen von Spalten zu Ihrer Datenbank Im Datenmanagement ist die Anpassungsfähigkeit von SQL von entscheidender Bedeutung. Müssen Sie Ihre Datenbankstruktur im laufenden Flug anpassen? Die Änderungstabelleerklärung ist Ihre Lösung. Diese Anleitung Details Hinzufügen von Colu

OpenAI-Verschiebungen Fokus mit GPT-4.1, priorisiert die Codierung und Kosteneffizienz

Apr 16, 2025 am 11:37 AM

OpenAI-Verschiebungen Fokus mit GPT-4.1, priorisiert die Codierung und Kosteneffizienz

Apr 16, 2025 am 11:37 AM

Die Veröffentlichung umfasst drei verschiedene Modelle, GPT-4.1, GPT-4.1 Mini und GPT-4.1-Nano, die einen Zug zu aufgabenspezifischen Optimierungen innerhalb der Landschaft des Großsprachenmodells signalisieren. Diese Modelle ersetzen nicht sofort benutzergerichtete Schnittstellen wie

Jenseits des Lama -Dramas: 4 neue Benchmarks für große Sprachmodelle

Apr 14, 2025 am 11:09 AM

Jenseits des Lama -Dramas: 4 neue Benchmarks für große Sprachmodelle

Apr 14, 2025 am 11:09 AM

Schwierige Benchmarks: Eine Lama -Fallstudie Anfang April 2025 stellte Meta seine Lama 4-Suite von Models vor und stellte beeindruckende Leistungsmetriken vor, die sie positiv gegen Konkurrenten wie GPT-4O und Claude 3.5 Sonnet positionierten. Zentral im Launc

Neuer kurzer Kurs zum Einbetten von Modellen von Andrew NG

Apr 15, 2025 am 11:32 AM

Neuer kurzer Kurs zum Einbetten von Modellen von Andrew NG

Apr 15, 2025 am 11:32 AM

Schalte die Kraft des Einbettungsmodelle frei: einen tiefen Eintauchen in den neuen Kurs von Andrew Ng Stellen Sie sich eine Zukunft vor, in der Maschinen Ihre Fragen mit perfekter Genauigkeit verstehen und beantworten. Dies ist keine Science -Fiction; Dank der Fortschritte in der KI wird es zu einem R

Wie ADHS -Spiele, Gesundheitstools und KI -Chatbots die globale Gesundheit verändern

Apr 14, 2025 am 11:27 AM

Wie ADHS -Spiele, Gesundheitstools und KI -Chatbots die globale Gesundheit verändern

Apr 14, 2025 am 11:27 AM

Kann ein Videospiel Angst erleichtern, Fokus aufbauen oder ein Kind mit ADHS unterstützen? Da die Herausforderungen im Gesundheitswesen weltweit steigen - insbesondere bei Jugendlichen - wenden sich Innovatoren einem unwahrscheinlichen Tool zu: Videospiele. Jetzt einer der größten Unterhaltungsindus der Welt

Raketenstartsimulation und -analyse unter Verwendung von Rocketpy - Analytics Vidhya

Apr 19, 2025 am 11:12 AM

Raketenstartsimulation und -analyse unter Verwendung von Rocketpy - Analytics Vidhya

Apr 19, 2025 am 11:12 AM

Simulieren Raketenstarts mit Rocketpy: Eine umfassende Anleitung Dieser Artikel führt Sie durch die Simulation von Rocketpy-Starts mit hoher Leistung mit Rocketpy, einer leistungsstarken Python-Bibliothek. Wir werden alles abdecken, von der Definition von Raketenkomponenten bis zur Analyse von Simula

Google enthüllt die umfassendste Agentenstrategie bei Cloud nächsten 2025

Apr 15, 2025 am 11:14 AM

Google enthüllt die umfassendste Agentenstrategie bei Cloud nächsten 2025

Apr 15, 2025 am 11:14 AM

Gemini als Grundlage der KI -Strategie von Google Gemini ist der Eckpfeiler der AI -Agentenstrategie von Google und nutzt seine erweiterten multimodalen Funktionen, um Antworten auf Text, Bilder, Audio, Video und Code zu verarbeiten und zu generieren. Entwickelt von Deepm