Backend-Entwicklung

Backend-Entwicklung

PHP-Tutorial

PHP-Tutorial

缓存头不起作用<meta http-equiv="Cache-Control" content="max-age=7200" />该怎么处理

缓存头不起作用<meta http-equiv="Cache-Control" content="max-age=7200" />该怎么处理

缓存头不起作用<meta http-equiv="Cache-Control" content="max-age=7200" />该怎么处理

缓存头不起作用

有个问题请教下

在html页面加这句没用不知道什么原因

或有没有什么方法控制单个静态页面缓存时间的方法啊

------解决方案--------------------

------解决方案--------------------

你怎么用的

------解决方案--------------------

看了一下 好像是没起什么作用,甚少用到这个参数,看看是否有其他人能帮你吧。抱歉

------解决方案--------------------

亲,可以试试这个哦.

具体用法可以参考PHP手册的header

header('Last-Modified: '.gmdate('D, d M Y H:i:s', $time).' GMT');

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1664

1664

14

14

1421

1421

52

52

1315

1315

25

25

1266

1266

29

29

1239

1239

24

24

Das erste Open-Source-Modell, das das GPT4o-Niveau übertrifft! Llama 3.1 durchgesickert: 405 Milliarden Parameter, Download-Links und Modellkarten sind verfügbar

Jul 23, 2024 pm 08:51 PM

Das erste Open-Source-Modell, das das GPT4o-Niveau übertrifft! Llama 3.1 durchgesickert: 405 Milliarden Parameter, Download-Links und Modellkarten sind verfügbar

Jul 23, 2024 pm 08:51 PM

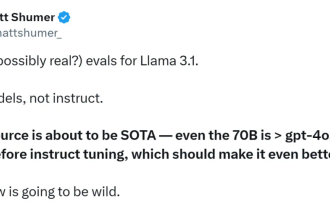

Machen Sie Ihre GPU bereit! Llama3.1 ist endlich erschienen, aber die Quelle ist nicht offiziell von Meta. Heute gingen die durchgesickerten Nachrichten über das neue Llama-Großmodell auf Reddit viral. Zusätzlich zum Basismodell enthält es auch Benchmark-Ergebnisse von 8B, 70B und den maximalen Parameter von 405B. Die folgende Abbildung zeigt die Vergleichsergebnisse jeder Version von Llama3.1 mit OpenAIGPT-4o und Llama38B/70B. Es ist ersichtlich, dass selbst die 70B-Version in mehreren Benchmarks GPT-4o übertrifft. Bildquelle: https://x.com/mattshumer_/status/1815444612414087294 Offensichtlich Version 3.1 von 8B und 70

Sechs schnelle Möglichkeiten, das neu veröffentlichte Llama 3 zu erleben!

Apr 19, 2024 pm 12:16 PM

Sechs schnelle Möglichkeiten, das neu veröffentlichte Llama 3 zu erleben!

Apr 19, 2024 pm 12:16 PM

Gestern Abend hat Meta die Modelle Llama38B und 70B veröffentlicht. Das anweisungsoptimierte Modell Llama3 ist für Dialog-/Chat-Anwendungsfälle optimiert und übertrifft viele bestehende Open-Source-Chat-Modelle in gängigen Benchmarks. Zum Beispiel Gemma7B und Mistral7B. Das Llama+3-Modell verbessert Daten und Skalierung und erreicht neue Höhen. Es wurde mit mehr als 15T Datentokens auf zwei benutzerdefinierten 24K-GPU-Clustern trainiert, die kürzlich von Meta veröffentlicht wurden. Dieser Trainingsdatensatz ist siebenmal größer als Llama2 und enthält viermal mehr Code. Dies bringt die Leistungsfähigkeit des Llama-Modells auf das derzeit höchste Niveau, das Textlängen von mehr als 8 KB unterstützt, doppelt so viel wie Llama2. unter

Das stärkste Modell Llama 3.1 405B wird offiziell veröffentlicht, Zuckerberg: Open Source leitet eine neue Ära ein

Jul 24, 2024 pm 08:23 PM

Das stärkste Modell Llama 3.1 405B wird offiziell veröffentlicht, Zuckerberg: Open Source leitet eine neue Ära ein

Jul 24, 2024 pm 08:23 PM

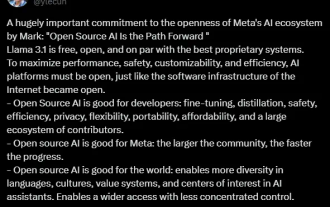

Gerade jetzt wurde das lang erwartete Llama 3.1 offiziell veröffentlicht! Meta gab offiziell bekannt, dass „Open Source eine neue Ära einläutet“. Im offiziellen Blog sagte Meta: „Bis heute sind große Open-Source-Sprachmodelle hinsichtlich Funktionalität und Leistung meist hinter geschlossenen Modellen zurückgeblieben. Jetzt läuten wir eine neue Ära ein, die von Open Source angeführt wird. Wir haben MetaLlama3.1405B öffentlich veröffentlicht.“ , von dem wir glauben, dass es sich um das größte und leistungsfähigste Open-Source-Basismodell der Welt handelt, die Gesamtzahl der Downloads aller Llama-Versionen hat gerade 300 Millionen Mal überschritten, und wir haben gerade erst damit begonnen, eine zu schreiben Artikel. Langer Artikel „OpenSourceAIIsthePathForward“,

Lama3 kommt plötzlich! In der Open-Source-Community brodelt es wieder: Die Ära des freien Zugangs zu Modellen auf GPT4-Ebene ist angebrochen

Apr 19, 2024 pm 12:43 PM

Lama3 kommt plötzlich! In der Open-Source-Community brodelt es wieder: Die Ära des freien Zugangs zu Modellen auf GPT4-Ebene ist angebrochen

Apr 19, 2024 pm 12:43 PM

Lama3 ist da! Gerade wurde die offizielle Website von Meta aktualisiert und die offiziellen Versionen der Parameter Llama 38 Milliarden und 70 Milliarden angekündigt. Und es ist nach seiner Einführung ein Open-Source-SOTA: Offizielle Daten von Meta zeigen, dass die Llama38B- und 70B-Versionen alle Konkurrenten in ihren jeweiligen Parameterskalen übertreffen. Das 8B-Modell übertrifft Gemma7B und Mistral7BInstruct bei vielen Benchmarks wie MMLU, GPQA und HumanEval. Das 70B-Modell hat das beliebte Closed-Source-Brathähnchen Claude3Sonnet übertroffen und ist mit Googles GeminiPro1.5 hin und her gegangen. Sobald der Huggingface-Link veröffentlicht wurde, war die Open-Source-Community wieder aufgeregt. Auch die scharfsichtigen, blinden Schüler entdeckten es sofort

Verstehen Sie gängige Anwendungsszenarien der Webseitenumleitung und verstehen Sie den HTTP-301-Statuscode

Feb 18, 2024 pm 08:41 PM

Verstehen Sie gängige Anwendungsszenarien der Webseitenumleitung und verstehen Sie den HTTP-301-Statuscode

Feb 18, 2024 pm 08:41 PM

Verstehen Sie die Bedeutung des HTTP 301-Statuscodes: Häufige Anwendungsszenarien der Webseitenumleitung. Mit der rasanten Entwicklung des Internets werden die Anforderungen der Menschen an die Webseiteninteraktion immer höher. Im Bereich Webdesign ist die Webseitenumleitung eine gängige und wichtige Technologie, die über den HTTP-301-Statuscode implementiert wird. In diesem Artikel werden die Bedeutung des HTTP 301-Statuscodes und häufige Anwendungsszenarien bei der Webseitenumleitung untersucht. Der HTTP-Statuscode 301 bezieht sich auf eine permanente Weiterleitung (PermanentRedirect). Wenn der Server die des Clients empfängt

Das neue erschwingliche Meta Quest 3S VR-Headset erscheint bei FCC, was auf eine baldige Markteinführung hindeutet

Sep 04, 2024 am 06:51 AM

Das neue erschwingliche Meta Quest 3S VR-Headset erscheint bei FCC, was auf eine baldige Markteinführung hindeutet

Sep 04, 2024 am 06:51 AM

Die Meta Connect 2024-Veranstaltung findet vom 25. bis 26. September statt. Bei dieser Veranstaltung wird das Unternehmen voraussichtlich ein neues erschwingliches Virtual-Reality-Headset vorstellen. Gerüchten zufolge handelt es sich bei dem VR-Headset um das Meta Quest 3S, das offenbar auf der FCC-Liste aufgetaucht ist. Dieser Vorschlag

HTTP 200 OK: Verstehen Sie die Bedeutung und den Zweck einer erfolgreichen Antwort

Dec 26, 2023 am 10:25 AM

HTTP 200 OK: Verstehen Sie die Bedeutung und den Zweck einer erfolgreichen Antwort

Dec 26, 2023 am 10:25 AM

HTTP-Statuscode 200: Erkunden Sie die Bedeutung und den Zweck erfolgreicher Antworten. HTTP-Statuscodes sind numerische Codes, die den Status einer Serverantwort angeben. Darunter zeigt der Statuscode 200 an, dass die Anfrage vom Server erfolgreich verarbeitet wurde. In diesem Artikel wird die spezifische Bedeutung und Verwendung des HTTP-Statuscodes 200 untersucht. Lassen Sie uns zunächst die Klassifizierung von HTTP-Statuscodes verstehen. Statuscodes sind in fünf Kategorien unterteilt, nämlich 1xx, 2xx, 3xx, 4xx und 5xx. Unter diesen zeigt 2xx eine erfolgreiche Antwort an. Und 200 ist der häufigste Statuscode in 2xx

Analyst bespricht Einführungspreise für das gemunkelte Meta Quest 3S VR-Headset

Aug 27, 2024 pm 09:35 PM

Analyst bespricht Einführungspreise für das gemunkelte Meta Quest 3S VR-Headset

Aug 27, 2024 pm 09:35 PM

Seit Metas Erstveröffentlichung von Quest 3 (aktuell 499,99 $ bei Amazon) ist mittlerweile über ein Jahr vergangen. Seitdem hat Apple das deutlich teurere Vision Pro ausgeliefert, während Byte Dance nun in China die Pico 4 Ultra vorgestellt hat. Es gibt jedoch eine