Classes and Objects in PHP5_PHP教程

第 1 页 第一节 面向对象编程 [1]

第 1 页 第一节 面向对象编程 [1] 第 2 页 第二节 对象模型 [2]

第 2 页 第二节 对象模型 [2] 第 3 页 第三节 定义一个类 [3]

第 3 页 第三节 定义一个类 [3] 第 4 页 第四节 构造函数和析构函数 [4]

第 4 页 第四节 构造函数和析构函数 [4] 第 5 页 第五节 克隆 [5]

第 5 页 第五节 克隆 [5] 第 6 页 第六节 访问属性和方法 [6]

第 6 页 第六节 访问属性和方法 [6] 第 7 页 第七节 类的静态成员 [7]

第 7 页 第七节 类的静态成员 [7] 第 8 页 第八节 访问方式 [8]

第 8 页 第八节 访问方式 [8] 第 9 页 第九节 绑定 [9]

第 9 页 第九节 绑定 [9] 第 10 页 第十节 抽象方法和抽象类 [10]

第 10 页 第十节 抽象方法和抽象类 [10] 第 11 页 第十一节 重载 [11]

第 11 页 第十一节 重载 [11] 第 12 页 第十二节 类的自动加载 [12]

第 12 页 第十二节 类的自动加载 [12] 第 13 页 第十三节 对象串行化 [13]

第 13 页 第十三节 对象串行化 [13] 第 14 页 第十四节 命名空间 [14]

第 14 页 第十四节 命名空间 [14] 第 15 页 第十五节 Zend引擎的发展 [15]

第 15 页 第十五节 Zend引擎的发展 [15]

|

|

作者:Leon Atkinson 翻译:Haohappy 面向对象编程被设计来为大型软件项目提供解决方案,尤其是多人合作的项目. 当源代码增长到一万行甚至更多的时候,每一个更动都可能导致不希望的副作用. 这种情况发生于模块间结成秘密联盟的时候,就像第一次世界大战前的欧洲. |

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1359

1359

52

52

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

An der Spitze der Softwaretechnologie kündigte die Gruppe von UIUC Zhang Lingming zusammen mit Forschern der BigCode-Organisation kürzlich das StarCoder2-15B-Instruct-Großcodemodell an. Diese innovative Errungenschaft erzielte einen bedeutenden Durchbruch bei Codegenerierungsaufgaben, übertraf erfolgreich CodeLlama-70B-Instruct und erreichte die Spitze der Codegenerierungsleistungsliste. Die Einzigartigkeit von StarCoder2-15B-Instruct liegt in seiner reinen Selbstausrichtungsstrategie. Der gesamte Trainingsprozess ist offen, transparent und völlig autonom und kontrollierbar. Das Modell generiert über StarCoder2-15B Tausende von Anweisungen als Reaktion auf die Feinabstimmung des StarCoder-15B-Basismodells, ohne auf teure manuelle Annotationen angewiesen zu sein.

Übertrifft DPO umfassend: Das Team von Chen Danqi schlug eine einfache Präferenzoptimierung (SimPO) vor und verfeinerte außerdem das stärkste 8B-Open-Source-Modell

Jun 01, 2024 pm 04:41 PM

Übertrifft DPO umfassend: Das Team von Chen Danqi schlug eine einfache Präferenzoptimierung (SimPO) vor und verfeinerte außerdem das stärkste 8B-Open-Source-Modell

Jun 01, 2024 pm 04:41 PM

Um große Sprachmodelle (LLMs) an menschlichen Werten und Absichten auszurichten, ist es wichtig, menschliches Feedback zu lernen, um sicherzustellen, dass sie nützlich, ehrlich und harmlos sind. Im Hinblick auf die Ausrichtung von LLM ist Reinforcement Learning basierend auf menschlichem Feedback (RLHF) eine wirksame Methode. Obwohl die Ergebnisse der RLHF-Methode ausgezeichnet sind, gibt es einige Herausforderungen bei der Optimierung. Dazu gehört das Training eines Belohnungsmodells und die anschließende Optimierung eines Richtlinienmodells, um diese Belohnung zu maximieren. Kürzlich haben einige Forscher einfachere Offline-Algorithmen untersucht, darunter die direkte Präferenzoptimierung (Direct Preference Optimization, DPO). DPO lernt das Richtlinienmodell direkt auf der Grundlage von Präferenzdaten, indem es die Belohnungsfunktion in RLHF parametrisiert, wodurch die Notwendigkeit eines expliziten Belohnungsmodells entfällt. Diese Methode ist einfach und stabil

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

1. Einleitung In den letzten Jahren haben sich YOLOs aufgrund ihres effektiven Gleichgewichts zwischen Rechenkosten und Erkennungsleistung zum vorherrschenden Paradigma im Bereich der Echtzeit-Objekterkennung entwickelt. Forscher haben das Architekturdesign, die Optimierungsziele, Datenerweiterungsstrategien usw. von YOLO untersucht und erhebliche Fortschritte erzielt. Gleichzeitig behindert die Verwendung von Non-Maximum Suppression (NMS) bei der Nachbearbeitung die End-to-End-Bereitstellung von YOLO und wirkt sich negativ auf die Inferenzlatenz aus. In YOLOs fehlt dem Design verschiedener Komponenten eine umfassende und gründliche Prüfung, was zu erheblicher Rechenredundanz führt und die Fähigkeiten des Modells einschränkt. Es bietet eine suboptimale Effizienz und ein relativ großes Potenzial zur Leistungsverbesserung. Ziel dieser Arbeit ist es, die Leistungseffizienzgrenze von YOLO sowohl in der Nachbearbeitung als auch in der Modellarchitektur weiter zu verbessern. zu diesem Zweck

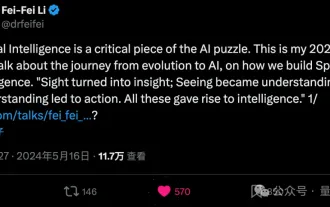

Li Feifei verrät die unternehmerische Ausrichtung der „räumlichen Intelligenz': Visualisierung wird zu Einsicht, Sehen wird zu Verstehen und Verstehen führt zu Handeln

Jun 01, 2024 pm 02:55 PM

Li Feifei verrät die unternehmerische Ausrichtung der „räumlichen Intelligenz': Visualisierung wird zu Einsicht, Sehen wird zu Verstehen und Verstehen führt zu Handeln

Jun 01, 2024 pm 02:55 PM

Stanford Li Feifei stellte das neue Konzept „räumliche Intelligenz“ zum ersten Mal vor, nachdem er sein eigenes Unternehmen gegründet hatte. Dies ist nicht nur ihre unternehmerische Ausrichtung, sondern auch der „Nordstern“, der sie leitet. Sie betrachtet es als „das entscheidende Puzzleteil zur Lösung des Problems der künstlichen Intelligenz“. Visualisierung führt zu Einsicht; Sehen führt zu Verständnis; Verständnis führt zu Handeln. Basierend auf Li Feifeis 15-minütigem TED-Vortrag wird alles umfassend offengelegt, angefangen beim Ursprung der Lebensevolution vor Hunderten von Millionen Jahren, darüber, wie Menschen sich nicht mit dem zufrieden geben, was die Natur ihnen gegeben hat, und künstliche Intelligenz entwickeln, bis hin zur Art und Weise, wie man baut räumliche Intelligenz im nächsten Schritt. Vor neun Jahren stellte Li Feifei auf derselben Bühne der Welt das neugeborene ImageNet vor – einer der Ausgangspunkte für diese Runde der Deep-Learning-Explosion. Sie selbst ermutigte auch die Internetnutzer: Wenn Sie sich beide Videos ansehen, werden Sie die Computer Vision der letzten 10 Jahre verstehen können.

LLM ist fertig! OmniDrive: Integration von 3D-Wahrnehmung und Argumentationsplanung (NVIDIAs neueste Version)

May 09, 2024 pm 04:55 PM

LLM ist fertig! OmniDrive: Integration von 3D-Wahrnehmung und Argumentationsplanung (NVIDIAs neueste Version)

May 09, 2024 pm 04:55 PM

Oben geschrieben und persönliches Verständnis des Autors: Dieses Papier widmet sich der Lösung der wichtigsten Herausforderungen aktueller multimodaler großer Sprachmodelle (MLLMs) in autonomen Fahranwendungen, nämlich dem Problem der Erweiterung von MLLMs vom 2D-Verständnis auf den 3D-Raum. Diese Erweiterung ist besonders wichtig, da autonome Fahrzeuge (AVs) genaue Entscheidungen über 3D-Umgebungen treffen müssen. Das räumliche 3D-Verständnis ist für AVs von entscheidender Bedeutung, da es sich direkt auf die Fähigkeit des Fahrzeugs auswirkt, fundierte Entscheidungen zu treffen, zukünftige Zustände vorherzusagen und sicher mit der Umgebung zu interagieren. Aktuelle multimodale große Sprachmodelle (wie LLaVA-1.5) können häufig nur Bildeingaben mit niedrigerer Auflösung verarbeiten (z. B. aufgrund von Auflösungsbeschränkungen des visuellen Encoders und Einschränkungen der LLM-Sequenzlänge). Allerdings erfordern autonome Fahranwendungen

Die Tsinghua-Universität übernahm und YOLOv10 kam heraus: Die Leistung wurde erheblich verbessert und es stand auf der GitHub-Hotlist

Jun 06, 2024 pm 12:20 PM

Die Tsinghua-Universität übernahm und YOLOv10 kam heraus: Die Leistung wurde erheblich verbessert und es stand auf der GitHub-Hotlist

Jun 06, 2024 pm 12:20 PM

Die Benchmark-Zielerkennungssysteme der YOLO-Serie haben erneut ein großes Upgrade erhalten. Seit der Veröffentlichung von YOLOv9 im Februar dieses Jahres wurde der Staffelstab der YOLO-Reihe (YouOnlyLookOnce) in die Hände von Forschern der Tsinghua-Universität übergeben. Letztes Wochenende erregte die Nachricht vom Start von YOLOv10 die Aufmerksamkeit der KI-Community. Es gilt als bahnbrechendes Framework im Bereich Computer Vision und ist für seine End-to-End-Objekterkennungsfunktionen in Echtzeit bekannt. Es führt das Erbe der YOLO-Serie fort und bietet eine leistungsstarke Lösung, die Effizienz und Genauigkeit vereint. Papieradresse: https://arxiv.org/pdf/2405.14458 Projektadresse: https://github.com/THU-MIG/yo

Mistral AI schlägt GPT-4o in Sekunden und Llama 3 70B in 22B und eröffnet sein erstes Codemodell

Jun 01, 2024 pm 06:32 PM

Mistral AI schlägt GPT-4o in Sekunden und Llama 3 70B in 22B und eröffnet sein erstes Codemodell

Jun 01, 2024 pm 06:32 PM

Das französische KI-Einhorn MistralAI, das auf OpenAI abzielt, hat einen neuen Schritt gemacht: Codestral, das erste große Codemodell, war geboren. Als offenes generatives KI-Modell, das speziell für Codegenerierungsaufgaben entwickelt wurde, unterstützt Codestral Entwickler beim Schreiben und Interagieren mit Code durch die gemeinsame Nutzung von Anweisungen und Vervollständigungs-API-Endpunkten. Die Programmier- und Englischkenntnisse von Codestral ermöglichen es Softwareentwicklern, fortschrittliche KI-Anwendungen zu entwerfen. Die Parametergröße von Codestral beträgt 22B, es entspricht der neuen MistralAINon-ProductionLicense und kann für Forschungs- und Testzwecke verwendet werden, eine kommerzielle Nutzung ist jedoch verboten. Derzeit steht das Modell auf HuggingFace zum Download bereit. Download-Link