Detaillierte Erläuterung der Nginx-Konfigurationsdatei

Nginx Details zur Konfigurationsdatei

user nginx ;

#Benutzer

worker_processes 8 ;

# Der an die Hardware angepasste Arbeitsprozess ist größer oder gleich der CPUAnzahl der Kerne

error_log logs/nginx_error.log crit;

#Fehlerprotokoll

pid logs/nginx.pid;

#pidPlatzierung

worker_rlimit_nofile 204800;

#Gibt den maximalen Deskriptor an, den ein Prozess öffnen kann

Dieser Befehl bezieht sich auf die maximale Anzahl von Dateideskriptoren, die von einem nginx geöffnet werden theoretischer Wert sollte die maximale Anzahl geöffneter Dateien sein

Stückzahl ( ulimit -n) wird durch die Anzahl der Prozesse geteilt nginx, aber nginxAnfragen werden nicht so gleichmäßig verteilt, daher ist es am besten, ulimit zu verwenden -n Der Wert von bleibt konsistent.

Jetzt auf Linux 2.6Die Anzahl der geöffneten Dateien unter dem Kernel beträgt 65535, worker_rlimit_nofile Sie sollten 65535 entsprechend ausfüllen.

Das liegt daran, dass nginxDie Verteilung der Anfragen auf Prozesse während der Planung ist nicht so ausgewogen, wenn Sie also 10240, die gesamte Parallelität erreicht 3-4 Jedes Mal gibt es Prozesse, die überschreiten können 10240, dann 502 Es wird ein Fehler zurückgegeben.

Veranstaltungen

{

Epoll verwenden;

#Verwenden Sie epoll von I/O Modell

Ergänzende Anleitung:

ähnelt Apache, nginx zielt auf verschiedene Betriebssysteme ab sind unterschiedliche Veranstaltungsmodelle

A ) Standard-Event-Modell

Auswählen, Umfrage gehören zum Standard-Ereignismodell Im aktuellen System wählt nginx auswählen oder Umfrage

B) Effizientes Veranstaltungsmodell

Kqueue: wird in FreeBSD verwendet

4.1+, OpenBSD 2.9+, NetBSD 2.0 und MacOS 🎜>MacOS

XDie Systemnutzung von kqueue kann zu einem Kernel-Absturz führen. Epoll:Verwenden Sie für Linux Kernel2.6 Version und neuere Systeme. /dev/poll: verwendet in Solaris

7 11/99+, HP/UX 11.22+ (Eventport), IRIX 6.5.15+ und Tru64 UNIX 5.1A+. Eventport: verwendet in Solaris

10. Um Kernel-Abstürze zu verhindern, ist es notwendig, Sicherheitspatches zu installieren worker_connections 204800; #Die maximale Anzahl der Verbindungen für den Arbeitsprozess wird entsprechend der Hardware angepasst und in Verbindung mit dem verwendet Vorheriger Arbeitsprozess. Es sollte so groß wie möglich sein. Aber nicht CPU auf 100 % ausführen >nur Die maximal zulässige Anzahl von Verbindungen pro Prozess, theoretisch pro Maschine nginxDie maximale Anzahl an Verbindungen für den Server beträgt worker_processes*worker_connections keepalive_timeout 60; keepaliveTimeout. client_header_buffer_size 4k; Die Puffergröße des Client-Anforderungsheaders kann im Allgemeinen entsprechend der Paging-Größe Ihres Systems festgelegt werden , wird die Größe eines Anforderungsheaders 1k nicht überschreiten, sondern weil das allgemeine System-Paging größer als 1k , daher ist dies auf die Seitengröße eingestellt. Seitengröße kann mit dem Befehl verwendet werden getconf PAGESIZE erhalten. [root@web001 ~]# getconf PAGESIZE 4096 Aber es gibt auch client_header_buffer_size überschreitet 4k, aber client_header_buffer_size Dieser Wert muss auf ein ganzzahliges Vielfaches der „System-Paging-Größe“ eingestellt werden. open_file_cache max=65535 inaktiv=60s; Dadurch wird ein Cache zum Öffnen von Dateien angegeben, der standardmäßig nicht aktiviert ist. maxGeben Sie die Anzahl der Caches an. Es wird empfohlen, mit der Anzahl der geöffneten Dateien übereinzustimmen, inaktiv bezieht sich darauf, wie lange die Datei nicht angefordert wurde, bevor der Cache gelöscht wird. open_file_cache_valid 80s; Dies bezieht sich darauf, wie oft die zwischengespeicherten gültigen Informationen überprüft werden. open_file_cache_min_uses 1; open_file_cache im Befehl Die Mindestanzahl, wie oft die Datei innerhalb des Parameters inaktiv verwendet wird. Wenn diese Anzahl überschritten wird, wird der Dateideskriptor immer verwendet im Cache geöffnet. Wenn eine Datei nicht innerhalb der inaktiven-Zeit verwendet wird, wird sie entfernt . } #Einstellungen http Server, der seine Reverse-Proxy-Funktion nutzt, um Lastausgleichsunterstützung bereitzustellen http { include mime.types; #EinstellungenMimetype,type by mime.typeDateidefinition default_type application/octet-stream; log_format main '$host $status [$time_local] $remote_addr [$time_local] $request_uri ' '"$http_referer" "$http_user_agent" "$http_x_forwarded_for " ' '$bytes_sent $request_time $ sent_http_x_cache_hit'; log_format log404 '$status [$time_local] $remote_addr $host$request_uri $sent_http_location'; $remote_addr vs. $http_x_forwarded_for wird verwendet, um die IP Adresse des Kunden zu erfassen; 🎜> $remote_user : wird zum Aufzeichnen des Kundenbenutzernamens verwendet; $time_local:

Wird verwendet, um Zugriffszeit und Zeitzone aufzuzeichnen; $request:

und http Protokoll $status:

Wird zum Aufzeichnen des Anforderungsstatus verwendet; der Erfolg ist , $body_bytes_s ent : Aufzeichnen Senden Geben Sie die Inhaltsgröße der Client-Datei an $http_user_agent NormalerweiseWeb -Adresse des Kunden nicht über abgerufen werden kann $remote_addHolen Sie sich die ist die iPAdresse des Reverse-Proxy-Servers. Der Reverse-Proxy-Server kann in den http-Header-Informationen der Weiterleitung hinzufügen Anfrage. >x_forwarded_for-Informationen werden verwendet, um die IP-Adresse des ursprünglichen Clients und die vom ursprünglichen Client angeforderte Serveradresse aufzuzeichnen ;access_log /dev/null; #Verwendet log_format festgelegt haben, müssen Sie es mit dem Befehl angeben Befehl Protokolldatei-Speicherpfad server_names_hash_bucket_size 128 ; #Hash Die Tabelle wird durch die Anweisungen server_names_hash_max_size und server_names_hash_bucket_size gesteuert. ParameterHash

Die Bucket-Größe entspricht immer der Größe der Hash-Tabelle und ist ein Vielfaches der Prozessor-Cache-Größe. Nachdem die Anzahl der Zugriffe im Speicher reduziert wurde, ist es möglich, die Suche nach Hash Tabellenschlüsselwerten im Prozessor zu beschleunigen. ifHash

Bucket-Größe entspricht der Größe des Prozessorcaches. Bei der Suche nach einem Schlüssel beträgt die Anzahl der Suchvorgänge im Speicher dann im schlimmsten Fall 2 . Das erste Mal besteht darin, die Adresse der Speichereinheit zu ermitteln, und das zweite Mal besteht darin, den Schlüssel in der Speichereinheit zu finden.

Wert. Wenn daher Nginx gegeben ist, muss der Hash erhöht werden

Maximale Größe oder Hash-Bucket-Größe Eingabeaufforderung, dann besteht das erste darin, die Größe des vorherigen Parameters 🎜> 1k , aber da das allgemeine System-Paging größer als getconf ermittelt werden

SEITENGRÖSSE erhalten. nginxStandardmäßig Puffer wenn zu klein eingestelltHTTP Kopfzeile/CookieZu groß

Meldet 400 Fehlernginx

400 schlechte AnfrageWenn sie den Puffer überschreitet, Es wird HTTP gemeldet

414 open_file_cache max 102400 Diese Anweisung gibt an, ob dies geschehen soll Cache Wenn aktiviert ist, zeichnet die folgenden Informationen auf in der Datei :

·Dateideskriptor öffnen,Größeninformationen und Änderungszeit.

·Vorhandene Verzeichnisinformationen ·Fehlermeldung bei der Dateisuche --Keine solche Datei,kann nicht richtig gelesen werden, Referenzopen_file_cache_errorsBefehlsoptionen:·max - Geben Sie die maximale Anzahl an Caches an ,Wenn der Cache überläuft , Die am längsten verwendete Datei open_file_cache_errors open_file_cache_min_uses Syntax: open_file_cache_min_uses number Standardwert :open_file_cache_min_uses

1 Benutzen Sie das Feld : http, Server, Standort dies Befehl Gibt die Mindestanzahl von Dateien an, die innerhalb eines bestimmten Zeitbereichs in den ungültigen Parametern des Befehls open_file_cache ,so wie

Wenn ein größerer Wert verwendet wird, befindet sich der Dateideskriptor im Cache ist immer geöffnet in . Syntax:open_file_cache_valid time Standardwert :open_file_cache_valid

60 Verwenden Sie Felder : http, Server, Standort Diese Anweisung gibt an, wann überprüft werden soll Gültige Informationen für zwischengespeicherte Elemente in open_file_cache. client_max_body_size 300m; Festlegen über nginx Dateigröße hochladen sendfile on; #sendfileBefehlsspezifikation nginx Ob um die Funktion sendfile aufzurufen (Null

Kopieren Methode), um die Datei auszugeben, muss für normale Anwendungen auf Ein gesetzt sein. Wenn die Festplatte für Hochleistungsanwendungen wie das Herunterladen von IO verwendet wird, kann sie auf aus , um Festplatte und Netzwerk IOVerarbeitungsgeschwindigkeit auszugleichen und das System zu reduzieren Betriebszeit. tcp_nopush on; Diese Option ermöglicht oder deaktiviert die Verwendung von Socket > TCP_CORK Option, diese Option wird nur verwendet, wenn sendfile verwendet wird #Timeout für Backend-Serververbindung_ Handshake einleiten und auf Antwort-Timeout warten

# Nach erfolgreich Verbindung_Warten auf Antwortzeit des Backend-Servers_Tatsächlich ist es so trat in die Back-End-Warteschlange ein und wartete auf die Verarbeitung (es kann auch gesagt werden, dass es sich um die Zeit handelt, die der Back-End-Server benötigt, um die Anfrage zu verarbeiten)

# Backend-Server-Datenrückgabezeit_Das heißt, der Backend-Server muss die gesamte Datenübertragung innerhalb abschließen die angegebene Zeit #Legen Sie die Puffergröße für den ersten Teil der vom Proxy-Server gelesenen Antwort fest Normalerweise enthält dieser Teil der Antwort einen kleinen Antwortheader. Standardmäßig entspricht die Größe dieses Werts der Größe eines Puffers, der in der Direktive proxy_buffers , aber es kann kleiner eingestellt werden proxy_buffers 4 256k; # ist so eingestellt, dass die Antwort gelesen wird (von The Anzahl und Größe der Puffer des Proxy-Servers), der Standardwert ist auch die Paging-Größe, die je nach 4k oder 8k proxy_busy_buffers_size 256k; proxy_temp_file_write_size 256k; # Legen Sie die Größe der Daten beim Schreiben von proxy_temp_path fest, um zu verhindern, dass ein Arbeitsprozess beim Übergeben von Dateien zu lange blockiert proxy_temp_path /data0/proxy_temp_dir; #proxy_temp_path und proxy_cache_pathDer angegebene Pfad muss sich in derselben Partition befindenproxy_cache_path /data0/proxy_cache_dirlevels=1:2keys_zone=cache_one:200m inaktiv =1d

max_size=30g;#

KeepaliveTimeout.

client_body_buffer_size 512k;

bedeutet, zu verwenden nginx BlockierenHTTPDer Antwortcode ist 400 oder höhere Antwort. upstream img_relay { Server 127.0.0.1:8027; Server 127.0.0.1:8028; Server 127.0.0.1:8029; hash $request_uri; } von UpstreamUnterstützt derzeit 4 Verteilungsmethoden , Abfrage (Standard) Jede Anfrage wird nacheinander in chronologischer Reihenfolge einem anderen Backend-Server zugewiesen, wenn der Backend-Server down fällt heraus und kann automatisch beseitigt werden. 2, Gewicht 2, ip_hash 3, fair(Dritter) Anfragen werden entsprechend der Antwortzeit des Backend-Servers zugewiesen, und diejenigen mit kurzen Antwortzeiten werden zuerst zugewiesen. 4 , url_hash (Dritter) Drücken Sie, um auf dieURL zuzugreifenHashDie Ergebnisse werden verwendet, um Anfragen so zu verteilen, dass jede URL an denselben Backend-Server weitergeleitet wird. Es ist effektiver, wenn der Backend-Server zwischengespeichert ist. Beispiel: in UpstreamHash-Anweisung zu 🎜> hinzu. Sie können Server schreiben Anweisung. 🎜>Gewicht und andere Parameter, hash_method wird verwendet HashAlgorithmus server squid1:3128; Tipps: Upstream-Backend{#Definieren Sie das Lastausgleichsgerät IP und Gerätestatusip_hash; eingestellt:1.down Unterstützt das Festlegen mehrerer Lastgruppen bei Gleichzeitig wird das Guthaben für ungenutzte Server verwendet. client_body_in_file_only ist auf Ein eingestellt Kann sprechenKunde

Die Daten aus dem Beitrag werden in einer Datei für Debug Standort entspricht URL.Sie können einen neuen Proxy umleiten oder erstellen

Lastausgleich Server #Virtuelle Maschine konfigurieren { hören 80; #Konfiguration Abhörport server_name image.***.com; #Zugriffsdomänennamen konfigurieren Standort ~* .(mp3|exe)$ { #Ersetzen Sie durch „mp3 oder exe“ Adresse, die im Lastausgleich endet proxy_pass http://img_relay$request_uri; #Stellen Sie den Port oder Socket des Proxyservers ein und URL proxy_set_header Host $host; Proxy_set_header >proxy_set_header Der Zweck der obigen drei Zeilen besteht darin, die vom Proxyserver empfangenen Benutzerinformationen an den realen Server zu übertragen } Standort/Gesicht { if ($http_user_agent ~* "xnp") { umschreiben ^(.*)$ http://211.151.188.190:8080/face.jpg Weiterleitung; } proxy_pass http://img_relay

proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; error_page 404 502 = @fetch; } location @fetch { access_log /data/logs/face.log log404; #

umschreiben ^(.* )$ http: //211.151.188.190:8080/face.jpg Weiterleitung; }

Standort/Bild { umschreiben ^(.*)$ http://211.151.188.190:8080/face.jpg Umleitung; } proxy_pass http://img_relay$request_uri; proxy_set_header Host $host; Proxy_set_header X-Real-IP $remote_addr; error_page 404 502 = @fetch; } location @fetch { access_log /data/logs/image.log log404 ; ^(.*)$ umschreiben http://211.151.188.190:8080/face.jpg Weiterleitung; } }

Server { hören 80; Servername *.***.com *.***. cn; Standort ~* .(mp3|exe)$ { proxy_pass http://img_relay$request_uri; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; } Standort / { if ($http_user_agent ~* "xnp" ) { umschreiben ^(.*)$ http://i1 .***img.com/help/noimg.gif weitergeleitet; } proxy_pass http://img_relay$request_uri; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; #error_page 404 http://i1.***img.com/help/noimg.gif; error_page 404 502 = @fetch; } location @fetch { access_log /data/logs/baijiaqi. log log404; rewrite ^(.*)$ http:// i1.***img.com/help/noimg.gif weitergeleitet; } #access_log off; }

Server { 80 hören; Servername *.***img.com;

Standort ~* .(mp3|exe)$ { proxy_pass http://img_relay$request_uri; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; } Standort / { if ($http_user_agent ~* "xnp ") { umschreiben ^(.* )$ http://i1.***img.com/help/noimg.gif; } proxy_pass http://img_relay$request_uri; proxy_set_header Host $host; proxy_set_header 🎜>proxy_set_header #error_page 404 http://i1.***img.com/help/noimg.gif; error_page 404 = @fetch; } #access_log off; location @fetch { access_log /data/logs/baijiaqi.log log404; umschreiben ^(.*)$ http://i1 .***img.com/help/noimg.gif weitergeleitet; } }

Server { listen 8080; Servername ngx -ha.***img.com; Standort / { stub_status on; access_log off; } } Server { listen 80; server_name imgsrc1.*** .net; root html; } Server { hören 80; Servername ***.com w. ***.com; # access_log /usr/local/nginx /logs/access_log main; Standort / { umschreiben ^(.*)$ http://www.***.com/ ; } } Server { hören 80; Servername *******.com w.*******.com; # access_log /usr/local/nginx/logs/access_log main; Standort / { rewrite ^(.*)$ http://www.*******.com/; } } Server { 80 hören; Servername ******.com; # access_log /usr/local/nginx/logs/access_log main; Standort / { umschreiben ^(.*)$ http://www.******.com/; } } Standort

/NginxStatus { #设定查看 Nginx状态的地址 Standort

~ /.ht { #禁止访问.htxxx文件

} 注释:变量 Ngx_http_core_module 模块支持内置变量,他们的名字和Apache的内置变量是一致的. 首先是说明客户请求title中的行,例如$http_user_agent,$http_cookie等等。 此外还有其它的一些变量 $args此变量与请求行中的参数相等 $content_length等于请求行的“Content_Length“的值。 $content_type等同与请求头部的“Content_Type“的值 $document_root等同于当前请求的root指令指定的值 $document_uri与 $uri一样 $host mit der Anfrage header Der Wert, der in der Zeile „Host“ oder angegeben ist Anfrageangekommen ServerName (ohne Host OK) dasselbe wie $limit_rateBegrenzte Verbindungsrate zulassen $request_method entspricht AnfrageMethode, normalerweise „GET“ oder „POST“ $remote_addrKundenterminalip $remote_portClientPort $remote_user entspricht dem Benutzernamen, dargestellt durch ngx_http_auth_basic_module Zertifizierung $ request_filenameDer Pfadname der aktuell angeforderten Datei, bestimmt durch root oder Alias und URI

AnfrageKombiniert $request_body_file $request_uriVollständige Initialisierung mit Parametern URI $query_string und $args Gleich $sheeme http Modus (http, https ) Alle Anforderungen werden bewertet, zum Beispiel Umschreiben ^(.+)$ $sheme://example.com$; Redirect; $server_protocol entspricht Anfrage Protokoll, verwenden Sie „ HTTP/ oder „HTTP/ $server_addr request AngekommenServerip, im Allgemeinen besteht der Zweck des Erhaltens des Werts dieser Variablen darin, einen Systemaufruf durchzuführen. Um Systemaufrufe zu vermeiden, ist es notwendig, im listen Direktive >ip und verwenden Sie Bind Parameter. $server_name Der Servername, auf dem die Anfrage angekommen ist $server_portDie Portnummer des Servers, auf dem die Anfrage eintrifft $uri ist äquivalent zu die aktuelle Anfrage in URI, kann sich vom Anfangswert unterscheiden, z. B. bei interner Umleitung oder Verwendung von Index nginx Chinesische Wikipedia http://wiki.nginx.org/NginxChs http://www.queryer.cn/DOC/nginxCHS/index.html

Das Obige stellt die detaillierte Erklärung der Nginx-Konfigurationsdatei einschließlich des relevanten Inhalts vor. Ich hoffe, dass sie für Freunde hilfreich ist, die sich für PHP-Tutorials interessieren.

zum Lesen des Header--Werts, wenn Header ist zu groß, es wird large_client_header_buffers

Fehler(URI zu lang)nginx Akzeptieren Sie das längste HTTPDie Headergröße muss größer als eine der beiden sein

Puffer ist groß, andernfalls wird 400HTTP Fehler(Schlecht

Anfrage).

(LRU)wird entferntBeispiel : open_file_cache max=1000 inaktiv=20s; open_file_cache_valid 30s;

open_file_cache_errors on;

Syntax :open_file_cache_errors on |. off Standardwert:open_file_cache_errors

aus Benutzen Sie das Feld : http, server, location this Befehl Gibt an, ob die Suche nach einer Datei protokolliert wird CacheFehler.

open_file_cache_valid

Stellen Sie die Speichercache-Speicherplatzgröße auf 200 MB, 1 Inhalt, auf den nicht zugegriffen wurde Tage werden automatisch gelöscht, die Größe des Festplatten-Cache-Speicherplatzes beträgt 30 GB.

Wenn Sie einen größeren Wert festlegen, z. B. 256k, also unabhängig von der Verwendung von Firefox oder IE Browser, um alles unter 256k sind alle normal. Wenn diese Anweisung auskommentiert ist, wird die Standardeinstellung client_body_buffer_size verwendet, die doppelt so groß ist wie die Seitengröße des Betriebssystems, 8k oder 16k, die Problem entsteht. Ob mit Firefox 4.0 oder IE8.0, reichen Sie ein größeres ein, 200k Die linken und rechten Bilder ergeben alle 500

Interner ServerfehlerFehler

gibt die Abfragewahrscheinlichkeit an, Gewicht ist proportional zum Zugriffsverhältnis, das für das Backend verwendet wird Situation mit ungleichmäßiger Serverleistung. Zum Beispiel:

Upstream-Backende {

Server 192.168.0.14 Gewicht=10;

Server 192.168.0.15 Gewicht=10;

}

Zugriff auf Anfrage Die HashErgebnis der IP wird verteilt, sodass jeder Besucher festen Zugriff auf einen Backend-Server hat, der das Problem lösen kann Problem der Sitzung Problem. Zum Beispiel:

Upstream Bakend {

ip_hash;

Server 192.168.0.14:88 ;

Server 192.168.0.15:80;

}

Upstream-Backend {

Server Server1;

Server Server2;

fair;

}

server squid2:3128;

hash $request_uri;

hash_method crc32 ;

}

Server 127.0.0.1: 9090 ausgefallen;

Server 127.0.0.1:8080 Gewicht=2;

Server 127.0.0.1:6060;

Server 127.0. 0,1:7070 Backup;

}

Auf dem

Server Hinzugefügt proxy_pass http://bakend/;

bedeutet einzelne Vorderseite Servervorerst nicht an der Auslastung teilnehmen2.Gewicht

Standard ist 1.Je größer das Gewicht, desto größer ist das Gewicht der Ladung. 3.max_fails

: Die Anzahl der zulässigen Anforderungsfehler beträgt standardmäßig 1.Wenn die maximale Anzahl überschritten wird, wird proxy_next_upstreamvom Modul definierter Fehler zurückgegeben 4.fail_timeout:max_fails Fehlern.

5.Backup: Alle anderen Nicht-

BackupMaschinenausgefallenoder wenn beschäftigt, Backup Maschine anfordern. Daher wird diese Maschine den geringsten Druck haben.

client_body_temp_path Einstellungen aufgezeichnet Das Verzeichnis der Aufnahmedateien kann auf 3Ebenenverzeichnisse

stub_status on;

access_log on;

auth_basic "NginxStatus";

auth_basic_user_file conf/htpasswd;

}

alles ablehnen;

}

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Was bedeutet der http-Statuscode 520?

Oct 13, 2023 pm 03:11 PM

Was bedeutet der http-Statuscode 520?

Oct 13, 2023 pm 03:11 PM

Der HTTP-Statuscode 520 bedeutet, dass der Server bei der Verarbeitung der Anfrage einen unbekannten Fehler festgestellt hat und keine genaueren Informationen bereitstellen kann. Wird verwendet, um darauf hinzuweisen, dass bei der Verarbeitung der Anforderung durch den Server ein unbekannter Fehler aufgetreten ist, der durch Serverkonfigurationsprobleme, Netzwerkprobleme oder andere unbekannte Gründe verursacht werden kann. Dies wird normalerweise durch Serverkonfigurationsprobleme, Netzwerkprobleme, Serverüberlastung oder Codierungsfehler verursacht. Wenn Sie auf einen Fehler mit dem Statuscode 520 stoßen, wenden Sie sich am besten an den Website-Administrator oder das technische Support-Team, um weitere Informationen und Unterstützung zu erhalten.

Was ist der HTTP-Statuscode 403?

Oct 07, 2023 pm 02:04 PM

Was ist der HTTP-Statuscode 403?

Oct 07, 2023 pm 02:04 PM

Der HTTP-Statuscode 403 bedeutet, dass der Server die Anfrage des Clients abgelehnt hat. Die Lösung für den HTTP-Statuscode 403 ist: 1. Überprüfen Sie die Authentifizierungsdaten. Wenn der Server eine Authentifizierung erfordert, stellen Sie sicher, dass die richtigen Anmeldedaten angegeben werden. 2. Überprüfen Sie die IP-Adresseinschränkungen Die IP-Adresse des Clients ist eingeschränkt oder nicht auf der Blacklist. Wenn der Statuscode 403 mit den Berechtigungseinstellungen der Datei oder des Verzeichnisses zusammenhängt, stellen Sie sicher, dass der Client über ausreichende Berechtigungen zum Zugriff auf diese Dateien oder Verzeichnisse verfügt. usw.

So verwenden Sie Nginx Proxy Manager, um einen Lastausgleich für mehrere Server zu erreichen

Sep 27, 2023 pm 09:42 PM

So verwenden Sie Nginx Proxy Manager, um einen Lastausgleich für mehrere Server zu erreichen

Sep 27, 2023 pm 09:42 PM

So verwenden Sie NginxProxyManager, um einen Lastausgleich für mehrere Server zu erreichen. NginxProxyManager ist ein auf Nginx basierendes Proxyserver-Verwaltungstool. Es bietet eine einfache und benutzerfreundliche Weboberfläche, mit der Nginx-Proxyserver einfach konfiguriert und verwaltet werden können. In praktischen Anwendungen müssen wir Anforderungen häufig auf mehrere Server verteilen, um einen Lastausgleich zu erreichen und die Systemleistung und -verfügbarkeit zu verbessern. In diesem Artikel wird die Verwendung von NginxProx vorgestellt

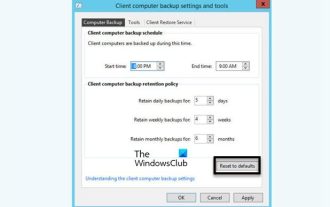

Anleitung zum Installieren, Deinstallieren und Zurücksetzen des Windows-Server-Backups

Mar 06, 2024 am 10:37 AM

Anleitung zum Installieren, Deinstallieren und Zurücksetzen des Windows-Server-Backups

Mar 06, 2024 am 10:37 AM

WindowsServerBackup ist eine Funktion des WindowsServer-Betriebssystems, die Benutzern dabei helfen soll, wichtige Daten und Systemkonfigurationen zu schützen und vollständige Sicherungs- und Wiederherstellungslösungen für kleine, mittlere und große Unternehmen bereitzustellen. Nur Benutzer, die Server2022 und höher ausführen, können diese Funktion nutzen. In diesem Artikel erklären wir, wie Sie WindowsServerBackup installieren, deinstallieren oder zurücksetzen. So setzen Sie die Windows Server-Sicherung zurück: Wenn Sie Probleme mit der Sicherung Ihres Servers haben, die Sicherung zu lange dauert oder Sie nicht auf gespeicherte Dateien zugreifen können, können Sie die Sicherungseinstellungen Ihres Windows Servers zurücksetzen. Um Windows zurückzusetzen

Nginx Proxy Manager-Tutorial: Kurzanleitung

Sep 27, 2023 pm 05:39 PM

Nginx Proxy Manager-Tutorial: Kurzanleitung

Sep 27, 2023 pm 05:39 PM

NginxProxyManager-Tutorial: Kurzanleitung, spezifische Codebeispiele erforderlich Einführung: Mit der Entwicklung der Netzwerktechnologie sind Proxyserver zu einem Teil unserer täglichen Nutzung des Internets geworden. NginxProxyManager ist eine auf Nginx basierende Proxyserver-Verwaltungsplattform, mit der wir Proxyserver schnell einrichten und verwalten können. In diesem Artikel werden Ihnen die Kurzanleitung von NginxProxyManager sowie einige spezifische Codebeispiele vorgestellt. eins

Verstehen Sie gängige Anwendungsszenarien der Webseitenumleitung und verstehen Sie den HTTP-301-Statuscode

Feb 18, 2024 pm 08:41 PM

Verstehen Sie gängige Anwendungsszenarien der Webseitenumleitung und verstehen Sie den HTTP-301-Statuscode

Feb 18, 2024 pm 08:41 PM

Verstehen Sie die Bedeutung des HTTP 301-Statuscodes: Häufige Anwendungsszenarien der Webseitenumleitung. Mit der rasanten Entwicklung des Internets werden die Anforderungen der Menschen an die Webseiteninteraktion immer höher. Im Bereich Webdesign ist die Webseitenumleitung eine gängige und wichtige Technologie, die über den HTTP-301-Statuscode implementiert wird. In diesem Artikel werden die Bedeutung des HTTP 301-Statuscodes und häufige Anwendungsszenarien bei der Webseitenumleitung untersucht. Der HTTP-Statuscode 301 bezieht sich auf eine permanente Weiterleitung (PermanentRedirect). Wenn der Server die des Clients empfängt

HTTP 200 OK: Verstehen Sie die Bedeutung und den Zweck einer erfolgreichen Antwort

Dec 26, 2023 am 10:25 AM

HTTP 200 OK: Verstehen Sie die Bedeutung und den Zweck einer erfolgreichen Antwort

Dec 26, 2023 am 10:25 AM

HTTP-Statuscode 200: Erkunden Sie die Bedeutung und den Zweck erfolgreicher Antworten. HTTP-Statuscodes sind numerische Codes, die den Status einer Serverantwort angeben. Darunter zeigt der Statuscode 200 an, dass die Anfrage vom Server erfolgreich verarbeitet wurde. In diesem Artikel wird die spezifische Bedeutung und Verwendung des HTTP-Statuscodes 200 untersucht. Lassen Sie uns zunächst die Klassifizierung von HTTP-Statuscodes verstehen. Statuscodes sind in fünf Kategorien unterteilt, nämlich 1xx, 2xx, 3xx, 4xx und 5xx. Unter diesen zeigt 2xx eine erfolgreiche Antwort an. Und 200 ist der häufigste Statuscode in 2xx

Häufige Netzwerkkommunikations- und Sicherheitsprobleme und Lösungen in C#

Oct 09, 2023 pm 09:21 PM

Häufige Netzwerkkommunikations- und Sicherheitsprobleme und Lösungen in C#

Oct 09, 2023 pm 09:21 PM

Häufige Netzwerkkommunikations- und Sicherheitsprobleme und Lösungen in C# Im heutigen Internetzeitalter ist Netzwerkkommunikation zu einem unverzichtbaren Bestandteil der Softwareentwicklung geworden. In C# treten normalerweise einige Netzwerkkommunikationsprobleme auf, z. B. die Sicherheit der Datenübertragung, die Stabilität der Netzwerkverbindung usw. In diesem Artikel werden häufig auftretende Netzwerkkommunikations- und Sicherheitsprobleme in C# ausführlich erläutert und entsprechende Lösungen und Codebeispiele bereitgestellt. 1. Netzwerkkommunikationsprobleme Unterbrechung der Netzwerkverbindung: Während des Netzwerkkommunikationsprozesses kann die Netzwerkverbindung unterbrochen werden, was zu Problemen führen kann