Backend-Entwicklung

Backend-Entwicklung

PHP-Tutorial

PHP-Tutorial

Holen Sie sich den Quellcode – Gibt es ein voll funktionsfähiges Open-Source-Projekt für die Erfassung von Webseitendaten in PHP?

Holen Sie sich den Quellcode – Gibt es ein voll funktionsfähiges Open-Source-Projekt für die Erfassung von Webseitendaten in PHP?

Holen Sie sich den Quellcode – Gibt es ein voll funktionsfähiges Open-Source-Projekt für die Erfassung von Webseitendaten in PHP?

Gibt es ein Open-Source-Tool zum Sammeln von Daten von Webseiten

?Wenn Sie beispielsweise eine kontinuierliche Regelerfassung einschließen möchten, erfassen Sie zuerst die Paging-Informationen, rufen Sie daraus die Detailseite ab und erfassen Sie die wirklich benötigten DOM-Felder von der Detailseite

Enthält die endgültige, in der Datenbank gespeicherte Anpassung,

Beinhaltet die Möglichkeit, IP usw. zu fälschen.

Enthält einen automatischen Warteschlangenmechanismus und eine automatische Verzögerung

Warten

Vielen Dank

Antwortinhalt:

Gibt es ein Open-Source-Tool zum Sammeln von Daten von Webseiten

?Wenn Sie beispielsweise eine kontinuierliche Regelerfassung einschließen möchten, erfassen Sie zuerst die Paging-Informationen, rufen Sie daraus die Detailseite ab und erfassen Sie die wirklich benötigten DOM-Felder von der Detailseite

Enthält die endgültige, in der Datenbank gespeicherte Anpassung,

Beinhaltet die Möglichkeit, IP usw. zu fälschen.

Enthält einen automatischen Warteschlangenmechanismus und eine automatische Verzögerung

Warten

Vielen Dank

Ja, Sie können die [Archer Cloud Crawler Development Platform] ausprobieren. 】

Archer Cloud Crawler ist eine SaaS-Serviceplattform, die JS-Entwicklern hilft, Crawler-Systeme schnell zu entwickeln. Archer bietet ein benutzerfreundliches, flexibles und offenes Cloud-Crawler-Entwicklungsframework, mit dem Entwickler einen Crawler implementieren können, indem sie nur wenige Zeilen JS-Code online schreiben. Und der Crawler läuft automatisch auf dem Cloud-Server, wodurch das Crawlen schneller und effizienter wird.

phpcrawler, PHP-Crawler, PHP-Collector, Multiprozess, Multithread

phpQuery

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

PHP 8.4 Installations- und Upgrade-Anleitung für Ubuntu und Debian

Dec 24, 2024 pm 04:42 PM

PHP 8.4 Installations- und Upgrade-Anleitung für Ubuntu und Debian

Dec 24, 2024 pm 04:42 PM

PHP 8.4 bringt mehrere neue Funktionen, Sicherheitsverbesserungen und Leistungsverbesserungen mit einer beträchtlichen Menge an veralteten und entfernten Funktionen. In dieser Anleitung wird erklärt, wie Sie PHP 8.4 installieren oder auf PHP 8.4 auf Ubuntu, Debian oder deren Derivaten aktualisieren. Obwohl es möglich ist, PHP aus dem Quellcode zu kompilieren, ist die Installation aus einem APT-Repository wie unten erläutert oft schneller und sicherer, da diese Repositorys in Zukunft die neuesten Fehlerbehebungen und Sicherheitsupdates bereitstellen.

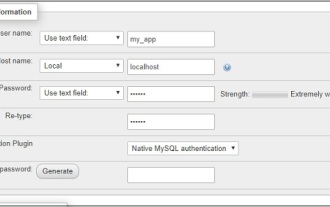

CakePHP arbeitet mit Datenbank

Sep 10, 2024 pm 05:25 PM

CakePHP arbeitet mit Datenbank

Sep 10, 2024 pm 05:25 PM

Das Arbeiten mit der Datenbank in CakePHP ist sehr einfach. In diesem Kapitel werden wir die CRUD-Operationen (Erstellen, Lesen, Aktualisieren, Löschen) verstehen.

CakePHP Datum und Uhrzeit

Sep 10, 2024 pm 05:27 PM

CakePHP Datum und Uhrzeit

Sep 10, 2024 pm 05:27 PM

Um in cakephp4 mit Datum und Uhrzeit zu arbeiten, verwenden wir die verfügbare FrozenTime-Klasse.

CakePHP-Datei hochladen

Sep 10, 2024 pm 05:27 PM

CakePHP-Datei hochladen

Sep 10, 2024 pm 05:27 PM

Um am Datei-Upload zu arbeiten, verwenden wir den Formular-Helfer. Hier ist ein Beispiel für den Datei-Upload.

Besprechen Sie CakePHP

Sep 10, 2024 pm 05:28 PM

Besprechen Sie CakePHP

Sep 10, 2024 pm 05:28 PM

CakePHP ist ein Open-Source-Framework für PHP. Es soll die Entwicklung, Bereitstellung und Wartung von Anwendungen erheblich vereinfachen. CakePHP basiert auf einer MVC-ähnlichen Architektur, die sowohl leistungsstark als auch leicht zu verstehen ist. Modelle, Ansichten und Controller gu

CakePHP erstellt Validatoren

Sep 10, 2024 pm 05:26 PM

CakePHP erstellt Validatoren

Sep 10, 2024 pm 05:26 PM

Der Validator kann durch Hinzufügen der folgenden zwei Zeilen im Controller erstellt werden.

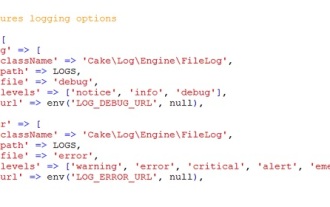

CakePHP-Protokollierung

Sep 10, 2024 pm 05:26 PM

CakePHP-Protokollierung

Sep 10, 2024 pm 05:26 PM

Die Anmeldung bei CakePHP ist eine sehr einfache Aufgabe. Sie müssen nur eine Funktion verwenden. Sie können Fehler, Ausnahmen, Benutzeraktivitäten und von Benutzern durchgeführte Aktionen für jeden Hintergrundprozess wie Cronjob protokollieren. Das Protokollieren von Daten in CakePHP ist einfach. Die Funktion log() wird bereitgestellt

So richten Sie Visual Studio-Code (VS-Code) für die PHP-Entwicklung ein

Dec 20, 2024 am 11:31 AM

So richten Sie Visual Studio-Code (VS-Code) für die PHP-Entwicklung ein

Dec 20, 2024 am 11:31 AM

Visual Studio Code, auch bekannt als VS Code, ist ein kostenloser Quellcode-Editor – oder eine integrierte Entwicklungsumgebung (IDE) –, die für alle gängigen Betriebssysteme verfügbar ist. Mit einer großen Sammlung von Erweiterungen für viele Programmiersprachen kann VS Code c