Python implementiert eine einfache Crawler-Funktion

Wenn wir jeden Tag im Internet surfen, sehen wir oft einige gut aussehende Bilder und wir möchten diese Bilder speichern und herunterladen oder sie als Desktop-Hintergrundbilder oder als Designmaterialien verwenden.

Unsere häufigste Vorgehensweise besteht darin, mit der rechten Maustaste zu klicken und „Speichern unter“ auszuwählen. Für einige Bilder gibt es jedoch keine Option zum Speichern unter, wenn Sie mit der rechten Maustaste klicken. Eine andere Möglichkeit besteht darin, sie mit einem Screenshot-Tool aufzunehmen, was jedoch die Klarheit des Bildes verringert. Okay~! Tatsächlich sind Sie sehr gut. Klicken Sie mit der rechten Maustaste, um den Quellcode der Seite anzuzeigen.

Wir können Python verwenden, um eine so einfache Crawler-Funktion zu implementieren und den gewünschten Code lokal zu crawlen. Schauen wir uns an, wie man mit Python eine solche Funktion implementiert.

1. Holen Sie sich die gesamten Seitendaten

Zuerst können wir die gesamten Seiteninformationen des Bildes abrufen heruntergeladen.

getjpg.py

#coding=utf-8

import urllib

def getHtml(url):

page = urllib.urlopen(url)

html = page.read()

return html

html = getHtml("http://tieba.baidu.com/p/2738151262")

print htmlDas Urllib-Modul bietet eine Schnittstelle zum Lesen von Webseitendaten. Wir können Daten auf www und ftp wie lokale Dateien lesen. Zuerst definieren wir eine getHtml()-Funktion:

Die urllib.urlopen()-Methode wird zum Öffnen einer URL-Adresse verwendet.

Die Methode read() wird verwendet, um die Daten auf der URL zu lesen, eine URL an die Funktion getHtml() zu übergeben und die gesamte Seite herunterzuladen. Beim Ausführen des Programms wird die gesamte Webseite ausgedruckt.

Zweitens filtern Sie die gewünschten Daten auf der Seite

Python bietet sehr leistungsstarke reguläre Ausdrücke, die wir brauchen Ich möchte zunächst ein wenig über reguläre Python-Ausdrücke wissen.

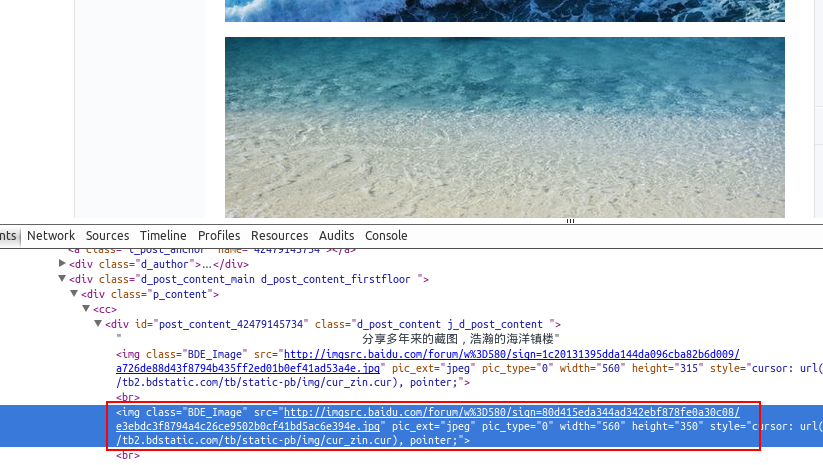

Angenommen, wir finden ein paar schöne Hintergrundbilder in Baidu Tieba und gehen zum vorherigen Abschnitt, um die Tools anzuzeigen. Die Adresse des Bildes wurde gefunden, z. B.: src="http://imgsrc.baidu.com/forum...jpg" pic_ext="jpeg"

Ändern Sie den Code wie folgt:

import re

import urllib

def getHtml(url):

page = urllib.urlopen(url)

html = page.read()

return html

def getImg(html):

reg = r'src="(.+?\.jpg)" pic_ext'

imgre = re.compile(reg)

imglist = re.findall(imgre,html)

return imglist

html = getHtml("http://tieba.baidu.com/p/2460150866")

print getImg(html)Wir haben außerdem die Funktion getImg() erstellt, um die erforderlichen Bildlinks auf der gesamten erhaltenen Seite zu filtern. Das re-Modul enthält hauptsächlich reguläre Ausdrücke:

re.compile() kann den regulären Ausdruck in ein reguläres Ausdrucksobjekt kompilieren.

Die re.findall()-Methode liest den in HTML imgre enthaltenen Inhalt. regulärer Ausdruck) Daten.

Durch Ausführen des Skripts wird die URL-Adresse des Bildes abgerufen, das auf der gesamten Seite enthalten ist.

Drittens speichern Sie die seitengefilterten Daten lokal

Durchlaufen Sie die gefilterte Bildadresse durch eine for-Schleife und speichern Sie unter lokal lautet der Code wie folgt:

#coding=utf-8

import urllib

import re

def getHtml(url):

page = urllib.urlopen(url)

html = page.read()

return html

def getImg(html):

reg = r'src="(.+?\.jpg)" pic_ext'

imgre = re.compile(reg)

imglist = re.findall(imgre,html)

x = 0

for imgurl in imglist:

urllib.urlretrieve(imgurl,'%s.jpg' % x)

x+=1

html = getHtml("http://tieba.baidu.com/p/2460150866")

print getImg(html)Der Kern hier besteht darin, die Methode urllib.urlretrieve() zu verwenden, um Remote-Daten direkt auf den lokalen herunterzuladen.

Durchlaufen Sie die erhaltene Bildverbindung durch eine for-Schleife. Um den Bilddateinamen standardisierter zu gestalten, benennen Sie ihn um. Die Benennungsregel besteht darin, 1 zur x-Variablen hinzuzufügen. Der Speicherort ist standardmäßig das Speicherverzeichnis des Programms.

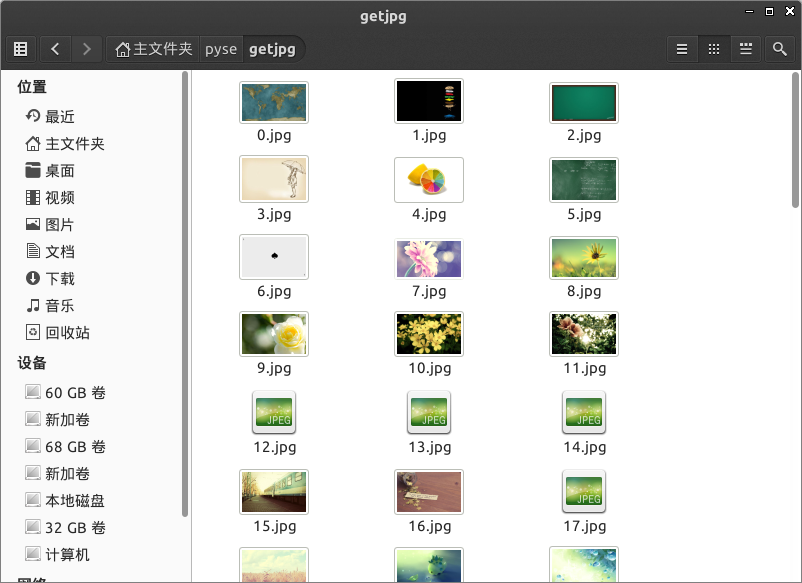

Nachdem das Programm ausgeführt wurde, sehen Sie die in das lokale Verzeichnis heruntergeladenen Dateien.

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1386

1386

52

52

Wie löste ich das Problem der Berechtigungen beim Betrachten der Python -Version in Linux Terminal?

Apr 01, 2025 pm 05:09 PM

Wie löste ich das Problem der Berechtigungen beim Betrachten der Python -Version in Linux Terminal?

Apr 01, 2025 pm 05:09 PM

Lösung für Erlaubnisprobleme beim Betrachten der Python -Version in Linux Terminal Wenn Sie versuchen, die Python -Version in Linux Terminal anzuzeigen, geben Sie Python ein ...

Wie kann ich die gesamte Spalte eines Datenrahmens effizient in einen anderen Datenrahmen mit verschiedenen Strukturen in Python kopieren?

Apr 01, 2025 pm 11:15 PM

Wie kann ich die gesamte Spalte eines Datenrahmens effizient in einen anderen Datenrahmen mit verschiedenen Strukturen in Python kopieren?

Apr 01, 2025 pm 11:15 PM

Bei der Verwendung von Pythons Pandas -Bibliothek ist das Kopieren von ganzen Spalten zwischen zwei Datenrahmen mit unterschiedlichen Strukturen ein häufiges Problem. Angenommen, wir haben zwei Daten ...

Wie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer-Anfänger-Programmierbasis in Projekt- und problemorientierten Methoden?

Apr 02, 2025 am 07:18 AM

Wie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer-Anfänger-Programmierbasis in Projekt- und problemorientierten Methoden?

Apr 02, 2025 am 07:18 AM

Wie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer -Anfänger für Programmierungen? Wenn Sie nur 10 Stunden Zeit haben, um Computer -Anfänger zu unterrichten, was Sie mit Programmierkenntnissen unterrichten möchten, was würden Sie dann beibringen ...

Wie kann man vom Browser vermeiden, wenn man überall Fiddler für das Lesen des Menschen in der Mitte verwendet?

Apr 02, 2025 am 07:15 AM

Wie kann man vom Browser vermeiden, wenn man überall Fiddler für das Lesen des Menschen in der Mitte verwendet?

Apr 02, 2025 am 07:15 AM

Wie kann man nicht erkannt werden, wenn Sie Fiddlereverywhere für Man-in-the-Middle-Lesungen verwenden, wenn Sie FiddLereverywhere verwenden ...

Was sind reguläre Ausdrücke?

Mar 20, 2025 pm 06:25 PM

Was sind reguläre Ausdrücke?

Mar 20, 2025 pm 06:25 PM

Regelmäßige Ausdrücke sind leistungsstarke Tools für Musteranpassung und Textmanipulation in der Programmierung, wodurch die Effizienz bei der Textverarbeitung in verschiedenen Anwendungen verbessert wird.

Wie hört Uvicorn kontinuierlich auf HTTP -Anfragen ohne Serving_forver () an?

Apr 01, 2025 pm 10:51 PM

Wie hört Uvicorn kontinuierlich auf HTTP -Anfragen ohne Serving_forver () an?

Apr 01, 2025 pm 10:51 PM

Wie hört Uvicorn kontinuierlich auf HTTP -Anfragen an? Uvicorn ist ein leichter Webserver, der auf ASGI basiert. Eine seiner Kernfunktionen ist es, auf HTTP -Anfragen zu hören und weiterzumachen ...

Was sind einige beliebte Python -Bibliotheken und ihre Verwendung?

Mar 21, 2025 pm 06:46 PM

Was sind einige beliebte Python -Bibliotheken und ihre Verwendung?

Mar 21, 2025 pm 06:46 PM

In dem Artikel werden beliebte Python-Bibliotheken wie Numpy, Pandas, Matplotlib, Scikit-Learn, TensorFlow, Django, Flask und Anfragen erörtert, die ihre Verwendung in wissenschaftlichen Computing, Datenanalyse, Visualisierung, maschinellem Lernen, Webentwicklung und h beschreiben

Wie erstelle ich dynamisch ein Objekt über eine Zeichenfolge und rufe seine Methoden in Python auf?

Apr 01, 2025 pm 11:18 PM

Wie erstelle ich dynamisch ein Objekt über eine Zeichenfolge und rufe seine Methoden in Python auf?

Apr 01, 2025 pm 11:18 PM

Wie erstellt in Python ein Objekt dynamisch über eine Zeichenfolge und ruft seine Methoden auf? Dies ist eine häufige Programmieranforderung, insbesondere wenn sie konfiguriert oder ausgeführt werden muss ...