Eine erste Einführung in webbasierte VR

Das spannendste Thema in der Technologiewelt im Jahr 2016 ist, wie VR die Welt verändern wird. Einige Filme haben begonnen, sich auf VR einzulassen, sodass Benutzer nicht nur 3D-Bilder sehen, sondern mithilfe der Technik der „Transformation“ auch in die Szene eintauchen können, was ein beispielloses immersives Seherlebnis bietet. Darüber hinaus hat auch der Gaming-Bereich begonnen Um VR zu werden, müssen Benutzer keine einzige Szene mehr in einem Spielpaket ertragen. Diese coolen Effekte bieten viel Raum für Fantasie und VR rückt immer näher in das Leben der Menschen ein. Die Realität ist jedoch, dass VR, abgesehen davon, dass man gelegentlich die Wunder der schwarzen Technologie erlebt, nicht wirklich populär geworden ist. Hinter der Begeisterung von Kapital- und Hardwareherstellern wachsen auch immer wieder Zweifel.

Obwohl die Entwicklung der VR-Hardware derzeit auf Hochtouren läuft, ist der Inhalt sehr dünn. Die Kosten für einen VR-Film sind ziemlich hoch und VR-Spiele sind nicht weniger teuer. Die hohen Kosten für die Erstellung von Inhalten haben zu einem hohen Bekanntheitsgrad von VR geführt. Um die distanzierte aristokratische Pracht loszuwerden und in die Häuser der einfachen Leute einzudringen, muss VR noch das Problem der Inhaltsversorgung lösen. Die Entwicklung der durch HTML5 repräsentierten Web-Technologie könnte diesen Stillstand ändern. Derzeit verfügen die neuesten Browser Google Chrome und Mozilla Firefox über WebVR-Funktionsunterstützung für die HTML5-Technologie, und alle Parteien entwerfen und erweitern die neuesten WebVR-API-Standards der Branche. Diese auf dem Web basierenden Virtual-Reality-Standards werden die technischen Erstellungskosten und Schwellenwerte von VR-Inhalten weiter senken und HTML5-Entwicklern (JavaScript), der weltweit größten Entwicklergruppe, den Einstieg in die Erstellung von VR-Inhalten erleichtern. Dies ist nicht nur ein bedeutender Durchbruch in der Entwicklung der Web-Technologie, sondern bietet auch eine Chance für den Durchbruch von VR.

Vorteile webbasierter VR

Web kann die Schwelle für VR-Erlebnisse senken

Web-Technologie macht nicht nur die Kosten für die Erstellung von VR günstiger, sondern senkt auch die technischen Kosten erheblich Schwelle. Basierend auf der rasanten Entwicklung der WebGL-Technologie nutzt Web VR die GPU zur Durchführung von Berechnungen und die Game-Engine-Technologie zur Optimierung der APIs auf Chipebene, wodurch die Grafik-Rendering-Rechenfunktionen verbessert und gleichzeitig die Schwelle für Entwickler, in den VR-Bereich einzusteigen, erheblich gesenkt wird , Web VR kann auch besser In Kombination mit Cloud-Computing-Technologie ergänzt es die Rechenleistung von VR-Terminals und verbessert das interaktive Erlebnis.

Es ist sicher, dass das Web den Umfang der VR-Nutzung erweitert hat. In den Bereichen Werbung und Marketing sowie Panoramavideos sind zahlreiche innovative Fälle entstanden, und auch viele lebensbezogene Inhalte wurden in VR integriert B. reale Tourismus- und Nachrichtenberichte, virtuelles Einkaufen usw., deren Inhaltsanzeige und Interaktion können einfach durch die HTML5-Engine erstellt werden. Dies wird zweifellos mehr Spielraum für die zukünftige Entwicklung bieten.

Die Basis an Webentwicklern ist riesig

Zusätzlich zu seinen technischen Implementierungsvorteilen kann das Web auch eine enorme Innovationskraft in die VR bringen, da es über ein breites Anwendungsspektrum und eine enorme Entwicklung verfügt Die Benutzerbasis kann dazu beitragen, dass die VR-Technologie einen Volkskrieg gewinnt, sodass VR nicht länger nur ein Kapitalspiel für Industriemagnaten ist, sondern auf zivile Weise in alle Aspekte des täglichen Lebens der Benutzer Einzug gehalten hat.

Ich glaube, dass VR-Anwendungen mit der Zeit wie die allgegenwärtigen Apps mit Hilfe der niedrigen Schwelle der Webentwicklung gleichzeitig eintreten werden In einem endlosen Strom werden seltsame und seltsame Ideen auftauchen, und die virtuelle Realität wird zu notwendigen Geschäftstools für E-Commerce-Händler usw. Wenn es dieses Stadium erreicht, ist VR nicht mehr weit von echtem Wohlstand entfernt.

Webseitige VR-Inhalte entwickeln

Als nächstes werden wir praktische Vorgänge nutzen, um tatsächlich einige webseitige VR-Inhalte zu erstellen und die praktischen Vorteile von WebVR zu erleben. Wir wissen, dass viele VR-Erlebnisse in Form von Anwendungen präsentiert werden, was bedeutet, dass Sie diese suchen und herunterladen müssen, bevor Sie VR erleben können. Web VR ändert diese Form, es verlagert das VR-Erlebnis in den Browser, Web+VR = WebVR. Bevor wir in die Praxis einsteigen, analysieren wir zunächst den technischen Stand der WebVR-Implementierung.

WebVR-Entwicklungsmethoden

Es gibt drei Möglichkeiten, VR-Anwendungen im Web zu entwickeln:

HTML5+ Java Scnipt + WebGL + WebVR API

Traditionelle Engine + Emscripten[1]

Tools von Drittanbietern wie A-Frame[2]

Die erste Methode besteht darin, WebGL in Kombination mit der WebVR-API zu verwenden, die auf regulären webseitigen 3D-Anwendungen basiert mit VR-Geräten über die API, um die entsprechende VR-Implementierung zu erhalten. Die zweite Methode basiert auf traditionellen Engine-Entwicklungsinhalten wie Unity, Unreal usw. und verwendet Emscripten, um den C/C++-Code in die Java-Scnipt-Version zu übertragen und so VR im Web zu realisieren. Die dritte Methode besteht darin, die erste Methode zu kapseln und speziell webseitige VR-Inhalte für normale Benutzer ohne Programmierkenntnisse zu erstellen. In diesem Artikel verwenden wir hauptsächlich die erste und dritte Methode als Beispiele zur Veranschaulichung.

WebVR Draft

WebVR ist eine frühe und experimentelle JavaScript-API, die APIs für den Zugriff auf die Funktionen von VR-Geräten wie Oculus Rift, HTC Vive und Google Cardboard bereitstellt. VR-Anwendungen erfordern hochpräzise Schnittstellen mit geringer Latenz, um ein akzeptables Erlebnis zu bieten. Für Schnittstellen wie Device Orientation Event können zwar flache VR-Eingaben erhalten werden, diese bieten jedoch nicht die erforderlichen Genauigkeitsanforderungen für hochwertige VR. WebVR bietet eine dedizierte Schnittstelle für den Zugriff auf VR-Hardware und ermöglicht Entwicklern die Erstellung komfortabler VR-Erlebnisse.

Die WebVR-API ist derzeit für Oculus Rift mit nachts installiertem Firefox, einer experimentellen Version von Chrome und dem Samsung Gear VR-Browser verfügbar.

Verwenden Sie A-Frame, um VR-Inhalte zu entwickeln

Wenn Sie die WebVR-Entwicklung mit einem niedrigeren Schwellenwert erleben möchten, können Sie das vom MozVR-Team entwickelte A-Frame-Framework verwenden. A-Frame ist ein Open-Source-WebVR-Framework zum Erstellen von VR-Erlebnissen über HTML. Mit diesem Framework erstellte VR-Szenen sind mit Smartphones, PCs, Oculus Rift und HTC Vive kompatibel. Das MozVR-Team hat das A-Frame-Framework entwickelt, um die Erstellung von 3D-/VR-Szenen einfacher und schneller zu machen und so die Webentwicklungs-Community für das WebVR-Ökosystem zu gewinnen. Damit WebVR erfolgreich ist, braucht es Inhalte. Derzeit gibt es jedoch nur eine kleine Anzahl von WebGL-Entwicklern, dafür aber Millionen von Webentwicklern und -designern. A-Frame möchte jedem die Möglichkeit geben, 3D-/VR-Inhalte zu erstellen. Es bietet die folgenden Vorteile und Eigenschaften:

A-Frame kann redundanten Code reduzieren. Redundanter und komplexer Code ist für Early Adopters zu einem Hindernis geworden. Wenn Sie eine Szene erstellen, benötigen Sie nur ein

A-Frame wurde speziell für Webentwickler entwickelt. Es basiert auf DOM und kann daher wie andere Webanwendungen 3D-/VR-Inhalte bedienen. Natürlich kann es auch in Verbindung mit JavaScript-Frameworks wie Box, D3 und React verwendet werden.

A-Frame strukturiert den Code. Three.js-Code ist normalerweise locker und A-Frame baut ein deklaratives Entitäts-Komponenten-System auf Three.js auf. Darüber hinaus können Komponenten veröffentlicht und geteilt werden, sodass andere Entwickler sie in HTML-Form verwenden können.

Der Code wird wie folgt implementiert:

// 引入A-Frame框架<script src="./aframe.min.js"></script><a-scene>

<!-- 定义并创建球体 -->

<a-sphere position="0 1 -1" radius="1" color="#EF2D5E"></a-sphere>

<!-- 定义交创建立方体 -->

<a-box width="1" height="1" rotation="0 45 0" depth="1" color="#4CC3D9" position="-1 0.5 1"></a-box>

<!-- 定义并创建圆柱体 -->

<a-cylinder position="1 0.75 1" radius="0.5" height="1.5" color="#FFC65D"></a-cylinder>

<!-- 定义并创建底板 -->

<a-plane rotation="-90 0 0" width="4" height="4" color="#7BC8A4"></a-plane>

<!-- 定义并创建基于颜色的天空盒背景-->

<a-sky color="#ECECEC"></a-sky>

<!-- 设置并指定摄像机的位置 -->

<a-entity position="0 0 4">

<a-camera></a-camera>

</a-entity></a-scene>Verwendung von Three.js zur Entwicklung von VR-Inhalten

Wie oben erwähnt, haben wir eine andere Methode erwähnt Das liegt näher am Boden. Gleichzeitig besteht eine flexiblere Möglichkeit zur Erstellung von WebVR-Inhalten darin, die WebGL + WebVR-API direkt zu verwenden. Der Vorteil dieser Methode gegenüber A-Frame besteht darin, dass die VR-Unterstützung problemlos in unsere eigene Web3D-Engine eingeführt werden kann. Gleichzeitig können mehr Optimierungsvorgänge auf der untersten Ebene, insbesondere im Rendering-Modul, durchgeführt werden, um die Leistung und das Erlebnis zu verbessern der VR-Laufzeit.

Es spielt keine Rolle, ob Sie über eine eigene Web3D-Engine verfügen. Sie können direkt ausgereifte Rendering-Frameworks wie Three.js und Babylon.js verwenden. Dies sind beliebte und hervorragende Web3D-seitige Rendering-Engines (Rahmen). Als nächstes nehmen wir Three.js als Beispiel, um zu erklären, wie man darauf WebVR-Inhalte produziert.

Zuallererst sind die drei Elemente jedes Rendering-Programms ähnlich, nämlich die Einrichtung einer Szene, eines Renderers und einer Kamera. Der Vorgang zum Einstellen des Renderers, der Szene und der Kamera ist wie folgt:

var renderer = new THREE.WebGLRenderer({antialias: true});

renderer.setPixelRatio(window.devicePixelRatio);

document.body.appendChild(renderer.domElement);

// 创建Three.js的场景

var scene = new THREE.Scene();

// 创建Three.js的摄像机

var camera = new THREE.PerspectiveCamera(60, window.innerWidth / window.innerHeight, 0.1, 10000);

// 调用WebVR API中的摄像机控制器对象,并将其与主摄像机进行绑定

var controls = new THREE.VRControls(camera);

// 设置为站立姿态controls.standing = true;

// 调用WebVR API中的渲染控制器对象,并将其与渲染器进行绑定

var effect = new THREE.VREffect(renderer);

effect.setSize(window.innerWidth, window.innerHeight);// 创建一个全局的VR管理器对象,并进行初始化的参数设置

var params = {

hideButton: false, // Default: false.

isUndistorted: false // Default: false.

};

var manager = new WebVRManager(renderer, effect, params);Der obige Code vervollständigt die Initialisierungseinstellungen vor dem Rendern. Als Nächstes müssen Sie der Szene bestimmte Modellobjekte hinzufügen. Die Hauptvorgänge sind wie folgt:

function onTextureLoaded(texture) {

texture.wrapS = THREE.RepeatWrapping;

texture.wrapT = THREE.RepeatWrapping;

texture.repeat.set(boxSize, boxSize);

var geometry = new THREE.BoxGeometry(boxSize, boxSize, boxSize);

var material = new THREE.MeshBasicMaterial({

map: texture,

color: 0x01BE00,

side: THREE.BackSide

});

// Align the skybox to the floor (which is at y=0).

skybox = new THREE.Mesh(geometry, material);

skybox.position.y = boxSize/2;

scene.add(skybox);

// For high end VR devices like Vive and Oculus, take into account the stage

// parameters provided.

setupStage();

}

// Create 3D objects.

var geometry = new THREE.BoxGeometry(0.5, 0.5, 0.5);

var material = new THREE.MeshNormalMaterial();

var targetMesh = new THREE.Mesh(geometry, material);

var light = new THREE.DirectionalLight( 0xffffff, 1.5 );

light.position.set( 10, 10, 10 ).normalize();

scene.add( light );

var ambientLight = new THREE.AmbientLight(0xffffff);

scene.add(ambientLight);

var loader = new THREE.ObjectLoader();

loader.load('./assets/scene.json', function (obj){

mesh = obj;

// Add cube mesh to your three.js scene

scene.add(mesh);

mesh.traverse(function (node) {

if (node instanceof THREE.Mesh) {

node.geometry.computeVertexNormals();

}

});

// Scale the object

mesh.scale.x = 0.2;

mesh.scale.y = 0.2;

mesh.scale.z = 0.2;

targetMesh = mesh;

// Position target mesh to be right in front of you.

targetMesh.position.set(0, controls.userHeight * 0.8, -1);

});Der letzte Vorgang besteht darin, das Update in requestAnimationFrame festzulegen. In der Animationsfunktion müssen wir kontinuierlich die vom HMD zurückgegebenen Informationen abrufen und die Kamera aktualisieren.

// Request animation frame loop functionvar lastRender = 0;function animate(timestamp) {

var delta = Math.min(timestamp - lastRender, 500);

lastRender = timestamp;

// Update VR headset position and apply to camera.

//更新获取HMD的信息

controls.update();

// Render the scene through the manager.

//进行camera更新和场景绘制

manager.render(scene, camera, timestamp);

requestAnimationFrame(animate);

}Erfahrungen und Erkenntnisse

Durch die obige Einführung können wir grundsätzlich eine webseitige VR-Anwendung mit einem vorläufigen interaktiven Erlebnis implementieren, dies ist jedoch nur der erste Schritt der rein technischen Umsetzung ist alles andere als real. Es gibt immer noch eine gewisse technische Lücke. Denn nach dem endgültigen Engineering muss das benutzerorientierte Produkt spezifischere Dinge berücksichtigen als der technische Prototyp, wie z. B. die Qualität des Renderings, die reibungslose Interaktion, die Immersion der Virtualisierung usw., die letztendlich darüber entscheiden, ob Benutzer das Produkt weiterhin verwenden Produkt und akzeptieren es. Die vom Produkt bereitgestellten Dienste usw. Es gibt also noch viel Optimierungs- und Verbesserungsarbeit, bevor die oben genannte Technologie im Engineering angewendet werden kann. Im Folgenden finden Sie einige persönliche Erfahrungen im Prozess der Erstellung webbasierter VR-Anwendungen, die den Lesern als Referenz zur Verfügung gestellt werden.

Motorauswahl. Wenn Sie eine vorhandene WebGL-Engine verwenden, können Sie sich zur VR-SDK-Integration auf die Dokumentation in [5] beziehen. Hier müssen Sie die Engine-Ebene mit der VR-SDK-Ebene kompatibel machen und den VR-Modus in den Tool-Teil der Engine integrieren. Zur VR-SDK-Integration können Sie sich auch auf das Entwicklungsmodell von Desktop-Engines wie Unity3D und Unreal beziehen. Wenn Sie sich für eine WebGL-Engine eines Drittanbieters entscheiden, können Sie zwischen Three.js und Babylon.js wählen. Diese Mainstream-WebGL-Engines sind (einige Funktionen) in das VR SDK integriert.

Gerät debuggt. Das Debuggen von VR-Anwendungen im Web erfordert auch die Unterstützung bestimmter VR-Geräte. Für Desktop-WebM-Inhalte sollten Sie versuchen, hochgradig immersive VR-Geräte wie HTC Vive oder Oculus zu verwenden. Bei mobilen Webanwendungen ist die Leistung aufgrund der großen Unterschiede zwischen den Browsern auf der Android-Plattform inkonsistent. Daher wird empfohlen, vor der endgültigen Veröffentlichung iOS-Geräte zu verwenden Testen und Optimieren.

Leistungsoptimierung. Beim 3D-Zeichnen und Rendern im Web ist die Leistung immer noch der größte Engpass. Daher muss die Leistung des Echtzeit-Renderings so weit wie möglich verbessert werden, damit mehr Ressourcen für den VR-Teil übrig bleiben. Das aktuelle WebVR ist wie das Desktop-VR-SDK nicht in der Lage, viele der GPU zugrunde liegende Schnittstellen für eine tiefgreifende Optimierung wie Stereo-Rendering in Echtzeit-Rendering aufzurufen, sodass es immer noch viel Leistung verbraucht.

Bekannte Probleme. Derzeit ist WebVR noch instabil und weist viele Fehler auf. Beispielsweise kann die Geräteverfolgung in einigen Fällen verloren gehen und die Effizienz ist nicht sehr hoch. Die meisten WebVR-Anwendungen können als Reserve und Vorforschung für spätere Produkte verwendet werden, aber es ist noch ein langer Weg, bis wir Produkte auf den Markt bringen können, die wirklich nutzbar sind und den Benutzern ein reibungsloses Erlebnis bieten.

Wir könnten uns genauso gut den Entwicklungsprozess einer VR-DEMO ansehen.

Im Folgenden finden Sie eine kurze Einführung in die Entwicklungslinks, die Sie möglicherweise beunruhigen:

1. Informationen zur Entwicklung eines Projekts von einer bestimmten Größe Die für die VR-DEMO benötigte Zeit

Vor 60 Tagen wurde in unserem Konferenzraum ein Buch mit dem Titel „UNITY from Beginner to Master“ auf den Tisch gelegt. Wir waren uns nicht sicher, ob diese Entwicklungszeit angemessen war Gute Sache oder nicht. Es ist leicht für die Leute zu glauben, dass es sich um eine andere Sache handelt, die von „China Speed“ geschaffen wurde.

Später sind wir auf die UE-Engine umgestiegen. Schauen Sie sich an, wie effizient unsere Engine ist, wie praktisch sie ist und wie einfach die Nutzung der Mall-Ressourcen ist ...

Es sollte auch darauf hingewiesen werden, dass diese 60 Tage nicht mit Null-Grundlagen begonnen haben. Unser Team ist relativ älter, im Grunde genommen über 30 Jahre alt. Sie verfügen alle über zehn Jahre grundlegende 3D-Kunsterfahrung spielen seit langem die Rolle der Partei B. Dies führt zu einer besseren Technologieumsetzung und Zeitkonzepten. Das liegt außerdem daran, dass ich selbst etwas erschaffe, sodass alle stärker involviert sind. Ich sage also, dies ist eine seltsame und glückliche Zeit, aber natürlich ist der gezahlte Preis auch sehr hoch. In dieser Zeit haben wir keine neuen Geschäftsaufträge erhalten.

2. Bezüglich der für die VR-Entwicklung zu verwendenden Engine

Tatsächlich spielt es keine Rolle, welche Engine ich verwenden soll, bevor ich darüber gesprochen habe Ob man UE oder UNITY für die VR-Entwicklung nutzt, die Meinung ist fast einseitig zugunsten von UE, man tappt in eine Falle... Aber wir haben eine Weile studiert und waren der Meinung, dass wir immer noch geeignet sind um UE zu verwenden, und jetzt leben wir immer noch relativ glücklich. Die Geschichte von „Little Pony Crossing the River“ ist. Haben Sie sie gelesen?

Ich erinnerte mich an die Tools, die wir zuvor verwendet hatten: MAX und MAYA. Beide sind gut, je nachdem, wofür Sie sie verwenden. Verwenden Sie MAX, da es schnell ist. Wenn Sie charakterbasierte Animationsfilme erstellen, ist MAYA einfach zu verwenden Teamzusammenarbeit.

Außerdem arbeitet UE jetzt sehr intensiv daran. Ein Blick auf die offiziellen Tutorials zeigt, dass sich das Einkaufszentrum viel Mühe gegeben hat und das Blueprint-Tool auch sehr gut für Teams geeignet ist die den visuellen Einsatz bevorzugen.

Allerdings ist die Anzahl der Lesevorgänge auf dem offiziellen öffentlichen Konto von UE jedes Mal erschreckend niedrig. Es bildet einen interessanten Kontrast zu einem so heißen VR-Thema in China. Ich weiß wirklich nicht, welchem Konto sie folgen.

Ein weiteres großes Problem besteht darin, dass es in UE relativ wenige Menschen gibt. Wir können nur die Zeit aufwenden, die wir alleine erkunden. Diese Methode wird als Deadlock bezeichnet.

3. Vor- und Nachteile der CG-Team-Entwicklung von VR

Ich denke, unser Vorteil liegt im visuellen Design. Wir sind der Meinung, dass der Vive-Controller als interaktives Tool auch anders sein sollte Szenarios, also erschienen verschiedene schöne Controller, und ich denke, sie können alle in das offizielle Einkaufszentrum gestellt werden.

Ich denke, die Hintergründe von VR-Content-Entwicklern in China können in verschiedene Arten unterteilt werden:

Die erste davon sind Panoramavideos mit einer relativ geringen technischen Hürde. Die meisten dieser Hintergründe stammen aus dem wirklichen Leben Schießen, der bisherige Titel war meist Regisseur.

Der zweite Typ ist ein Spieleunternehmen. Der Vorteil besteht darin, dass das Programm und der Workflow VR ähneln und sich technisch leicht umwandeln lassen. Das Peinliche ist jedoch, dass es sich um visuelle Effekte handelt Es ist am besten, Spiele der nächsten Generation zu entwickeln, aber in China basieren die meisten Online-Spiele mittlerweile auf Mobilgeräten, und die Verarbeitung von Spielen der nächsten Generation erfolgt hauptsächlich ausgelagert.

Der dritte Typ stammt aus der CG-Branche, also unserer Art. Der Vorteil ist, dass wir mehr auf visuelle Elemente setzen. Es gibt einige ausländische Teams, die recht gut abschneiden und diesen Ansatz verfolgt haben Sie müssen jedoch technisch weiterentwickelt werden, aber glücklicherweise sind die zugrunde liegenden Prinzipien ähnlich und auf einen Blick verständlich.

Der vierte Typ ist ein Team von Programmierern. Ihr Vorteil besteht darin, dass sie großartigen Code entwickeln, die gewünschten Shader schreiben und die gewünschten Funktionen erhalten können.

Das letzte ist, dass er VR macht.

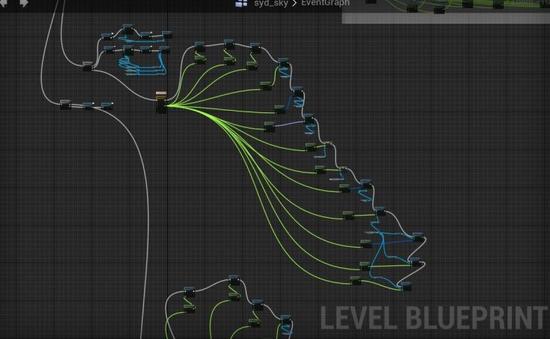

4. UE-Engine-Blaupause

Die Blaupause ist eine visuelle Modulprogrammierung, die speziell zur Verbesserung der Arbeitseffizienz entwickelt wurde. Ohne sie wäre unsere DEMO nicht möglich möglich. .

Gib mir ein Beispiel:

In der zweiten Hälfte der DEMO hast du deine Flügel geschwenkt und bist in den Himmel geflogen Die gleiche Farbe wie Wasser und Himmel, deine Flügel haben sich in Federn verwandelt, die über den ganzen Himmel fliegen ... was für eine romantische Szene.

Um dies zu realisieren, benötigen Sie die Hilfe von Blaupausen. Natürlich ist unsere Anmerkung sehr bodenständig, und wer sie verstehen kann, wird sie auf jeden Fall verstehen.

Kurz gesagt, dies ist eine DEMO mit einem vollständigen Entwurf, ohne eine einzige Zeile Code zu schreiben. Was ist eigentlich der Zweck des UE-Entwicklungsplans, damit Sie sich auf Dinge konzentrieren können, die für den Endeffekt hilfreicher sind? Der Prozess, der zu Ihrem Team passt, ist der richtige.

5. Ein weiterer technischer Punkt: PBR-Prozess

Das PBR-Verfahren soll von der Spieleindustrie eingeführt worden sein, nachdem sie von der CG-Branche gelernt hatte, aber ich schäme mich, dass wir in den späteren Phasen der CG-Branche aufgrund der Art des Projekts selten UV gezeigt haben.

Das PBR-Materialsystem ermöglicht es Objekten, realistischere Texturen und reichhaltigere Details in der Engine anzuzeigen. Dies ist auch ein gängiges Materialsystem für diese Generation von Spiel-Engines. Künstler können besser im Einklang mit den Beleuchtungsprinzipien arbeiten reale Welt. Die Logik zeichnet die Textur und passt das Material an. Die auf diesem System basierende Tool-Software-Reihe Substance Tools integriert Texturen, Materialien, Shader und andere Systeme aus der ursprünglichen Multi-Software-Tool-Kollaboration in ein Gesamtsystem. Gleichzeitig spart der flexible Workflow erheblich Produktionszeit und erleichtert die Produktion Serialisierte Texturen und Materialien machen den Materialzuordnungsprozess intuitiver und effizienter.

Mit der Software Substance Painter ist dieser Prozess viel besser als das Hin und Her zwischen PS- und MAX-Flächentexturen in unseren frühen Jahren.

Technologie ist sehr wichtig, aber angesichts einer neuen audiovisuellen Erlebnismethode ist die Kreation sehr wichtig und auch ein schwieriger Punkt beim VR-Erlebnisdesign.

Zur Themenauswahl des VR-Erlebnisses

Das Thema, das wir gewählt haben, ist eigentlich ein relativ unpopuläres Thema, das sich derzeit mit Waffenschießen befasst Ich interessierte mich mehr für kulturelle Themen und einige unserer Kollegen waren Luftfahrtfans, also habe ich mich für dieses Thema entschieden.

Uns ist aufgefallen, dass es ein ausländisches Team auf STEAM gibt, das das Apollo-Mondlandeerlebnis gemacht hat, also haben wir es heruntergeladen und studiert, aber wir dachten, er hätte uns ein paar falsche Erfahrungen gemacht. Ich denke, dieses Team ist ein Haufen Langweilige Ingenieure sind so langweilig, dass ich es nicht ertragen kann. Kultureller Output ist etwas, in dem wir relativ gut sind. Das hat vielleicht etwas mit früherer Berufserfahrung zu tun, und wir sollten neue Technologien nutzen, um etwas Sinnvolles zu tun. Es ist notwendig, Monster zu besiegen, aber es wäre falsch, nur Monster zu besiegen.

Meine eigene Schlussfolgerung ist, dass es am besten ist, wenn das Thema etwas ist, das Ihnen gefällt, Sie gründlich recherchiert haben und für den VR-Ausdruck geeignet sind.

8. Wie wird sich die Erzählsprache von VR von früher unterscheiden?

Aus kreativer Sicht hielt der Regisseur in der Vergangenheit die Kamera in der Hand und ließ Sie blicken, wohin Sie wollten , und es gab Montagen und so weiter. Man wundert sich, aber in der Welt der VR ist man ein Live-Teilnehmer, und der Regisseur muss einen anleiten, um zu sehen, was er möchte, dass man sieht und woran man teilnimmt.

Wir sind seit 2008 an der Planung und Durchführung vieler Live-Events beteiligt. Ich denke, diese Erfahrung ähnelt tatsächlich der von VR. In einem großen Raum, wo es Lärm und Licht gibt, wie man die Sichtlinie steuert und die Entwicklung der Handlung voranzutreiben, ist eine heikle und unterhaltsame Angelegenheit.

Ich denke also, dass die visuelle Sprache von VR kein filmischer Ansatz ist, sondern ein Live-Event- oder Performance-Ansatz.

In Bezug auf den technischen Prozess wurden die ursprünglichen Kompositions- und Bearbeitungspositionen zurückgezogen, aber sie sind immer noch da, aber sie haben nur die Plattform geändert, die tatsächlich zu UE hinzugefügt wurde. Und man kann auch Postproduktionsfilter und andere Dinge verwenden, die wirklich Spaß machen.

9. Über den Prozess und die Arbeitsteilung

Davor und nachher werden sich die meisten Menschen auf die Position der 3D-Kunstmaterialien konzentrieren, was ähnlich ist bis hin zur Verteilung von Spieleentwicklungspersonal. Es gibt einen Regisseur, unseren aufrechten Lehrer Pu An, der das Ganze koordiniert und die künstlerische Kontrolle übernimmt. Dann werden andere Kollegen und ich gemeinsam den technischen Prozess vorantreiben.

Grundsätzlich ist dieses Thema möglicherweise etwas zu groß, um damit zu beginnen. Der Vorteil besteht darin, dass die gesamte Auditionssprache ausführlicher und ausführlicher besprochen wird. Der Nachteil besteht darin, dass es viele Ressourcen erfordert. Obwohl wir in den letzten zehn Jahren viele Ressourcen entwickelt haben, ist Zhong ein Team, das besonders gut darin ist, große Mengen aufzubauen und großartige Produkte zu verkaufen. Allerdings sind einige Ressourcen in der begrenzten Zeit möglicherweise nicht genau genug. Es wäre besser, wenn wir mehr Zeit hätten. Ich hatte das Glück, nicht auf Fallstricke zu stoßen, aus denen ich nicht herauskommen konnte, und verwandelte die Katastrophe immer in Glück. Ich dachte zum Beispiel zunächst, dass so viele Gegenstände irgendwann stecken bleiben würden, aber durch vernünftiges Laden und Verstecken wurde das Die Bildrate war immer noch in Ordnung, das heißt, die Belastbarkeit des Motors ist tatsächlich besser, als wir es uns vorgestellt haben.

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Wie verwende ich Ansichtsfenster -Meta -Tags, um die Seite zu steuern, die auf mobilen Geräten skaliert wird?

Mar 13, 2025 pm 08:00 PM

Wie verwende ich Ansichtsfenster -Meta -Tags, um die Seite zu steuern, die auf mobilen Geräten skaliert wird?

Mar 13, 2025 pm 08:00 PM

In dem Artikel werden die Meta-Tags mit Ansichtsfenster besprochen, um die Seite zu steuern, die auf mobilen Geräten skaliert und sich auf Einstellungen wie Breite und initiale Maßstäbe für optimale Reaktionsfähigkeit und Leistung konzentriert.Character Count: 159

So führen Sie das H5 -Projekt aus

Apr 06, 2025 pm 12:21 PM

So führen Sie das H5 -Projekt aus

Apr 06, 2025 pm 12:21 PM

Ausführen des H5 -Projekts erfordert die folgenden Schritte: Installation der erforderlichen Tools wie Webserver, Node.js, Entwicklungstools usw. Erstellen Sie eine Entwicklungsumgebung, erstellen Sie Projektordner, initialisieren Sie Projekte und schreiben Sie Code. Starten Sie den Entwicklungsserver und führen Sie den Befehl mit der Befehlszeile aus. Vorschau des Projekts in Ihrem Browser und geben Sie die Entwicklungsserver -URL ein. Veröffentlichen Sie Projekte, optimieren Sie Code, stellen Sie Projekte bereit und richten Sie die Webserverkonfiguration ein.

Wie gehe ich mit der Privatsphäre und Berechtigungen des Benutzer Ort mit der Geolocation -API um?

Mar 18, 2025 pm 02:16 PM

Wie gehe ich mit der Privatsphäre und Berechtigungen des Benutzer Ort mit der Geolocation -API um?

Mar 18, 2025 pm 02:16 PM

In dem Artikel wird die Verwaltung der Privatsphäre und Berechtigungen des Benutzerstandorts mithilfe der Geolocation -API erörtert, wobei die Best Practices für die Anforderung von Berechtigungen, die Gewährleistung der Datensicherheit und die Einhaltung der Datenschutzgesetze hervorgehoben werden.

Wie benutze ich die API der HTML5 -Seite Sichtbarkeit, um zu erkennen, wann eine Seite sichtbar ist?

Mar 13, 2025 pm 07:51 PM

Wie benutze ich die API der HTML5 -Seite Sichtbarkeit, um zu erkennen, wann eine Seite sichtbar ist?

Mar 13, 2025 pm 07:51 PM

In dem Artikel werden die Sichtbarkeits -API der HTML5 -Seite mit der Sichtbarkeit von Seiten ermittelt, die Benutzererfahrung verbessert und die Ressourcennutzung optimiert. Zu den wichtigsten Aspekten gehören die Pause, die Verringerung der CPU -Last und die Verwaltung von Analysen auf der Grundlage von Sichtbarkeitsänderungen.

Wie verwende ich die HTML5 -Drag & Drop -API für interaktive Benutzeroberflächen?

Mar 18, 2025 pm 02:17 PM

Wie verwende ich die HTML5 -Drag & Drop -API für interaktive Benutzeroberflächen?

Mar 18, 2025 pm 02:17 PM

In dem Artikel wird erläutert, wie die HTML5 -Drag & Drop -API verwendet wird, um interaktive Benutzeroberflächen zu erstellen, Schritte zu detaillieren, um Elemente draggierbar zu machen, Schlüsselereignisse zu verarbeiten und Benutzererfahrung mit benutzerdefiniertem Feedback zu verbessern. Es wird auch gemeinsame Fallstricke zu a diskutiert

Bedarf die Produktion von H5 -Seiten eine kontinuierliche Wartung?

Apr 05, 2025 pm 11:27 PM

Bedarf die Produktion von H5 -Seiten eine kontinuierliche Wartung?

Apr 05, 2025 pm 11:27 PM

Die H5 -Seite muss aufgrund von Faktoren wie Code -Schwachstellen, Browserkompatibilität, Leistungsoptimierung, Sicherheitsaktualisierungen und Verbesserungen der Benutzererfahrung kontinuierlich aufrechterhalten werden. Zu den effektiven Wartungsmethoden gehören das Erstellen eines vollständigen Testsystems, die Verwendung von Versionstools für Versionskontrolle, die regelmäßige Überwachung der Seitenleistung, das Sammeln von Benutzern und die Formulierung von Wartungsplänen.

Was genau bedeutet H5 -Seitenproduktion?

Apr 06, 2025 am 07:18 AM

Was genau bedeutet H5 -Seitenproduktion?

Apr 06, 2025 am 07:18 AM

Die Produktion von H5-Seiten bezieht sich auf die Erstellung von plattformübergreifenden kompatiblen Webseiten unter Verwendung von Technologien wie HTML5, CSS3 und JavaScript. Sein Kern liegt im Parsingcode des Browsers, der Struktur-, Stil- und interaktive Funktionen macht. Zu den allgemeinen Technologien gehören Animationseffekte, reaktionsschnelles Design und Dateninteraktion. Um Fehler zu vermeiden, sollten Entwickler debuggen werden. Leistungsoptimierung und Best Practices umfassen Bildformatoptimierung, Anforderungsreduzierung und Codespezifikationen usw., um die Ladegeschwindigkeit und die Codequalität zu verbessern.

Wie verwende ich die HTML5 WebSockets -API für die bidirektionale Kommunikation zwischen Client und Server?

Mar 12, 2025 pm 03:20 PM

Wie verwende ich die HTML5 WebSockets -API für die bidirektionale Kommunikation zwischen Client und Server?

Mar 12, 2025 pm 03:20 PM

In diesem Artikel werden die HTML5 WebSockets-API für die Kommunikation zwischen bidirektionaler Client-Server in Echtzeit erläutert. Es werden clientseitige (JavaScript) und serverseitige (Python/Flask) -implementierungen beschrieben, die Herausforderungen wie Skalierbarkeit, staatliches Management, ein