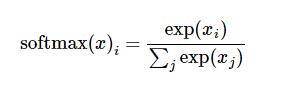

Die Softmax-Regressionsfunktion wird verwendet, um die Klassifizierungsergebnisse zu normalisieren. Es unterscheidet sich jedoch von der allgemeinen Normalisierungsmethode entsprechend der Proportionen. Die Normalisierung erfolgt durch logarithmische Transformation, sodass größere Werte während des Normalisierungsprozesses stärker zunehmen.

Softmax-Formel

Softmax-Implementierungsmethode 1

import numpy as np

def softmax(x):

"""Compute softmax values for each sets of scores in x."""

pass # TODO: Compute and return softmax(x)

x = np.array(x)

x = np.exp(x)

x.astype('float32')

if x.ndim == 1:

sumcol = sum(x)

for i in range(x.size):

x[i] = x[i]/float(sumcol)

if x.ndim > 1:

sumcol = x.sum(axis = 0)

for row in x:

for i in range(row.size):

row[i] = row[i]/float(sumcol[i])

return x

#测试结果

scores = [3.0,1.0, 0.2]

print softmax(scores)

seine Berechnung Die Ergebnisse sind wie folgt:

[ 0.8360188 0.11314284 0.05083836]

Softmax-Implementierungsmethode 2

import numpy as np def softmax(x): return np.exp(x)/np.sum(np.exp(x),axis=0) #测试结果 scores = [3.0,1.0, 0.2] print softmax(scores)

Die obige Implementierungsmethode der Softmax-Regressionsfunktion unter Python (empfohlen) ist der gesamte vom Herausgeber geteilte Inhalt. Ich hoffe, dass er Ihnen eine Referenz geben kann, und ich hoffe auch, dass Sie die chinesische PHP-Website unterstützen.

Weitere verwandte Artikel zur Implementierung der Softmax-Regressionsfunktion unter Python finden Sie auf der chinesischen PHP-Website!