Scrapy ist in Python geschrieben, leicht, einfach und leicht und sehr bequem zu verwenden. Die Verwendung von Scrapy kann die Sammlung von Online-Daten problemlos vervollständigen. Es hat uns viel Arbeit abgenommen, ohne dass wir große Anstrengungen unternehmen müssen, um es selbst zu entwickeln. In diesem Artikel wird die Verwendung des Scrapy-Frameworks von Python zum Crawlen schöner Bilder in zehn Minuten vorgestellt. Freunde, die es benötigen, können sich auf die folgende

Einführung

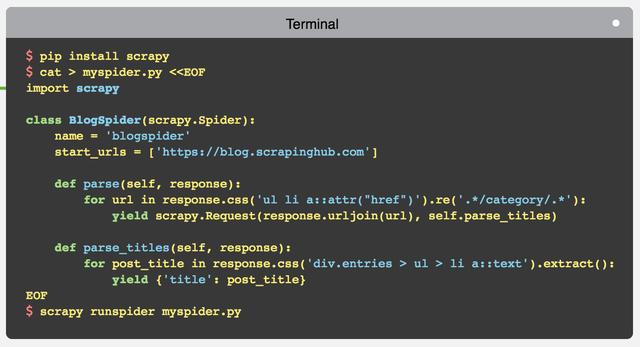

Scrapy ist ein Python-Framework. Das Folgende ist ein Crawler-Framework, das reich an Funktionen ist und schnell und einfach zu verwenden ist. Sie können Scrapy verwenden, um schnell einen einfachen Crawler zu entwickeln. Ein einfaches Beispiel des Beamten reicht aus, um seine Leistungsfähigkeit zu beweisen:

Schnelle Entwicklung

Der 10-Minuten-Countdown beginnt unten: Bevor Sie beginnen, können Sie natürlich einen Blick auf den kratzigen Einführungsartikel werfen, den wir zuvor geschrieben haben: „Python-Crawler von Zero Basics schreiben“. : Scrapy Framework zum Schreiben von Crawlern verwenden1 Initialisieren Sie das Projekt

scrapy startproject mzt cd mzt scrapy genspider meizitu meizitu.com

2. Spider-Code hinzufügen:

Scrapy.Item definieren, image_urls und Bilder hinzufügen und das Herunterladen von Bildern vorbereiten. Ändern Sie start_urls auf der Startseite, fügen Sie parse hinzu, um die Listenseite zu verarbeiten, und fügen Sie parse_item hinzu, um die Elementseite zu verarbeiten.

3. Ändern Sie die Konfigurationsdatei:

DOWNLOAD_DELAY = 1 # 添加下载延迟配置

ITEM_PIPELINES = {'scrapy.pipelines.images.ImagesPipeline': 1} # 添加图片下载 pipeline

IMAGES_STORE = '.' # 设置图片保存目录4. Führen Sie das Projekt aus:

scrapy crawl meizitu

Sehen Sie sich die Renderings des Projektbetriebs an