Python crawlt die Daten der Baidu-Enzyklopädie

Crawling-Strategie

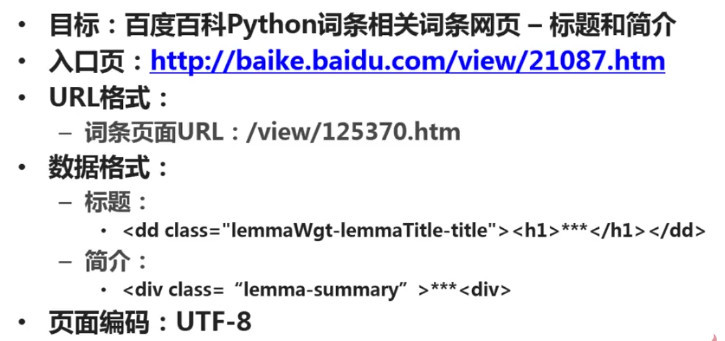

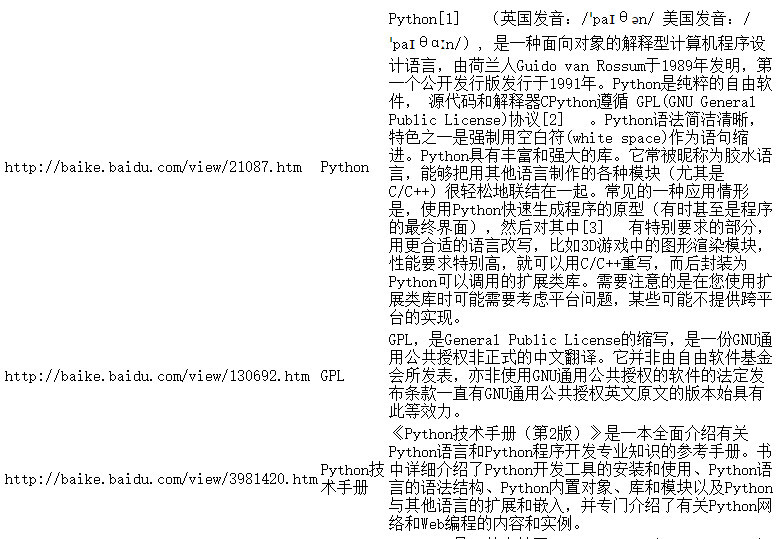

Bestimmen Sie das Ziel: Bestimmen Sie, welcher Teil der Daten welcher Seiten welcher Website gecrawlt werden soll. Dieses Beispiel erfasst den Titel und die Einleitung der Python-Einstiegsseite der Baidu-Enzyklopädie und der Python-bezogenen Einstiegsseite.

Analyseziel: Analysieren Sie das Format der zu crawlenden URL und begrenzen Sie den Crawling-Bereich. Analysieren Sie das Format der zu erfassenden Daten. In diesem Beispiel müssen wir das Format der Tags analysieren, in denen sich die beiden Daten, Titel und Einleitung, befinden. Analysieren Sie das Format der zu crawlenden Seitenkodierung. Im Abschnitt „Webseiten-Parser“ müssen Sie die Webseitenkodierung angeben, bevor eine korrekte Analyse durchgeführt werden kann.

Code schreiben: Im Webseiten-Parser-Teil müssen Sie die durch die Analyse des Ziels erhaltenen Ergebnisse verwenden.

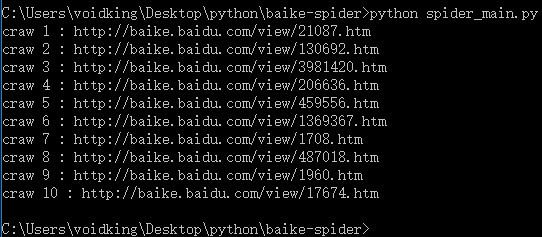

Crawler ausführen: Datenerfassung durchführen.

Analyseziele

1. URL-Format

Die Links zu verwandten Einträgen auf der Seite sind relativ einheitlich, meist /view/xxx.htm.

2. Datenformat

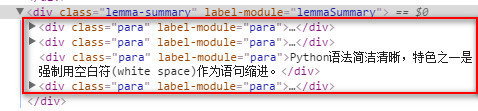

Der Titel befindet sich im h1-Untertag unter der Klasse lemmaWgt-lemmaTitle-title und die Einleitung befindet sich unter der Klasse lemma-summary.

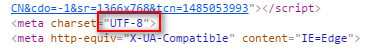

3. Kodierungsformat

Sehen Sie sich das Seitenkodierungsformat an, das utf-8 ist.

Nach der obigen Analyse sind die Ergebnisse wie folgt:

Code-Schreiben

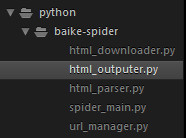

Projektstruktur

In sublime Erstellen Sie als Nächstes einen neuen Ordner „Baike-Spider“ als Projektstammverzeichnis.

Erstellen Sie eine neue Datei „spider_main.py“ als Crawler-Master-Scheduler.

Erstellen Sie eine neue url_manger.py als URL-Manager.

Erstellen Sie eine neue html_downloader.py als HTML-Downloader.

Erstellen Sie eine neue Datei html_parser.py als HTML-Parser.

Erstellen Sie eine neue html_outputer.py als Werkzeug zum Schreiben von Daten.

Die endgültige Projektstruktur ist wie folgt:

spider_main.py

# coding:utf-8

import url_manager, html_downloader, html_parser, html_outputer

class SpiderMain(object):

def __init__(self):

self.urls = url_manager.UrlManager()

self.downloader = html_downloader.HtmlDownloader()

self.parser = html_parser.HtmlParser()

self.outputer = html_outputer.HtmlOutputer()

def craw(self, root_url):

count = 1

self.urls.add_new_url(root_url)

while self.urls.has_new_url():

try:

new_url = self.urls.get_new_url()

print('craw %d : %s' % (count, new_url))

html_cont = self.downloader.download(new_url)

new_urls, new_data = self.parser.parse(new_url, html_cont)

self.urls.add_new_urls(new_urls)

self.outputer.collect_data(new_data)

if count == 10:

break

count = count + 1

except:

print('craw failed')

self.outputer.output_html()

if __name__=='__main__':

root_url = 'http://baike.baidu.com/view/21087.htm'

obj_spider = SpiderMain()

obj_spider.craw(root_url)url_manger.py

# coding:utf-8 class UrlManager(object): def __init__(self): self.new_urls = set() self.old_urls = set() def add_new_url(self, url): if url is None: return if url not in self.new_urls and url not in self.old_urls: self.new_urls.add(url) def add_new_urls(self, urls): if urls is None or len(urls) == 0: return for url in urls: self.add_new_url(url) def has_new_url(self): return len(self.new_urls) != 0 def get_new_url(self): new_url = self.new_urls.pop() self.old_urls.add(new_url) return new_url

html_downloader.py

# coding:utf-8 import urllib.request class HtmlDownloader(object): def download(self, url): if url is None: return None response = urllib.request.urlopen(url) if response.getcode() != 200: return None return response.read()

html_parser.py

# coding:utf-8

from bs4 import BeautifulSoup

import re

from urllib.parse import urljoin

class HtmlParser(object):

def _get_new_urls(self, page_url, soup):

new_urls = set()

# /view/123.htm

links = soup.find_all('a', href=re.compile(r'/view/\d+\.htm'))

for link in links:

new_url = link['href']

new_full_url = urljoin(page_url, new_url)

# print(new_full_url)

new_urls.add(new_full_url)

#print(new_urls)

return new_urls

def _get_new_data(self, page_url, soup):

res_data = {}

# url

res_data['url'] = page_url

# <dd class="lemmaWgt-lemmaTitle-title"> <h1>Python</h1>

title_node = soup.find('dd', class_='lemmaWgt-lemmaTitle-title').find('h1')

res_data['title'] = title_node.get_text()

# <p class="lemma-summary" label-module="lemmaSummary">

summary_node = soup.find('p', class_='lemma-summary')

res_data['summary'] = summary_node.get_text()

# print(res_data)

return res_data

def parse(self, page_url, html_cont):

if page_url is None or html_cont is None:

return

soup = BeautifulSoup(html_cont, 'html.parser')

# print(soup.prettify())

new_urls = self._get_new_urls(page_url, soup)

new_data = self._get_new_data(page_url, soup)

# print('mark')

return new_urls, new_datahtml_outputer.py

# coding:utf-8

class HtmlOutputer(object):

def __init__(self):

self.datas = []

def collect_data(self, data):

if data is None:

return

self.datas.append(data)

def output_html(self):

fout = open('output.html','w', encoding='utf-8')

fout.write('<html>')

fout.write('<body>')

fout.write('<table>')

for data in self.datas:

fout.write('<tr>')

fout.write('<td>%s</td>' % data['url'])

fout.write('<td>%s</td>' % data['title'])

fout.write('<td>%s</td>' % data['summary'])

fout.write('</tr>')

fout.write('</table>')

fout.write('</body>')

fout.write('</html>')

fout.close()Ausführen

Führen Sie in der Befehlszeile python spider_main.py aus.

Kodierungsproblem

Problembeschreibung: UnicodeEncodeError: Der Codec „gbk“ kann das Zeichen „xa0“ an Position nicht kodieren ...

Beim Schreiben einer Datei mit Python oder Beim Schreiben von Netzwerkdatenströmen in lokale Dateien tritt dieses Problem in den meisten Fällen auf. Es gibt viele ähnliche Artikel im Internet, die sich mit der Lösung dieses Problems befassen, aber sie sind nichts anderes als Codierung und Decodierung. Ist dies die wahre Ursache dieses Problems? NEIN. Oft verwenden wir Dekodieren und Kodieren und probieren verschiedene Kodierungen aus, z. B. utf8, utf-8, gbk, gb2312 usw. Wir haben alle Kodierungen ausprobiert, aber der Fehler tritt immer noch auf, was frustrierend ist.

Beim Schreiben von Python-Skripten unter Windows ist das Codierungsproblem sehr ernst. Beim Schreiben von Netzwerkdatenströmen in Dateien werden wir auf mehrere Kodierungen stoßen:

1. #encoding='XXX'

Die Kodierung hier (dh der Inhalt der ersten Zeile der Python-Datei) bezieht sich auf Python script Die Kodierung der Datei selbst spielt keine Rolle. Solange die Codierung von XXX und der Datei selbst identisch sind, ist alles in Ordnung.

Im Menü „Format“ von Notepad++ können beispielsweise verschiedene Kodierungen eingestellt werden. In diesem Fall müssen Sie sicherstellen, dass die im Menü eingestellte Kodierung mit der Kodierung XXX übereinstimmt gemeldet werden.

2. Kodierung des Netzwerkdatenstroms

Wenn Sie beispielsweise eine Webseite erhalten, ist die Kodierung des Netzwerkdatenstroms die Kodierung der Webseite. Zum Dekodieren in die Unicode-Kodierung muss Dekodieren verwendet werden.

3. Kodierung der Zieldatei

Schreiben Sie den Netzwerkdatenstrom in eine neue Datei. Der Dateischreibcode lautet wie folgt:

fout = open('output.html','w')

fout.write(str)Unter Windows ist die Standardkodierung von Neue Dateien sind gbk. Der Python-Interpreter verwendet die gbk-Kodierung, um unseren Netzwerkdatenstrom str zu analysieren. Allerdings handelt es sich bei str um eine dekodierte Unicode-Kodierung, was zu einem Fehler beim Parsen und den oben genannten Problemen führt. Die Lösung besteht darin, die Kodierung der Zieldatei zu ändern:

fout = open('output.html','w', encoding='utf-8')运行结果

更多Python抓取百度百科数据 相关文章请关注PHP中文网!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Was ist der Grund, warum PS immer wieder Laden zeigt?

Apr 06, 2025 pm 06:39 PM

Was ist der Grund, warum PS immer wieder Laden zeigt?

Apr 06, 2025 pm 06:39 PM

PS "Laden" Probleme werden durch Probleme mit Ressourcenzugriff oder Verarbeitungsproblemen verursacht: Die Lesegeschwindigkeit von Festplatten ist langsam oder schlecht: Verwenden Sie Crystaldiskinfo, um die Gesundheit der Festplatte zu überprüfen und die problematische Festplatte zu ersetzen. Unzureichender Speicher: Upgrade-Speicher, um die Anforderungen von PS nach hochauflösenden Bildern und komplexen Schichtverarbeitung zu erfüllen. Grafikkartentreiber sind veraltet oder beschädigt: Aktualisieren Sie die Treiber, um die Kommunikation zwischen PS und der Grafikkarte zu optimieren. Dateipfade sind zu lang oder Dateinamen haben Sonderzeichen: Verwenden Sie kurze Pfade und vermeiden Sie Sonderzeichen. Das eigene Problem von PS: Installieren oder reparieren Sie das PS -Installateur neu.

Wie löst ich das Problem des Ladens beim Starten von PS?

Apr 06, 2025 pm 06:36 PM

Wie löst ich das Problem des Ladens beim Starten von PS?

Apr 06, 2025 pm 06:36 PM

Ein PS, der beim Booten auf "Laden" steckt, kann durch verschiedene Gründe verursacht werden: Deaktivieren Sie korrupte oder widersprüchliche Plugins. Eine beschädigte Konfigurationsdatei löschen oder umbenennen. Schließen Sie unnötige Programme oder aktualisieren Sie den Speicher, um einen unzureichenden Speicher zu vermeiden. Upgrade auf ein Solid-State-Laufwerk, um die Festplatte zu beschleunigen. PS neu installieren, um beschädigte Systemdateien oder ein Installationspaketprobleme zu reparieren. Fehlerinformationen während des Startprozesses der Fehlerprotokollanalyse anzeigen.

Wie löste ich das Problem des Ladens, wenn die PS die Datei öffnet?

Apr 06, 2025 pm 06:33 PM

Wie löste ich das Problem des Ladens, wenn die PS die Datei öffnet?

Apr 06, 2025 pm 06:33 PM

Das Laden von Stottern tritt beim Öffnen einer Datei auf PS auf. Zu den Gründen gehören: zu große oder beschädigte Datei, unzureichender Speicher, langsame Festplattengeschwindigkeit, Probleme mit dem Grafikkarten-Treiber, PS-Version oder Plug-in-Konflikte. Die Lösungen sind: Überprüfen Sie die Dateigröße und -integrität, erhöhen Sie den Speicher, aktualisieren Sie die Festplatte, aktualisieren Sie den Grafikkartentreiber, deinstallieren oder deaktivieren Sie verdächtige Plug-Ins und installieren Sie PS. Dieses Problem kann effektiv gelöst werden, indem die PS -Leistungseinstellungen allmählich überprüft und genutzt wird und gute Dateimanagementgewohnheiten entwickelt werden.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Wie kontrolliert PS -Federn die Weichheit des Übergangs?

Apr 06, 2025 pm 07:33 PM

Wie kontrolliert PS -Federn die Weichheit des Übergangs?

Apr 06, 2025 pm 07:33 PM

Der Schlüssel zur Federkontrolle liegt darin, seine allmähliche Natur zu verstehen. PS selbst bietet nicht die Möglichkeit, die Gradientenkurve direkt zu steuern, aber Sie können den Radius und die Gradientenweichheit flexius durch mehrere Federn, Matching -Masken und feine Selektionen anpassen, um einen natürlichen Übergangseffekt zu erzielen.

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

MySQL hat eine kostenlose Community -Version und eine kostenpflichtige Enterprise -Version. Die Community -Version kann kostenlos verwendet und geändert werden, die Unterstützung ist jedoch begrenzt und für Anwendungen mit geringen Stabilitätsanforderungen und starken technischen Funktionen geeignet. Die Enterprise Edition bietet umfassende kommerzielle Unterstützung für Anwendungen, die eine stabile, zuverlässige Hochleistungsdatenbank erfordern und bereit sind, Unterstützung zu bezahlen. Zu den Faktoren, die bei der Auswahl einer Version berücksichtigt werden, gehören Kritikalität, Budgetierung und technische Fähigkeiten von Anwendungen. Es gibt keine perfekte Option, nur die am besten geeignete Option, und Sie müssen die spezifische Situation sorgfältig auswählen.

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

Die MySQL -Leistungsoptimierung muss von drei Aspekten beginnen: Installationskonfiguration, Indexierung und Abfrageoptimierung, Überwachung und Abstimmung. 1. Nach der Installation müssen Sie die my.cnf -Datei entsprechend der Serverkonfiguration anpassen, z. 2. Erstellen Sie einen geeigneten Index, um übermäßige Indizes zu vermeiden und Abfrageanweisungen zu optimieren, z. B. den Befehl Erklärung zur Analyse des Ausführungsplans; 3. Verwenden Sie das eigene Überwachungstool von MySQL (ShowProcessList, Showstatus), um die Datenbankgesundheit zu überwachen und die Datenbank regelmäßig zu sichern und zu organisieren. Nur durch kontinuierliche Optimierung dieser Schritte kann die Leistung der MySQL -Datenbank verbessert werden.

Was soll ich tun, wenn sich die PS -Karte in der Ladeschnittstelle befindet?

Apr 06, 2025 pm 06:54 PM

Was soll ich tun, wenn sich die PS -Karte in der Ladeschnittstelle befindet?

Apr 06, 2025 pm 06:54 PM

Die Ladeschnittstelle der PS-Karte kann durch die Software selbst (Dateibeschäftigung oder Plug-in-Konflikt), die Systemumgebung (ordnungsgemäße Treiber- oder Systemdateienbeschäftigung) oder Hardware (Hartscheibenbeschäftigung oder Speicherstickfehler) verursacht werden. Überprüfen Sie zunächst, ob die Computerressourcen ausreichend sind. Schließen Sie das Hintergrundprogramm und geben Sie den Speicher und die CPU -Ressourcen frei. Beheben Sie die PS-Installation oder prüfen Sie, ob Kompatibilitätsprobleme für Plug-Ins geführt werden. Aktualisieren oder Fallback die PS -Version. Überprüfen Sie den Grafikkartentreiber und aktualisieren Sie ihn und führen Sie die Systemdateiprüfung aus. Wenn Sie die oben genannten Probleme beheben, können Sie die Erkennung von Festplatten und Speichertests ausprobieren.