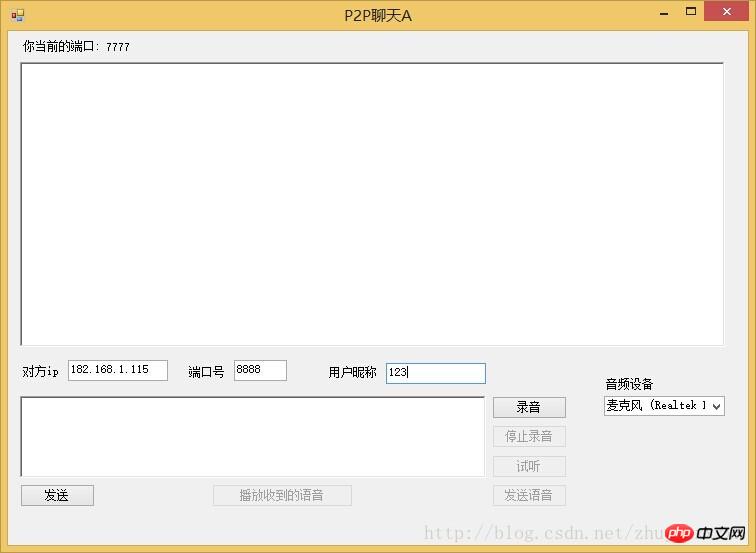

C# P2P-Voice-Chat-Tool basierend auf UDP

Originalitätserklärung

Die Quelle dieses Blogbeitrags ist http://www.php.cn/ Wenn Sie fertig sind, geben Sie beim Nachdruck bitte die Quelle an. Dieser Artikel ist ein Original des Autors. Senden Sie eine E-Mail an zhujunxxxxx@163.com. Wenn Sie Fragen haben, wenden Sie sich bitte an den Autor

Übersicht

Ich habe schon einmal einen Artikel gepostethttp://www.php.cn / Die UDP-Funktion zum Senden von Daten in Paketen wurde implementiert. In diesem Artikel handelt es sich hauptsächlich um eine Anwendung, die UDP zum Übertragen von Informationen wie Sprache und Text verwendet. In diesem System gibt es keinen Server und keinen Client, und die gegenseitige Kommunikation steht in direktem Zusammenhang miteinander. Kann gute Ergebnisse erzielen.

Spracherfassung

Um eine Sprachnachricht zu senden, müssen Sie zuerst die Stimme abrufen. Es gibt mehrere Methoden, um DirectXSound zu verwenden Einfachheit. Ein Open-Source-Plug-in NAudio zur Implementierung von Sprachaufzeichnungen. Referenz NAudio.dll

//------------------录音相关-----------------------------

private IWaveIn waveIn;

private WaveFileWriter writer;

private void LoadWasapiDevicesCombo()

{

var deviceEnum = new MMDeviceEnumerator();

var devices = deviceEnum.EnumerateAudioEndPoints(DataFlow.Capture, DeviceState.Active).ToList();

comboBox1.DataSource = devices;

comboBox1.DisplayMember = "FriendlyName";

}

private void CreateWaveInDevice()

{

waveIn = new WaveIn();

waveIn.WaveFormat = new WaveFormat(8000, 1);

waveIn.DataAvailable += OnDataAvailable;

waveIn.RecordingStopped += OnRecordingStopped;

}

void OnDataAvailable(object sender, WaveInEventArgs e)

{

if (this.InvokeRequired)

{

this.BeginInvoke(new EventHandler<WaveInEventArgs>(OnDataAvailable), sender, e);

}

else

{

writer.Write(e.Buffer, 0, e.BytesRecorded);

int secondsRecorded = (int)(writer.Length / writer.WaveFormat.AverageBytesPerSecond);

if (secondsRecorded >= 10)//最大10s

{

StopRecord();

}

else

{

l_sound.Text = secondsRecorded + " s";

}

}

}

void OnRecordingStopped(object sender, StoppedEventArgs e)

{

if (InvokeRequired)

{

BeginInvoke(new EventHandler<StoppedEventArgs>(OnRecordingStopped), sender, e);

}

else

{

FinalizeWaveFile();

}

}

void StopRecord()

{

AllChangeBtn(btn_luyin, true);

AllChangeBtn(btn_stop, false);

AllChangeBtn(btn_sendsound, true);

AllChangeBtn(btn_play, true);

//btn_luyin.Enabled = true;

//btn_stop.Enabled = false;

//btn_sendsound.Enabled = true;

//btn_play.Enabled = true;

if (waveIn != null)

waveIn.StopRecording();

//Cleanup();

}

private void Cleanup()

{

if (waveIn != null)

{

waveIn.Dispose();

waveIn = null;

}

FinalizeWaveFile();

}

private void FinalizeWaveFile()

{

if (writer != null)

{

writer.Dispose();

writer = null;

}

}

//开始录音

private void btn_luyin_Click(object sender, EventArgs e)

{

btn_stop.Enabled = true;

btn_luyin.Enabled = false;

if (waveIn == null)

{

CreateWaveInDevice();

}

if (File.Exists(soundfile))

{

File.Delete(soundfile);

}

writer = new WaveFileWriter(soundfile, waveIn.WaveFormat);

waveIn.StartRecording();

}

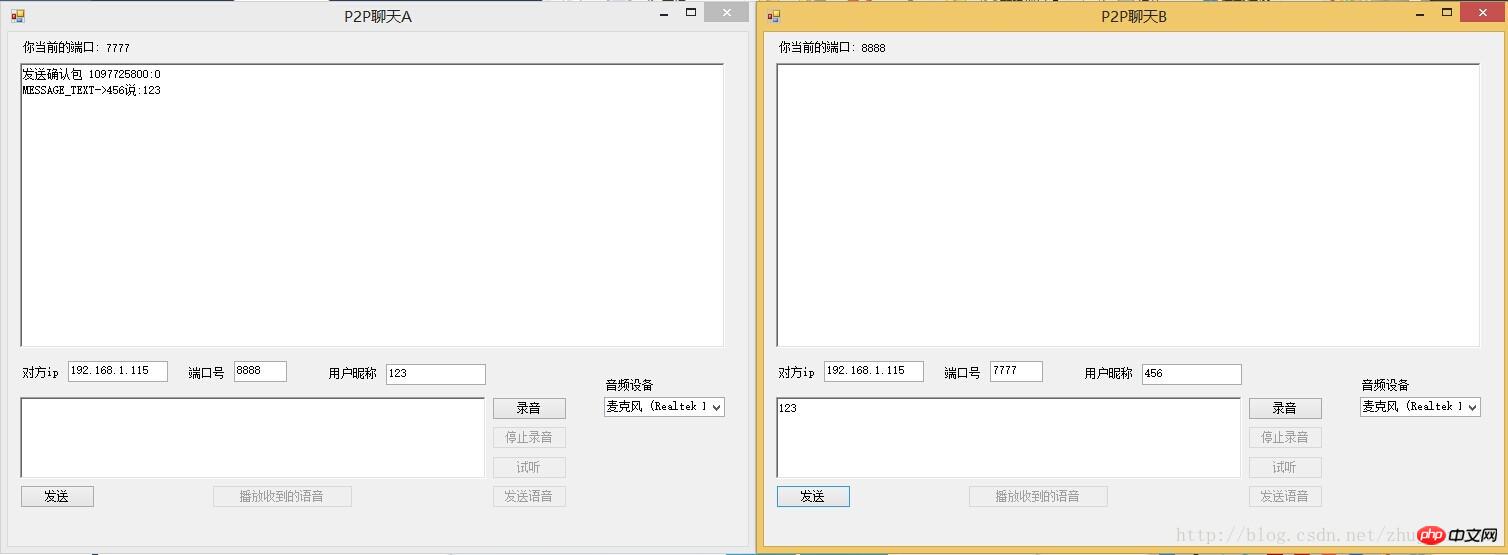

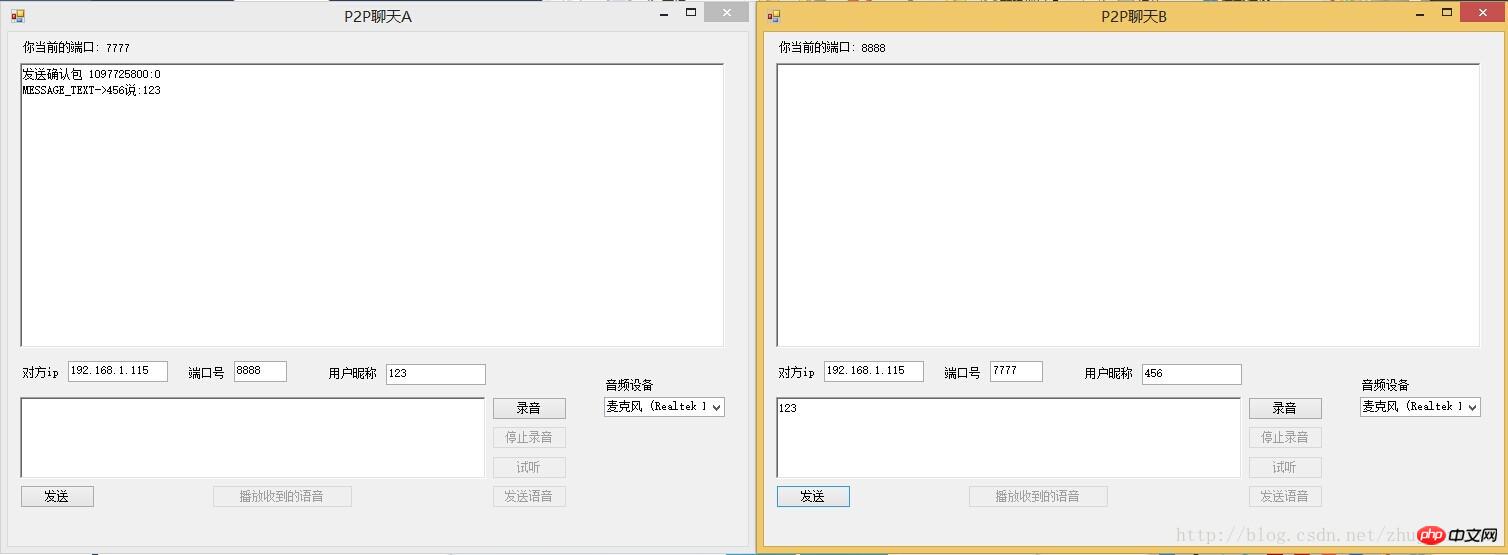

Sprachübertragung

Nachdem wir die Stimme erhalten haben, müssen wir sie senden raus

Wenn wir das Audio aufnehmen, klicken Sie auf Senden. Der relevante Code für diesen Teil ist

MsgTranslator tran = null;

public Form1()

{

InitializeComponent();

LoadWasapiDevicesCombo();//显示音频设备

Config cfg = SeiClient.GetDefaultConfig();

cfg.Port = 7777;

UDPThread udp = new UDPThread(cfg);

tran = new MsgTranslator(udp, cfg);

tran.MessageReceived += tran_MessageReceived;

tran.Debuged += new EventHandler<DebugEventArgs>(tran_Debuged);

}

private void btn_sendsound_Click(object sender, EventArgs e)

{

if (t_ip.Text == "")

{

MessageBox.Show("请输入ip");

return;

}

if (t_port.Text == "")

{

MessageBox.Show("请输入端口号");

return;

}

string ip = t_ip.Text;

int port = int.Parse(t_port.Text);

string nick = t_nick.Text;

string msg = "语音消息";

IPEndPoint remote = new IPEndPoint(IPAddress.Parse(ip), port);

Msg m = new Msg(remote, "zz", nick, Commands.SendMsg, msg, "Come From A");

m.IsRequireReceive = true;

m.ExtendMessageBytes = FileContent(soundfile);

m.PackageNo = Msg.GetRandomNumber();

m.Type = Consts.MESSAGE_BINARY;

tran.Send(m);

}

private byte[] FileContent(string fileName)

{

FileStream fs = new FileStream(fileName, FileMode.Open, FileAccess.Read);

try

{

byte[] buffur = new byte[fs.Length];

fs.Read(buffur, 0, (int)fs.Length);

return buffur;

}

catch (Exception ex)

{

return null;

}

finally

{

if (fs != null)

{

//关闭资源

fs.Close();

}

}

} Auf diese Weise haben wir die generierte Sprachdatei gesendet

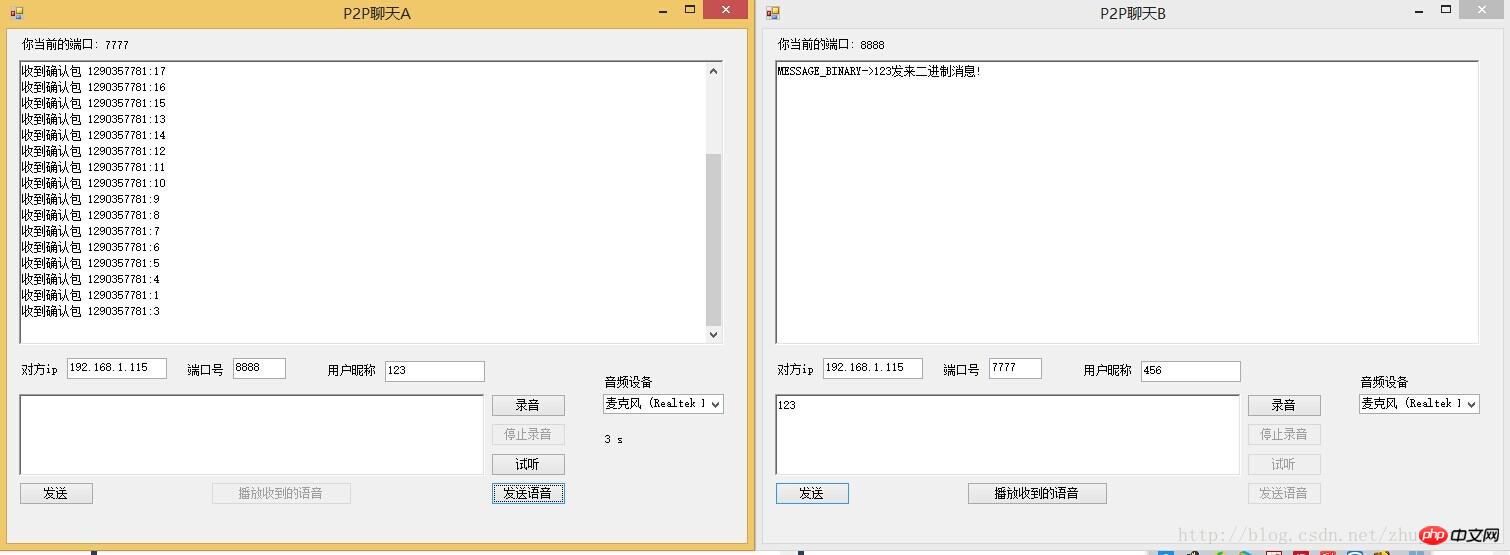

Empfang und Wiedergabe der Stimme

Eigentlich der Empfang und Sprachwiedergabe Es gibt keinen Unterschied beim Empfang von Textnachrichten, außer dass die Stimme binär gesendet wird. Nach dem Empfang der Stimme sollten wir sie also in eine Datei schreiben. Nachdem der Empfang abgeschlossen ist, spielen Sie einfach die Stimme ab.

Der folgende Code dient hauptsächlich dazu, die empfangenen Daten in einer Datei zu speichern. Dieses Funktionsereignis wird ausgelöst, wenn eine Nachricht in meinem NetFrame empfangen wird

void tran_MessageReceived(object sender, MessageEventArgs e)

{

Msg msg = e.msg;

if (msg.Type == Consts.MESSAGE_BINARY)

{

string m = msg.Type + "->" + msg.UserName + "发来二进制消息!";

AddServerMessage(m);

if (File.Exists(recive_soundfile))

{

File.Delete(recive_soundfile);

}

FileStream fs = new FileStream(recive_soundfile, FileMode.Create, FileAccess.Write);

fs.Write(msg.ExtendMessageBytes, 0, msg.ExtendMessageBytes.Length);

fs.Close();

//play_sound(recive_soundfile);

ChangeBtn(true);

}

else

{

string m = msg.Type + "->" + msg.UserName + "说:" + msg.NormalMsg;

AddServerMessage(m);

}

} Nachdem wir die Sprachnachricht erhalten haben, müssen wir sie abspielen und beim Abspielen immer noch dasselbe Plug-In verwenden Spielen

//--------播放部分----------

private IWavePlayer wavePlayer;

private WaveStream reader;

public void play_sound(string filename)

{

if (wavePlayer != null)

{

wavePlayer.Dispose();

wavePlayer = null;

}

if (reader != null)

{

reader.Dispose();

}

reader = new MediaFoundationReader(filename, new MediaFoundationReader.MediaFoundationReaderSettings() { SingleReaderObject = true });

if (wavePlayer == null)

{

wavePlayer = new WaveOut();

wavePlayer.PlaybackStopped += WavePlayerOnPlaybackStopped;

wavePlayer.Init(reader);

}

wavePlayer.Play();

}

private void WavePlayerOnPlaybackStopped(object sender, StoppedEventArgs stoppedEventArgs)

{

if (stoppedEventArgs.Exception != null)

{

MessageBox.Show(stoppedEventArgs.Exception.Message);

}

if (wavePlayer != null)

{

wavePlayer.Stop();

}

btn_luyin.Enabled = true;

}private void btn_play_Click(object sender, EventArgs e)

{

btn_luyin.Enabled = false;

play_sound(soundfile);

}

Die Schnittstelle zum Empfangen und Senden einer Sprachnachricht ist oben dargestellt

Technische Zusammenfassung

Die wichtigsten verwendeten Technologien sind UDP und NAudio Recording und Wiedergabefunktionen

Das Obige ist der Inhalt des in c# basierenden P2P-Voice-Chat-Tools, das auf udp basiert. Weitere verwandte Inhalte finden Sie hier zur chinesischen PHP-Website (www.php.cn)!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1393

1393

52

52

1209

1209

24

24

Active Directory mit C#

Sep 03, 2024 pm 03:33 PM

Active Directory mit C#

Sep 03, 2024 pm 03:33 PM

Leitfaden zu Active Directory mit C#. Hier besprechen wir die Einführung und die Funktionsweise von Active Directory in C# sowie die Syntax und das Beispiel.

C#-Serialisierung

Sep 03, 2024 pm 03:30 PM

C#-Serialisierung

Sep 03, 2024 pm 03:30 PM

Leitfaden zur C#-Serialisierung. Hier besprechen wir die Einführung, die Schritte des C#-Serialisierungsobjekts, die Funktionsweise bzw. das Beispiel.

Zufallszahlengenerator in C#

Sep 03, 2024 pm 03:34 PM

Zufallszahlengenerator in C#

Sep 03, 2024 pm 03:34 PM

Leitfaden zum Zufallszahlengenerator in C#. Hier besprechen wir die Funktionsweise des Zufallszahlengenerators, das Konzept von Pseudozufallszahlen und sicheren Zahlen.

C#-Datenrasteransicht

Sep 03, 2024 pm 03:32 PM

C#-Datenrasteransicht

Sep 03, 2024 pm 03:32 PM

Leitfaden zur C#-Datenrasteransicht. Hier diskutieren wir die Beispiele, wie eine Datenrasteransicht aus der SQL-Datenbank oder einer Excel-Datei geladen und exportiert werden kann.

Muster in C#

Sep 03, 2024 pm 03:33 PM

Muster in C#

Sep 03, 2024 pm 03:33 PM

Leitfaden zu Mustern in C#. Hier besprechen wir die Einführung und die drei wichtigsten Arten von Mustern in C# zusammen mit ihren Beispielen und der Code-Implementierung.

Primzahlen in C#

Sep 03, 2024 pm 03:35 PM

Primzahlen in C#

Sep 03, 2024 pm 03:35 PM

Leitfaden zu Primzahlen in C#. Hier besprechen wir die Einführung und Beispiele von Primzahlen in C# sowie die Codeimplementierung.

Fakultät in C#

Sep 03, 2024 pm 03:34 PM

Fakultät in C#

Sep 03, 2024 pm 03:34 PM

Leitfaden zur Fakultät in C#. Hier diskutieren wir die Einführung in die Fakultät in C# zusammen mit verschiedenen Beispielen und Code-Implementierungen.

Der Unterschied zwischen Multithreading und asynchronem C#

Apr 03, 2025 pm 02:57 PM

Der Unterschied zwischen Multithreading und asynchronem C#

Apr 03, 2025 pm 02:57 PM

Der Unterschied zwischen Multithreading und Asynchron besteht darin, dass Multithreading gleichzeitig mehrere Threads ausführt, während asynchron Operationen ausführt, ohne den aktuellen Thread zu blockieren. Multithreading wird für rechenintensive Aufgaben verwendet, während asynchron für die Benutzerinteraktion verwendet wird. Der Vorteil des Multi-Threading besteht darin, die Rechenleistung zu verbessern, während der Vorteil von Asynchron nicht darin besteht, UI-Threads zu blockieren. Die Auswahl von Multithreading oder Asynchron ist von der Art der Aufgabe abhängt: Berechnungsintensive Aufgaben verwenden Multithreading, Aufgaben, die mit externen Ressourcen interagieren und die UI-Reaktionsfähigkeit asynchron verwenden müssen.