Backend-Entwicklung

Backend-Entwicklung

XML/RSS-Tutorial

XML/RSS-Tutorial

RSS und Crawler, ausführliche Erklärung zur Datenerfassung

RSS und Crawler, ausführliche Erklärung zur Datenerfassung

RSS und Crawler, ausführliche Erklärung zur Datenerfassung

Zusammenfassung: Bevor der Wert von Daten ermittelt werden kann, müssen diese zunächst Prozesse wie das Sammeln, Speichern, Analysieren und Berechnen durchlaufen. Die Gewinnung umfassender und genauer Daten ist die Grundlage für das Data Value Mining. Diese Ausgabe der „Big Data Story“ des CSDN Cloud Computing Club beginnt mit den gängigsten Datenerfassungsmethoden – RSS und Suchmaschinen-Crawlern.

Am 30. Dezember fand die CSDN Cloud Computing Club-Veranstaltung im 3W Coffee statt. Das Thema der Veranstaltung lautete „RSS und Crawler: Die Geschichte von Big Data – Beginnend mit der Datenerfassung.“ Bevor der Wert von Daten ermittelt werden kann, müssen diese zunächst Prozesse wie das Sammeln, Speichern, Analysieren und Berechnen durchlaufen. Die Gewinnung umfassender und genauer Daten ist die Grundlage für das Data Value Mining. Vielleicht können die aktuellen Daten dem Unternehmen oder der Organisation keinen tatsächlichen Wert bringen, aber als weitsichtiger Entscheidungsträger sollten Sie sich darüber im Klaren sein, dass wichtige Daten so früh wie möglich gesammelt und gespeichert werden sollten. Diese Ausgabe von „Big Data Story“ beginnt mit den gängigsten Datenerfassungsmethoden – RSS und Suchmaschinen-Crawlern.

Die Veranstaltung war voller Sitzplätze

Zuallererst sagte Cui Kejun, General Manager der Bibliotheksabteilung von Beijing Wanfang Software Co., Ltd., teilte das Thema „RSS-Implementierung in großem Maßstab – Erste Anwendungen der Aggregation und des Herunterladens von Websites in der wissenschaftlichen Forschung“. Cui Kejun ist seit 12 Jahren in der Bibliotheks- und Informationsbranche tätig und verfügt über umfangreiche Erfahrung in der Datenerfassung. Er teilte hauptsächlich RSS, eine wichtige Methode zur Informationsaggregation, und deren Implementierungstechnologie.

RSS (Really Simple Syndication) ist eine Quellformatspezifikation, die zum Zusammenfassen von Websites verwendet wird, die häufig aktualisierte Daten veröffentlichen, wie z. B. Blogbeiträge, Nachrichten, Audio- oder Videoauszüge. RSS-Dateien enthalten Volltext oder Textauszüge sowie auszugsweise Daten und Autorisierungsmetadaten aus dem Netzwerk, bei dem der Benutzer abonniert ist.

Die Aggregation von Hunderten oder sogar Tausenden von RSS-Seeds, die eng mit einer bestimmten Branche verbunden sind, ermöglicht es Ihnen, die neuesten Entwicklungen in einer bestimmten Branche schnell und umfassend zu verstehen wird in der Lage sein, die Entwicklung eines bestimmten Themas in der Branche in allen Einzelheiten zu verstehen.

Cui Kejun, General Manager der Bibliotheksabteilung von Beijing Wanfang Software Co., Ltd.

Cui Kejun stellte die Rolle von RSS im Institut für vor Hochenergiephysik als Beispiel. Anwendungen in wissenschaftlichen Forschungsinstituten. Die Informationsüberwachung der Hochenergiephysik richtet sich an Partnerinstitutionen der Hochenergiephysik auf der ganzen Welt: Laboratorien, Industriegesellschaften, internationale Verbände, Regierungsbehörden, die in verschiedenen Ländern für die wissenschaftliche Forschung zuständig sind, wichtige umfassende wissenschaftliche Veröffentlichungen, experimentelle Projekte und experimentelle Einrichtungen der Hochenergiephysik . Die überwachten Arten von Informationen sind: Nachrichten, Aufsätze, Konferenzberichte, Analysen und Rezensionen, Vorabdrucke, Fallstudien, Multimedia, Bücher, Informationen zur Personalbeschaffung usw.

Die Literaturinformationen zur Hochenergiephysik nutzen das fortschrittlichste Open-Source-Content-Management-System Drupal, die Open-Source-Suchtechnologie Apache Solr sowie die von Google-Mitarbeitern entwickelte PubSubHubbub-Technologie zum Abonnieren von Nachrichten in Echtzeit und die von Amazon OpenSearch zur Einrichtung einer Reihe von Hochenergiephysik-Informationsüberwachungssystemen unterscheidet sich vom herkömmlichen RSS-Abonnement und -Push und ermöglicht die Informationserfassung nahezu in Echtzeit und den aktiven Push von Nachrichten mit beliebigen Schlüsselwörtern, Kategorien und zusammengesetzten Bedingungen.

Als nächstes teilte Cui Kejun seine Erfahrungen mit der Verwendung von Technologien wie Drupal, Apache Solr, PubSubHubbub und OpenSearch.

Als nächstes hielt Ye Shunping, der Architekt und Crawler-Teamleiter der Suchabteilung von Yisou Technology, einen Vortrag mit dem Titel „Web Search Crawler Timeliness System“, einschließlich der Hauptziele, der Architektur und verschiedener Untermodule von das Pünktlichkeitssystem.

Ye Shunping, Architekt und Leiter des Crawl-Teams der Suchabteilung von Yisou Technology

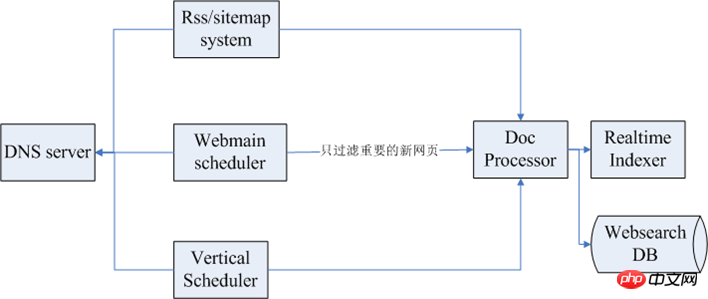

Die verschiedenen Ziele von Webcrawlern sind eine hohe Abdeckung und niedrige Dead-Link-Rate Wie bei guter Effektivität ist das Ziel des Crawler-Effektivitätssystems ähnlich, hauptsächlich die schnelle und umfassende Einbindung neuer Webseiten. Die folgende Abbildung zeigt die Gesamtarchitektur des Aktualitätssystems:

Darunter ist das erste oben das RSS/Sitemap-Subsystem und das nächste der Webmain-Planer. Das Planungssystem für das Crawlen von Webseiten und dann ein Vertikalplaner. Ganz links gibt es beim Crawlen normalerweise Dutzende oder sogar Hunderte von Crawling-Clustern relativ groß sein, daher gibt es in der Regel ein DNS-Dienstmodul zur Bereitstellung globaler Dienste. Nach der Datenerfassung erfolgt in der Regel eine anschließende Datenverarbeitung.

Zu den mit der Wirksamkeit verbundenen Modulen gehören die folgenden:

RSS/Sitemap-System: Der Prozess der Verwendung von RSS/Sitemap durch das Timeliness-System besteht darin, Seeds abzubauen, regelmäßig zu crawlen und die Link-Release-Zeit zu analysieren. Crawlen und indizieren Sie zuerst neuere Webseiten.

Pan-Crawling-System: Wenn das Pan-Crawling-System gut konzipiert ist, trägt es dazu bei, die hohe Abdeckung zeitkritischer Webseiten zu verbessern, aber Pan-Crawling muss den Planungszyklus so weit wie möglich verkürzen.

Seed-Planungssystem: Es handelt sich hauptsächlich um eine zeitkritische Seed-Bibliothek. Das Planungssystem scannt die Datenbank kontinuierlich und sendet sie dann an den Crawling-Cluster Links werden extrahiert und dann nach Kategorie gesendet, und jeder vertikale Kanal erhält zeitnahe Daten.

Seed-Mining: umfasst das Parsen von Seiten oder andere Mining-Methoden, die über Sitemaps und Navigationsleisten erstellt werden können und auf Seitenstrukturmerkmalen und Seitenänderungsregeln basieren.

Seed-Aktualisierungsmechanismus: Zeichnen Sie den Crawling-Verlauf jedes Seeds auf, folgen Sie den Linkinformationen, aktualisieren Sie regelmäßig die externen Linkeigenschaften des Seeds und berechnen Sie den Aktualisierungszyklus des Seeds neu.

Crawling-System und JavaScript-Analyse: Verwenden Sie den Browser zum Crawlen und Erstellen eines Crawling-Clusters basierend auf dem Browser-Crawling. Oder übernehmen Sie ein Open-Source-Projekt wie Qtwebkit.

Das obige ist der detaillierte Inhalt vonRSS und Crawler, ausführliche Erklärung zur Datenerfassung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

PHPs Fähigkeiten zur Verarbeitung von Big-Data-Strukturen

May 08, 2024 am 10:24 AM

PHPs Fähigkeiten zur Verarbeitung von Big-Data-Strukturen

May 08, 2024 am 10:24 AM

Fähigkeiten zur Verarbeitung von Big-Data-Strukturen: Chunking: Teilen Sie den Datensatz auf und verarbeiten Sie ihn in Blöcken, um den Speicherverbrauch zu reduzieren. Generator: Generieren Sie Datenelemente einzeln, ohne den gesamten Datensatz zu laden, geeignet für unbegrenzte Datensätze. Streaming: Lesen Sie Dateien oder fragen Sie Ergebnisse Zeile für Zeile ab, geeignet für große Dateien oder Remote-Daten. Externer Speicher: Speichern Sie die Daten bei sehr großen Datensätzen in einer Datenbank oder NoSQL.

Fünf große Entwicklungstrends in der AEC/O-Branche im Jahr 2024

Apr 19, 2024 pm 02:50 PM

Fünf große Entwicklungstrends in der AEC/O-Branche im Jahr 2024

Apr 19, 2024 pm 02:50 PM

AEC/O (Architecture, Engineering & Construction/Operation) bezieht sich auf die umfassenden Dienstleistungen, die Architekturdesign, Ingenieurdesign, Bau und Betrieb in der Bauindustrie anbieten. Im Jahr 2024 steht die AEC/O-Branche angesichts des technologischen Fortschritts vor sich ändernden Herausforderungen. In diesem Jahr wird voraussichtlich die Integration fortschrittlicher Technologien stattfinden, was einen Paradigmenwechsel in Design, Bau und Betrieb einläuten wird. Als Reaktion auf diese Veränderungen definieren Branchen Arbeitsprozesse neu, passen Prioritäten an und verbessern die Zusammenarbeit, um sich an die Bedürfnisse einer sich schnell verändernden Welt anzupassen. Die folgenden fünf großen Trends in der AEC/O-Branche werden im Jahr 2024 zu Schlüsselthemen und empfehlen den Weg in eine stärker integrierte, reaktionsfähigere und nachhaltigere Zukunft: integrierte Lieferkette, intelligente Fertigung

Anwendung von Algorithmen beim Aufbau einer 58-Porträt-Plattform

May 09, 2024 am 09:01 AM

Anwendung von Algorithmen beim Aufbau einer 58-Porträt-Plattform

May 09, 2024 am 09:01 AM

1. Hintergrund des Baus der 58-Portrait-Plattform Zunächst möchte ich Ihnen den Hintergrund des Baus der 58-Portrait-Plattform mitteilen. 1. Das traditionelle Denken der traditionellen Profiling-Plattform reicht nicht mehr aus. Der Aufbau einer Benutzer-Profiling-Plattform basiert auf Data-Warehouse-Modellierungsfunktionen, um Daten aus mehreren Geschäftsbereichen zu integrieren, um genaue Benutzerporträts zu erstellen Und schließlich muss es über Datenplattformfunktionen verfügen, um Benutzerprofildaten effizient zu speichern, abzufragen und zu teilen sowie Profildienste bereitzustellen. Der Hauptunterschied zwischen einer selbst erstellten Business-Profiling-Plattform und einer Middle-Office-Profiling-Plattform besteht darin, dass die selbst erstellte Profiling-Plattform einen einzelnen Geschäftsbereich bedient und bei Bedarf angepasst werden kann. Die Mid-Office-Plattform bedient mehrere Geschäftsbereiche und ist komplex Modellierung und bietet allgemeinere Funktionen. 2.58 Benutzerporträts vom Hintergrund der Porträtkonstruktion im Mittelbahnsteig 58

Diskussion über die Gründe und Lösungen für das Fehlen eines Big-Data-Frameworks in der Go-Sprache

Mar 29, 2024 pm 12:24 PM

Diskussion über die Gründe und Lösungen für das Fehlen eines Big-Data-Frameworks in der Go-Sprache

Mar 29, 2024 pm 12:24 PM

Im heutigen Big-Data-Zeitalter sind Datenverarbeitung und -analyse zu einer wichtigen Unterstützung für die Entwicklung verschiedener Branchen geworden. Als Programmiersprache mit hoher Entwicklungseffizienz und überlegener Leistung hat die Go-Sprache im Bereich Big Data nach und nach Aufmerksamkeit erregt. Im Vergleich zu anderen Sprachen wie Java, Python usw. verfügt die Go-Sprache jedoch über eine relativ unzureichende Unterstützung für Big-Data-Frameworks, was einigen Entwicklern Probleme bereitet hat. In diesem Artikel werden die Hauptgründe für das Fehlen eines Big-Data-Frameworks in der Go-Sprache untersucht, entsprechende Lösungen vorgeschlagen und anhand spezifischer Codebeispiele veranschaulicht. 1. Gehen Sie zur Sprache

Erste Schritte: Verwendung der Go-Sprache zur Verarbeitung großer Datenmengen

Feb 25, 2024 pm 09:51 PM

Erste Schritte: Verwendung der Go-Sprache zur Verarbeitung großer Datenmengen

Feb 25, 2024 pm 09:51 PM

Als Open-Source-Programmiersprache hat die Go-Sprache in den letzten Jahren nach und nach große Aufmerksamkeit und Verwendung gefunden. Es wird von Programmierern wegen seiner Einfachheit, Effizienz und leistungsstarken Funktionen zur gleichzeitigen Verarbeitung bevorzugt. Auch im Bereich der Big-Data-Verarbeitung verfügt die Go-Sprache über großes Potenzial. Sie kann zur Verarbeitung großer Datenmengen, zur Leistungsoptimierung und zur guten Integration in verschiedene Big-Data-Verarbeitungstools und Frameworks eingesetzt werden. In diesem Artikel stellen wir einige grundlegende Konzepte und Techniken der Big-Data-Verarbeitung in der Go-Sprache vor und zeigen anhand spezifischer Codebeispiele, wie die Go-Sprache verwendet wird.

Big-Data-Verarbeitung in C++-Technologie: Wie nutzt man In-Memory-Datenbanken, um die Big-Data-Leistung zu optimieren?

May 31, 2024 pm 07:34 PM

Big-Data-Verarbeitung in C++-Technologie: Wie nutzt man In-Memory-Datenbanken, um die Big-Data-Leistung zu optimieren?

May 31, 2024 pm 07:34 PM

Bei der Verarbeitung großer Datenmengen kann die Verwendung einer In-Memory-Datenbank (z. B. Aerospike) die Leistung von C++-Anwendungen verbessern, da sie Daten im Computerspeicher speichert, wodurch Festplatten-E/A-Engpässe vermieden und die Datenzugriffsgeschwindigkeiten erheblich erhöht werden. Praxisbeispiele zeigen, dass die Abfragegeschwindigkeit bei Verwendung einer In-Memory-Datenbank um mehrere Größenordnungen schneller ist als bei Verwendung einer Festplattendatenbank.

Golang und Big Data: eine perfekte Übereinstimmung oder ein Widerspruch?

Mar 05, 2024 pm 01:57 PM

Golang und Big Data: eine perfekte Übereinstimmung oder ein Widerspruch?

Mar 05, 2024 pm 01:57 PM

Golang und Big Data: eine perfekte Übereinstimmung oder ein Widerspruch? Mit der rasanten Entwicklung der Big-Data-Technologie beginnen immer mehr Unternehmen, Geschäfte und Entscheidungen durch Datenanalyse zu optimieren. Für die Verarbeitung großer Datenmengen sind effiziente Programmiersprachen von entscheidender Bedeutung. Unter vielen Programmiersprachen ist Golang (Go-Sprache) aufgrund seiner Parallelität, Effizienz, Einfachheit und anderer Eigenschaften zu einer der beliebtesten Optionen für die Verarbeitung großer Datenmengen geworden. Passen Golang und Big Data also perfekt zusammen oder sind sie widersprüchlich? Dieser Artikel beginnt mit der Anwendung von Golang in der Big-Data-Verarbeitung.

Wie wird das EU-Datenrecht die Art und Weise verändern, wie Daten verwendet und weitergegeben werden?

Mar 28, 2024 pm 12:06 PM

Wie wird das EU-Datenrecht die Art und Weise verändern, wie Daten verwendet und weitergegeben werden?

Mar 28, 2024 pm 12:06 PM

Vor einiger Zeit haben wir über die offizielle Verabschiedung des EU-Datengesetzes gesprochen. Welche Auswirkungen wird es auf die Branche haben? , werfen wir heute weiterhin einen Blick darauf, wie das „Datengesetz“ der EU die Art und Weise verändern wird, wie Daten genutzt und weitergegeben werden? Einführung zum „Data Act“ Am 23. Februar 2022 hat die Europäische Kommission offiziell den „Draft Data Act“ (im Folgenden „Data Act“ genannt) veröffentlicht, der darauf abzielt, das wirtschaftliche und soziale Potenzial freizusetzen. Der Gesetzentwurf stellt neue Anforderungen in Bezug auf Datenaustausch, Zugang öffentlicher Stellen, internationale Datenübertragung, Cloud-Switching und Interoperabilität usw. vor und wird erhebliche potenzielle Auswirkungen auf die globale digitale Wirtschaft und Datenverwaltung haben. Am 9. November 2023 stimmte das Europäische Parlament für die Verabschiedung des „Datengesetzes“ und im Jahr 202