10 empfohlene Artikel zum Thema Python-Crawling

In diesem Artikel wird detailliert ein Beispiel für die Verwendung von Python vorgestellt, um beliebte Kommentare zu NetEase Cloud Music zu erhalten. Es hat einen sehr guten Referenzwert. Ich habe kürzlich Inhalte im Zusammenhang mit Text Mining studiert Für die Analyse müssen Sie zunächst den Text abrufen. Es gibt viele Möglichkeiten, Text zu erhalten, z. B. das Herunterladen vorgefertigter Textdokumente aus dem Internet oder das Abrufen von Daten über von Dritten bereitgestellte APIs. Aber manchmal können die gewünschten Daten nicht direkt abgerufen werden, weil es keinen direkten Download-Kanal oder keine API gibt, über die wir die Daten erhalten könnten. Was sollen wir also zu diesem Zeitpunkt tun? Eine bessere Möglichkeit ist die Verwendung eines Webcrawlers, der ein Computerprogramm schreibt, das sich als Benutzer ausgibt, um die gewünschten Daten zu erhalten. Durch die Leistungsfähigkeit von Computern können wir Daten einfach und schnell abrufen. Wie schreibt man also einen Crawler? Es gibt viele Sprachen, die zum Schreiben von Crawlern verwendet werden können, wie Java, PHP, Python usw. Ich persönlich bevorzuge die Verwendung von Python. Da Python nicht nur über leistungsstarke Netzwerkbibliotheken verfügt, sondern auch über viele hervorragende Bibliotheken von Drittanbietern, können wir es einfach verwenden. Dies bringt großen Komfort beim Schreiben von Crawlern. Keine Übertreibung

1. Teilen Sie eine Python-Methode zum Crawlen beliebter Kommentare zu NetEase Cloud Music

Einführung: In diesem Artikel wird ein Beispiel für das Erhalten beliebter Kommentare zu NetEase Cloud Music mithilfe von Python ausführlich vorgestellt. Es hat einen sehr guten Referenzwert, schauen wir es uns mit dem Editor unten an

2 Lernen Sie, wie Sie den w3shcool-Kurs mit Python crawlen und speichern das lokale Codebeispiel

Einführung: In diesem Artikel wird hauptsächlich die Methodenanalyse des Python-Crawlings im JQuery-Prozess vorgestellt w3shcool und lokal speichern. Hat einen sehr guten Referenzwert. Werfen wir einen Blick mit dem Editor unten

3 Beispiel für einen automatischen IP-Proxy in der Python-Crawling-Technologie

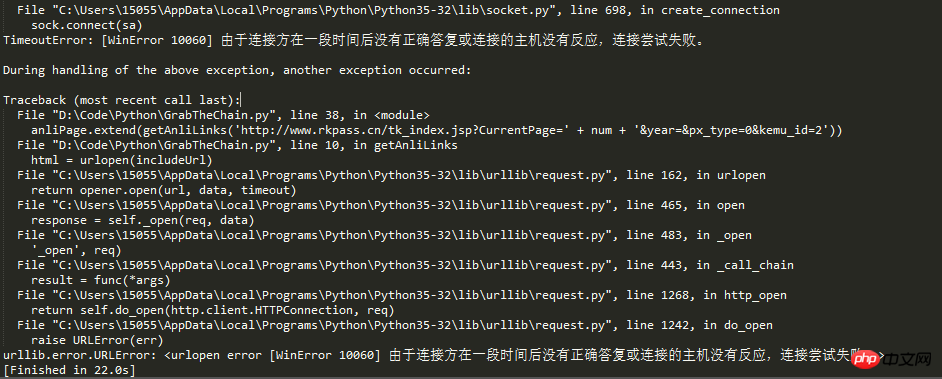

Einführung: Ich habe kürzlich geplant, Online-Soft-Prüfungsfragen für die Prüfung zu crawlen, und bin beim Crawlen auf einige Probleme gestoßen. Der folgende Artikel stellt hauptsächlich die Verwendung von Python-Crawling vor Der IP-Automatik-Proxy der Soft-Prüfungsfrage wird im Artikel ausführlich vorgestellt. Freunde, die ihn benötigen, können einen Blick darauf werfen.

4. Python crawlt Baidu-Schönheitsbilder

Einführung: Der Effekt des automatischen Herunterladens von Baidu-Schönheitsbildern über Python ist wie folgt: Mein Code fasst die Crawler-Idee zusammen, um mehrseitige Zugriffslinks zu erhalten> Bildlinks für jede Seite abrufen> Bild-Download; Format und mit offener Verwendung von AS-Syntax; Anpassung von Codierungsmethoden; Verwendung von Anfragen und RE-Modulen.

Einführung: Ich habe kürzlich geplant, weiche Prüfungsfragen für die Prüfung im Internet zu crawlen, und bin beim Crawlen auf einige Probleme gestoßen. Der folgende Artikel stellt hauptsächlich die Verwendung von Python zum Crawlen der IP vor Die relevanten Informationen werden im Artikel ausführlich vorgestellt.

6. Detaillierte Erklärung, wie Python Sogou-Bilder von Webseiten crawlt

Einführung: Ich hätte nicht erwartet, dass Python so leistungsstark und faszinierend ist. Früher habe ich Bilder einzeln kopiert und eingefügt, aber jetzt ist es besser, das Programm zu verwenden Speichern Sie die Bilder einzeln. Der folgende Artikel führt Sie hauptsächlich in die relevanten Informationen zur Verwendung von Python3.6 zum Crawlen von Bildern von Sogou-Bildwebseiten ein. Freunde in Not können darauf verweisen.

7. Wie man Musik-URLs in qq music mit Python crawlt und stapelweise herunterlädt

Einführung: Dieser Artikel führt Sie hauptsächlich in die Verwendung von Python zum Crawlen der Musik-URLs in qq-Musik ein und bietet eine detaillierte Einführung und einen Beispielcode. Als Referenzwert können Freunde in Not einen Blick unten werfen.

8. Python-Methode zum Crawlen von WeChat-Artikeln

Einführung: Dieser Artikel stellt Ihnen ein kleines Programm vor, das Python zum Crawlen von WeChat-Artikeln durch das Sogou-Portal verwendet. Es ist sehr einfach und praktisch. Freunde in Not können darauf verweisen

9. Python crawlt verfügbare Proxy-IPs

Einführung: Wir verwenden normalerweise Python-Crawler. Manchmal verwenden wir Es wird ein IP-Proxy verwendet. Es gibt viele kostenlose Proxy-IP-Websites im Internet, aber nicht alle IPs können verwendet werden. In diesem Artikel erfahren Sie daher, wie Sie verfügbare Proxy-IPs crawlen.

10. Python crawlt JD-Produktkategorien und Links

Einführung: In diesem Artikel wird hauptsächlich die Verwendung von Python zum Crawlen von JD.com-Produktkategorien und entsprechenden Verbindungen vorgestellt. Diese Funktion ist nicht sehr kompliziert und enthält keine versteckten Dinge. Es kann als Beispiel-Tutorial für Anfänger betrachtet werden.

[Verwandte Q&A-Empfehlungen]:

So crawlen Sie Webseitenverbindungen mit Ajax in Python

Python-Crawler – Python crawlt Douban-Filme, aber der Inhalt kann nicht gecrawlt werden

Python-Multithread crawlt Dateien, wie man ein Timeout einstellt und die Verbindung wiederherstellt.

Webcrawler – Python crawlt Online-Romane Chinesisch „verstümmelt“

Python-Crawler-Programm läuft „hängen“

Das obige ist der detaillierte Inhalt von10 empfohlene Artikel zum Thema Python-Crawling. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Wie löste ich das Problem der Berechtigungen beim Betrachten der Python -Version in Linux Terminal?

Apr 01, 2025 pm 05:09 PM

Wie löste ich das Problem der Berechtigungen beim Betrachten der Python -Version in Linux Terminal?

Apr 01, 2025 pm 05:09 PM

Lösung für Erlaubnisprobleme beim Betrachten der Python -Version in Linux Terminal Wenn Sie versuchen, die Python -Version in Linux Terminal anzuzeigen, geben Sie Python ein ...

Wie kann ich die gesamte Spalte eines Datenrahmens effizient in einen anderen Datenrahmen mit verschiedenen Strukturen in Python kopieren?

Apr 01, 2025 pm 11:15 PM

Wie kann ich die gesamte Spalte eines Datenrahmens effizient in einen anderen Datenrahmen mit verschiedenen Strukturen in Python kopieren?

Apr 01, 2025 pm 11:15 PM

Bei der Verwendung von Pythons Pandas -Bibliothek ist das Kopieren von ganzen Spalten zwischen zwei Datenrahmen mit unterschiedlichen Strukturen ein häufiges Problem. Angenommen, wir haben zwei Daten ...

Was sind einige beliebte Python -Bibliotheken und ihre Verwendung?

Mar 21, 2025 pm 06:46 PM

Was sind einige beliebte Python -Bibliotheken und ihre Verwendung?

Mar 21, 2025 pm 06:46 PM

In dem Artikel werden beliebte Python-Bibliotheken wie Numpy, Pandas, Matplotlib, Scikit-Learn, TensorFlow, Django, Flask und Anfragen erörtert, die ihre Verwendung in wissenschaftlichen Computing, Datenanalyse, Visualisierung, maschinellem Lernen, Webentwicklung und h beschreiben

Wie hört Uvicorn kontinuierlich auf HTTP -Anfragen ohne Serving_forver () an?

Apr 01, 2025 pm 10:51 PM

Wie hört Uvicorn kontinuierlich auf HTTP -Anfragen ohne Serving_forver () an?

Apr 01, 2025 pm 10:51 PM

Wie hört Uvicorn kontinuierlich auf HTTP -Anfragen an? Uvicorn ist ein leichter Webserver, der auf ASGI basiert. Eine seiner Kernfunktionen ist es, auf HTTP -Anfragen zu hören und weiterzumachen ...

Wie erstelle ich dynamisch ein Objekt über eine Zeichenfolge und rufe seine Methoden in Python auf?

Apr 01, 2025 pm 11:18 PM

Wie erstelle ich dynamisch ein Objekt über eine Zeichenfolge und rufe seine Methoden in Python auf?

Apr 01, 2025 pm 11:18 PM

Wie erstellt in Python ein Objekt dynamisch über eine Zeichenfolge und ruft seine Methoden auf? Dies ist eine häufige Programmieranforderung, insbesondere wenn sie konfiguriert oder ausgeführt werden muss ...

Wie behandle ich die mit Kommas getrennten Listen-Abfrageparameter in Fastapi?

Apr 02, 2025 am 06:51 AM

Wie behandle ich die mit Kommas getrennten Listen-Abfrageparameter in Fastapi?

Apr 02, 2025 am 06:51 AM

Fastapi ...

Was sind reguläre Ausdrücke?

Mar 20, 2025 pm 06:25 PM

Was sind reguläre Ausdrücke?

Mar 20, 2025 pm 06:25 PM

Regelmäßige Ausdrücke sind leistungsstarke Tools für Musteranpassung und Textmanipulation in der Programmierung, wodurch die Effizienz bei der Textverarbeitung in verschiedenen Anwendungen verbessert wird.

Wie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer-Anfänger-Programmierbasis in Projekt- und problemorientierten Methoden?

Apr 02, 2025 am 07:18 AM

Wie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer-Anfänger-Programmierbasis in Projekt- und problemorientierten Methoden?

Apr 02, 2025 am 07:18 AM

Wie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer -Anfänger für Programmierungen? Wenn Sie nur 10 Stunden Zeit haben, um Computer -Anfänger zu unterrichten, was Sie mit Programmierkenntnissen unterrichten möchten, was würden Sie dann beibringen ...