Empfohlene Ressourcen für Mahout-Video-Tutorials

Mahout bietet einige skalierbare Implementierungen klassischer Algorithmen im Bereich des maschinellen Lernens mit dem Ziel, Entwicklern dabei zu helfen, intelligente Anwendungen bequemer und schneller zu erstellen. Mahout enthält viele Implementierungen, einschließlich Clustering, Klassifizierung, Empfehlungsfilterung und häufiges Unterelement-Mining. Darüber hinaus kann Mahout mithilfe der Apache Hadoop-Bibliothek effizient in die Cloud skalieren.

Der Unterrichtsstil des Lehrers:

Die Vorträge des Lehrers sind einfach, klar, schichtweise analysiert, ineinandergreifend und Strenge Argumentation, hat eine strenge Struktur, nutzt die logische Kraft des Denkens, um die Aufmerksamkeit der Schüler zu erregen, und nutzt Vernunft, um den Unterrichtsprozess im Klassenzimmer zu steuern. Durch das Anhören der Vorlesungen des Lehrers lernen die Schüler nicht nur Wissen, sondern erhalten auch eine Denkschulung und werden auch von der strengen akademischen Haltung des Lehrers beeinflusst und beeinflusst

Der schwierigere Punkt in diesem Video ist die Logistik regression classifier_Bei Yessian Classifier_1:

1. Hintergrund

Lassen Sie uns zunächst einige Fragen stellen Fragen: Wenn Sie diese Fragen beantworten können, müssen Sie diesen Artikel nicht lesen, da Ihre Motivation zum Lesen lediglich darin besteht, Fehler in diesem Artikel zu finden. Bitte senden Sie eine E-Mail an „Naive Bayesian“. of Faults“ an 297314262 @qq.com, ich werde Ihren Brief sorgfältig lesen.

Übrigens, wenn Sie nach dem Lesen dieses Artikels die folgenden Fragen immer noch nicht beantworten können, benachrichtigen Sie mich bitte per E-Mail und ich werde mein Bestes tun, um Ihre Zweifel zu beantworten.

Das „naive“ im Naive-Bayes-Klassifikator bezieht sich speziell auf die Eigenschaften dieses Klassifikators

Naive-Bayes-Klassifikator und Maximum-Likelihood-Schätzung (MLE), Maximum-Posteriori-Wahrscheinlichkeitsbeziehung (MAP)

Naive Bayes-Klassifizierung, logistische Regressionsklassifizierung, generatives Modell und Entscheidungsmodell

Die Beziehung zwischen überwachtem Lernen und Bayes'scher Schätzung

2 Übereinstimmung

Das ist also so Artikel beginnt. Was die verschiedenen Ausdrucksformen betrifft, die in diesem Artikel vorkommen können, werden hier zunächst einige Konventionen getroffen.

Großbuchstaben wie X stellen Zufallsvariablen dar; wenn X eine mehrdimensionale Variable ist, dann der Index i stellt die i-te Dimensionsvariable dar. Das heißt, Xi

Kleinbuchstaben wie Xij repräsentieren einen Wert der Variablen (den j-ten Wert von Xi)

3 Überwachtes Lernen

Okay, also beantworten Sie zuerst die vierte Frage: Wie kann die Bayes'sche Schätzung verwendet werden, um Probleme beim überwachten Lernen zu lösen?

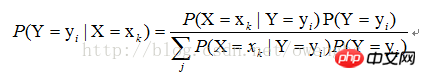

Für überwachtes Lernen besteht unser Ziel tatsächlich darin, eine Zielfunktion f zu schätzen: Die Variable Y ist das tatsächliche Klassifizierungsergebnis der Stichprobe. Angenommen, der Wert der Stichprobe |X=xk), finden Sie einfach alle Schätzungen von P(X=xk|Y=yi) und alle Schätzungen von P(Y=yi) basierend auf der Stichprobe. Der anschließende Klassifizierungsprozess besteht darin, das größte yi von P(Y=yi|X=xk) zu finden. Es ist ersichtlich, dass die Verwendung der Bayes'schen Schätzung das Problem des überwachten Lernens lösen kann.

4. „Naive“ Eigenschaften von Klassifikatoren

Wie oben erwähnt, kann die Lösung von P(X=xk|Y=yi) in die Lösung von P(X1=x1j1|Y=yi), P(X2=x2j2|Y=yi) umgewandelt werden. .. P (Xn=xnjn|Y=yi), wie verwendet man dann die Maximum-Likelihood-Schätzmethode, um diese Werte zu finden?

Zuerst müssen wir verstehen, was Maximum-Likelihood-Schätzung ist. Tatsächlich geht es in unseren Lehrbüchern zur Wahrscheinlichkeitstheorie ausschließlich um die Lösung unbeaufsichtigter Lernprobleme. Sie sollten verstehen, dass die Verwendung der Maximum-Likelihood-Schätzung zur Lösung überwachter Lernprobleme unter naiven Merkmalen tatsächlich die Verwendung der Maximum-Likelihood-Schätzung zur Lösung unbeaufsichtigter Lernprobleme unter verschiedenen Kategorien von Bedingungen bedeutet.

Das obige ist der detaillierte Inhalt vonEmpfohlene Ressourcen für Mahout-Video-Tutorials. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1392

1392

52

52

Empfohlene Treiberversion für die Grafikkarte der NVIDIA 40-Serie 2022

Jan 02, 2024 pm 06:43 PM

Empfohlene Treiberversion für die Grafikkarte der NVIDIA 40-Serie 2022

Jan 02, 2024 pm 06:43 PM

Empfohlene NVIDIA 4060-Grafikkartentreiberversion. Bei der Auswahl einer Grafikkartentreiberversion auf einem Laptop wird im Allgemeinen empfohlen, die von der offiziellen Website empfohlene Version oder die neueste Version zu wählen. Für die Intel HD Graphics 4060-Grafikkarte wird empfohlen, für die Aktualisierung und Installation den neuesten Treiber auszuwählen, der auf der offiziellen Website von Intel veröffentlicht wurde. Die einzelnen Schritte sind wie folgt: „Words Play Flowers“ ist ein beliebtes Worträtselspiel mit täglich neuen Levels. Eine der Ebenen heißt Nostalgische Reinigung. Wir müssen 12 Elemente im Bild finden, die nicht mit der Zeit übereinstimmen. Heute werde ich Ihnen eine Anleitung zum Bewältigen des nostalgischen Reinigungslevels von „Word Play Flowers“ bringen, um Spielern, die es nicht bestanden haben, zu helfen, das Level erfolgreich zu bestehen. Werfen wir einen Blick auf die konkreten Schritte! Besuchen Sie Intel

Die erste Wahl für CS-Spieler: empfohlene Computerkonfiguration

Jan 02, 2024 pm 04:26 PM

Die erste Wahl für CS-Spieler: empfohlene Computerkonfiguration

Jan 02, 2024 pm 04:26 PM

1. Prozessor Bei der Auswahl einer Computerkonfiguration ist der Prozessor eine der wichtigsten Komponenten. Bei Spielen wie CS wirkt sich die Leistung des Prozessors direkt auf die Laufruhe und Reaktionsgeschwindigkeit des Spiels aus. Es wird empfohlen, Prozessoren der Intel Core i5- oder i7-Serie zu wählen, da diese über leistungsstarke Multi-Core-Verarbeitungsfunktionen und hohe Frequenzen verfügen und den hohen Anforderungen von CS problemlos gerecht werden. 2. Grafikkarte Die Grafikkarte ist einer der wichtigen Faktoren für die Spieleleistung. Bei Schießspielen wie CS wirkt sich die Leistung der Grafikkarte direkt auf die Klarheit und Glätte des Spielbildschirms aus. Es wird empfohlen, Grafikkarten der NVIDIA GeForce GTX-Serie oder der AMD Radeon RX-Serie zu wählen. Sie verfügen über hervorragende Grafikverarbeitungsfunktionen und eine hohe Bildratenausgabe und können ein besseres Spielerlebnis bieten

Wie kann ich mir Freunde auf Taobao empfehlen?

Feb 29, 2024 pm 07:07 PM

Wie kann ich mir Freunde auf Taobao empfehlen?

Feb 29, 2024 pm 07:07 PM

Bei der Verwendung von Taobao werden wir oft von einigen Freunden empfohlen, die wir kennen. Hier finden Sie eine Einführung, wie Sie diese Funktion deaktivieren können. Nachdem Sie die „Taobao“-APP auf Ihrem Mobiltelefon geöffnet haben, klicken Sie unten rechts auf der Seite auf „Mein Taobao“, um die Seite des persönlichen Zentrums aufzurufen, und klicken Sie dann oben rechts auf die Funktion „Einstellungen“, um die Einstellungsseite aufzurufen . 2. Nachdem Sie zur Einstellungsseite gelangt sind, suchen Sie nach „Datenschutz“ und klicken Sie auf dieses Element, um es aufzurufen. 3. Auf der Datenschutzseite gibt es die Option „Freunde empfehlen“. Wenn angezeigt wird, dass der aktuelle Status „Ein“ ist, klicken Sie darauf, um die Seite zu schließen. 4. Schließlich befindet sich im Popup-Fenster hinter „Freunde weiterempfehlen“ eine Schaltfläche zum Umschalten. Klicken Sie darauf, um die Schaltfläche auf grau zu setzen.

Werden Sie ein C-Experte: Fünf unverzichtbare Compiler empfohlen

Feb 19, 2024 pm 01:03 PM

Werden Sie ein C-Experte: Fünf unverzichtbare Compiler empfohlen

Feb 19, 2024 pm 01:03 PM

Vom Anfänger zum Experten: Fünf wesentliche C-Compiler-Empfehlungen Mit der Entwicklung der Informatik interessieren sich immer mehr Menschen für Programmiersprachen. Als Hochsprache, die in der Programmierung auf Systemebene weit verbreitet ist, war die Sprache C schon immer bei Programmierern beliebt. Um effizienten und stabilen Code zu schreiben, ist es wichtig, einen C-Sprach-Compiler auszuwählen, der zu Ihnen passt. In diesem Artikel werden fünf wichtige C-Sprachcompiler vorgestellt, aus denen Anfänger und Experten wählen können. GCCGCC, die GNU-Compiler-Sammlung, ist einer der am häufigsten verwendeten C-Sprach-Compiler

Huangquan-Lichtkegel-Empfehlung

Mar 27, 2024 pm 05:31 PM

Huangquan-Lichtkegel-Empfehlung

Mar 27, 2024 pm 05:31 PM

Der Lichtkegel von Huang Quan kann den kritischen Trefferschaden und die Angriffskraft des Charakters im Kampf effektiv erhöhen. Die von Huang Quan empfohlenen Lichtkegel sind: Walking on the Passing Shore, Good Night und Sleeping Face, Rain Keeps Falling, Just Wait und Determination Like Beads von Shine, unten bringt Ihnen der Herausgeber Empfehlungen für den Underworld Light Cone der Collapsed Star Dome Railway. Huangquan-Lichtkegel-Empfehlung 1. Gehen auf der Passing Bank 1. Huangquans Spezialwaffe kann den Explosionsschaden erhöhen. Ein Angriff auf den Feind kann den Feind in einen Blasen-Negativzustand versetzen, was den verursachten Schaden zusätzlich erhöht Es gibt sowohl negative Zustände als auch den Schaden, man muss sagen, dass es sich um eine besondere Waffe handelt. 2. Der exklusive Lichtkegel ist unter vielen ätherischen Lichtkegeln sehr einzigartig. Er erhöht direkt den direkten Schaden, hat hohen Schaden und verbessert das Attribut für kritischen Schaden. 3. Darüber hinaus sorgt der Lichtkegel für einen negativen Statuseffekt, der dazu führen kann, dass Huangquan selbst reagiert.

Empfehlungen für Java-Emulator: Diese fünf sind einfach zu verwenden und praktisch!

Feb 22, 2024 pm 08:42 PM

Empfehlungen für Java-Emulator: Diese fünf sind einfach zu verwenden und praktisch!

Feb 22, 2024 pm 08:42 PM

Ein Java-Emulator ist eine Software, die Java-Anwendungen auf einem Computer oder Gerät ausführen kann. Es kann die virtuelle Java-Maschine simulieren und Java-Bytecode ausführen, sodass Benutzer Java-Programme auf verschiedenen Plattformen ausführen können. Java-Simulatoren werden häufig in der Softwareentwicklung, beim Lernen und Testen eingesetzt. In diesem Artikel werden fünf nützliche und praktische Java-Emulatoren vorgestellt, die den Anforderungen verschiedener Benutzer gerecht werden und Benutzern dabei helfen, Java-Programme effizienter zu entwickeln und auszuführen. Der erste Emulator war Eclipse. Ekl

Empfohlene Tastaturen zur Reduzierung von Schlaggeräuschen in Spielen

Jan 05, 2024 am 10:36 AM

Empfohlene Tastaturen zur Reduzierung von Schlaggeräuschen in Spielen

Jan 05, 2024 am 10:36 AM

Gehen Sie zu Silent Gaming Keyboard empfehlen Wenn Sie beim Gaming ein ruhiges Erlebnis genießen möchten, können Sie über den Kauf einer Silent Gaming Tastatur nachdenken. Zu den empfohlenen Produkten gehören CherryMXSilent, LogitechG915 und SteelSeriesApexPro. Diese Tastaturen sind geräuscharm, leicht und reaktionsschnell. Darüber hinaus wird empfohlen, eine Tastatur mit Funktionen wie einstellbarer Helligkeit der Hintergrundbeleuchtung, programmierbaren Funktionen und komfortabler Haptik zu wählen, um bessere Nutzungsanforderungen zu erfüllen. Die „Durga K320“ gilt als die leiseste Tastatur und ist ein beliebtes elektronisches Produkt. Es ist für seine hervorragende Leistung und Funktionen bekannt und daher für viele Menschen die ideale Wahl. Ob Gaming, Unterhaltung oder Büroarbeit, der Duga K320 bietet hervorragende Leistung. Es

So finden Sie Ressourcen auf einer 115-Netzwerkfestplatte

Feb 23, 2024 pm 05:10 PM

So finden Sie Ressourcen auf einer 115-Netzwerkfestplatte

Feb 23, 2024 pm 05:10 PM

Auf der 115-Netzwerkfestplatte befinden sich viele Ressourcen. Wie findet man also Ressourcen? Benutzer können in der Software nach den benötigten Ressourcen suchen, dann die Download-Schnittstelle aufrufen und dann das Speichern auf der Netzwerkfestplatte auswählen. Diese Einführung in die Methode zum Auffinden von Ressourcen auf 115 Netzwerkfestplatten kann Ihnen den spezifischen Inhalt erklären. Im Folgenden finden Sie eine detaillierte Einführung. Schauen Sie sich um. Wie finde ich Ressourcen auf 115 Netzwerkfestplatten? Antwort: Suchen Sie den Inhalt in der Software und klicken Sie dann, um ihn auf der Netzwerkfestplatte zu speichern. Ausführliche Einführung: 1. Geben Sie zunächst die gewünschten Ressourcen in der App ein. 2. Klicken Sie dann auf den angezeigten Schlüsselwort-Link. 3. Rufen Sie dann die Download-Oberfläche auf. 4. Klicken Sie im Inneren auf „Auf Netzwerkfestplatte speichern“.