Backend-Entwicklung

Backend-Entwicklung

Python-Tutorial

Python-Tutorial

Detailliertes Beispiel dafür, wie Python Parallelitätsprobleme durch Futures behandelt

Detailliertes Beispiel dafür, wie Python Parallelitätsprobleme durch Futures behandelt

Detailliertes Beispiel dafür, wie Python Parallelitätsprobleme durch Futures behandelt

Dieser Artikel stellt Python hauptsächlich zur Bewältigung von Parallelitätsproblemen in der Zukunft vor. Er ist sehr gut und hat Referenzwert.

Erste Einführung in die Zukunft

Verwenden Sie das folgende Skript, um ein vorläufiges Verständnis der Zukunft zu erhalten:

Beispiel 1: Gewöhnliche Schleifenmethode

import os

import time

import sys

import requests

POP20_CC = (

"CN IN US ID BR PK NG BD RU JP MX PH VN ET EG DE IR TR CD FR"

).split()

BASE_URL = 'http://flupy.org/data/flags'

DEST_DIR = 'downloads/'

def save_flag(img,filename):

path = os.path.join(DEST_DIR,filename)

with open(path,'wb') as fp:

fp.write(img)

def get_flag(cc):

url = "{}/{cc}/{cc}.gif".format(BASE_URL,cc=cc.lower())

resp = requests.get(url)

return resp.content

def show(text):

print(text,end=" ")

sys.stdout.flush()

def download_many(cc_list):

for cc in sorted(cc_list):

image = get_flag(cc)

show(cc)

save_flag(image,cc.lower()+".gif")

return len(cc_list)

def main(download_many):

t0 = time.time()

count = download_many(POP20_CC)

elapsed = time.time()-t0

msg = "\n{} flags downloaded in {:.2f}s"

print(msg.format(count,elapsed))

if __name__ == '__main__':

main(download_many)Beispiel 2: Durch die zukünftige Methode implementiert, hier verwenden wir einen Teil des obigen Codes wieder

from concurrent import futures from flags import save_flag, get_flag, show, main MAX_WORKERS = 20 def download_one(cc): image = get_flag(cc) show(cc) save_flag(image, cc.lower()+".gif") return cc def download_many(cc_list): workers = min(MAX_WORKERS,len(cc_list)) with futures.ThreadPoolExecutor(workers) as executor: res = executor.map(download_one, sorted(cc_list)) return len(list(res)) if __name__ == '__main__': main(download_many)

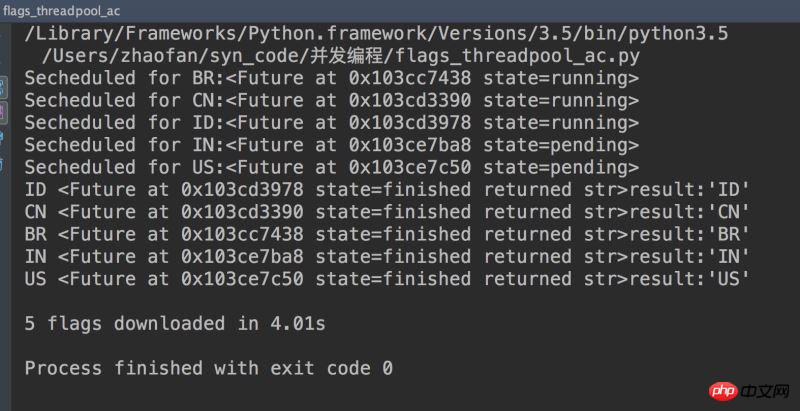

Führen Sie jeweils drei Mal aus, die Durchschnittsgeschwindigkeit der beiden beträgt: 13,67 und 1,59 Sekunden, man sieht, dass der Unterschied immer noch sehr groß ist.

future

future ist ein wichtiger Bestandteil des concurrent.futures-Moduls und des Asyncio-Moduls

Ab Python 3.4 gibt es in der Standardbibliothek zwei Klassen mit dem Namen Future: concurrent.futures.Future und asyncio.Future

Diese beiden Klassen haben die gleiche Funktion: Instanzen beider Future-Klassen repräsentieren Dinge, die abgeschlossen werden können oder noch nicht abgeschlossen. Ähnliche Funktionen wie die Deferred-Klasse in Twisted und die Future-Klasse im Tornado-Framework

Hinweis: Normalerweise sollten Sie einen Future nicht selbst erstellen, sondern ihn durch das Parallelitätsframework (concurrent.futures oder asyncio) instanziieren

Grund: Zukunft stellt etwas dar, das irgendwann passieren wird, und die einzige Möglichkeit, festzustellen, dass etwas passieren wird, besteht darin, die Ausführungszeit zu planen, also nur, wenn etwas zur Verarbeitung an die Unterklasse concurrent.futures.Executor übergeben wird. Es wird eine concurrent.futures.Future-Instanz erstellt.

Zum Beispiel: Der Parameter der Methode Executor.submit() ist ein aufrufbares Objekt. Nach dem Aufruf dieser Methode wird die Zeit für das eingehende aufrufbare Objekt und eine

Zukunft

< geplant zurückgegeben werden. 🎜>Der Client-Code kann den Status der Zukunft nicht ändern, nachdem die durch die Zukunft dargestellte verzögerte Berechnung endet. Beide Futures verfügen über eine .done()-Methode. Diese Methode blockiert nicht und der Rückgabewert ist ein boolescher Wert, der angibt, ob das mit der Zukunft verknüpfte aufrufbare Objekt ausgeführt wurde. Der Clientcode fragt normalerweise nicht, ob die Ausführung der Zukunft abgeschlossen ist, sondern wartet auf eine Benachrichtigung. Daher verfügen beide Future-Klassen über die Methode .add_done_callback(). Diese Methode hat nur einen Parameter und der Typ ist ein aufrufbares Objekt. Das angegebene aufrufbare Objekt wird nach der Ausführung der Zukunft aufgerufen. Die Methode .result() hat in den beiden Future-Klassen dieselbe Funktion: das Ergebnis des aufrufbaren Objekts zurückzugeben oder die beim Ausführen des aufrufbaren Objekts ausgelöste Ausnahme erneut auszulösen. Wenn die Zukunft jedoch nicht endet, ist das Verhalten der Ergebnismethode in den beiden Future-Klassen sehr unterschiedlich.from concurrent import futures

from flags import save_flag, get_flag, show, main

MAX_WORKERS = 20

def download_one(cc):

image = get_flag(cc)

show(cc)

save_flag(image, cc.lower()+".gif")

return cc

def download_many(cc_list):

cc_list = cc_list[:5]

with futures.ThreadPoolExecutor(max_workers=3) as executor:

to_do = []

for cc in sorted(cc_list):

future = executor.submit(download_one,cc)

to_do.append(future)

msg = "Secheduled for {}:{}"

print(msg.format(cc,future))

results = []

for future in futures.as_completed(to_do):

res = future.result()

msg = "{}result:{!r}"

print(msg.format(future,res))

results.append(res)

return len(results)

if __name__ == '__main__':

main(download_many)

concurrent.futures zu Starten Sie den Prozess

concurrent.futures Die ProcessPoolExecutor-Klasse verteilt die Arbeit auf mehrere Python-Prozesse. Wenn Sie also eine CPU-intensive Verarbeitung durchführen müssen, verwenden Sie dieses Modul, um die GIL zu umgehen und die gesamte CPU zu nutzen Kerne. Das Prinzip besteht darin, dass ein ProcessPoolExecutor N unabhängige Python-Interpreter erstellt, wobei N die Anzahl der auf dem System verfügbaren CPU-Kerne ist. Die Verwendungsmethode ist dieselbe wie die ThreadPoolExecutor-MethodeDas obige ist der detaillierte Inhalt vonDetailliertes Beispiel dafür, wie Python Parallelitätsprobleme durch Futures behandelt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Der 2-stündige Python-Plan: ein realistischer Ansatz

Apr 11, 2025 am 12:04 AM

Der 2-stündige Python-Plan: ein realistischer Ansatz

Apr 11, 2025 am 12:04 AM

Sie können grundlegende Programmierkonzepte und Fähigkeiten von Python innerhalb von 2 Stunden lernen. 1. Lernen Sie Variablen und Datentypen, 2. Master Control Flow (bedingte Anweisungen und Schleifen), 3.. Verstehen Sie die Definition und Verwendung von Funktionen, 4. Beginnen Sie schnell mit der Python -Programmierung durch einfache Beispiele und Code -Snippets.

Python: Erforschen der primären Anwendungen

Apr 10, 2025 am 09:41 AM

Python: Erforschen der primären Anwendungen

Apr 10, 2025 am 09:41 AM

Python wird in den Bereichen Webentwicklung, Datenwissenschaft, maschinelles Lernen, Automatisierung und Skripten häufig verwendet. 1) In der Webentwicklung vereinfachen Django und Flask Frameworks den Entwicklungsprozess. 2) In den Bereichen Datenwissenschaft und maschinelles Lernen bieten Numpy-, Pandas-, Scikit-Learn- und TensorFlow-Bibliotheken eine starke Unterstützung. 3) In Bezug auf Automatisierung und Skript ist Python für Aufgaben wie automatisiertes Test und Systemmanagement geeignet.

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Es ist unmöglich, das MongoDB -Passwort direkt über Navicat anzuzeigen, da es als Hash -Werte gespeichert ist. So rufen Sie verlorene Passwörter ab: 1. Passwörter zurücksetzen; 2. Überprüfen Sie die Konfigurationsdateien (können Hash -Werte enthalten). 3. Überprüfen Sie Codes (May Hardcode -Passwörter).

Wie man AWS -Kleber mit Amazon Athena verwendet

Apr 09, 2025 pm 03:09 PM

Wie man AWS -Kleber mit Amazon Athena verwendet

Apr 09, 2025 pm 03:09 PM

Als Datenprofi müssen Sie große Datenmengen aus verschiedenen Quellen verarbeiten. Dies kann Herausforderungen für das Datenmanagement und die Analyse darstellen. Glücklicherweise können zwei AWS -Dienste helfen: AWS -Kleber und Amazon Athena.

So starten Sie den Server mit Redis

Apr 10, 2025 pm 08:12 PM

So starten Sie den Server mit Redis

Apr 10, 2025 pm 08:12 PM

Zu den Schritten zum Starten eines Redis -Servers gehören: Installieren von Redis gemäß dem Betriebssystem. Starten Sie den Redis-Dienst über Redis-Server (Linux/macOS) oder redis-server.exe (Windows). Verwenden Sie den Befehl redis-cli ping (linux/macOS) oder redis-cli.exe ping (Windows), um den Dienststatus zu überprüfen. Verwenden Sie einen Redis-Client wie Redis-Cli, Python oder Node.js, um auf den Server zuzugreifen.

So lesen Sie Redis -Warteschlange

Apr 10, 2025 pm 10:12 PM

So lesen Sie Redis -Warteschlange

Apr 10, 2025 pm 10:12 PM

Um eine Warteschlange aus Redis zu lesen, müssen Sie den Warteschlangenname erhalten, die Elemente mit dem Befehl LPOP lesen und die leere Warteschlange verarbeiten. Die spezifischen Schritte sind wie folgt: Holen Sie sich den Warteschlangenname: Nennen Sie ihn mit dem Präfix von "Warteschlange:" wie "Warteschlangen: My-Queue". Verwenden Sie den Befehl LPOP: Wischen Sie das Element aus dem Kopf der Warteschlange aus und geben Sie seinen Wert zurück, z. B. die LPOP-Warteschlange: my-queue. Verarbeitung leerer Warteschlangen: Wenn die Warteschlange leer ist, gibt LPOP NIL zurück, und Sie können überprüfen, ob die Warteschlange existiert, bevor Sie das Element lesen.

So sehen Sie die Serverversion von Redis

Apr 10, 2025 pm 01:27 PM

So sehen Sie die Serverversion von Redis

Apr 10, 2025 pm 01:27 PM

FRAGE: Wie kann man die Redis -Server -Version anzeigen? Verwenden Sie das Befehlszeilen-Tool-REDIS-CLI-Verssion, um die Version des angeschlossenen Servers anzuzeigen. Verwenden Sie den Befehl "Info Server", um die interne Version des Servers anzuzeigen, und muss Informationen analysieren und zurückgeben. Überprüfen Sie in einer Cluster -Umgebung die Versionskonsistenz jedes Knotens und können automatisch mit Skripten überprüft werden. Verwenden Sie Skripte, um die Anzeigeversionen zu automatisieren, z. B. eine Verbindung mit Python -Skripten und Druckversionsinformationen.

Wie sicher ist Navicats Passwort?

Apr 08, 2025 pm 09:24 PM

Wie sicher ist Navicats Passwort?

Apr 08, 2025 pm 09:24 PM

Die Kennwortsicherheit von Navicat beruht auf der Kombination aus symmetrischer Verschlüsselung, Kennwortstärke und Sicherheitsmaßnahmen. Zu den spezifischen Maßnahmen gehören: Verwenden von SSL -Verbindungen (vorausgesetzt, dass der Datenbankserver das Zertifikat unterstützt und korrekt konfiguriert), die Navicat regelmäßig Aktualisierung unter Verwendung von sichereren Methoden (z. B. SSH -Tunneln), die Einschränkung von Zugriffsrechten und vor allem niemals Kennwörter aufzeichnen.