Backend-Entwicklung

Backend-Entwicklung

PHP-Tutorial

PHP-Tutorial

Praktische Weitergabe der Verwendung von Swoole zum asynchronen Crawlen von Webseiten

Praktische Weitergabe der Verwendung von Swoole zum asynchronen Crawlen von Webseiten

Praktische Weitergabe der Verwendung von Swoole zum asynchronen Crawlen von Webseiten

PHP-Programmierer wissen alle, dass in PHP geschriebene Programme alle synchron sind. Wie schreibt man ein asynchrones Programm in PHP? Hier nehmen wir das Crawlen von Webinhalten als Beispiel, um zu zeigen, wie man Swoole zum Schreiben asynchroner Programme verwendet.

PHP-Synchronisationsprogramm

Bevor Sie ein asynchrones Programm schreiben, machen Sie sich keine Sorgen, verwenden Sie zuerst PHP, um das Synchronisationsprogramm zu implementieren.

<?php

/**

* Class Crawler

* Path: /Sync/Crawler.php

*/

class Crawler

{

private $url;

private $toVisit = [];

public function __construct($url)

{

$this->url = $url;

}

public function visitOneDegree()

{

$this->loadPageUrls();

$this->visitAll();

}

private function loadPageUrls()

{

$content = $this->visit($this->url);

$pattern = '#((http|ftp)://(\S*?\.\S*?))([\s)\[\]{},;"\':<]|\.\s|$)#i';

preg_match_all($pattern, $content, $matched);

foreach ($matched[0] as $url) {

if (in_array($url, $this->toVisit)) {

continue;

}

$this->toVisit[] = $url;

}

}

private function visitAll()

{

foreach ($this->toVisit as $url) {

$this->visit($url);

}

}

private function visit($url)

{

return @file_get_contents($url);

}

}<?php /** * crawler.php */ require_once 'Sync/Crawler.php'; $start = microtime(true); $url = 'http://www.swoole.com/'; $ins = new Crawler($url); $ins->visitOneDegree(); $timeUsed = microtime(true) - $start; echo "time used: " . $timeUsed; /* output: time used: 6.2610177993774 */

Eine vorläufige Studie zur Implementierung asynchroner Crawler durch Swoole

Beziehen Sie sich zunächst auf die offizielle Seite zum asynchronen Crawlen.

Anwendungsbeispiel

Swoole\Async::dnsLookup("www.baidu.com", function ($domainName, $ip) {

$cli = new swoole_http_client($ip, 80);

$cli->setHeaders([

'Host' => $domainName,

"User-Agent" => 'Chrome/49.0.2587.3',

'Accept' => 'text/html,application/xhtml+xml,application/xml',

'Accept-Encoding' => 'gzip',

]);

$cli->get('/index.html', function ($cli) {

echo "Length: " . strlen($cli->body) . "\n";

echo $cli->body;

});

});Es scheint, dass durch eine leichte Änderung des synchronen file_get_contents-Codes eine asynchrone Implementierung erreicht werden kann. Es scheint, dass der Erfolg einfach ist.

Also haben wir den folgenden Code erhalten:

<?php

/**

* Class Crawler

* Path: /Async/CrawlerV1.php

*/

class Crawler

{

private $url;

private $toVisit = [];

private $loaded = false;

public function __construct($url)

{

$this->url = $url;

}

public function visitOneDegree()

{

$this->visit($this->url, true);

$retryCount = 3;

do {

sleep(1);

$retryCount--;

} while ($retryCount > 0 && $this->loaded == false);

$this->visitAll();

}

private function loadPage($content)

{

$pattern = '#((http|ftp)://(\S*?\.\S*?))([\s)\[\]{},;"\':<]|\.\s|$)#i';

preg_match_all($pattern, $content, $matched);

foreach ($matched[0] as $url) {

if (in_array($url, $this->toVisit)) {

continue;

}

$this->toVisit[] = $url;

}

}

private function visitAll()

{

foreach ($this->toVisit as $url) {

$this->visit($url);

}

}

private function visit($url, $root = false)

{

$urlInfo = parse_url($url);

Swoole\Async::dnsLookup($urlInfo['host'], function ($domainName, $ip) use($urlInfo, $root) {

$cli = new swoole_http_client($ip, 80);

$cli->setHeaders([

'Host' => $domainName,

"User-Agent" => 'Chrome/49.0.2587.3',

'Accept' => 'text/html,application/xhtml+xml,application/xml',

'Accept-Encoding' => 'gzip',

]);

$cli->get($urlInfo['path'], function ($cli) use ($root) {

if ($root) {

$this->loadPage($cli->body);

$this->loaded = true;

}

});

});

}

}<?php /** * crawler.php */ require_once 'Async/CrawlerV1.php'; $start = microtime(true); $url = 'http://www.swoole.com/'; $ins = new Crawler($url); $ins->visitOneDegree(); $timeUsed = microtime(true) - $start; echo "time used: " . $timeUsed; /* output: time used: 3.011773109436 */

Das Ergebnis lief 3 Sekunden lang. Achten Sie auf meine Implementierung. Nachdem ich eine Anfrage zum Crawlen der Homepage initiiert habe, werde ich jede Sekunde die Ergebnisse abfragen, und diese wird nach dreimaliger Abfrage beendet. Die 3 Sekunden hier scheinen der Exit zu sein, der durch dreimaliges Abfragen ohne Ergebnis verursacht wurde.

Es scheint, dass ich zu ungeduldig war und ihnen nicht genügend Vorbereitungszeit gegeben habe. Okay, ändern wir die Anzahl der Umfragen auf 10 und sehen uns die Ergebnisse an.

time used: 10.034232854843

Du weißt, wie ich mich in dieser Zeit fühle.

Ist es ein Leistungsproblem bei Swoole? Warum gibt es nach 10 Sekunden kein Ergebnis? Liegt es daran, dass meine Haltung falsch ist? Der alte Mann Marx sagte: „Übung ist das einzige Kriterium, um die Wahrheit zu prüfen.“ Es scheint, dass wir es debuggen müssen, um den Grund herauszufinden.

Also habe ich Haltepunkte bei

$this->visitAll();

und

$this->loadPage($cli->body);

hinzugefügt. Schließlich habe ich festgestellt, dass visitAll() immer zuerst und dann loadPage() ausgeführt wird.

Nachdem ich eine Weile darüber nachgedacht habe, verstehe ich wahrscheinlich den Grund. Was ist der Grund?

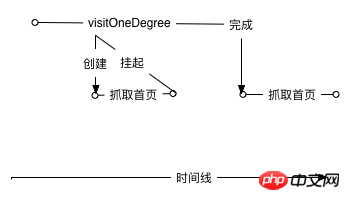

Das von mir erwartete asynchrone dynamische Modell sieht folgendermaßen aus:

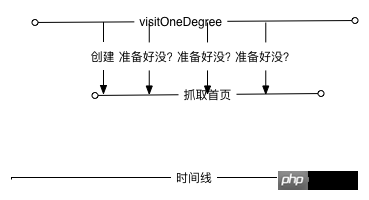

Das tatsächliche Szenario sieht jedoch nicht so aus. Durch das Debuggen habe ich ungefähr verstanden, dass das tatsächliche Modell so aussehen sollte:

Mit anderen Worten, egal wie ich die Zahl erhöhe Bei vielen Wiederholungen werden die Daten erst dann ausgeführt, wenn die aktuelle Funktion bereit ist. Durch die Asynchronität wird nur die Zeit zum Vorbereiten der Verbindung verkürzt.

Dann stellt sich die Frage, wie ich das Programm dazu bringen kann, die Funktionen auszuführen, die ich nach der Aufbereitung der Daten erwarte.

Schauen wir uns zunächst an, wie Swooles offizieller Code zum Ausführen asynchroner Aufgaben geschrieben ist

$serv = new swoole_server("127.0.0.1", 9501);

//设置异步任务的工作进程数量

$serv->set(array('task_worker_num' => 4));

$serv->on('receive', function($serv, $fd, $from_id, $data) {

//投递异步任务

$task_id = $serv->task($data);

echo "Dispath AsyncTask: id=$task_id\n";

});

//处理异步任务

$serv->on('task', function ($serv, $task_id, $from_id, $data) {

echo "New AsyncTask[id=$task_id]".PHP_EOL;

//返回任务执行的结果

$serv->finish("$data -> OK");

});

//处理异步任务的结果

$serv->on('finish', function ($serv, $task_id, $data) {

echo "AsyncTask[$task_id] Finish: $data".PHP_EOL;

});

$serv->start();Sie können sehen, dass der Beamte die nachfolgende Ausführungslogik durch eine anonyme Funktion leitet. So gesehen wird es viel einfacher.

url = $url;

}

public function visitOneDegree()

{

$this->visit($this->url, function ($content) {

$this->loadPage($content);

$this->visitAll();

});

}

private function loadPage($content)

{

$pattern = '#((http|ftp)://(\S*?\.\S*?))([\s)\[\]{},;"\':<]|\.\s|$)#i';

preg_match_all($pattern, $content, $matched);

foreach ($matched[0] as $url) {

if (in_array($url, $this->toVisit)) {

continue;

}

$this->toVisit[] = $url;

}

}

private function visitAll()

{

foreach ($this->toVisit as $url) {

$this->visit($url);

}

}

private function visit($url, $callBack = null)

{

$urlInfo = parse_url($url);

Swoole\Async::dnsLookup($urlInfo['host'], function ($domainName, $ip) use($urlInfo, $callBack) {

if (!$ip) {

return;

}

$cli = new swoole_http_client($ip, 80);

$cli->setHeaders([

'Host' => $domainName,

"User-Agent" => 'Chrome/49.0.2587.3',

'Accept' => 'text/html,application/xhtml+xml,application/xml',

'Accept-Encoding' => 'gzip',

]);

$cli->get($urlInfo['path'], function ($cli) use ($callBack) {

if ($callBack) {

call_user_func($callBack, $cli->body);

}

$cli->close();

});

});

}

}Nachdem ich diesen Code gelesen habe, verspüre ich ein Déjà-vu-Gefühl. In der NodeJS-Entwicklung haben die allgegenwärtigen Rückrufe ihre eigenen Gründe. Jetzt verstehe ich plötzlich, dass es einen Rückruf gibt, um asynchrone Probleme zu lösen.

Ich habe das Programm ausgeführt, es dauerte nur 0,0007 Sekunden und es war vorbei, bevor es überhaupt gestartet war! Kann die asynchrone Effizienz wirklich so stark verbessert werden? Die Antwort lautet natürlich: Nein, mit unserem Code stimmt etwas nicht.

Aufgrund der Verwendung von Asynchronität wurde die Logik zur Berechnung der Endzeit ausgeführt, ohne auf den vollständigen Abschluss der Aufgabe zu warten. Es scheint, dass es an der Zeit ist, den Rückruf erneut zu verwenden.

/**

Async/Crawler.php

**/

public function visitOneDegree($callBack)

{

$this->visit($this->url, function ($content) use($callBack) {

$this->loadPage($content);

$this->visitAll();

call_user_func($callBack);

});

}<?php

/**

* crawler.php

*/

require_once 'Async/Crawler.php';

$start = microtime(true);

$url = 'http://www.swoole.com/';

$ins = new Crawler($url);

$ins->visitOneDegree(function () use($start) {

$timeUsed = microtime(true) - $start;

echo "time used: " . $timeUsed;

});

/*output:

time used: 0.068463802337646

*/Aus heutiger Sicht sind die Ergebnisse viel glaubwürdiger.

Vergleichen wir den Unterschied zwischen synchron und asynchron. Die Synchronisation dauert 6,26 Sekunden und die asynchrone dauert 0,068 Sekunden, was einem Unterschied von ganzen 6,192 Sekunden entspricht. Nein, um es genauer auszudrücken: Es müsste fast zehnmal schlimmer sein!

Natürlich ist asynchroner Code hinsichtlich der Effizienz viel höher als synchroner Code, aber logisch gesehen ist asynchrone Logik komplizierter als synchrone, und der Code bringt viele Rückrufe mit sich, was nicht leicht zu verstehen ist.

Swoole hat eine Beschreibung zur Auswahl von asynchron und synchron, die ich gerne mit Ihnen teilen möchte:

我们不赞成用异步回调的方式去做功能开发,传统的PHP同步方式实现功能和逻辑是最简单的,也是最佳的方案。像node.js这样到处callback,只是牺牲可维护性和开发效率。

Verwandte Lektüre:

So installieren Sie die Swoole-Erweiterung mit PHP7

Einführung in Swoole-Entwicklungspunkte

Beispiel zur asynchronen Verwendung von PHP mit mehreren Threads

Das Obige ist der gesamte Inhalt dieses Artikels. Wenn Schüler Fragen haben, können sie diese im diskutieren Kommentarbereich unten~

Das obige ist der detaillierte Inhalt vonPraktische Weitergabe der Verwendung von Swoole zum asynchronen Crawlen von Webseiten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

So verwenden Sie Swoole-Coroutine in Laravel

Apr 09, 2024 pm 06:48 PM

So verwenden Sie Swoole-Coroutine in Laravel

Apr 09, 2024 pm 06:48 PM

Die Verwendung von Swoole-Coroutinen in Laravel kann eine große Anzahl von Anfragen gleichzeitig verarbeiten. Zu den Vorteilen gehören: Gleichzeitige Verarbeitung: Ermöglicht die gleichzeitige Verarbeitung mehrerer Anfragen. Hohe Leistung: Basierend auf dem Linux-Epoll-Ereignismechanismus werden Anfragen effizient verarbeitet. Geringer Ressourcenverbrauch: Benötigt weniger Serverressourcen. Einfache Integration: Nahtlose Integration mit dem Laravel-Framework, einfach zu verwenden.

Was ist besser, Swoole oder Workerman?

Apr 09, 2024 pm 07:00 PM

Was ist besser, Swoole oder Workerman?

Apr 09, 2024 pm 07:00 PM

Swoole und Workerman sind beide leistungsstarke PHP-Server-Frameworks. Swoole ist für seine asynchrone Verarbeitung, hervorragende Leistung und Skalierbarkeit bekannt und eignet sich für Projekte, die eine große Anzahl gleichzeitiger Anfragen und einen hohen Durchsatz verarbeiten müssen. Workerman bietet die Flexibilität sowohl des asynchronen als auch des synchronen Modus mit einer intuitiven API, die sich besser für Benutzerfreundlichkeit und Projekte eignet, die ein geringeres Parallelitätsvolumen bewältigen.

Wie ermöglicht swoole_process Benutzern den Wechsel?

Apr 09, 2024 pm 06:21 PM

Wie ermöglicht swoole_process Benutzern den Wechsel?

Apr 09, 2024 pm 06:21 PM

Mit dem Swoole-Prozess können Benutzer wechseln. Die spezifischen Schritte sind: Erstellen eines Prozesses, Starten des Prozesses.

So starten Sie den Dienst im Swoole-Framework neu

Apr 09, 2024 pm 06:15 PM

So starten Sie den Dienst im Swoole-Framework neu

Apr 09, 2024 pm 06:15 PM

Um den Swoole-Dienst neu zu starten, führen Sie die folgenden Schritte aus: Überprüfen Sie den Dienststatus und rufen Sie die PID ab. Verwenden Sie „kill -15 PID“, um den Dienst zu stoppen. Starten Sie den Dienst mit demselben Befehl neu, der zum Starten des Dienstes verwendet wurde.

Welches hat die bessere Leistung, Swoole oder Java?

Apr 09, 2024 pm 07:03 PM

Welches hat die bessere Leistung, Swoole oder Java?

Apr 09, 2024 pm 07:03 PM

Leistungsvergleich: Durchsatz: Swoole hat dank seines Coroutine-Mechanismus einen höheren Durchsatz. Latenz: Swooles Coroutine-Kontextwechsel hat einen geringeren Overhead und eine geringere Latenz. Speicherverbrauch: Swooles Coroutinen belegen weniger Speicher. Benutzerfreundlichkeit: Swoole bietet eine benutzerfreundlichere API für die gleichzeitige Programmierung.

Swoole in Aktion: So verwenden Sie Coroutinen für die gleichzeitige Aufgabenverarbeitung

Nov 07, 2023 pm 02:55 PM

Swoole in Aktion: So verwenden Sie Coroutinen für die gleichzeitige Aufgabenverarbeitung

Nov 07, 2023 pm 02:55 PM

Swoole in Aktion: So verwenden Sie Coroutinen für die gleichzeitige Aufgabenverarbeitung. Einführung In der täglichen Entwicklung stoßen wir häufig auf Situationen, in denen wir mehrere Aufgaben gleichzeitig bearbeiten müssen. Die herkömmliche Verarbeitungsmethode besteht darin, Multithreads oder Multiprozesse zu verwenden, um eine gleichzeitige Verarbeitung zu erreichen. Diese Methode weist jedoch bestimmte Probleme hinsichtlich Leistung und Ressourcenverbrauch auf. Als Skriptsprache kann PHP in der Regel nicht direkt Multithreading- oder Multiprozess-Methoden zur Bearbeitung von Aufgaben nutzen. Mithilfe der Swoole-Coroutinen-Bibliothek können wir jedoch Coroutinen verwenden, um eine leistungsstarke gleichzeitige Aufgabenverarbeitung zu erreichen. In diesem Artikel wird vorgestellt

Swoole Advanced: So optimieren Sie die Server-CPU-Auslastung

Nov 07, 2023 pm 12:27 PM

Swoole Advanced: So optimieren Sie die Server-CPU-Auslastung

Nov 07, 2023 pm 12:27 PM

Swoole ist ein leistungsstarkes PHP-Netzwerkentwicklungsframework mit seinem leistungsstarken asynchronen Mechanismus und ereignisgesteuerten Funktionen, mit dem es schnell Serveranwendungen mit hoher Parallelität und hohem Durchsatz erstellen kann. Wenn das Unternehmen jedoch weiter wächst und die Parallelität zunimmt, kann die CPU-Auslastung des Servers zu einem Engpass werden, der die Leistung und Stabilität des Servers beeinträchtigt. Daher stellen wir in diesem Artikel vor, wie Sie die CPU-Auslastung des Servers optimieren und gleichzeitig die Leistung und Stabilität des Swoole-Servers verbessern können, und stellen spezifische Optimierungscodebeispiele bereit. eins,

Wie ist die Swoole-Coroutine geplant?

Apr 09, 2024 pm 07:06 PM

Wie ist die Swoole-Coroutine geplant?

Apr 09, 2024 pm 07:06 PM

Swoole Coroutine ist eine leichte Parallelitätsbibliothek, die es Entwicklern ermöglicht, gleichzeitige Programme zu schreiben. Der Coroutine-Planungsmechanismus von Swoole basiert auf dem Coroutine-Muster und der Ereignisschleife, wobei der Coroutine-Stack zur Verwaltung der Coroutine-Ausführung verwendet und die Coroutinen angehalten werden, nachdem sie die Kontrolle aufgegeben haben. Die Ereignisschleife verarbeitet E/A- und Timer-Ereignisse. Wenn die Coroutine die Kontrolle aufgibt, wird sie angehalten und kehrt zur Ereignisschleife zurück. Wenn ein Ereignis auftritt, wechselt Swoole von der Ereignisschleife zur ausstehenden Coroutine und schließt den Wechsel durch Speichern und Laden des Coroutine-Status ab. Die Coroutine-Planung nutzt einen Prioritätsmechanismus und unterstützt Suspend-, Sleep- und Resume-Vorgänge, um die Coroutine-Ausführung flexibel zu steuern.