Backend-Entwicklung

Backend-Entwicklung

Python-Tutorial

Python-Tutorial

Python-Crawler zum Erstellen eines Scrapy-Crawler-Frameworks in der Anaconda-Umgebung

Python-Crawler zum Erstellen eines Scrapy-Crawler-Frameworks in der Anaconda-Umgebung

Python-Crawler zum Erstellen eines Scrapy-Crawler-Frameworks in der Anaconda-Umgebung

Wie erstelle ich ein Scrapy-Crawler-Framework in einer Anaconda-Umgebung? Dieser Artikel führt Sie in die Schritte zum Erstellen eines Scrapy-Crawler-Framework-Projekts in der Anaconda-Umgebung ein. Es lohnt sich, ihn zu lesen.

Python-Crawler-Tutorial-31 – Scrapy-Crawler-Framework-Projekt erstellen

Zuallererst befindet sich dieser Artikel in der Anaconda-Umgebung. Wenn Anaconda also nicht installiert ist, gehen Sie bitte zum Herunterladen auf die offizielle Website und installieren Sie es zuerst

Anaconda-Download-Adresse: https://www.anaconda.com/download/

Erstellung des Scrapy-Crawler-Framework-Projekts

0.

1. Geben Sie die Anaconda-Umgebung ein, die Sie verwenden möchten

Hier haben wir das Projekt erstellt und analysieren die Rolle der automatisch generierten Dateien

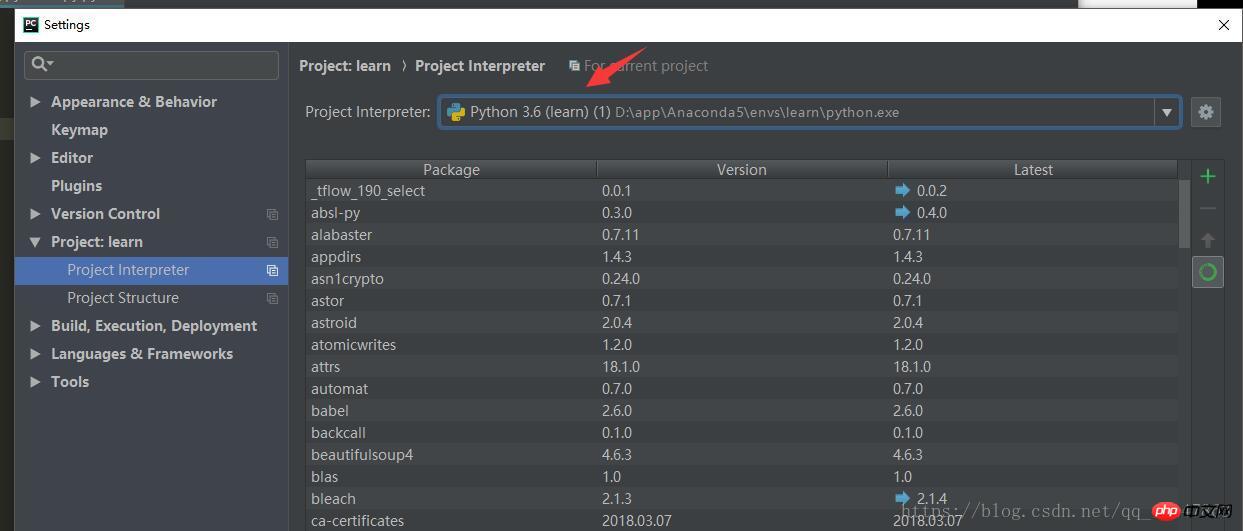

1. Der Umgebungsname kann sein gefunden unter [Einstellungen] in [Pycharm] Suchen Sie

unter [Projekt:] 2. Verwenden Sie den Befehl: Umgebungsnamen aktivieren, zum Beispiel:

aktivieren learn

3. Geben Sie das gewünschte Verzeichnis ein, in dem das Scrapy-Projekt gespeichert werden soll [Hinweis]

4. Neues Projekt: scrapy startproject xxx Projektname, zum Beispiel:

scrapy startproject new_project

5. Vorgangs-Screenshot:

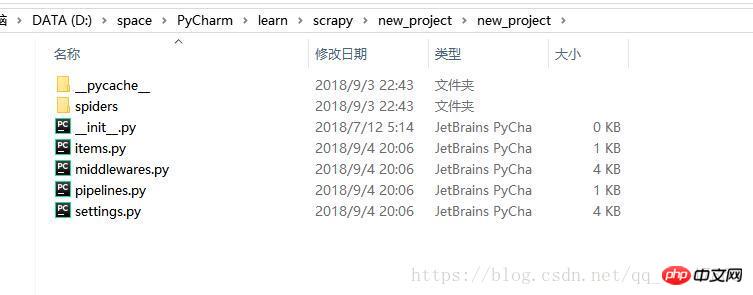

6. Öffnen Sie das Verzeichnis im Datei-Explorer und Sie werden feststellen, dass mehrere Dateien generiert wurden

7. Öffnen Sie einfach das Verzeichnis, in dem sich das Projekt befindet

Entwicklung des Scrapy-Crawler-Framework-Projekts

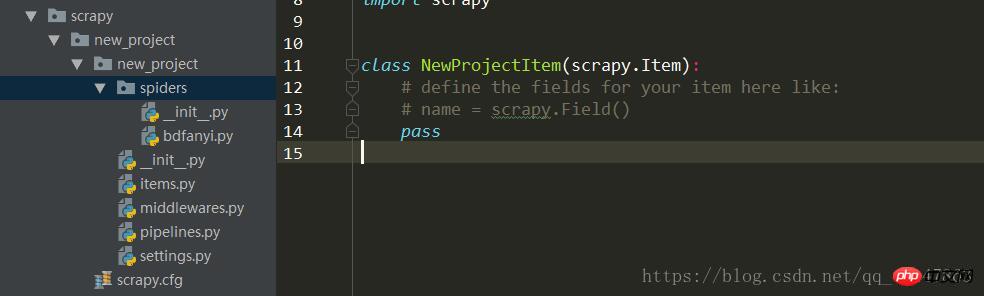

0 um das Projekt zu öffnen, Screenshot:

Der allgemeine Prozess der Projektentwicklung:

Die Adresse Spider/xxspider.py ist für die Zerlegung und verantwortlich Extrahieren der heruntergeladenen Daten

1. Klären Sie das Ziel/Produkt, das gecrawlt werden muss: Schreiben Sie item py

2. Laden Sie eine Python-Datei herunter und erstellen Sie sie im Spider-Verzeichnis:

3. Inhalt speichern: Pipelines.py

Pipeline.py-Datei

Wenn das Spider-Objekt geschlossen ist, wird das

Wenn das Spider-Objekt geöffnet wird, wird

aufgerufen, um einige notwendige Parameter zu initialisieren.

Die von der Spider extrahierten Elemente werden als Parameter übergeben

wird ebenfalls übergeben. Diese Methode muss

implementieren und ein Item-Objekt zurückgeben. Das verworfene Element entspricht nicht der nachfolgenden Pipeline

Pipeline-Datei

Nachdem der Crawler die Daten extrahiert und im Element gespeichert hat, müssen die im Element gespeicherten Daten weiter verarbeitet werden, z. B. Reinigung, Entwurmung, Speicherung usw.

Pipeline muss die Funktion „process_item“ verarbeiten

process_item

_ init _: Konstruktor

open_spider(spider):

close_spider(spider):

Spider-Verzeichnis

entspricht der Datei unter dem Ordner Spider

_ init _: Initialisieren Sie den Crawler-Namen, starten Sie die _urls-Liste

start_requests: generieren Anforderungen Objektschnittpunkt Laden Sie die Antwort herunter und geben Sie sie an Scrapy zurück

Analyse: Analysieren Sie das entsprechende Element gemäß der zurückgegebenen Antwort, und das Element gelangt automatisch in die Pipeline: Analysieren Sie bei Bedarf die URL, und die URL wird automatisch übergeben zum Anforderungsmodul, und der Zyklus geht weiter

start_requests: Diese Methode kann einmal aufgerufen werden, den Inhalt von start_urls lesen und den Schleifenprozess starten

Name: Legen Sie den Crawler-Namen fest

start_urls: Legen Sie die URL fest, um den ersten Crawling-Batch zu starten

allow_domains: Liste der Domänennamen, die Spider crawlen darf

start_request(self): wird nur einmal aufgerufen

Parse: Erkennungskodierung

Protokoll: Protokolldatensatz

Verwandte Empfehlungen:

Detaillierte Erläuterung von Scrapy-Beispielen des Python-Crawler-Frameworks

Einführungs-Tutorial zum Scrapy-Crawler 4 Spider (Crawler)

Ein einfaches Beispiel für das Schreiben eines Webcrawlers mit Pythons Scrapy-Framework

Das obige ist der detaillierte Inhalt vonPython-Crawler zum Erstellen eines Scrapy-Crawler-Frameworks in der Anaconda-Umgebung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1393

1393

52

52

1207

1207

24

24

Wie löste ich das Problem der Berechtigungen beim Betrachten der Python -Version in Linux Terminal?

Apr 01, 2025 pm 05:09 PM

Wie löste ich das Problem der Berechtigungen beim Betrachten der Python -Version in Linux Terminal?

Apr 01, 2025 pm 05:09 PM

Lösung für Erlaubnisprobleme beim Betrachten der Python -Version in Linux Terminal Wenn Sie versuchen, die Python -Version in Linux Terminal anzuzeigen, geben Sie Python ein ...

Wie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer-Anfänger-Programmierbasis in Projekt- und problemorientierten Methoden?

Apr 02, 2025 am 07:18 AM

Wie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer-Anfänger-Programmierbasis in Projekt- und problemorientierten Methoden?

Apr 02, 2025 am 07:18 AM

Wie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer -Anfänger für Programmierungen? Wenn Sie nur 10 Stunden Zeit haben, um Computer -Anfänger zu unterrichten, was Sie mit Programmierkenntnissen unterrichten möchten, was würden Sie dann beibringen ...

Wie kann man vom Browser vermeiden, wenn man überall Fiddler für das Lesen des Menschen in der Mitte verwendet?

Apr 02, 2025 am 07:15 AM

Wie kann man vom Browser vermeiden, wenn man überall Fiddler für das Lesen des Menschen in der Mitte verwendet?

Apr 02, 2025 am 07:15 AM

Wie kann man nicht erkannt werden, wenn Sie Fiddlereverywhere für Man-in-the-Middle-Lesungen verwenden, wenn Sie FiddLereverywhere verwenden ...

Wie kann ich die gesamte Spalte eines Datenrahmens effizient in einen anderen Datenrahmen mit verschiedenen Strukturen in Python kopieren?

Apr 01, 2025 pm 11:15 PM

Wie kann ich die gesamte Spalte eines Datenrahmens effizient in einen anderen Datenrahmen mit verschiedenen Strukturen in Python kopieren?

Apr 01, 2025 pm 11:15 PM

Bei der Verwendung von Pythons Pandas -Bibliothek ist das Kopieren von ganzen Spalten zwischen zwei Datenrahmen mit unterschiedlichen Strukturen ein häufiges Problem. Angenommen, wir haben zwei Daten ...

Wie hört Uvicorn kontinuierlich auf HTTP -Anfragen ohne Serving_forver () an?

Apr 01, 2025 pm 10:51 PM

Wie hört Uvicorn kontinuierlich auf HTTP -Anfragen ohne Serving_forver () an?

Apr 01, 2025 pm 10:51 PM

Wie hört Uvicorn kontinuierlich auf HTTP -Anfragen an? Uvicorn ist ein leichter Webserver, der auf ASGI basiert. Eine seiner Kernfunktionen ist es, auf HTTP -Anfragen zu hören und weiterzumachen ...

Wie löste ich Berechtigungsprobleme bei der Verwendung von Python -Verssionsbefehl im Linux Terminal?

Apr 02, 2025 am 06:36 AM

Wie löste ich Berechtigungsprobleme bei der Verwendung von Python -Verssionsbefehl im Linux Terminal?

Apr 02, 2025 am 06:36 AM

Verwenden Sie Python im Linux -Terminal ...

Wie erstelle ich dynamisch ein Objekt über eine Zeichenfolge und rufe seine Methoden in Python auf?

Apr 01, 2025 pm 11:18 PM

Wie erstelle ich dynamisch ein Objekt über eine Zeichenfolge und rufe seine Methoden in Python auf?

Apr 01, 2025 pm 11:18 PM

Wie erstellt in Python ein Objekt dynamisch über eine Zeichenfolge und ruft seine Methoden auf? Dies ist eine häufige Programmieranforderung, insbesondere wenn sie konfiguriert oder ausgeführt werden muss ...

Wie behandle ich die mit Kommas getrennten Listen-Abfrageparameter in Fastapi?

Apr 02, 2025 am 06:51 AM

Wie behandle ich die mit Kommas getrennten Listen-Abfrageparameter in Fastapi?

Apr 02, 2025 am 06:51 AM

Fastapi ...