Web-Frontend

Web-Frontend

js-Tutorial

js-Tutorial

Zusammenfassung des Prozesses zum Verbinden des Node-Frameworks mit ELK

Zusammenfassung des Prozesses zum Verbinden des Node-Frameworks mit ELK

Zusammenfassung des Prozesses zum Verbinden des Node-Frameworks mit ELK

Der Inhalt dieses Artikels ist eine Zusammenfassung des Prozesses der Verbindung des Node-Frameworks mit ELK. Ich hoffe, dass er für Freunde hilfreich ist.

Wir alle haben die Erfahrung, Protokolle auf Maschinen zu überprüfen. Wenn die Anzahl der Cluster zunimmt, stellt uns die Ineffizienz, die dieser primitive Vorgang mit sich bringt, nicht nur vor große Herausforderungen Gleichzeitig sind wir nicht in der Lage, eine effektive quantitative Diagnose verschiedener Indikatoren unseres Dienstleistungsrahmens durchzuführen, geschweige denn eine gezielte Optimierung und Verbesserung. Zu diesem Zeitpunkt ist es besonders wichtig, ein Echtzeit-Protokollüberwachungssystem mit Funktionen wie Informationssuche, Servicediagnose und Datenanalyse aufzubauen.

ELK (ELK Stack: ElasticSearch, LogStash, Kibana, Beats) ist eine ausgereifte Protokollierungslösung, die aufgrund ihrer Open Source und hohen Leistung in großen Unternehmen weit verbreitet ist. Wie verbindet sich das von unserem Unternehmen verwendete Service-Framework mit dem ELK-System?

Business-Hintergrund

Unser Business-Framework-Hintergrund:

Das Business-Framework ist WebServer basierend auf NodeJs

Der Dienst verwendet das Winston-Protokollmodul, um die Protokolle zu lokalisieren

Die vom Dienst generierten Protokolle werden auf den Festplatten der jeweiligen Maschinen gespeichert

Die Dienste werden in verschiedenen Regionen bereitgestellt. Mehrere Maschinen

Zugriffsschritte

Wir fassen das gesamte Framework zu ELK einfach in den folgenden Schritten zusammen:

Protokollstrukturdesign: Wandeln Sie herkömmliche Klartextprotokolle in strukturierte Objekte um und geben Sie sie als JSON aus.

-

Protokollsammlung: Protokolle an einigen Schlüsselknoten im Lebenszyklus der Framework-Anforderung ausgeben

Definition der ES-Indexvorlage: Erstellen einer Zuordnung von JSON zum tatsächlichen ES-Speicher

1. Protokollstrukturdesign

Traditionell , wir sind Bei der Protokollausgabe werden die Protokollebene (Ebene) und die Protokollinhaltszeichenfolge (Nachricht) direkt ausgegeben. Wir achten jedoch nicht nur darauf, wann und was passiert ist, sondern müssen möglicherweise auch darauf achten, wie oft ähnliche Protokolle aufgetreten sind, auf die Details und den Kontext der Protokolle sowie auf die zugehörigen Protokolle. Deshalb strukturieren wir unsere Protokolle nicht nur einfach in Objekte, sondern extrahieren auch die Schlüsselfelder der Protokolle.

1. Protokolle in Ereignisse abstrahieren

Wir abstrahieren das Auftreten jedes Protokolls als Ereignis. Das Ereignis enthält:

Ereignismetafeld

Ereignisauftrittszeit: Datum/Uhrzeit, Zeitstempel

Ereignisebene: Ebene, zum Beispiel: ERROR, INFO, WARNING, DEBUG

Ereignisname: Ereignis, Beispiel: Kundenanfrage

Relative Zeit, zu der das Ereignis auftritt (Einheit: Nanosekunde): reqLife, dieses Feld ist die Zeit (Intervall), zu der das Ereignis auftritt relativ zur Anfrage

Der Ort, an dem das Ereignis auftritt: Zeile, Code-Server, der Standort des Servers

Anfrage-Metafeld

Eindeutige ID der Anforderung: reqId, dieses Feld durchläuft die gesamte Anforderung. Alle Ereignisse, die auf dem Link auftreten

Benutzer-ID der Anforderung: reqUid, dieses Feld ist die Benutzer-ID, die den Zugriff des Benutzers oder den Anforderungslink verfolgen kann

Datenfeld

Verschiedene Arten von Ereignissen erfordern unterschiedliche Ausgabedetails. Wir fügen diese Details (Nicht-Meta-Felder) in d – Daten ein. Dies macht unsere Event-Struktur klarer und verhindert gleichzeitig, dass Datenfelder Metafelder verunreinigen.

z. B. ein Client-Init-Ereignis, dieses Ereignis wird jedes Mal gedruckt, wenn der Server eine Benutzeranfrage empfängt. Wir klassifizieren die IP-Adresse, die URL und andere Ereignisse des Benutzers eindeutig in Datenfelder und fügen sie in das d-Objekt ein

Geben Sie ein vollständiges Beispiel

{

"datetime":"2018-11-07 21:38:09.271",

"timestamp":1541597889271,

"level":"INFO",

"event":"client-init",

"reqId":"rJtT5we6Q",

"reqLife":5874,

"reqUid": "999793fc03eda86",

"d":{

"url":"/",

"ip":"9.9.9.9",

"httpVersion":"1.1",

"method":"GET",

"userAgent":"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_0) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.77 Safari/537.36",

"headers":"*"

},

"browser":"{"name":"Chrome","version":"70.0.3538.77","major":"70"}",

"engine":"{"version":"537.36","name":"WebKit"}",

"os":"{"name":"Mac OS","version":"10.14.0"}",

"content":"(Empty)",

"line":"middlewares/foo.js:14",

"server":"127.0.0.1"

}Einige Felder, wie zum Beispiel: Browser, Betriebssystem, Engine Warum möchten wir manchmal, dass das Protokoll in der äußeren Ebene so flach wie möglich ist (maximale Tiefe beträgt 2 ), um ES unnötigen Leistungsverlust durch die Indizierung zu vermeiden. In der tatsächlichen Ausgabe geben wir Werte mit einer Tiefe von mehr als 1 als Zeichenfolgen aus. Manchmal sind einige Objektfelder für uns von Belang, daher platzieren wir diese speziellen Felder in der äußeren Ebene, um sicherzustellen, dass die Ausgabetiefe nicht größer als 2 ist.

Im Allgemeinen müssen wir beim Ausdrucken des Protokolls nur auf 事件名称 und 数据字段 achten. Darüber hinaus können wir durch den Zugriff auf den Kontext in der Methode zum Drucken von Protokollen eine einheitliche Erfassung, Berechnung und Ausgabe durchführen.

2. Protokolltransformationsausgabe

Wir haben bereits erwähnt, wie ein Protokollereignis definiert wird. Wie können wir also ein Upgrade basierend auf der vorhandenen Protokolllösung durchführen und gleichzeitig mit der Protokollaufrufmethode des alten Codes kompatibel sein? .

Transformieren Sie das ProtokollausgabeformatWie bereits erwähnt, durchläuft Winston das Protokoll vor der Ausgabe durch unseren vordefinierten Formatierer, sodass wir zusätzlich zur Verarbeitung kompatibler Logik einige Gemeinsamkeiten angeben können Logik hier. Was den Anruf betrifft, konzentrieren wir uns nur auf das Feld selbst. Metafeldextraktion und -verarbeitung- Feldlängenkontrolle

- Kompatible Logikverarbeitung

- So extrahieren Sie Metafelder. Dazu gehört die Erstellung und Verwendung von Kontext. Hier finden Sie eine kurze Einführung in die Erstellung und Verwendung von Domänen.

Auf diese Weise können wir

// 改造前 logger.info('client-init => ' + JSON.stringfiy({ url, ip, browser, //... })); // 改造后 logger.info({ event: 'client-init', url, ip, browser, //... });Nach dem Login kopieren an alle Ereignisse in einer Anfrage ausgeben und so den Zweck der Korrelation von Ereignissen erreichen.

2. Protokollsammlung

Da wir nun wissen, wie ein Ereignis ausgegeben wird, sollten wir im nächsten Schritt zwei Fragen berücksichtigen: reqId

- Welche Details soll das Event ausgeben?

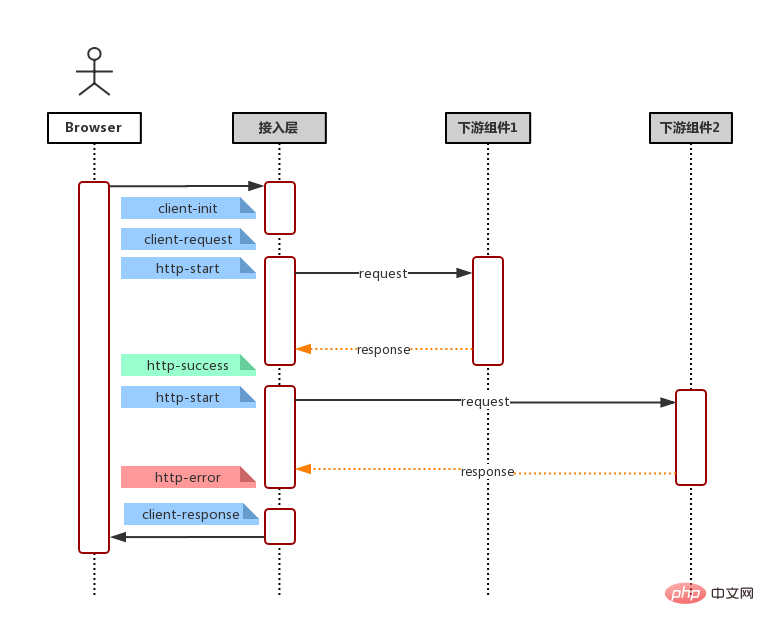

- Mit anderen Worten, um welche Knoten geht es im gesamten Anforderungslink? Wenn ein Problem auftritt, welche Knoteninformationen können verwendet werden, um das Problem schnell zu lokalisieren? Welche Knotendaten können wir außerdem für statistische Analysen verwenden? Kombiniert mit allgemeinen Anforderungslinks (Benutzeranforderung, Empfangsanforderung der Dienstseite, Dienstanforderung an nachgeschalteten Server/Datenbank (*mehrfach), Datenaggregationsrendering, Dienstantwort), wie im Flussdiagramm unten dargestellt

Dann können wir unser Ereignis wie folgt definieren:

Benutzeranforderung

client-init: Drucken Sie die vom Benutzer erhaltene Anforderung aus Frame (ungeparst), einschließlich: Anforderungsadresse, Anforderungsheader, HTTP-Version und -Methode, Benutzer-IP und Browser

Client-Anfrage: Wird gedruckt, wenn der Frame eine Anforderung empfängt (analysiert), einschließlich: Anforderungsadresse, Anforderungsheader , Cookie, Anfragetext

下游依赖

http-start: 打印于请求下游起始:请求地址,请求包体,模块别名(方便基于名字聚合而且域名)

http-success: 打印于请求返回 200:请求地址,请求包体,响应包体(code & msg & data),耗时

http-error: 打印于请求返回非 200,亦即连接服务器失败:请求地址,请求包体,响应包体(code & message & stack),耗时。

http-timeout: 打印于请求连接超时:请求地址,请求包体,响应包体(code & msg & stack),耗时。

字段这么多,该怎么选择? 一言以蔽之,事件输出的字段原则就是:输出你关注的,方便检索的,方便后期聚合的字段。一些建议

请求下游的请求体和返回体有固定格式, e.g. 输入:{ action: 'getUserInfo', payload: {} } 输出: { code: 0, msg: '', data: {}} 我们可以在事件输出 action,code 等,以便后期通过 action 检索某模块具体某个接口的各项指标和聚合。

一些原则

保证输出字段类型一致 由于所有事件都存储在同一个 ES 索引, 因此,相同字段不管是相同事件还是不同事件,都应该保持一致,例如:code不应该既是数字,又是字符串,这样可能会产生字段冲突,导致某些记录(document)无法被冲突字段检索到。

ES 存储类型为 keyword, 不应该超过 ES mapping 设定的 ignore_above 中指定的字节数(默认4096个字节)。否则同样可能会产生无法被检索的情况

三、ES 索引模版定义

这里引入 ES 的两个概念,映射(Mapping)与模版(Template)。

首先,ES 基本的存储类型大概枚举下,有以下几种

String: keyword & text

Numeric: long, integer, double

Date: date

Boolean: boolean

一般的,我们不需要显示指定每个事件字段的在ES对应的存储类型,ES 会自动根据字段第一次出现的document中的值来决定这个字段在这个索引中的存储类型。但有时候,我们需要显示指定某些字段的存储类型,这个时候我们需要定义这个索引的 Mapping, 来告诉 ES 这此字段如何存储以及如何索引。

e.g.

还记得事件元字段中有一个字段为 timestamp ?实际上,我们输出的时候,timestamp 的值是一个数字,它表示跟距离 1970/01/01 00:00:00 的毫秒数,而我们期望它在ES的存储类型为 date 类型方便后期的检索和可视化, 那么我们创建索引的时候,指定我们的Mapping。

PUT my_logs

{

"mappings": {

"_doc": {

"properties": {

"title": {

"type": "date",

"format": "epoch_millis"

},

}

}

}

}但一般的,我们可能会按日期自动生成我们的日志索引,假定我们的索引名称格式为 my_logs_yyyyMMdd (e.g. my_logs_20181030)。那么我们需要定义一个模板(Template),这个模板会在(匹配的)索引创建时自动应用预设好的 Mapping。

PUT _template/my_logs_template

{

"index_patterns": "my_logs*",

"mappings": {

"_doc": {

"properties": {

"title": {

"type": "date",

"format": "epoch_millis"

},

}

}

}

}小结

至此,日志改造及接入的准备工作都已经完成了,我们只须在机器上安装 FileBeat -- 一个轻量级的文件日志Agent, 它负责将日志文件中的日志传输到 ELK。接下来,我们便可使用 Kibana 快速的检索我们的日志。

Das obige ist der detaillierte Inhalt vonZusammenfassung des Prozesses zum Verbinden des Node-Frameworks mit ELK. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1359

1359

52

52

PHP und Vue: eine perfekte Kombination von Front-End-Entwicklungstools

Mar 16, 2024 pm 12:09 PM

PHP und Vue: eine perfekte Kombination von Front-End-Entwicklungstools

Mar 16, 2024 pm 12:09 PM

PHP und Vue: eine perfekte Kombination von Front-End-Entwicklungstools In der heutigen Zeit der rasanten Entwicklung des Internets ist die Front-End-Entwicklung immer wichtiger geworden. Da Benutzer immer höhere Anforderungen an das Erlebnis von Websites und Anwendungen stellen, müssen Frontend-Entwickler effizientere und flexiblere Tools verwenden, um reaktionsfähige und interaktive Schnittstellen zu erstellen. Als zwei wichtige Technologien im Bereich der Front-End-Entwicklung können PHP und Vue.js in Kombination als perfekte Waffe bezeichnet werden. In diesem Artikel geht es um die Kombination von PHP und Vue sowie um detaillierte Codebeispiele, die den Lesern helfen sollen, diese beiden besser zu verstehen und anzuwenden

Wie verwende ich die Go-Sprache für die Front-End-Entwicklung?

Jun 10, 2023 pm 05:00 PM

Wie verwende ich die Go-Sprache für die Front-End-Entwicklung?

Jun 10, 2023 pm 05:00 PM

Mit der Entwicklung der Internet-Technologie hat die Front-End-Entwicklung immer mehr an Bedeutung gewonnen. Insbesondere die Popularität mobiler Geräte erfordert eine Front-End-Entwicklungstechnologie, die effizient, stabil, sicher und einfach zu warten ist. Als sich schnell entwickelnde Programmiersprache wird die Go-Sprache von immer mehr Entwicklern verwendet. Ist es also möglich, die Go-Sprache für die Front-End-Entwicklung zu verwenden? Als Nächstes wird in diesem Artikel ausführlich erläutert, wie die Go-Sprache für die Front-End-Entwicklung verwendet wird. Werfen wir zunächst einen Blick darauf, warum die Go-Sprache für die Front-End-Entwicklung verwendet wird. Viele Leute denken, dass die Go-Sprache eine ist

Häufig gestellte Fragen von Front-End-Interviewern

Mar 19, 2024 pm 02:24 PM

Häufig gestellte Fragen von Front-End-Interviewern

Mar 19, 2024 pm 02:24 PM

In Front-End-Entwicklungsinterviews decken häufige Fragen ein breites Themenspektrum ab, darunter HTML/CSS-Grundlagen, JavaScript-Grundlagen, Frameworks und Bibliotheken, Projekterfahrung, Algorithmen und Datenstrukturen, Leistungsoptimierung, domänenübergreifende Anfragen, Front-End-Engineering, Designmuster sowie neue Technologien und Trends. Interviewerfragen sollen die technischen Fähigkeiten, die Projekterfahrung und das Verständnis des Kandidaten für Branchentrends beurteilen. Daher sollten Kandidaten in diesen Bereichen umfassend vorbereitet sein, um ihre Fähigkeiten und Fachkenntnisse unter Beweis zu stellen.

Ist Django Front-End oder Back-End? Hör zu!

Jan 19, 2024 am 08:37 AM

Ist Django Front-End oder Back-End? Hör zu!

Jan 19, 2024 am 08:37 AM

Django ist ein in Python geschriebenes Webanwendungs-Framework, das Wert auf schnelle Entwicklung und saubere Methoden legt. Obwohl Django ein Web-Framework ist, müssen Sie zur Beantwortung der Frage, ob Django ein Front-End oder ein Back-End ist, ein tiefes Verständnis der Konzepte von Front-End und Back-End haben. Das Front-End bezieht sich auf die Schnittstelle, mit der Benutzer direkt interagieren, und das Back-End bezieht sich auf serverseitige Programme. Sie interagieren mit Daten über das HTTP-Protokoll. Wenn das Front-End und das Back-End getrennt sind, können die Front-End- und Back-End-Programme unabhängig voneinander entwickelt werden, um Geschäftslogik bzw. interaktive Effekte sowie den Datenaustausch zu implementieren.

Kann Golang als Frontend verwendet werden?

Jun 06, 2023 am 09:19 AM

Kann Golang als Frontend verwendet werden?

Jun 06, 2023 am 09:19 AM

Golang kann als Front-End verwendet werden. Golang ist eine sehr vielseitige Programmiersprache, mit der verschiedene Arten von Anwendungen entwickelt werden können, einschließlich Front-End-Anwendungen Eine Reihe von Problemen, die durch Sprachen wie JavaScript verursacht werden. Zum Beispiel Probleme wie schlechte Typsicherheit, geringe Leistung und schwierig zu wartender Code.

Erfahrungsaustausch in der C#-Entwicklung: Fähigkeiten zur kollaborativen Front-End- und Back-End-Entwicklung

Nov 23, 2023 am 10:13 AM

Erfahrungsaustausch in der C#-Entwicklung: Fähigkeiten zur kollaborativen Front-End- und Back-End-Entwicklung

Nov 23, 2023 am 10:13 AM

Als C#-Entwickler umfasst unsere Entwicklungsarbeit in der Regel die Front-End- und Back-End-Entwicklung. Mit der Weiterentwicklung der Technologie und der zunehmenden Komplexität von Projekten wird die gemeinsame Entwicklung von Front-End und Back-End immer wichtiger und komplexer. In diesem Artikel werden einige kollaborative Front-End- und Back-End-Entwicklungstechniken vorgestellt, um C#-Entwicklern dabei zu helfen, die Entwicklungsarbeit effizienter abzuschließen. Nach der Festlegung der Schnittstellenspezifikationen ist die gemeinsame Entwicklung von Front-End und Backend untrennbar mit dem Zusammenspiel der API-Schnittstellen verbunden. Um den reibungslosen Ablauf der kollaborativen Front-End- und Back-End-Entwicklung sicherzustellen, ist es am wichtigsten, gute Schnittstellenspezifikationen zu definieren. Bei der Schnittstellenspezifikation handelt es sich um den Namen der Schnittstelle

Erkundung der Front-End-Technologie der Go-Sprache: eine neue Vision für die Front-End-Entwicklung

Mar 28, 2024 pm 01:06 PM

Erkundung der Front-End-Technologie der Go-Sprache: eine neue Vision für die Front-End-Entwicklung

Mar 28, 2024 pm 01:06 PM

Als schnelle und effiziente Programmiersprache erfreut sich Go im Bereich der Backend-Entwicklung großer Beliebtheit. Allerdings assoziieren nur wenige Menschen die Go-Sprache mit der Front-End-Entwicklung. Tatsächlich kann die Verwendung der Go-Sprache für die Front-End-Entwicklung nicht nur die Effizienz verbessern, sondern Entwicklern auch neue Horizonte eröffnen. In diesem Artikel wird die Möglichkeit der Verwendung der Go-Sprache für die Front-End-Entwicklung untersucht und spezifische Codebeispiele bereitgestellt, um den Lesern ein besseres Verständnis dieses Bereichs zu erleichtern. In der traditionellen Frontend-Entwicklung werden häufig JavaScript, HTML und CSS zum Erstellen von Benutzeroberflächen verwendet

So implementieren Sie Instant Messaging im Frontend

Oct 09, 2023 pm 02:47 PM

So implementieren Sie Instant Messaging im Frontend

Oct 09, 2023 pm 02:47 PM

Zu den Methoden zur Implementierung von Instant Messaging gehören WebSocket, Long Polling, vom Server gesendete Ereignisse, WebRTC usw. Detaillierte Einführung: 1. WebSocket, das eine dauerhafte Verbindung zwischen dem Client und dem Server herstellen kann, um eine bidirektionale Kommunikation in Echtzeit zu erreichen. Das Front-End kann die WebSocket-API verwenden, um eine WebSocket-Verbindung herzustellen und Instant Messaging durch Senden und Empfangen zu erreichen 2. Long Polling, eine Technologie, die Echtzeitkommunikation usw. simuliert.