Backend-Entwicklung

Backend-Entwicklung

Python-Tutorial

Python-Tutorial

Einführung in die Methode zum Lesen benutzerdefinierter Daten für das Tensorflow-Klassifikatorprojekt (Codebeispiel)

Einführung in die Methode zum Lesen benutzerdefinierter Daten für das Tensorflow-Klassifikatorprojekt (Codebeispiel)

Einführung in die Methode zum Lesen benutzerdefinierter Daten für das Tensorflow-Klassifikatorprojekt (Codebeispiel)

Dieser Artikel bietet Ihnen eine Einführung in die Methode zum Lesen benutzerdefinierter Daten für das Tensorflow-Klassifizierungsprojekt (Codebeispiel). Freunde in Not können sich darauf beziehen Du.

Benutzerdefiniertes Lesen der Daten des Tensorflow-Klassifikatorprojekts

Nachdem der Code des Klassifikatorprojekts gemäß der Demo auf der offiziellen Tensorflow-Website eingegeben wurde, war der Vorgang erfolgreich. Auch nicht schlecht . Aber am Ende muss ich noch meine eigenen Daten trainieren, also habe ich versucht, mich auf das Laden benutzerdefinierter Daten vorzubereiten. Fashion_mnist.load_data() erschien jedoch nur in der Demo, ohne dass ein detaillierter Lesevorgang erforderlich war Lesevorgang hier aufgezeichnet.

Lassen Sie mich zunächst die Module erwähnen, die Sie verwenden müssen:

import os import keras import matplotlib.pyplot as plt from PIL import Image from keras.preprocessing.image import ImageDataGenerator from sklearn.model_selection import train_test_split

Bildklassifizierungsprojekt: Bestimmen Sie zunächst die Auflösung des Bildes, das Sie verarbeiten möchten. Das Beispiel hier ist 30 Pixel:

IMG_SIZE_X = 30 IMG_SIZE_Y = 30

Bestimmen Sie als Zweites das Verzeichnis Ihrer Bilder:

image_path = r'D:\Projects\ImageClassifier\data\set' path = ".\data" # 你也可以使用相对路径的方式 # image_path =os.path.join(path, "set")

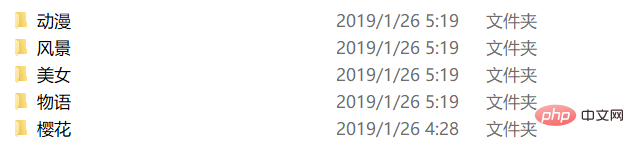

Die Struktur unter dem Verzeichnis ist wie folgt:

Die Die entsprechende label.txt lautet wie folgt:

动漫 风景 美女 物语 樱花

Als nächstes wird sie wie folgt mit labels.txt verbunden:

label_name = "labels.txt"

label_path = os.path.join(path, label_name)

class_names = np.loadtxt(label_path, type(""))Der Einfachheit halber wird die Loadtxt-Funktion von Numpy zum direkten Laden verwendet.

Danach werden die Bilddaten offiziell verarbeitet und die Kommentare werden hineingeschrieben:

re_load = False

re_build = False

# re_load = True

re_build = True

data_name = "data.npz"

data_path = os.path.join(path, data_name)

model_name = "model.h5"

model_path = os.path.join(path, model_name)

count = 0

# 这里判断是否存在序列化之后的数据,re_load是一个开关,是否强制重新处理,测试用,可以去除。

if not os.path.exists(data_path) or re_load:

labels = []

images = []

print('Handle images')

# 由于label.txt是和图片防止目录的分类目录一一对应的,即每个子目录的目录名就是labels.txt里的一个label,所以这里可以通过读取class_names的每一项去拼接path后读取

for index, name in enumerate(class_names):

# 这里是拼接后的子目录path

classpath = os.path.join(image_path, name)

# 先判断一下是否是目录

if not os.path.isdir(classpath):

continue

# limit是测试时候用的这里可以去除

limit = 0

for image_name in os.listdir(classpath):

if limit >= max_size:

break

# 这里是拼接后的待处理的图片path

imagepath = os.path.join(classpath, image_name)

count = count + 1

limit = limit + 1

# 利用Image打开图片

img = Image.open(imagepath)

# 缩放到你最初确定要处理的图片分辨率大小

img = img.resize((IMG_SIZE_X, IMG_SIZE_Y))

# 转为灰度图片,这里彩色通道会干扰结果,并且会加大计算量

img = img.convert("L")

# 转为numpy数组

img = np.array(img)

# 由(30,30)转为(1,30,30)(即`channels_first`),当然你也可以转换为(30,30,1)(即`channels_last`)但为了之后预览处理后的图片方便这里采用了(1,30,30)的格式存放

img = np.reshape(img, (1, IMG_SIZE_X, IMG_SIZE_Y))

# 这里利用循环生成labels数据,其中存放的实际是class_names中对应元素的索引

labels.append([index])

# 添加到images中,最后统一处理

images.append(img)

# 循环中一些状态的输出,可以去除

print("{} class: {} {} limit: {} {}"

.format(count, index + 1, class_names[index], limit, imagepath))

# 最后一次性将images和labels都转换成numpy数组

npy_data = np.array(images)

npy_labels = np.array(labels)

# 处理数据只需要一次,所以我们选择在这里利用numpy自带的方法将处理之后的数据序列化存储

np.savez(data_path, x=npy_data, y=npy_labels)

print("Save images by npz")

else:

# 如果存在序列化号的数据,便直接读取,提高速度

npy_data = np.load(data_path)["x"]

npy_labels = np.load(data_path)["y"]

print("Load images by npz")

image_data = npy_data

labels_data = npy_labelsZu diesem Zeitpunkt ist die Verarbeitung und Vorverarbeitung der Originaldaten abgeschlossen. Nur der letzte Schritt wird benötigt, genau wie in der Demo fashion_mnist.load_data()Die zurückgegebenen Ergebnisse sind die gleichen. Der Code lautet wie folgt:

# 最后一步就是将原始数据分成训练数据和测试数据 train_images, test_images, train_labels, test_labels = \ train_test_split(image_data, labels_data, test_size=0.2, random_state=6)

Die Methode zum Drucken relevanter Informationen ist auch hier angehängt:

print("_________________________________________________________________")

print("%-28s %-s" % ("Name", "Shape"))

print("=================================================================")

print("%-28s %-s" % ("Image Data", image_data.shape))

print("%-28s %-s" % ("Labels Data", labels_data.shape))

print("=================================================================")

print('Split train and test data,p=%')

print("_________________________________________________________________")

print("%-28s %-s" % ("Name", "Shape"))

print("=================================================================")

print("%-28s %-s" % ("Train Images", train_images.shape))

print("%-28s %-s" % ("Test Images", test_images.shape))

print("%-28s %-s" % ("Train Labels", train_labels.shape))

print("%-28s %-s" % ("Test Labels", test_labels.shape))

print("=================================================================")Vergessen Sie nicht, danach zu normalisieren:

print("Normalize images")

train_images = train_images / 255.0

test_images = test_images / 255.0Schließlich die Lesen aus vollständigen Codedefinitionsdaten:

import os

import keras

import matplotlib.pyplot as plt

from PIL import Image

from keras.layers import *

from keras.models import *

from keras.optimizers import Adam

from keras.preprocessing.image import ImageDataGenerator

from sklearn.model_selection import train_test_split

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

# 支持中文

plt.rcParams['font.sans-serif'] = ['SimHei'] # 用来正常显示中文标签

plt.rcParams['axes.unicode_minus'] = False # 用来正常显示负号

re_load = False

re_build = False

# re_load = True

re_build = True

epochs = 50

batch_size = 5

count = 0

max_size = 2000000000

IMG_SIZE_X = 30

IMG_SIZE_Y = 30

np.random.seed(9277)

image_path = r'D:\Projects\ImageClassifier\data\set'

path = ".\data"

data_name = "data.npz"

data_path = os.path.join(path, data_name)

model_name = "model.h5"

model_path = os.path.join(path, model_name)

label_name = "labels.txt"

label_path = os.path.join(path, label_name)

class_names = np.loadtxt(label_path, type(""))

print('Load class names')

if not os.path.exists(data_path) or re_load:

labels = []

images = []

print('Handle images')

for index, name in enumerate(class_names):

classpath = os.path.join(image_path, name)

if not os.path.isdir(classpath):

continue

limit = 0

for image_name in os.listdir(classpath):

if limit >= max_size:

break

imagepath = os.path.join(classpath, image_name)

count = count + 1

limit = limit + 1

img = Image.open(imagepath)

img = img.resize((30, 30))

img = img.convert("L")

img = np.array(img)

img = np.reshape(img, (1, 30, 30))

# img = skimage.io.imread(imagepath, as_grey=True)

# if img.shape[2] != 3:

# print("{} shape is {}".format(image_name, img.shape))

# continue

# data = transform.resize(img, (IMG_SIZE_X, IMG_SIZE_Y))

labels.append([index])

images.append(img)

print("{} class: {} {} limit: {} {}"

.format(count, index + 1, class_names[index], limit, imagepath))

npy_data = np.array(images)

npy_labels = np.array(labels)

np.savez(data_path, x=npy_data, y=npy_labels)

print("Save images by npz")

else:

npy_data = np.load(data_path)["x"]

npy_labels = np.load(data_path)["y"]

print("Load images by npz")

image_data = npy_data

labels_data = npy_labels

print("_________________________________________________________________")

print("%-28s %-s" % ("Name", "Shape"))

print("=================================================================")

print("%-28s %-s" % ("Image Data", image_data.shape))

print("%-28s %-s" % ("Labels Data", labels_data.shape))

print("=================================================================")

train_images, test_images, train_labels, test_labels = \

train_test_split(image_data, labels_data, test_size=0.2, random_state=6)

print('Split train and test data,p=%')

print("_________________________________________________________________")

print("%-28s %-s" % ("Name", "Shape"))

print("=================================================================")

print("%-28s %-s" % ("Train Images", train_images.shape))

print("%-28s %-s" % ("Test Images", test_images.shape))

print("%-28s %-s" % ("Train Labels", train_labels.shape))

print("%-28s %-s" % ("Test Labels", test_labels.shape))

print("=================================================================")

# 归一化

# 我们将这些值缩小到 0 到 1 之间,然后将其馈送到神经网络模型。为此,将图像组件的数据类型从整数转换为浮点数,然后除以 255。以下是预处理图像的函数:

# 务必要以相同的方式对训练集和测试集进行预处理:

print("Normalize images")

train_images = train_images / 255.0

test_images = test_images / 255.0Das obige ist der detaillierte Inhalt vonEinführung in die Methode zum Lesen benutzerdefinierter Daten für das Tensorflow-Klassifikatorprojekt (Codebeispiel). Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Wie kontrolliert PS -Federn die Weichheit des Übergangs?

Apr 06, 2025 pm 07:33 PM

Wie kontrolliert PS -Federn die Weichheit des Übergangs?

Apr 06, 2025 pm 07:33 PM

Der Schlüssel zur Federkontrolle liegt darin, seine allmähliche Natur zu verstehen. PS selbst bietet nicht die Möglichkeit, die Gradientenkurve direkt zu steuern, aber Sie können den Radius und die Gradientenweichheit flexius durch mehrere Federn, Matching -Masken und feine Selektionen anpassen, um einen natürlichen Übergangseffekt zu erzielen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

MySQL hat eine kostenlose Community -Version und eine kostenpflichtige Enterprise -Version. Die Community -Version kann kostenlos verwendet und geändert werden, die Unterstützung ist jedoch begrenzt und für Anwendungen mit geringen Stabilitätsanforderungen und starken technischen Funktionen geeignet. Die Enterprise Edition bietet umfassende kommerzielle Unterstützung für Anwendungen, die eine stabile, zuverlässige Hochleistungsdatenbank erfordern und bereit sind, Unterstützung zu bezahlen. Zu den Faktoren, die bei der Auswahl einer Version berücksichtigt werden, gehören Kritikalität, Budgetierung und technische Fähigkeiten von Anwendungen. Es gibt keine perfekte Option, nur die am besten geeignete Option, und Sie müssen die spezifische Situation sorgfältig auswählen.

Wie richte ich PS -Federn ein?

Apr 06, 2025 pm 07:36 PM

Wie richte ich PS -Federn ein?

Apr 06, 2025 pm 07:36 PM

PS Federn ist ein Bildkantenschwärcheneffekt, der durch den gewichteten Durchschnitt der Pixel im Randbereich erreicht wird. Das Einstellen des Federradius kann den Grad der Unschärfe steuern und je größer der Wert ist, desto unscharfer ist er. Eine flexible Einstellung des Radius kann den Effekt entsprechend den Bildern und Bedürfnissen optimieren. Verwenden Sie beispielsweise einen kleineren Radius, um Details bei der Verarbeitung von Charakterfotos zu erhalten und einen größeren Radius zu verwenden, um ein dunstiges Gefühl bei der Verarbeitung von Kunst zu erzeugen. Es ist jedoch zu beachten, dass zu groß der Radius leicht an Kantendetails verlieren kann, und zu klein ist der Effekt nicht offensichtlich. Der Federneffekt wird von der Bildauflösung beeinflusst und muss anhand des Bildverständnisses und des Griffs von Effekten angepasst werden.

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

Die MySQL -Leistungsoptimierung muss von drei Aspekten beginnen: Installationskonfiguration, Indexierung und Abfrageoptimierung, Überwachung und Abstimmung. 1. Nach der Installation müssen Sie die my.cnf -Datei entsprechend der Serverkonfiguration anpassen, z. 2. Erstellen Sie einen geeigneten Index, um übermäßige Indizes zu vermeiden und Abfrageanweisungen zu optimieren, z. B. den Befehl Erklärung zur Analyse des Ausführungsplans; 3. Verwenden Sie das eigene Überwachungstool von MySQL (ShowProcessList, Showstatus), um die Datenbankgesundheit zu überwachen und die Datenbank regelmäßig zu sichern und zu organisieren. Nur durch kontinuierliche Optimierung dieser Schritte kann die Leistung der MySQL -Datenbank verbessert werden.

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

Die Hauptgründe für den Fehler bei MySQL -Installationsfehlern sind: 1. Erlaubnisprobleme, Sie müssen als Administrator ausgeführt oder den Sudo -Befehl verwenden. 2. Die Abhängigkeiten fehlen, und Sie müssen relevante Entwicklungspakete installieren. 3. Portkonflikte müssen Sie das Programm schließen, das Port 3306 einnimmt, oder die Konfigurationsdatei ändern. 4. Das Installationspaket ist beschädigt. Sie müssen die Integrität herunterladen und überprüfen. 5. Die Umgebungsvariable ist falsch konfiguriert und die Umgebungsvariablen müssen korrekt entsprechend dem Betriebssystem konfiguriert werden. Lösen Sie diese Probleme und überprüfen Sie jeden Schritt sorgfältig, um MySQL erfolgreich zu installieren.

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Die MySQL-Datenbankleistung Optimierungshandbuch In ressourcenintensiven Anwendungen spielt die MySQL-Datenbank eine entscheidende Rolle und ist für die Verwaltung massiver Transaktionen verantwortlich. Mit der Erweiterung der Anwendung werden jedoch die Datenbankleistung Engpässe häufig zu einer Einschränkung. In diesem Artikel werden eine Reihe effektiver Strategien zur Leistungsoptimierung von MySQL -Leistung untersucht, um sicherzustellen, dass Ihre Anwendung unter hohen Lasten effizient und reaktionsschnell bleibt. Wir werden tatsächliche Fälle kombinieren, um eingehende Schlüsseltechnologien wie Indexierung, Abfrageoptimierung, Datenbankdesign und Caching zu erklären. 1. Das Design der Datenbankarchitektur und die optimierte Datenbankarchitektur sind der Eckpfeiler der MySQL -Leistungsoptimierung. Hier sind einige Kernprinzipien: Die Auswahl des richtigen Datentyps und die Auswahl des kleinsten Datentyps, der den Anforderungen entspricht, kann nicht nur Speicherplatz speichern, sondern auch die Datenverarbeitungsgeschwindigkeit verbessern.

Lösungen für den Dienst, der nach der MySQL -Installation nicht gestartet werden kann

Apr 08, 2025 am 11:18 AM

Lösungen für den Dienst, der nach der MySQL -Installation nicht gestartet werden kann

Apr 08, 2025 am 11:18 AM

MySQL hat sich geweigert, anzufangen? Nicht in Panik, lass es uns ausprobieren! Viele Freunde stellten fest, dass der Service nach der Installation von MySQL nicht begonnen werden konnte, und sie waren so ängstlich! Mach dir keine Sorgen, dieser Artikel wird dich dazu bringen, ruhig damit umzugehen und den Mastermind dahinter herauszufinden! Nachdem Sie es gelesen haben, können Sie dieses Problem nicht nur lösen, sondern auch Ihr Verständnis von MySQL -Diensten und Ihren Ideen zur Fehlerbehebungsproblemen verbessern und zu einem leistungsstärkeren Datenbankadministrator werden! Der MySQL -Dienst startete nicht und es gibt viele Gründe, von einfachen Konfigurationsfehlern bis hin zu komplexen Systemproblemen. Beginnen wir mit den häufigsten Aspekten. Grundkenntnisse: Eine kurze Beschreibung des Service -Startup -Prozesses MySQL Service Startup. Einfach ausgedrückt, lädt das Betriebssystem MySQL-bezogene Dateien und startet dann den MySQL-Daemon. Dies beinhaltet die Konfiguration