Der Hauptinhalt dieses Artikels besteht darin, mehrere PHP-Prozesse mit der geordneten Redis-Sammlung zu verwenden, um eine Deduplizierung großer Dateien zu erreichen.

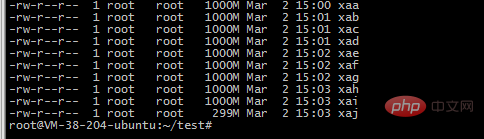

1. Für eine große Datei lautet meine Datei beispielsweise

-rw-r--r-- 1 ubuntu ubuntu 9.1G 1. März 17:53 2018-12 -awk -uniq.txt

2. Verwenden Sie den Split-Befehl, um in 10 kleine Dateien zu schneiden

split -b 1000m 2018-12-awk-uniq.txt -b Nach Bytes schneiden, Unterstützungseinheit m und k

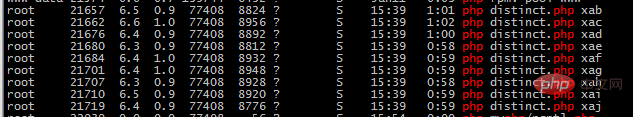

3. Verwenden Sie 10 PHP-Prozesse, um die Datei zu lesen und in die geordnete Mengenstruktur von Redis einzufügen. Wiederholte Prozesse sind nicht möglich eingefügt werden, damit es die Rolle der Deduplizierung spielen kann

4 redis

4 redis

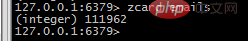

zcard emails Holen Sie sich die Anzahl der Elemente

Rufen Sie Elemente in einem bestimmten Bereich ab, z. B. beginnend bei 100000 und endend bei 100100 zrange emails 100000 100100 WITHSCORES

zrange emails 100000 100100 WITHSCORES

Wenn Sie PHP effizienter lernen möchten, achten Sie bitte auf das

PHP-Video-Tutorialauf der chinesischen PHP-Website.

Das obige ist der detaillierte Inhalt vonPHP kombiniert mit Redis zur Implementierung der Deduplizierung großer Dateien. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So öffnen Sie eine PHP-Datei

So öffnen Sie eine PHP-Datei

So entfernen Sie die ersten paar Elemente eines Arrays in PHP

So entfernen Sie die ersten paar Elemente eines Arrays in PHP

Was tun, wenn die PHP-Deserialisierung fehlschlägt?

Was tun, wenn die PHP-Deserialisierung fehlschlägt?

So verbinden Sie PHP mit der MSSQL-Datenbank

So verbinden Sie PHP mit der MSSQL-Datenbank

So verbinden Sie PHP mit der MSSQL-Datenbank

So verbinden Sie PHP mit der MSSQL-Datenbank

Häufig verwendete Datenbanksoftware

Häufig verwendete Datenbanksoftware

So laden Sie HTML hoch

So laden Sie HTML hoch

So lösen Sie verstümmelte Zeichen in PHP

So lösen Sie verstümmelte Zeichen in PHP