Welche Bibliotheken müssen installiert werden, um den Python-Webcrawler zu erlernen?

Im Folgenden sind die relevanten Bibliotheken aufgeführt, die an Python-Crawlern beteiligt sind

Anforderungsbibliothek, Analysebibliothek, Repository, Toolbibliothek

1. Bibliothek anfordern: urllib/re/requests

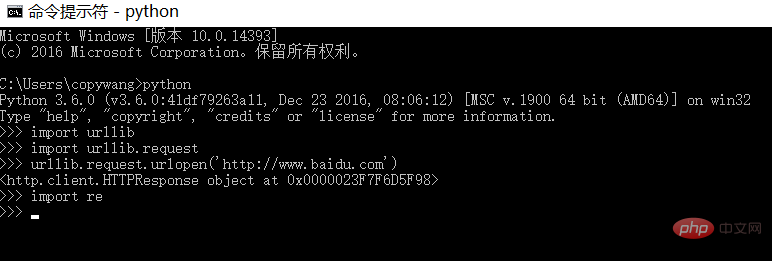

(1) urllib/re ist die standardmäßig mit Python gelieferte Bibliothek. Sie kann mit dem folgenden Befehl überprüft werden:

Es wird keine Fehlermeldung ausgegeben, was darauf hinweist, dass die Umgebung normal ist

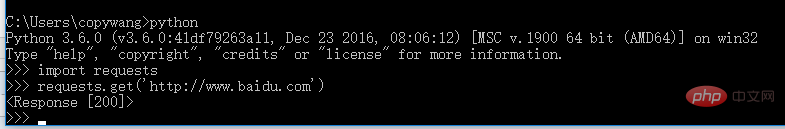

(2) fordert Installation an

2.1 CMD öffnen, pip3-Installationsanfragen eingeben

2.2 Installation abwarten, überprüfen

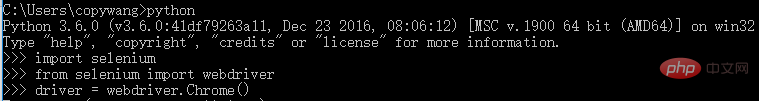

(3) Selenium-Installation (Browser für Website-Zugriffsverhalten steuern)

3.1 CMD öffnen, eingeben pip3 install selenium

3.2 Chromedriver installieren

Website: https://npm.taobao.org/

Entpacken Sie das heruntergeladene komprimierte Paket und legen Sie die Exe in D ab :Python3.6.0Scripts

Dieser Pfad muss nur in der PATH-Variablen sein

3.3 Überprüfen Sie nach Abschluss der Installation

Drücken Sie die Eingabetaste und der Chrome-Browser wird angezeigt. Schnittstelle

3.4 Andere Browser installieren

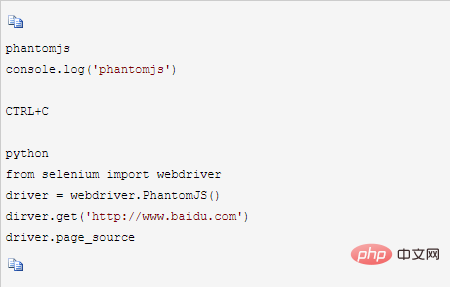

Schnittstellenloser Browser Phantomjs

Download-URL: http://phantomjs.org/

Nach Abschluss des Downloads entpacken, das gesamte Verzeichnis in D:Python3.6.0Scripts einfügen und den Pfad zum bin-Verzeichnis zur PATH-Variablen hinzufügen

Überprüfung:

CMD öffnen

2. Parsing-Bibliothek:

2.1 lxml (XPATH)

Öffnen Sie CMD und geben Sie pip3 install lxml ein oder laden Sie es von https://pypi herunter .python.org, zum Beispiel lxml-4.1. 1-cp36-cp36m-win_amd64.whl (md5), laden Sie zuerst die WHL-Datei herunter und führen Sie die pip3-Installation in der Befehlszeile aus. Dateiname.whl

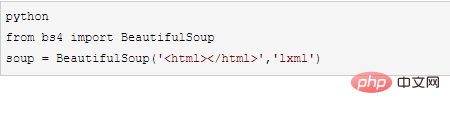

2.2 beautifulsoup

Öffnen Sie CMD, Sie müssen es zuerst installieren. Gutes lxml

pip3 install beautifulsoup4

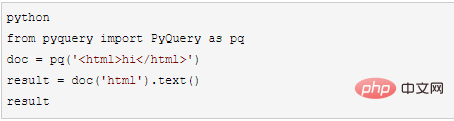

2.3 pyquery ( ähnlich der JQuery-Syntax)

Öffnen Sie CMD, pip3 install pyquery

Überprüfen Sie die Installationsergebnisse

3. Repository

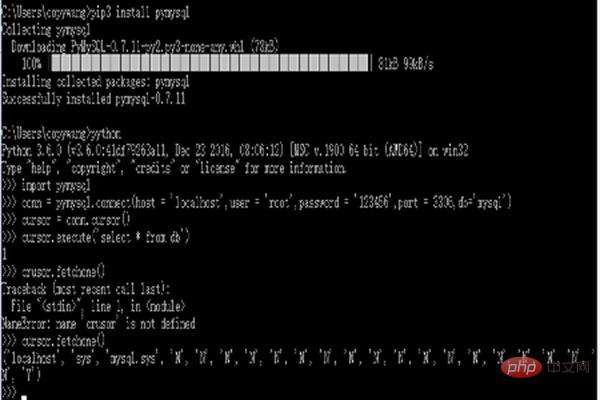

3.1 pymysql (betreiben MySQL, relationale Datenbank)

Installation: pip3 install pymysql, Test nach der Installation:

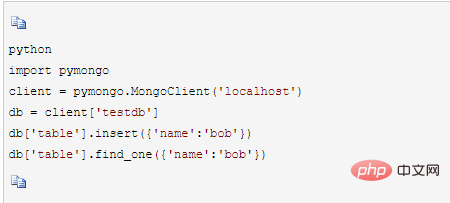

3.2 pymongo (betreiben MongoDB, Schlüsselwert )

Pip3 installieren, Pymongo installieren

Überprüfung

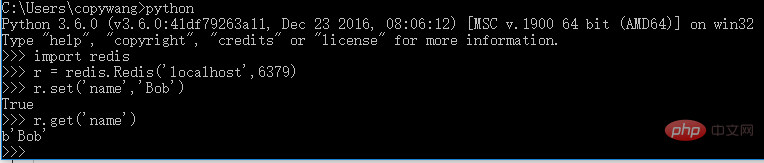

3.3 Redis (verteilter Crawler, Crawling-Warteschlange beibehalten) Installation: pip3-Installation redis

Überprüfung:

4.1Django (verteiltes Crawler-Wartungssystem) pip3 install django

4.2jupyter ( Notizblock läuft auf der Webseite, unterstützt Markdown, kann auf der Webseite ausgeführt werden Code) Installation pip3 install jupyter

Überprüfung: CMD öffnen, Jupyter-Notizbuch

kann Notizblöcke und Codeblöcke erstellen und Markdown-Blöcke direkt auf der Webseite unterstützen das Drucken

Das obige ist der detaillierte Inhalt vonWelche Pakete sollten für den Python-Crawler installiert werden?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Welche Versionen des Linux-Systems gibt es?

Welche Versionen des Linux-Systems gibt es?

Verwendung von #include in der C-Sprache

Verwendung von #include in der C-Sprache

Was bedeutet Marge in CSS?

Was bedeutet Marge in CSS?

So stellen Sie den normalen Druck wieder her, wenn der Drucker offline ist

So stellen Sie den normalen Druck wieder her, wenn der Drucker offline ist

Was bedeutet Liquidation?

Was bedeutet Liquidation?

Einführung in Artikel-Tag-Attribute

Einführung in Artikel-Tag-Attribute

So starten Sie die Oracle-Datenüberwachung

So starten Sie die Oracle-Datenüberwachung

Windows kann zum Hinzufügen eines Druckers nicht geöffnet werden

Windows kann zum Hinzufügen eines Druckers nicht geöffnet werden

Virtuelle Mobiltelefonnummer, um den Bestätigungscode zu erhalten

Virtuelle Mobiltelefonnummer, um den Bestätigungscode zu erhalten