So verbessern Sie die Trefferquote des Redis-Cache

Einführung in die Cache-Trefferquote

Treffer: Die erforderlichen Daten können direkt über den Cache abgerufen werden.

Fehlend: Die gewünschten Daten können nicht direkt über den Cache abgerufen werden und die Datenbank muss erneut abgefragt oder andere Vorgänge ausgeführt werden. Der Grund könnte sein, dass es einfach nicht im Cache vorhanden ist oder dass der Cache abgelaufen ist.

Im Allgemeinen gilt: Je höher die Cache-Trefferrate, desto größer sind die Vorteile der Verwendung des Caches, desto besser ist die Leistung der Anwendung (kürzere Antwortzeit, höherer Durchsatz) und desto stärker ist die Fähigkeit, der Parallelität zu widerstehen.

Es ist ersichtlich, dass in einem Internetsystem mit hoher Parallelität die Cache-Trefferrate ein entscheidender Indikator ist.

So überwachen Sie die Cache-Trefferquote

Führen Sie in Memcached den Statusbefehl aus, um die Statusinformationen des Memcached-Dienstes anzuzeigen, wobei cmd_get die Gesamtzahl der Gets und get_hits die Gesamtzahl darstellt Anzahl der Treffer, Trefferquote = get_hits/cmd_get.

Natürlich können wir den gesamten Memcached-Cluster auch über einige Open-Source-Tools von Drittanbietern überwachen, wodurch die Anzeige intuitiver wird. Typische sind: zabbix, MemAdmin usw.

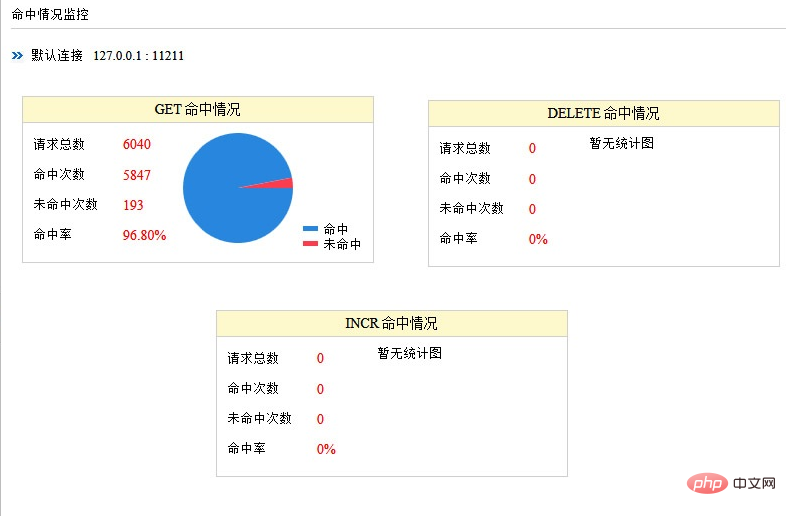

Wie in der Abbildung gezeigt: MemAdmins Überwachungsstatistik der Trefferquote des zwischengespeicherten Dienstes

In ähnlicher Weise können Sie Informationen ausführen in redis Verwenden Sie den Befehl, um die Statusinformationen des Redis-Dienstes anzuzeigen, wobei keyspace_hits die Gesamtzahl der Treffer, keyspace_misses die Gesamtzahl der Fehlschläge und die Trefferrate = keyspace_hits/(keyspace_hits + keyspace_misses) ist.

Das Open-Source-Tool Redis-star kann Redis-Service-bezogene Informationen in einem Diagramm visualisieren. Gleichzeitig stellt zabbix auch zugehörige Plug-Ins zur Überwachung von Redis-Services bereit.

Mehrere Faktoren, die die Cache-Trefferquote beeinflussen

Im vorherigen Kapitel haben wir die Bedeutung der Cache-Trefferquote erwähnt. Lassen Sie uns mehrere Faktoren analysieren, die die Cache-Trefferquote beeinflussen.

- Geschäftsszenarien und Geschäftsanforderungen

Cache ist für Geschäftsszenarien mit „mehr Lesen und weniger Schreiben“ geeignet. Im Gegenteil, die Verwendung von Cache ist tatsächlich nicht von Bedeutung großartig. Die Trefferquote wird sehr niedrig sein.

Geschäftsanforderungen bestimmen die Aktualitätsanforderungen, die sich direkt auf die Cache-Ablaufzeit und die Aktualisierungsstrategie auswirken. Je geringer die Aktualitätsanforderung ist, desto besser eignet sie sich für das Caching. Bei gleichem Schlüssel und gleicher Anzahl an Anfragen ist die Trefferquote umso höher, je länger die Cache-Zeit ist.

Cache ist für die meisten Geschäftsszenarien von Internetanwendungen geeignet.

- Cache-Design (Granularität und Strategie)

Im Allgemeinen gilt: Je kleiner die Cache-Granularität, desto höher die Trefferquote. Ein praktisches Beispiel:

Beim Zwischenspeichern eines einzelnen Objekts (z. B. einer einzelnen Benutzerinformation) müssen wir den Cache nur aktualisieren oder den Cache entfernen, wenn sich die dem Objekt entsprechenden Daten ändern. Beim Zwischenspeichern einer Sammlung (z. B. aller Benutzerdaten) muss der Cache aktualisiert oder entfernt werden, wenn sich die einem Objekt entsprechenden Daten ändern.

Es gibt eine andere Situation: Unter der Annahme, dass auch andere Orte die dem Objekt entsprechenden Daten abrufen müssen (z. B. müssen andere Orte auch individuelle Benutzerinformationen abrufen), ist dies möglich, wenn der Cache ein einzelnes Objekt ist Schlagen Sie direkt auf den Cache zu, andernfalls kann er nicht direkt treffen. Dies ist flexibler und die Cache-Trefferquote ist höher.

Darüber hinaus wirkt sich die Cache-Aktualisierungs-/Ablaufrichtlinie auch direkt auf die Cache-Trefferquote aus. Wenn sich die Daten ändern, hat das direkte Aktualisieren des zwischengespeicherten Werts eine höhere Trefferquote als das Entfernen des Caches (oder das Ablaufenlassen des Caches). Natürlich ist auch die Systemkomplexität höher.

- Cache-Kapazität und Infrastruktur

Die Cache-Kapazität ist begrenzt, was leicht zu Cache-Ausfällen und -Beseitigungen führen kann (die meisten Cache-Frameworks oder Middleware verwenden derzeit den LRU-Algorithmus). Gleichzeitig ist auch die Auswahl der Cache-Technologie von entscheidender Bedeutung. Beispielsweise führt die Verwendung eines in die Anwendung integrierten lokalen Caches eher zu einem Engpass auf einer einzelnen Maschine, während die Verwendung eines verteilten Caches leicht zu erweitern ist. Daher ist es notwendig, die Systemkapazität zu planen und zu prüfen, ob sie skalierbar ist. Darüber hinaus unterscheiden sich auch die Effizienz und Stabilität verschiedener Caching-Frameworks oder Middleware.

- Andere Faktoren

Wenn ein Cache-Knoten ausfällt, muss eine Cache-Invalidierung vermieden und die Auswirkungen minimiert werden. Auch diese besondere Situation muss vom Architekten berücksichtigt werden. Ein typischer Ansatz in der Branche ist die Verwendung eines konsistenten Hash-Algorithmus oder Knotenredundanz.

Einige Freunde haben möglicherweise dieses Missverständnis: Da die Geschäftsanforderungen hohe Anforderungen an die Aktualität der Daten stellen und die Cache-Zeit die Cache-Trefferquote beeinflusst, sollte das System den Cache nicht verwenden. Tatsächlich wird dabei ein wichtiger Faktor außer Acht gelassen: die Parallelität. Im Allgemeinen ist bei gleicher Cache-Zeit und gleichem Schlüssel der Cache-Umsatz umso höher, je höher die Parallelität ist, selbst wenn die Cache-Zeit kurz ist.

Methoden zur Verbesserung der Cache-Trefferquote

Aus Sicht eines Architekten muss die Anwendung Daten so weit wie möglich direkt über den Cache abrufen und eine Cache-Ungültigmachung vermeiden. Dies stellt auch die Fähigkeiten des Architekten auf die Probe und erfordert umfassende Überlegungen und Kompromisse in verschiedenen Aspekten wie Geschäftsanforderungen, Cache-Granularität, Cache-Strategie und Technologieauswahl. Konzentrieren Sie sich so weit wie möglich auf Hot-Services, auf die häufig zugegriffen wird und die geringe Aktualitätsanforderungen haben, und verbessern Sie die Trefferquote durch Vorladen (Erwärmen) des Caches, Erhöhen der Speicherkapazität, Anpassen der Cache-Granularität und Aktualisieren des Caches.

Bei Anwendungen mit hoher Aktualität (oder begrenztem Cache-Speicherplatz), großer Inhaltsspanne (oder sehr zufälligem Zugriff) und geringem Zugriffsvolumen kann die Cache-Trefferquote über einen längeren Zeitraum sehr niedrig sein. Der Cache ist abgelaufen bevor überhaupt darauf zugegriffen wurde.

Weitere technische Artikel zum Thema Redis finden Sie in der Spalte Redis-Tutorial, um mehr darüber zu erfahren!

Das obige ist der detaillierte Inhalt vonSo verbessern Sie die Trefferquote des Redis-Cache. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1393

1393

52

52

1209

1209

24

24

So erstellen Sie den Redis -Clustermodus

Apr 10, 2025 pm 10:15 PM

So erstellen Sie den Redis -Clustermodus

Apr 10, 2025 pm 10:15 PM

Der Redis -Cluster -Modus bietet Redis -Instanzen durch Sharding, die Skalierbarkeit und Verfügbarkeit verbessert. Die Bauschritte sind wie folgt: Erstellen Sie ungerade Redis -Instanzen mit verschiedenen Ports; Erstellen Sie 3 Sentinel -Instanzen, Monitor -Redis -Instanzen und Failover; Konfigurieren von Sentinel -Konfigurationsdateien, Informationen zur Überwachung von Redis -Instanzinformationen und Failover -Einstellungen hinzufügen. Konfigurieren von Redis -Instanzkonfigurationsdateien, aktivieren Sie den Cluster -Modus und geben Sie den Cluster -Informationsdateipfad an. Erstellen Sie die Datei nodes.conf, die Informationen zu jeder Redis -Instanz enthält. Starten Sie den Cluster, führen Sie den Befehl erstellen aus, um einen Cluster zu erstellen und die Anzahl der Replikate anzugeben. Melden Sie sich im Cluster an, um den Befehl cluster info auszuführen, um den Clusterstatus zu überprüfen. machen

So löschen Sie Redis -Daten

Apr 10, 2025 pm 10:06 PM

So löschen Sie Redis -Daten

Apr 10, 2025 pm 10:06 PM

So löschen Sie Redis -Daten: Verwenden Sie den Befehl Flushall, um alle Schlüsselwerte zu löschen. Verwenden Sie den Befehl flushdb, um den Schlüsselwert der aktuell ausgewählten Datenbank zu löschen. Verwenden Sie SELECT, um Datenbanken zu wechseln, und löschen Sie dann FlushDB, um mehrere Datenbanken zu löschen. Verwenden Sie den Befehl del, um einen bestimmten Schlüssel zu löschen. Verwenden Sie das Redis-Cli-Tool, um die Daten zu löschen.

So lesen Sie Redis -Warteschlange

Apr 10, 2025 pm 10:12 PM

So lesen Sie Redis -Warteschlange

Apr 10, 2025 pm 10:12 PM

Um eine Warteschlange aus Redis zu lesen, müssen Sie den Warteschlangenname erhalten, die Elemente mit dem Befehl LPOP lesen und die leere Warteschlange verarbeiten. Die spezifischen Schritte sind wie folgt: Holen Sie sich den Warteschlangenname: Nennen Sie ihn mit dem Präfix von "Warteschlange:" wie "Warteschlangen: My-Queue". Verwenden Sie den Befehl LPOP: Wischen Sie das Element aus dem Kopf der Warteschlange aus und geben Sie seinen Wert zurück, z. B. die LPOP-Warteschlange: my-queue. Verarbeitung leerer Warteschlangen: Wenn die Warteschlange leer ist, gibt LPOP NIL zurück, und Sie können überprüfen, ob die Warteschlange existiert, bevor Sie das Element lesen.

So verwenden Sie den Befehl Redis

Apr 10, 2025 pm 08:45 PM

So verwenden Sie den Befehl Redis

Apr 10, 2025 pm 08:45 PM

Die Verwendung der REDIS -Anweisung erfordert die folgenden Schritte: Öffnen Sie den Redis -Client. Geben Sie den Befehl ein (Verbschlüsselwert). Bietet die erforderlichen Parameter (variiert von der Anweisung bis zur Anweisung). Drücken Sie die Eingabetaste, um den Befehl auszuführen. Redis gibt eine Antwort zurück, die das Ergebnis der Operation anzeigt (normalerweise in Ordnung oder -err).

So verwenden Sie Redis Lock

Apr 10, 2025 pm 08:39 PM

So verwenden Sie Redis Lock

Apr 10, 2025 pm 08:39 PM

Um die Operationen zu sperren, muss die Sperre durch den Befehl setNX erfasst werden und dann den Befehl Ablauf verwenden, um die Ablaufzeit festzulegen. Die spezifischen Schritte sind: (1) Verwenden Sie den Befehl setNX, um zu versuchen, ein Schlüsselwertpaar festzulegen; (2) Verwenden Sie den Befehl Ablauf, um die Ablaufzeit für die Sperre festzulegen. (3) Verwenden Sie den Befehl Del, um die Sperre zu löschen, wenn die Sperre nicht mehr benötigt wird.

So lesen Sie den Quellcode von Redis

Apr 10, 2025 pm 08:27 PM

So lesen Sie den Quellcode von Redis

Apr 10, 2025 pm 08:27 PM

Der beste Weg, um Redis -Quellcode zu verstehen, besteht darin, Schritt für Schritt zu gehen: Machen Sie sich mit den Grundlagen von Redis vertraut. Wählen Sie ein bestimmtes Modul oder eine bestimmte Funktion als Ausgangspunkt. Beginnen Sie mit dem Einstiegspunkt des Moduls oder der Funktion und sehen Sie sich die Codezeile nach Zeile an. Zeigen Sie den Code über die Funktionsaufrufkette an. Kennen Sie die von Redis verwendeten Datenstrukturen. Identifizieren Sie den von Redis verwendeten Algorithmus.

So verwenden Sie die Befehlszeile der Redis

Apr 10, 2025 pm 10:18 PM

So verwenden Sie die Befehlszeile der Redis

Apr 10, 2025 pm 10:18 PM

Verwenden Sie das Redis-Befehlszeilen-Tool (REDIS-CLI), um Redis in folgenden Schritten zu verwalten und zu betreiben: Stellen Sie die Adresse und den Port an, um die Adresse und den Port zu stellen. Senden Sie Befehle mit dem Befehlsnamen und den Parametern an den Server. Verwenden Sie den Befehl Hilfe, um Hilfeinformationen für einen bestimmten Befehl anzuzeigen. Verwenden Sie den Befehl zum Beenden, um das Befehlszeilenwerkzeug zu beenden.

So konfigurieren Sie die Ausführungszeit der Lua -Skript in CentOS Redis

Apr 14, 2025 pm 02:12 PM

So konfigurieren Sie die Ausführungszeit der Lua -Skript in CentOS Redis

Apr 14, 2025 pm 02:12 PM

Auf CentOS -Systemen können Sie die Ausführungszeit von LuA -Skripten einschränken, indem Sie Redis -Konfigurationsdateien ändern oder Befehle mit Redis verwenden, um zu verhindern, dass bösartige Skripte zu viele Ressourcen konsumieren. Methode 1: Ändern Sie die Redis -Konfigurationsdatei und suchen Sie die Redis -Konfigurationsdatei: Die Redis -Konfigurationsdatei befindet sich normalerweise in /etc/redis/redis.conf. Konfigurationsdatei bearbeiten: Öffnen Sie die Konfigurationsdatei mit einem Texteditor (z. B. VI oder Nano): Sudovi/etc/redis/redis.conf Setzen Sie die LUA -Skriptausführungszeit.