Wie schreibe ich einen Python-Crawler?

Heutzutage geben sich viele Freunde mit Programmierkenntnissen nicht mehr mit der manuellen Suche nach Inhalten zufrieden und hoffen, durch das Schreiben einer Crawler-Software schnell an die erforderlichen Inhalte zu gelangen Crawler? Der Redakteur unten erklärt Ihnen die Ideen

Die Methoden/Schritte zum Schreiben eines Python-Crawlers

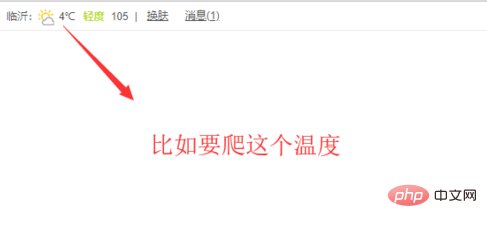

Zuerst müssen wir den Inhalt der Zielseite bestimmen gecrawlt werden, wie in der Abbildung unten gezeigt, zum Beispiel Um den Temperaturwert

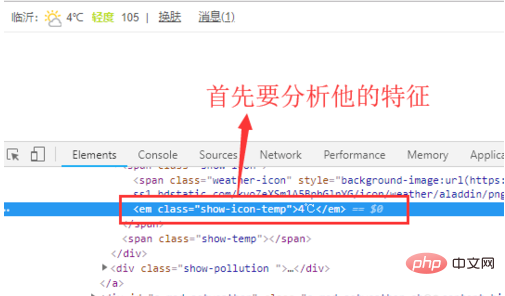

zu erhalten, müssen wir F12 des Browsers öffnen und die Eigenschaften des Inhalts finden, den wir haben B. welche Stil-Tags oder ID-Attribute es hat

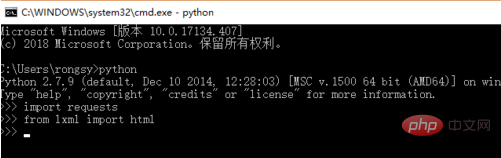

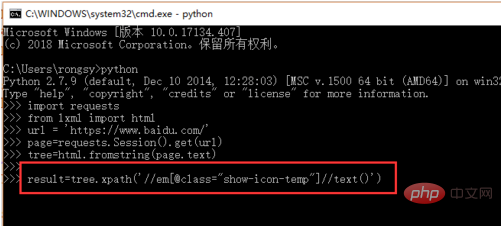

Als nächstes öffnen wir die cmd-Befehlszeilenschnittstelle und importieren die Anforderungsbibliothek und die HTML-Bibliothek, wie im gezeigt Abbildung unten. Diese lxml muss selbst heruntergeladen und installiert werden

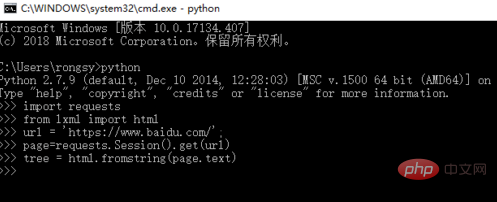

Der nächste Schritt besteht darin, den Seiteninhalt über die Anforderungsbibliothek abzurufen und dann den HTML-Code unter lxml zu verwenden Konvertieren Sie es in Text, wie in der Abbildung unten gezeigt

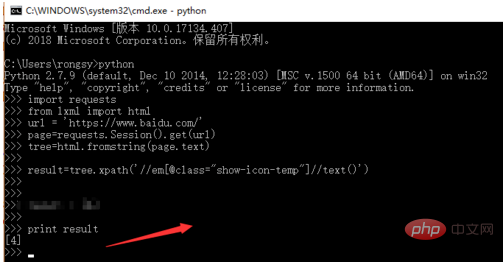

Der nächste Schritt besteht darin, die xpath-Syntax zu verwenden, um nach dem Inhalt eines bestimmten Elements, dem Namen der Klasse oder der ID zu suchen wird hier im Allgemeinen verwendet, wie in der folgenden Abbildung gezeigt

Führen Sie abschließend das Programm aus, um den erforderlichen Inhalt wie folgt abzurufen Wie in der Abbildung gezeigt

Zusammenfassend lässt sich sagen, dass die Verwendung von Python zum Erstellen eines Crawlers hauptsächlich Anforderungen zum Abrufen von Inhalten verwendet und dann basierend auf dem Inhalt nach bestimmten Elementen sucht. Dies ist jedoch nur der einfachste Prozess in komplexen Crawlern.

Verwandte Empfehlungen: „Python-Tutorial“

Das obige ist der detaillierte Inhalt vonWie schreibe ich einen Python-Crawler?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1371

1371

52

52

Wie löste ich das Problem der Berechtigungen beim Betrachten der Python -Version in Linux Terminal?

Apr 01, 2025 pm 05:09 PM

Wie löste ich das Problem der Berechtigungen beim Betrachten der Python -Version in Linux Terminal?

Apr 01, 2025 pm 05:09 PM

Lösung für Erlaubnisprobleme beim Betrachten der Python -Version in Linux Terminal Wenn Sie versuchen, die Python -Version in Linux Terminal anzuzeigen, geben Sie Python ein ...

Wie benutze ich eine schöne Suppe, um HTML zu analysieren?

Mar 10, 2025 pm 06:54 PM

Wie benutze ich eine schöne Suppe, um HTML zu analysieren?

Mar 10, 2025 pm 06:54 PM

In diesem Artikel wird erklärt, wie man schöne Suppe, eine Python -Bibliothek, verwendet, um HTML zu analysieren. Es beschreibt gemeinsame Methoden wie find (), find_all (), select () und get_text () für die Datenextraktion, die Behandlung verschiedener HTML -Strukturen und -Anternativen (SEL)

Mathematische Module in Python: Statistik

Mar 09, 2025 am 11:40 AM

Mathematische Module in Python: Statistik

Mar 09, 2025 am 11:40 AM

Das Statistikmodul von Python bietet leistungsstarke Datenstatistikanalysefunktionen, mit denen wir die allgemeinen Merkmale von Daten wie Biostatistik und Geschäftsanalyse schnell verstehen können. Anstatt Datenpunkte nacheinander zu betrachten, schauen Sie sich nur Statistiken wie Mittelwert oder Varianz an, um Trends und Merkmale in den ursprünglichen Daten zu ermitteln, die möglicherweise ignoriert werden, und vergleichen Sie große Datensätze einfacher und effektiv. In diesem Tutorial wird erläutert, wie der Mittelwert berechnet und den Grad der Dispersion des Datensatzes gemessen wird. Sofern nicht anders angegeben, unterstützen alle Funktionen in diesem Modul die Berechnung der Mittelwert () -Funktion, anstatt einfach den Durchschnitt zu summieren. Es können auch schwimmende Punktzahlen verwendet werden. zufällig importieren Statistiken importieren Aus Fracti

Wie führe ich ein tiefes Lernen mit Tensorflow oder Pytorch durch?

Mar 10, 2025 pm 06:52 PM

Wie führe ich ein tiefes Lernen mit Tensorflow oder Pytorch durch?

Mar 10, 2025 pm 06:52 PM

Dieser Artikel vergleicht TensorFlow und Pytorch für Deep Learning. Es beschreibt die beteiligten Schritte: Datenvorbereitung, Modellbildung, Schulung, Bewertung und Bereitstellung. Wichtige Unterschiede zwischen den Frameworks, insbesondere bezüglich des rechnerischen Graps

Was sind einige beliebte Python -Bibliotheken und ihre Verwendung?

Mar 21, 2025 pm 06:46 PM

Was sind einige beliebte Python -Bibliotheken und ihre Verwendung?

Mar 21, 2025 pm 06:46 PM

In dem Artikel werden beliebte Python-Bibliotheken wie Numpy, Pandas, Matplotlib, Scikit-Learn, TensorFlow, Django, Flask und Anfragen erörtert, die ihre Verwendung in wissenschaftlichen Computing, Datenanalyse, Visualisierung, maschinellem Lernen, Webentwicklung und h beschreiben

Wie erstelle ich Befehlszeilenschnittstellen (CLIS) mit Python?

Mar 10, 2025 pm 06:48 PM

Wie erstelle ich Befehlszeilenschnittstellen (CLIS) mit Python?

Mar 10, 2025 pm 06:48 PM

Dieser Artikel führt die Python-Entwickler in den Bauen von CLIS-Zeilen-Schnittstellen (CLIS). Es werden mit Bibliotheken wie Typer, Click und ArgParse beschrieben, die Eingabe-/Ausgabemedelung betonen und benutzerfreundliche Designmuster für eine verbesserte CLI-Usabilität fördern.

Wie kann ich die gesamte Spalte eines Datenrahmens effizient in einen anderen Datenrahmen mit verschiedenen Strukturen in Python kopieren?

Apr 01, 2025 pm 11:15 PM

Wie kann ich die gesamte Spalte eines Datenrahmens effizient in einen anderen Datenrahmen mit verschiedenen Strukturen in Python kopieren?

Apr 01, 2025 pm 11:15 PM

Bei der Verwendung von Pythons Pandas -Bibliothek ist das Kopieren von ganzen Spalten zwischen zwei Datenrahmen mit unterschiedlichen Strukturen ein häufiges Problem. Angenommen, wir haben zwei Daten ...

Erklären Sie den Zweck virtueller Umgebungen in Python.

Mar 19, 2025 pm 02:27 PM

Erklären Sie den Zweck virtueller Umgebungen in Python.

Mar 19, 2025 pm 02:27 PM

Der Artikel erörtert die Rolle virtueller Umgebungen in Python und konzentriert sich auf die Verwaltung von Projektabhängigkeiten und die Vermeidung von Konflikten. Es beschreibt ihre Erstellung, Aktivierung und Vorteile bei der Verbesserung des Projektmanagements und zur Verringerung der Abhängigkeitsprobleme.