häufiges Problem

häufiges Problem

Was sind die vier wesentlichen gesunden Menschenverstand für den Einstieg in Big Data?

Was sind die vier wesentlichen gesunden Menschenverstand für den Einstieg in Big Data?

Was sind die vier wesentlichen gesunden Menschenverstand für den Einstieg in Big Data?

Vier wesentliche gesunde Menschenverstand für den Einstieg in Big Data

Eine sehr wichtige Aufgabe für Big-Data-Ingenieure ist pass Analysieren Sie Daten, um Merkmale vergangener Ereignisse zu finden. Das Datenteam von Tencent baut beispielsweise ein Data Warehouse auf, um die großen und unregelmäßigen Dateninformationen auf allen Netzwerkplattformen des Unternehmens zu sortieren und die Merkmale zusammenzufassen, die abgefragt werden können, um den Datenbedarf der verschiedenen Geschäftsbereiche des Unternehmens zu unterstützen, einschließlich Werbeplatzierung. Spieleentwicklung, soziale Netzwerke usw.

1. Fünf grundlegende Aspekte der Big-Data-Analyse

1. Zu den Benutzern der Big-Data-Analyse gehören Experten für Big-Data-Analysen auch normale Benutzer, aber ihre grundlegendste Anforderung für die Big-Data-Analyse ist die visuelle Analyse, da die visuelle Analyse die Merkmale von Big Data intuitiv darstellen kann und vom Leser leicht akzeptiert werden kann, so einfach und klar wie das Sprechen durch Bilder.

2. Data-Mining-Algorithmus

Der theoretische Kern der Big-Data-Analyse ist der Data-Mining-Algorithmus, der auf verschiedenen Datentypen und -formaten basiert, um die Daten selbst wissenschaftlicher darzustellen Gerade weil diese verschiedenen statistischen Methoden (die als Wahrheit bezeichnet werden können) von Statistikern auf der ganzen Welt anerkannt werden, können sie tief in die Daten eindringen und anerkannte Werte ans Licht bringen. Ein weiterer Aspekt besteht darin, dass diese Data-Mining-Algorithmen Big Data schneller verarbeiten können. Wenn ein Algorithmus mehrere Jahre braucht, um zu einem Ergebnis zu gelangen, lässt sich der Wert von Big Data nicht beurteilen.

3. Möglichkeiten der prädiktiven Analyse

Einer der letzten Anwendungsbereiche der Big-Data-Analyse ist die prädiktive Analyse und die wissenschaftliche Etablierung von Modellen, um dann neue Daten einzubringen zukünftige Daten vorhersagen.

4. Semantische Engine

Big-Data-Analyse wird häufig im Netzwerk-Data-Mining verwendet. Sie kann Benutzeranforderungen anhand der Suchschlüsselwörter, Tag-Schlüsselwörter oder anderer Eingabesemantiken analysieren und beurteilen um eine bessere Benutzererfahrung und bessere Werbeanpassung zu erreichen.

5. Datenqualität und Datenmanagement

Big-Data-Analyse ist untrennbar mit Datenqualität und Datenmanagement verbunden, sei es in der akademischen Forschung oder im kommerziellen Anwendungsbereich Stellen Sie sicher, dass die Analyseergebnisse wahr und wertvoll sind. Die Grundlage der Big-Data-Analyse sind die oben genannten fünf Aspekte. Wenn Sie tiefer in die Big-Data-Analyse einsteigen, gibt es natürlich noch viele weitere ausgeprägte, tiefgreifende und professionelle Big-Data-Analysemethoden.

2. So wählen Sie geeignete Datenanalysetools ausUm zu verstehen, welche Daten analysiert werden müssen, gibt es vier Haupttypen von Daten, die in Big Data analysiert werden müssen:

TRANSAKTIONSDATEN

Die Big-Data-Plattform kann immer größere Mengen strukturierter Transaktionsdaten erhalten, sodass ein breiteres Spektrum an Transaktionsdatentypen analysiert werden kann, nicht nur POS- oder E-Commerce-Einkaufsdaten Dazu gehören Verhaltenstransaktionsdaten, wie z. B. von Webservern aufgezeichnete Internet-Clickstream-Datenprotokolle.

VOM MENSCHEN GENERIERTE DATEN

Unstrukturierte Daten kommen häufig in E-Mails, Dokumenten, Bildern, Audios, Videos sowie in Daten vor, die durch Blogs, Wikis und insbesondere in sozialen Medien generiert werden. Diese Daten stellen eine reichhaltige Datenquelle für die Analyse mithilfe von Textanalysefunktionen dar.

MOBILE DATEN

Smartphones und Tablets mit Internetzugang werden immer häufiger eingesetzt. Apps auf diesen Mobilgeräten sind in der Lage, unzählige Ereignisse zu verfolgen und zu kommunizieren, von In-App-Transaktionsdaten (z. B. der Protokollierung einer Suche nach einem Produkt) bis hin zu Profil- oder Statusberichtsereignissen (z. B. einer Standortänderung, die einen neuen Geocode meldet).

MASCHINEN- UND SENSORDATEN

Dazu gehören Daten, die von Funktionsgeräten wie intelligenten Messgeräten, intelligenten Temperaturreglern, Fabrikmaschinen und mit dem Internet verbundenen Haushaltsgeräten erstellt oder generiert werden. Diese Geräte können für die Kommunikation mit anderen Knoten im Internetnetzwerk konfiguriert werden und können auch automatisch Daten an einen zentralen Server übertragen, damit die Daten analysiert werden können. Maschinen- und Sensordaten sind Paradebeispiele für das entstehende Internet der Dinge (IoT). Daten aus dem IoT können verwendet werden, um analytische Modelle zu erstellen, das prädiktive Verhalten kontinuierlich zu überwachen (z. B. um zu erkennen, wann Sensorwerte auf ein Problem hinweisen) und vorgeschriebene Anweisungen bereitzustellen (z. B. um Techniker zu warnen, Geräte zu überprüfen, bevor ein tatsächliches Problem auftritt).

Verwandte Empfehlungen: „

FAQ3. Wie man drei beliebte Big-Data-Berufe unterscheidet – Datenwissenschaftler, Dateningenieure und DatenanalystenDa Big Data immer beliebter wird, erfreuen sich auch Karrieren im Zusammenhang mit Big Data wachsender Beliebtheit und bieten viele Möglichkeiten zur Talententwicklung. Datenwissenschaftler, Dateningenieure und Datenanalysten sind zu den beliebtesten Positionen in der Big-Data-Branche geworden. Wie sind sie definiert? Was genau ist nötig? Welche Fähigkeiten sind erforderlich?

Wie sind diese drei Berufe positioniert?

Was für ein Dasein führt ein DatenwissenschaftlerDatenwissenschaftler beziehen sich auf Ingenieure oder Ingenieure, die wissenschaftliche Methoden und Data-Mining-Tools verwenden können, um komplexe und große Mengen an Zahlen, Symbolen, Texten, URLs, Audio- oder Videoinformationen digital zu reproduzieren und zu verstehen und neue Datenerkenntnisse zu gewinnen (anders als Statistiker oder Analyst). Wie wird ein Dateningenieur definiert? Ein Dateningenieur wird im Allgemeinen als „Star-Software-Ingenieur mit einem tiefen Verständnis für das Thema Statistik“ definiert. Wenn Sie mit einem geschäftlichen Problem zu kämpfen haben, benötigen Sie einen Dateningenieur. Ihr zentraler Wert liegt in ihrer Fähigkeit, Datenpipelines aus sauberen Daten zu erstellen. Ein umfassendes Verständnis von Dateisystemen, verteiltem Rechnen und Datenbanken sind notwendige Fähigkeiten, um ein ausgezeichneter Dateningenieur zu werden. Dateningenieure haben ein ziemlich gutes Verständnis von Algorithmen. Daher sollten Dateningenieure in der Lage sein, grundlegende Datenmodelle auszuführen. Die anspruchsvollen Geschäftsanforderungen haben zu einem Bedarf an hochkomplexen Berechnungen geführt. Oft übersteigen diese Anforderungen das Wissen des Dateningenieurs. Zu diesem Zeitpunkt müssen Sie einen Datenwissenschaftler um Hilfe bitten. Wie man Datenanalysten versteht Datenanalysten beziehen sich auf Personen in verschiedenen Branchen, die sich auf das Sammeln, Organisieren und Analysieren von Branchendaten sowie das Treffen von Branchenentscheidungen auf der Grundlage der Daten spezialisiert haben Fachleute, die recherchieren, bewerten und Prognosen erstellen. Sie wissen, wie man die richtigen Fragen stellt und sind sehr gut in der Datenanalyse, Datenvisualisierung und Datenpräsentation. Was sind die spezifischen Aufgaben dieser drei Berufe? Datenwelt. Um eine große Menge verstreuter Daten in strukturierte Daten umzuwandeln, die analysiert werden können, ist es außerdem notwendig, umfangreiche Datenquellen zu finden, andere möglicherweise unvollständige Datenquellen zu integrieren und den resultierenden Datensatz zu bereinigen. Im neuen Wettbewerbsumfeld ändern sich die Herausforderungen ständig und es fließen ständig neue Daten ein. Datenwissenschaftler müssen Entscheidungsträgern dabei helfen, verschiedene Analysen durchzuführen, von der temporären Datenanalyse bis hin zur kontinuierlichen Dateninteraktionsanalyse. Wenn sie Entdeckungen machen, kommunizieren sie ihre Erkenntnisse und schlagen neue Geschäftsrichtungen vor. Sie präsentieren visuelle Informationen kreativ und machen die Muster, die sie finden, klar und überzeugend. Schlagen Sie dem Chef die in den Daten enthaltenen Muster vor, um Produkte, Prozesse und Entscheidungen zu beeinflussen. Aufgabenbereiche von Dateningenieuren Historie analysieren, die Zukunft vorhersagen und Entscheidungen optimieren sind die drei wichtigsten Aufgaben von Big-Data-Ingenieuren beim „Spielen mit Daten“. Durch diese drei Arbeitsbereiche helfen sie Unternehmen, bessere Geschäftsentscheidungen zu treffen. Eine sehr wichtige Aufgabe von Big-Data-Ingenieuren besteht darin, durch die Analyse von Daten die Merkmale vergangener Ereignisse herauszufinden. Das Datenteam von Tencent baut beispielsweise ein Data Warehouse auf, um die großen und unregelmäßigen Dateninformationen auf allen Netzwerkplattformen des Unternehmens zu sortieren und die Merkmale zusammenzufassen, die abgefragt werden können, um den Datenbedarf der verschiedenen Geschäftsbereiche des Unternehmens zu unterstützen, einschließlich Werbeplatzierung. Spieleentwicklung, soziale Netzwerke usw. Die wichtigste Rolle bei der Ermittlung der Merkmale vergangener Ereignisse besteht darin, Unternehmen dabei zu helfen, die Verbraucher besser zu verstehen. Durch die Analyse des bisherigen Verhaltensverlaufs des Benutzers können Sie diese Person verstehen und ihr Verhalten vorhersagen. Durch die Einführung von Schlüsselfaktoren können Big-Data-Ingenieure zukünftige Verbrauchstrends vorhersagen. Auf der Marketingplattform von Alimama versuchen Ingenieure, Taobao-Verkäufern durch die Bereitstellung von Wetterdaten bei der Geschäftsabwicklung zu helfen. Wenn beispielsweise dieser Sommer nicht heiß ist, ist es sehr wahrscheinlich, dass sich bestimmte Produkte nicht so gut verkaufen wie letztes Jahr. Neben Klimaanlagen und Ventilatoren können auch Westen, Badeanzüge usw. betroffen sein. Anschließend stellen wir die Beziehung zwischen Wetterdaten und Verkaufsdaten her, finden verwandte Kategorien und benachrichtigen die Verkäufer im Voraus, um den Lagerbestand umzutauschen. Abhängig von der Geschäftsnatur verschiedener Unternehmen können Big-Data-Ingenieure durch Datenanalyse unterschiedliche Ziele erreichen. Für Tencent ist das einfachste und direkteste Beispiel, das die Arbeit von Big-Data-Ingenieuren widerspiegelt, der Optionstest (AB-Test), der Produktmanagern hilft, zwischen den Alternativen A und B zu wählen. In der Vergangenheit konnten Entscheidungsträger nur auf der Grundlage von Erfahrungen urteilen, doch jetzt können Big-Data-Ingenieure Echtzeittests in großem Maßstab durchführen – beispielsweise im Beispiel von Produkten für soziale Netzwerke, sodass die Hälfte der Benutzer die Schnittstelle A und sehen kann Die andere Hälfte nutzt Schnittstelle B und beobachtet Statistiken über Klickraten und Konversionsraten über einen bestimmten Zeitraum hinweg, um der Marketingabteilung bei der endgültigen Entscheidung zu helfen. Das Internet selbst zeichnet sich durch Digitalisierung und Interaktivität aus und hat zu einem Durchbruch bei der Datenerfassung, -organisation und -forschung geführt. In der Vergangenheit mussten Datenanalysten in der „atomaren Welt“ höhere Kosten (Mittel, Ressourcen und Zeit) aufwenden, um Daten zur Unterstützung von Forschung und Analyse zu erhalten. Der Reichtum, die Vollständigkeit, die Kontinuität und die Aktualität der Daten waren viel schlechter als im Internet Epoche. Im Vergleich zu herkömmlichen Datenanalysten sind Datenanalysten im Internetzeitalter nicht mit einem Datenmangel, sondern mit einem Datenüberschuss konfrontiert. Daher müssen Datenanalysten im Internetzeitalter lernen, mit technischen Mitteln eine effiziente Datenverarbeitung durchzuführen. Noch wichtiger ist, dass Datenanalysten im Internetzeitalter weiterhin Innovationen vorantreiben und Durchbrüche bei Datenforschungsmethoden erzielen müssen. In Bezug auf die Branche ist der Wert von Datenanalysten ähnlich. Was die Nachrichtenverlagsbranche betrifft, ist unabhängig von der Epoche der Schlüssel zum Erfolg oder Misserfolg der Medien, ob Medienbetreiber die Situation des Publikums und sich ändernde Trends genau, detailliert und zeitnah verstehen können. Darüber hinaus ist es für Content-Branchen wie Nachrichten und Verlagswesen noch wichtiger, dass Datenanalysten die Rolle der Content-Konsumentendatenanalyse übernehmen können, was eine Schlüsselfunktion zur Unterstützung von Nachrichten- und Verlagsorganisationen bei der Kundenverbesserung darstellt Service. Welche Fähigkeiten müssen Sie beherrschen, um diese drei Berufe ausüben zu können? Fähigkeiten, die Datenwissenschaftler beherrschen müssen 1, Computer Wissenschaft Im Allgemeinen wird von Datenwissenschaftlern meist ein beruflicher Hintergrund in den Bereichen Programmierung und Informatik verlangt. Einfach ausgedrückt sind es die Fähigkeiten im Zusammenhang mit groß angelegten Parallelverarbeitungstechnologien wie Hadoop und Mahout und maschinellem Lernen, die für die Verarbeitung großer Datenmengen erforderlich sind. 2. Mathematik, Statistik, Data Mining usw. Zusätzlich zu den Kenntnissen in Mathematik und Statistik müssen Sie auch über die Fähigkeiten verfügen, gängige statistische Analysesoftware wie SPSS und SAS zu verwenden . Unter ihnen haben die Open-Source-Programmiersprache und ihre Betriebsumgebung „R“ für statistische Analysen in letzter Zeit große Aufmerksamkeit erregt. Die Stärke von R liegt nicht nur darin, dass es eine umfangreiche statistische Analysebibliothek enthält, sondern auch über hochwertige Diagrammerstellungsfunktionen zur Visualisierung von Ergebnissen verfügt, die über einfache Befehle ausgeführt werden können. Darüber hinaus verfügt es über einen Paketerweiterungsmechanismus namens CRAN (The Comprehensive R Archive Network). Durch den Import des Erweiterungspakets können Sie Funktionen und Datensätze verwenden, die im Standardzustand nicht unterstützt werden. 3. Datenvisualisierung (Visualisierung) Die Qualität der Informationen hängt weitgehend von ihrer Ausdrucksweise ab. Für Datenwissenschaftler ist es sehr wichtig, die Bedeutung der aus numerischen Listen zusammengesetzten Daten zu analysieren, Web-Prototypen zu entwickeln und externe APIs zu verwenden, um Diagramme, Karten, Dashboards und andere Dienste zu vereinheitlichen, um die Analyseergebnisse zu visualisieren. Fähigkeiten, die Dateningenieure beherrschen müssen 1. Mathematik- und Statistik-Hintergrund Die Anforderungen an Big-Data-Ingenieure bestehen darin, dass sie über einen Hintergrund in Statistik verfügen und Mathematik. Datenarbeiter, denen es an theoretischem Hintergrund mangelt, geraten eher in eine technische Gefahrenzone (Gefahrenzone) – eine Reihe von Zahlen kann nach verschiedenen Datenmodellen und Algorithmen immer zu einigen Ergebnissen führen, aber wenn Sie nicht wissen, was sie bedeuten, ist es so Dies ist kein wirklich aussagekräftiges Ergebnis, und ein solches Ergebnis kann Sie leicht in die Irre führen. Nur mit bestimmten theoretischen Kenntnissen können wir Modelle verstehen, Modelle wiederverwenden und sogar Modelle erneuern, um praktische Probleme zu lösen. 2. Computerprogrammierungsfähigkeiten Tatsächliche Entwicklungsfähigkeiten und umfangreiche Datenverarbeitungsfähigkeiten sind einige wesentliche Elemente für einen Big-Data-Ingenieur. Da der Wert vieler Daten aus dem Prozess des Goldabbaus stammt, müssen Sie ihn selbst durchführen, um den Wert von Gold herauszufinden. Beispielsweise sind viele von Menschen in sozialen Netzwerken erstellte Daten mittlerweile unstrukturierte Daten. Um aus diesen ahnungslosen Texten, Stimmen, Bildern und sogar Videos aussagekräftige Informationen zu extrahieren, müssen Big-Data-Ingenieure diese selbst herausfinden. Selbst in einigen Teams sind Big-Data-Ingenieure hauptsächlich für Geschäftsanalysen zuständig, müssen aber auch mit der Art und Weise vertraut sein, wie Computer Big Data verarbeiten. 3. Kenntnisse über bestimmte Anwendungsfelder oder Branchen Ein sehr wichtiger Punkt bei der Rolle des Big-Data-Ingenieurs ist, dass er nicht vom Markt getrennt werden kann, da Big Data nur generiert werden kann, wenn kombiniert mit Anwendungen in bestimmten Bereichen Wert. Daher kann Erfahrung in einer oder mehreren vertikalen Branchen den Kandidaten dabei helfen, Kenntnisse über die Branche zu sammeln, was bei der künftigen Karriere als Big-Data-Ingenieur von großem Nutzen sein wird. Daher ist dies auch ein überzeugenderer Bonus bei der Bewerbung für diese Position. C. Fähigkeiten, die Datenanalysten beherrschen müssen 1. Voraussetzung für die Arbeit an der Datenanalyse ist, dass Sie das Geschäft verstehen, also mit Branchenkenntnissen, Unternehmensgeschäften und -prozessen vertraut sind. Am besten verfügen Sie über eigene, einzigartige Erkenntnisse, wenn Sie über Branchenkenntnisse und den geschäftlichen Hintergrund des Unternehmens verfügen , die Ergebnisse der Analyse sind nur offline verfügbar. Drachen haben keinen großen Nutzwert. 2. Management verstehen. Einerseits ist es erforderlich, ein Datenanalyse-Framework zu erstellen. Um beispielsweise die Analyseideen zu ermitteln, müssen Sie sich an Marketing-, Management- und anderen theoretischen Kenntnissen orientieren Es wird schwierig sein, ein Datenanalyse-Framework aufzubauen, und die anschließende Datenanalyse wird ebenfalls schwierig durchzuführen sein. Andererseits besteht die Aufgabe darin, lehrreiche Analysevorschläge auf der Grundlage der Schlussfolgerungen der Datenanalyse bereitzustellen. 3. Analyse verstehen. Dabei geht es darum, die Grundprinzipien der Datenanalyse und einige effektive Datenanalysemethoden zu beherrschen und diese flexibel in der Praxis anwenden zu können, um eine Datenanalyse effektiv durchzuführen. Zu den grundlegenden Analysemethoden gehören: Vergleichsanalyse, Gruppenanalyse, Kreuzanalyse, Strukturanalyse, Trichterdiagrammanalyse, umfassende Bewertungsanalyse, Faktoranalyse, Matrixkorrelationsanalyse usw. Zu den erweiterten Analysemethoden gehören: Korrelationsanalyse, Regressionsanalyse, Clusteranalyse, Diskriminanzanalyse, Hauptkomponentenanalyse, Faktoranalyse, Korrespondenzanalyse, Zeitreihen usw. 4. Werkzeuge verstehen. Bezieht sich auf die Beherrschung gängiger Tools im Zusammenhang mit der Datenanalyse. Datenanalysemethoden sind Theorien, und Datenanalysetools sind Werkzeuge zur Umsetzung der Theorie von Datenanalysemethoden. Angesichts immer größerer Datenmengen können wir uns bei der Analyse nicht auf leistungsstarke Datenanalysetools verlassen Analysearbeit. 5. Design verstehen. Design zu verstehen bedeutet, Diagramme zu verwenden, um die analytischen Ansichten des Datenanalysten effektiv auszudrücken, sodass die Analyseergebnisse auf einen Blick klar sind. Die Gestaltung von Diagrammen ist ein wichtiges Thema, wie z. B. die Auswahl von Grafiken, Layoutgestaltung, Farbabstimmung usw., die alle die Beherrschung bestimmter Gestaltungsprinzipien erfordern. Ein 9-stufiger Entwicklungsplan, um von einem Anfänger zum Datenwissenschaftler zu werden Zunächst einmal hat jedes Unternehmen unterschiedliche Definitionen von Datenwissenschaftlern, und das gibt es derzeit keine einheitliche Definition. Aber im Allgemeinen kombiniert ein Datenwissenschaftler die Fähigkeiten eines Softwareentwicklers mit denen eines Statistikers und verfügt über umfangreiche Branchenkenntnisse in dem Bereich, in dem er oder sie arbeiten möchte. Ungefähr 90 % der Datenwissenschaftler haben mindestens eine Hochschulausbildung und sogar einen Doktortitel, und natürlich sind die Bereiche, in denen sie ihre Abschlüsse erwerben, sehr breit gefächert. Einige Personalvermittler sind sogar der Meinung, dass Geisteswissenschaftler über die nötige Kreativität verfügen, um anderen wichtige Fähigkeiten beizubringen. Welche Schritte müssen Sie unternehmen, um Datenwissenschaftler zu werden, abgesehen von einem Datenwissenschaftsstudiengang (der an renommierten Universitäten auf der ganzen Welt wie Pilze aus dem Boden schießt)? >Überprüfen Sie Ihre mathematischen und statistischen Fähigkeiten Ein guter Datenwissenschaftler muss in der Lage sein zu verstehen, was die Daten Ihnen sagen, und um dies zu tun, müssen Sie über ein solides Verständnis der grundlegenden linearen Algebra verfügen, ein Verständnis von Algorithmen und statistische Fähigkeiten. In bestimmten Situationen sind möglicherweise fortgeschrittene Mathematikkenntnisse erforderlich, aber dies ist ein guter Anfang. Verstehen Sie das Konzept des maschinellen Lernens Maschinelles Lernen ist das nächste aufkommende Wort, aber es ist untrennbar mit Big Data verbunden. Maschinelles Lernen nutzt Algorithmen der künstlichen Intelligenz, um Daten ohne explizite Programmierung in Werte umzuwandeln. Programmieren lernen Ein Datenwissenschaftler muss wissen, wie man den Code optimiert, um dem Computer mitzuteilen, wie er die Daten analysieren soll. Beginnen Sie mit einer Open-Source-Sprache wie Python. Datenbanken, Datenpools und verteilte Speicherung verstehen Daten werden in Datenbanken, Datenpools oder ganzen verteilten Netzwerken gespeichert. Und wie Sie ein Repository dieser Daten erstellen, hängt davon ab, wie Sie auf diese Daten zugreifen, sie verwenden und analysieren. Wenn Sie beim Aufbau Ihres Datenspeichers nicht über eine Gesamtarchitektur oder Vorplanung verfügen, werden die Folgen für Sie gravierend sein. Erlernen Sie Datenmodifikations- und Datenbereinigungstechniken Datenmodifikation ist der Prozess der Konvertierung von Rohdaten in ein anderes Format, das leichter zugänglich und einfacher zu analysieren ist. Durch die Datenbereinigung werden doppelte und „schlechte“ Daten beseitigt. Beides sind wesentliche Werkzeuge im Werkzeugkasten eines Datenwissenschaftlers. Lernen Sie die Grundlagen einer guten Datenvisualisierung und Berichterstattung Sie müssen kein Grafikdesigner sein, aber Sie müssen ein solides Verständnis dafür haben Erstellen Sie Datenberichte, die auch für Laien zugänglich sind, die Menschen wie Ihr Manager oder CEO verstehen können. Fügen Sie Ihrer Toolbox weitere Tools hinzu Sobald Sie die oben genannten Fähigkeiten beherrschen, ist es an der Zeit, Ihre Data-Science-Toolbox um Hadoop, R Language und Spark zu erweitern. Mit der Erfahrung und dem Wissen im Umgang mit diesen Tools heben Sie sich von der Masse der Datenwissenschafts-Arbeitssuchenden ab. Üben Wie übt man als Datenwissenschaftler, bevor man einen Job in einem neuen Bereich bekommt? Verwenden Sie Open-Source-Code, um ein Projekt zu entwickeln, das Ihnen gefällt, und nehmen Sie an Wettbewerben teil , Werden Sie Web-Job-Datenwissenschaftler, nehmen Sie an einem Bootcamp teil, melden Sie sich ehrenamtlich oder als Praktikant. Die besten Datenwissenschaftler verfügen über Erfahrung und Intuition im Datenbereich und können ihre Arbeit unter Beweis stellen, um Kandidaten zu werden. Werden Sie Mitglied der Community Folgen Sie Vordenkern in Ihrer Branche, lesen Sie Branchenblogs und Websites, engagieren Sie sich, stellen Sie Fragen und bleiben Sie über aktuelle Nachrichten und Theorien auf dem Laufenden .

Das obige ist der detaillierte Inhalt vonWas sind die vier wesentlichen gesunden Menschenverstand für den Einstieg in Big Data?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1375

1375

52

52

Ein Diffusionsmodell-Tutorial, das Ihre Zeit wert ist, von der Purdue University

Apr 07, 2024 am 09:01 AM

Ein Diffusionsmodell-Tutorial, das Ihre Zeit wert ist, von der Purdue University

Apr 07, 2024 am 09:01 AM

Diffusion kann nicht nur besser imitieren, sondern auch „erschaffen“. Das Diffusionsmodell (DiffusionModel) ist ein Bilderzeugungsmodell. Im Vergleich zu bekannten Algorithmen wie GAN und VAE im Bereich der KI verfolgt das Diffusionsmodell einen anderen Ansatz. Seine Hauptidee besteht darin, dem Bild zunächst Rauschen hinzuzufügen und es dann schrittweise zu entrauschen. Das Entrauschen und Wiederherstellen des Originalbilds ist der Kernbestandteil des Algorithmus. Der endgültige Algorithmus ist in der Lage, aus einem zufälligen verrauschten Bild ein Bild zu erzeugen. In den letzten Jahren hat das phänomenale Wachstum der generativen KI viele spannende Anwendungen in der Text-zu-Bild-Generierung, Videogenerierung und mehr ermöglicht. Das Grundprinzip dieser generativen Werkzeuge ist das Konzept der Diffusion, ein spezieller Sampling-Mechanismus, der die Einschränkungen bisheriger Methoden überwindet.

Generieren Sie PPT mit einem Klick! Kimi: Lassen Sie zuerst die „PPT-Wanderarbeiter' populär werden

Aug 01, 2024 pm 03:28 PM

Generieren Sie PPT mit einem Klick! Kimi: Lassen Sie zuerst die „PPT-Wanderarbeiter' populär werden

Aug 01, 2024 pm 03:28 PM

Kimi: In nur einem Satz, in nur zehn Sekunden ist ein PPT fertig. PPT ist so nervig! Um ein Meeting abzuhalten, benötigen Sie einen PPT; um einen wöchentlichen Bericht zu schreiben, müssen Sie einen PPT vorlegen, auch wenn Sie jemanden des Betrugs beschuldigen PPT. Das College ähnelt eher dem Studium eines PPT-Hauptfachs. Man schaut sich PPT im Unterricht an und macht PPT nach dem Unterricht. Als Dennis Austin vor 37 Jahren PPT erfand, hatte er vielleicht nicht damit gerechnet, dass PPT eines Tages so weit verbreitet sein würde. Wenn wir über unsere harte Erfahrung bei der Erstellung von PPT sprechen, treiben uns Tränen in die Augen. „Es dauerte drei Monate, ein PPT mit mehr als 20 Seiten zu erstellen, und ich habe es Dutzende Male überarbeitet. Als ich das PPT sah, musste ich mich übergeben.“ war PPT.“ Wenn Sie ein spontanes Meeting haben, sollten Sie es tun

PHPs Fähigkeiten zur Verarbeitung von Big-Data-Strukturen

May 08, 2024 am 10:24 AM

PHPs Fähigkeiten zur Verarbeitung von Big-Data-Strukturen

May 08, 2024 am 10:24 AM

Fähigkeiten zur Verarbeitung von Big-Data-Strukturen: Chunking: Teilen Sie den Datensatz auf und verarbeiten Sie ihn in Blöcken, um den Speicherverbrauch zu reduzieren. Generator: Generieren Sie Datenelemente einzeln, ohne den gesamten Datensatz zu laden, geeignet für unbegrenzte Datensätze. Streaming: Lesen Sie Dateien oder fragen Sie Ergebnisse Zeile für Zeile ab, geeignet für große Dateien oder Remote-Daten. Externer Speicher: Speichern Sie die Daten bei sehr großen Datensätzen in einer Datenbank oder NoSQL.

Alle CVPR 2024-Auszeichnungen bekannt gegeben! Fast 10.000 Menschen nahmen offline an der Konferenz teil und ein chinesischer Forscher von Google gewann den Preis für den besten Beitrag

Jun 20, 2024 pm 05:43 PM

Alle CVPR 2024-Auszeichnungen bekannt gegeben! Fast 10.000 Menschen nahmen offline an der Konferenz teil und ein chinesischer Forscher von Google gewann den Preis für den besten Beitrag

Jun 20, 2024 pm 05:43 PM

Am frühen Morgen des 20. Juni (Pekinger Zeit) gab CVPR2024, die wichtigste internationale Computer-Vision-Konferenz in Seattle, offiziell die besten Beiträge und andere Auszeichnungen bekannt. In diesem Jahr wurden insgesamt 10 Arbeiten ausgezeichnet, darunter zwei beste Arbeiten und zwei beste studentische Arbeiten. Darüber hinaus gab es zwei Nominierungen für die beste Arbeit und vier Nominierungen für die beste studentische Arbeit. Die Top-Konferenz im Bereich Computer Vision (CV) ist die CVPR, die jedes Jahr zahlreiche Forschungseinrichtungen und Universitäten anzieht. Laut Statistik wurden in diesem Jahr insgesamt 11.532 Arbeiten eingereicht, von denen 2.719 angenommen wurden, was einer Annahmequote von 23,6 % entspricht. Laut der statistischen Analyse der CVPR2024-Daten des Georgia Institute of Technology befassen sich die meisten Arbeiten aus Sicht der Forschungsthemen mit der Bild- und Videosynthese und -generierung (Imageandvideosyn

Von Bare-Metal bis hin zu einem großen Modell mit 70 Milliarden Parametern finden Sie hier ein Tutorial und gebrauchsfertige Skripte

Jul 24, 2024 pm 08:13 PM

Von Bare-Metal bis hin zu einem großen Modell mit 70 Milliarden Parametern finden Sie hier ein Tutorial und gebrauchsfertige Skripte

Jul 24, 2024 pm 08:13 PM

Wir wissen, dass LLM auf großen Computerclustern unter Verwendung umfangreicher Daten trainiert wird. Auf dieser Website wurden viele Methoden und Technologien vorgestellt, die den LLM-Trainingsprozess unterstützen und verbessern. Was wir heute teilen möchten, ist ein Artikel, der tief in die zugrunde liegende Technologie eintaucht und vorstellt, wie man einen Haufen „Bare-Metals“ ohne Betriebssystem in einen Computercluster für das LLM-Training verwandelt. Dieser Artikel stammt von Imbue, einem KI-Startup, das allgemeine Intelligenz durch das Verständnis der Denkweise von Maschinen erreichen möchte. Natürlich ist es kein einfacher Prozess, einen Haufen „Bare Metal“ ohne Betriebssystem in einen Computercluster für das Training von LLM zu verwandeln, aber Imbue hat schließlich erfolgreich ein LLM mit 70 Milliarden Parametern trainiert der Prozess akkumuliert

Fünf große Entwicklungstrends in der AEC/O-Branche im Jahr 2024

Apr 19, 2024 pm 02:50 PM

Fünf große Entwicklungstrends in der AEC/O-Branche im Jahr 2024

Apr 19, 2024 pm 02:50 PM

AEC/O (Architecture, Engineering & Construction/Operation) bezieht sich auf die umfassenden Dienstleistungen, die Architekturdesign, Ingenieurdesign, Bau und Betrieb in der Bauindustrie anbieten. Im Jahr 2024 steht die AEC/O-Branche angesichts des technologischen Fortschritts vor sich ändernden Herausforderungen. In diesem Jahr wird voraussichtlich die Integration fortschrittlicher Technologien stattfinden, was einen Paradigmenwechsel in Design, Bau und Betrieb einläuten wird. Als Reaktion auf diese Veränderungen definieren Branchen Arbeitsprozesse neu, passen Prioritäten an und verbessern die Zusammenarbeit, um sich an die Bedürfnisse einer sich schnell verändernden Welt anzupassen. Die folgenden fünf großen Trends in der AEC/O-Branche werden im Jahr 2024 zu Schlüsselthemen und empfehlen den Weg in eine stärker integrierte, reaktionsfähigere und nachhaltigere Zukunft: integrierte Lieferkette, intelligente Fertigung

KI im Einsatz |. AI hat einen Lebens-Vlog eines allein lebenden Mädchens erstellt, der innerhalb von drei Tagen Zehntausende Likes erhielt

Aug 07, 2024 pm 10:53 PM

KI im Einsatz |. AI hat einen Lebens-Vlog eines allein lebenden Mädchens erstellt, der innerhalb von drei Tagen Zehntausende Likes erhielt

Aug 07, 2024 pm 10:53 PM

Herausgeber des Machine Power Report: Yang Wen Die Welle der künstlichen Intelligenz, repräsentiert durch große Modelle und AIGC, hat unsere Lebens- und Arbeitsweise still und leise verändert, aber die meisten Menschen wissen immer noch nicht, wie sie sie nutzen sollen. Aus diesem Grund haben wir die Kolumne „KI im Einsatz“ ins Leben gerufen, um detailliert vorzustellen, wie KI durch intuitive, interessante und prägnante Anwendungsfälle für künstliche Intelligenz genutzt werden kann, und um das Denken aller anzuregen. Wir heißen Leser auch willkommen, innovative, praktische Anwendungsfälle einzureichen. Videolink: https://mp.weixin.qq.com/s/2hX_i7li3RqdE4u016yGhQ Vor kurzem wurde der Lebens-Vlog eines allein lebenden Mädchens auf Xiaohongshu populär. Eine Animation im Illustrationsstil, gepaart mit ein paar heilenden Worten, kann in nur wenigen Tagen leicht erlernt werden.

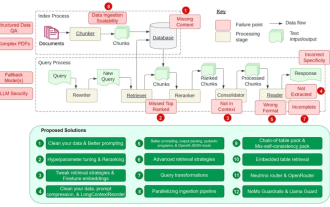

Der leitende NVIDIA-Architekt zählt die 12 Schwachstellen von RAG auf und vermittelt Lösungen

Jul 11, 2024 pm 01:53 PM

Der leitende NVIDIA-Architekt zählt die 12 Schwachstellen von RAG auf und vermittelt Lösungen

Jul 11, 2024 pm 01:53 PM

Retrieval-Augmented Generation (RAG) ist eine Technik, die Retrieval nutzt, um Sprachmodelle zu verbessern. Bevor ein Sprachmodell eine Antwort generiert, ruft es insbesondere relevante Informationen aus einer umfangreichen Dokumentendatenbank ab und verwendet diese Informationen dann zur Steuerung des Generierungsprozesses. Diese Technologie kann die Genauigkeit und Relevanz von Inhalten erheblich verbessern, das Problem der Halluzinationen wirksam lindern, die Geschwindigkeit der Wissensaktualisierung erhöhen und die Nachverfolgbarkeit der Inhaltsgenerierung verbessern. RAG ist zweifellos einer der spannendsten Bereiche der Forschung im Bereich der künstlichen Intelligenz. Weitere Informationen zu RAG finden Sie im Kolumnenartikel auf dieser Website „Was sind die neuen Entwicklungen bei RAG, das sich darauf spezialisiert hat, die Mängel großer Modelle auszugleichen?“ Diese Rezension erklärt es deutlich. Aber RAG ist nicht perfekt und Benutzer stoßen bei der Verwendung oft auf einige „Problempunkte“. Kürzlich die fortschrittliche generative KI-Lösung von NVIDIA