Was bedeutet Apache Spark?

Apache Spark ist eine leistungsstarke Open-Source-Verarbeitungs-Engine, die ursprünglich von Matei Zaharia entwickelt wurde Entwickelt im Rahmen seiner Doktorarbeit an der University of California, Berkeley. Die erste Version von Spark wurde 2012 veröffentlicht.

Apache Spark ist ein schnelles, benutzerfreundliches Framework, mit dem Sie eine Vielzahl komplexer Datenprobleme lösen können, unabhängig davon, ob es sich um halbstrukturierte, strukturierte, Streaming- oder maschinelles Lernen oder Datenwissenschaft handelt. Mit mehr als 1.000 Mitwirkenden aus mehr als 250 Organisationen und mehr als 300.000 Spark Meetup-Community-Mitgliedern an mehr als 570 Standorten auf der ganzen Welt hat es sich außerdem zu einer der größten Open-Source-Communitys im Bereich Big Data entwickelt.

Was ist Apache Spark?

Apache Spark ist eine Open-Source-, leistungsstarke, verteilte Abfrage- und Verarbeitungs-Engine. Es bietet die Flexibilität und Skalierbarkeit von MapReduce, jedoch bei deutlich höheren Geschwindigkeiten: Es ist 100-mal schneller als Apache Hadoop, wenn Daten im Speicher gespeichert werden, und bis zu 10-mal schneller beim Zugriff auf die Festplatte.

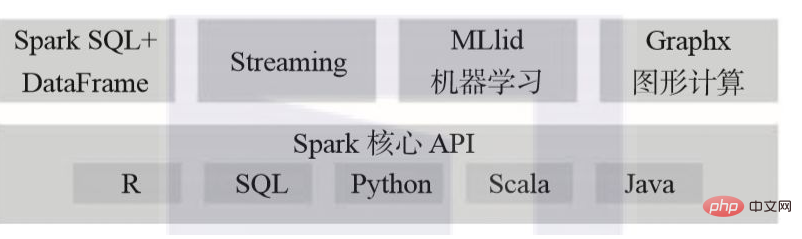

Apache Spark ermöglicht Benutzern das Lesen, Transformieren, Aggregieren von Daten sowie das einfache Trainieren und Bereitstellen komplexer statistischer Modelle. Java, Scala, Python, R und SQL haben alle Zugriff auf die Spark-API.

Apache Spark kann zum Erstellen von Anwendungen verwendet werden, die entweder als Bibliotheken zur Bereitstellung in einem Cluster verpackt oder interaktiv über Notebooks wie Jupyter, Spark-Notebook, Databricks-Notebooks und Apache Zeppelin Quick Analysis ausgeführt werden.

Apache Spark bietet viele Bibliotheken, die Datenanalysten, Datenwissenschaftlern oder Forschern vertraut sein werden, die Pythons Pandas oder data.frame oder data.tables der R-Sprache verwendet haben. Es ist sehr wichtig zu beachten, dass Spark DataFrame zwar den Benutzern von pandas oder data.frame und data.tables bekannt vorkommt, es aber dennoch einige Unterschiede gibt, also erwarten Sie nicht zu viel. Benutzer mit mehr SQL-Hintergrund können die Sprache auch zum Formen ihrer Daten verwenden.

Darüber hinaus bietet Apache Spark mehrere bereits implementierte und abgestimmte Algorithmen, statistische Modelle und Frameworks: MLlib und ML für maschinelles Lernen, GraphX und GraphFrames für die Diagrammverarbeitung sowie Spark Streaming (DStream und Structured). Mit Spark können Benutzer diese Bibliotheken in derselben Anwendung frei kombinieren.

Apache Spark läuft bequem auf einem lokalen Laptop und kann problemlos im Standalone-Modus auf einem lokalen Cluster oder in der Cloud über YARN oder Apache Mesos bereitgestellt werden. Es kann aus verschiedenen Datenquellen lesen und schreiben, einschließlich (aber nicht beschränkt auf) HDFS, Apache Cassandra, Apache HBase und S3:

Das obige ist der detaillierte Inhalt vonApache Spark, was bedeutet das?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!