Word2Vector-Prinzip

Das Abbilden eines Wortes in einem neuen Raum und dessen Darstellung als mehrdimensionaler kontinuierlicher reeller Vektor wird als „Wortdarstellung“ oder „Worteinbettung“ bezeichnet.

Seit dem 21. Jahrhundert sind die Menschen schrittweise von der ursprünglichen spärlichen Darstellung von Wortvektoren zur aktuellen dichten Darstellung im niedrigdimensionalen Raum übergegangen.

Die Verwendung einer spärlichen Darstellung stößt bei der Lösung praktischer Probleme häufig auf den Fluch der Dimensionalität, und semantische Informationen können nicht dargestellt und mögliche Verbindungen zwischen Wörtern nicht aufgedeckt werden.

Die Verwendung einer niedrigdimensionalen Raumdarstellung löst nicht nur das Problem der Dimensionalitätskatastrophe, sondern untersucht auch die zugehörigen Attribute zwischen Wörtern und verbessert so die Genauigkeit der Vektorsemantik.

word2vec-Lernaufgabe

Angenommen, es gibt einen solchen Satz: Heute um 14 Uhr nachmittags hält die Suchmaschinengruppe ein Gruppentreffen ab .

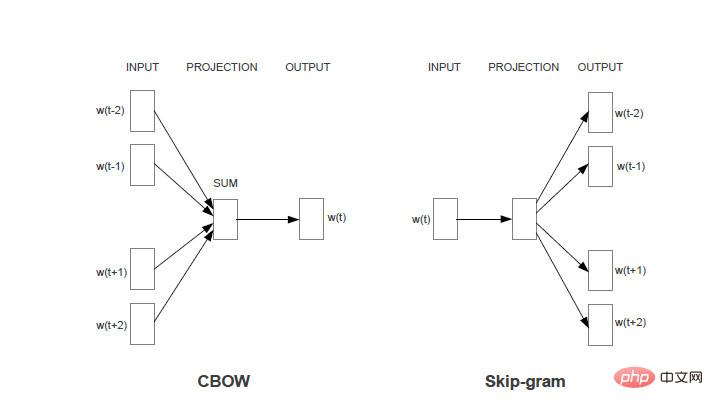

Aufgabe 1: Verwenden Sie für jedes Wort die Wörter, die das Wort umgeben, um die Wahrscheinlichkeit der Generierung des aktuellen Wortes vorherzusagen. Verwenden Sie beispielsweise „heute, Nachmittag, Suche, Suchmaschine, Gruppe“, um „2 Uhr“ zu generieren.

Aufgabe 2: Verwenden Sie für jedes Wort das Wort selbst, um die Wahrscheinlichkeit der Generierung anderer Wörter vorherzusagen. Verwenden Sie beispielsweise „2 Uhr“, um jedes Wort in „heute, nachmittag, Suche, Suchmaschine, Gruppe“ zu generieren.

Die gemeinsame Einschränkung beider Aufgaben ist: Für die gleiche Eingabe beträgt die Summe der Wahrscheinlichkeiten für die Ausgabe jedes Wortes 1.

Das Word2vec-Modell ist eine Möglichkeit, die Genauigkeit der oben genannten Aufgaben durch maschinelles Lernen zu verbessern. Die beiden Aufgaben entsprechen jeweils zwei Modellen (CBOW und Skim-Gramm). Wenn keine besonderen Anweisungen gegeben werden, wird CBOW, das Modell entsprechend Aufgabe 1, für die folgende Analyse verwendet.

Die Analysemethode des Skim-Gramm-Modells ist dieselbe.

Weitere technische Artikel zu Word finden Sie in der Spalte Word-Tutorial zum Lernen!

Das obige ist der detaillierte Inhalt vonWord2Vector-Prinzip. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52