BigData-Big-Data-Betrieb und -Wartung

Big-Data-Betrieb und -Wartung

1.HDFSVerteiltes Dateisystem-Betrieb und -Wartung

1.Rekursion im Stammverzeichnis des HDFS erstellen Dateisystemverzeichnis "1daoyun/file", laden Sie die angehängte Datei BigDataSkills.txt hoch Gehen Sie in das Verzeichnis 1daoyun/file und verwenden Sie die entsprechenden Befehle, um die Dateien im 1daoyun/file anzuzeigen > Verzeichnislisteninformationen.

hadoop fs -mkdir -p /1daoyun/file

hadoop fs -put BigDataSkills.txt /1daoyun/file

hadoop fs -ls /1daoyun/file

2.in HDFS Erstellen Sie ein rekursives Verzeichnis "1daoyun/file" im Stammverzeichnis des Dateisystems, ändern Sie das BigDataSkills.txt , laden Sie sie in das Verzeichnis 1daoyun/file hoch und verwenden Sie HDFS Dateisystem Check-Tool prüft, ob Dateien beschädigt sind.

hadoop fs -mkdir -p /1daoyun/filehadoop fs -put BigDataSkills.txt/1daoyun/file

hadoop fsck /1daoyun/file/BigDataSkills.txt

3.

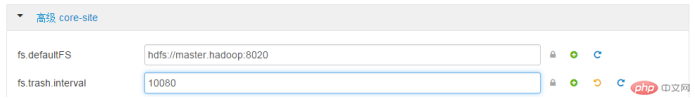

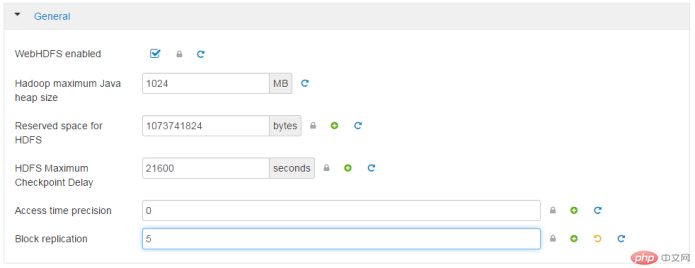

in Erstellen Sie ein rekursives Verzeichnis „1daoyun/file“ im Stammverzeichnis des HDFS-Dateisystems und fügen Sie das im Anhang BigDataSkills.txt wird in das Verzeichnis 1daoyun/file hochgeladen, und der Upload-Prozess gibt an BigDataSkills.txt Dateien im HDFS Dateisystem haben einen Replikationsfaktor von 2 und werden verwendet fsck ToolTool prüft die Anzahl der Kopien von Speicherblöcken. hadoop fs -mkdir -p /1daoyun/file hadoop fs -D dfs.replication=2 -put BigDataSkills.txt /1daoyun/file hadoop fsck /1daoyun/file/BigDataSkills.txt 4.HDFS Es gibt ein Dateisystem im Stammverzeichnis Verzeichnis /apps Dateiverzeichnis, es ist erforderlich, die Snapshot-Erstellungsfunktion dieses Verzeichnisses zu aktivieren und einen Snapshot für zu erstellen In der Verzeichnisdatei lautet der Snapshot-Name apps_1daoyun. Verwenden Sie , um die Listeninformationen der Snapshot-Datei mithilfe verwandter Befehle anzuzeigen. hadoop dfsadmin -allowSnapshot /apps hadoop fs -createSnapshot /apps apps_1daoyun hadoop fs -ls /apps/.snapshot 5.wann Hadoop Wenn der Cluster startet, wechselt er zunächst in den abgesicherten Modus, der standardmäßig nach 30 Sekunden beendet wird. Wenn sich das System im abgesicherten Modus befindet, kann das Dateisystem HDFS nur gelesen werden und kann keine Vorgänge wie Schreiben, Ändern, Löschen usw. ausführen. Gehen Sie nun davon aus, dass der Hadoop -Cluster gewartet werden muss und dass es notwendig ist, den Cluster in den abgesicherten Modus zu versetzen und seinen Status zu überprüfen. hdfs dfsadmin -safemode enter hdfs dfsadmin -safemode get 6.Um zu verhindern, dass Bediener versehentlich Dateien löschen, bietet das HDFS -Dateisystem die Papierkorbfunktion, aber Viele Junk-Dateien beanspruchen viel Speicherplatz. Es ist erforderlich, dass die WEB -Schnittstelle der Xiandian Big Data Platform vollständig aus der HDFS -Datei gelöscht wird Das Zeitintervall beträgt 7 Tage. ErweitertKernseitefs.trash.interval: 10080 7.Um zu verhindern, dass Bediener versehentlich Dateien löschen, bietet das HDFS Dateisystem eine Papierkorbfunktion, aber zu viele Junk-Dateien beanspruchen viel Speicherplatz. Es ist erforderlich, den Befehl „vi“ in der Linux Shell zu verwenden, um die entsprechenden Konfigurationsdateien und Parameterinformationen zu ändern Papierkorbfunktion. Starten Sie nach Abschluss den entsprechenden Dienst neu . ErweitertKernseitefs.trash.interval: 0vi /etc/hadoop/2.4.3.0 -227/0/core-site.xml dfs.sh 8.Hadoop Auf den Hosts im Cluster kann es unter bestimmten Umständen zu Ausfallzeiten oder Systemschäden kommen Sobald diese Probleme auftreten, werden die Datendateien im HDFS Dateisystem wird unweigerlich beschädigt oder geht verloren Um sicherzustellen HDFS Die Zuverlässigkeit des Dateisystems erfordert nun die redundante Replikation Faktor, der in der WEB- Schnittstelle der Xidian-Big-Data-Plattform verwendet werden soll. Geändert in 5. AllgemeinBlockreplikation5 9.Hadoop Bei den Hosts im Cluster kann es unter bestimmten Umständen zu Ausfallzeiten oder Systemschäden kommen Diese Probleme, HDFS Datendateien im Dateisystem werden unweigerlich beschädigt oder gehen verloren, Um sicherzustellen, dass HDFS Für die Zuverlässigkeit von Im Dateisystem muss der Redundanzreplikationsfaktor des Clusters in Linux Shell

oder

oder

vi/etc/hadoop/2.4.3.0-227/0/hdfs- site.xml

>/usr/hdp/current/hadoop-client/sbin/hadoop-daemon.sh --config /usr/hdp/current/hadoop-client/conf stop {namenode/datenode}

/usr/hdp/current/hadoop-client/sbin/hadoop-daemon.sh --config /usr/hdp/current/hadoop-client/conf start {namenode/datenode }

10.

Verwenden Sie den Befehl, um das hdfs

Dateisystem /tmp anzuzeigen

Die Anzahl der Verzeichnisse unter dem Verzeichnis, die Anzahl der Dateien und die Gesamtgröße der Dateien . hadoop fs -count /tmp2.MapREDUCE Fallfrage

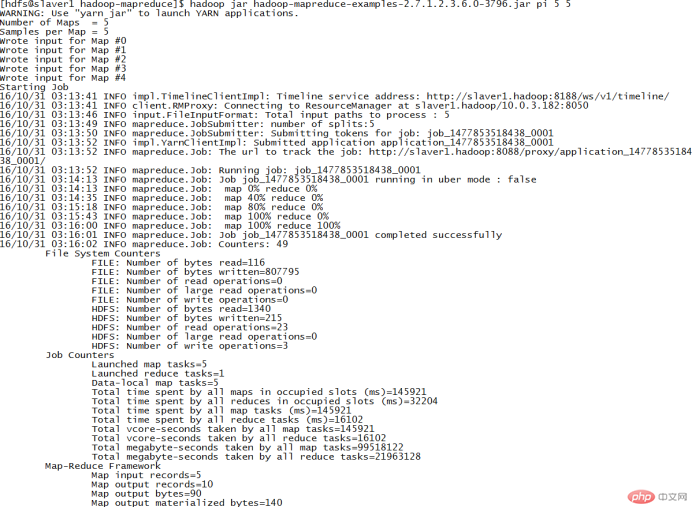

1.Im Clusterknoten/usr/hdp/2.4.3.0-227/hadoop-mapreduce/ Verzeichnis, es gibt ein Fall JAR Paket hadoop-mapreduce-examples.jar. Führen Sie das Programm PI im JAR-Paket aus, um die PiπApproximation von zu berechnen , erfordert das Ausführen von 5 Malen für jede Map -Aufgabe Die Anzahl der Würfe für die Aufgabe beträgt 5. cd /usr/hdp/2.4.3.0-227/hadoop-mapreduce/

hadoop jar hadoop- mapreduce-examples-2.7.1.2.4.3.0-227.jar pi 5 5

2. Es gibt einen Fall

Es gibt einen Fall

/usr/hdp/2.4.3.0-227/hadoop-mapreduce/ Verzeichnis 🎜>JAR Pakethadoop-mapreduce-examples.jar. Führen Sie das Programm wordcount im Paket JAR aus, um ein Paar /1daoyun/file zu erstellen / Die Datei BigDataSkills.txt zählt Wörter, gibt die Operationsergebnisse im Verzeichnis /1daoyun/output aus und verwendet zugehörige Befehle, um die Ergebnisse der Wortzählung abzufragen. hadoop jar/usr/hdp/2.4.3.0-227/hadoop-mapreduce/hadoop-mapreduce-examples-2.7.1.2.4.3.0-227.jar wordcount /1daoyun/ file/BigDataSkills.txt /1daoyun/output

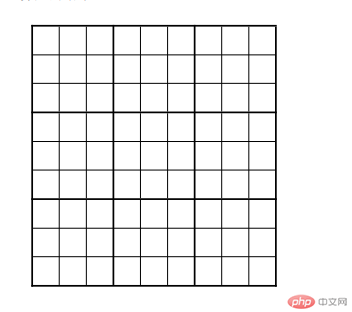

3.Im Clusterknoten/usr/hdp/2.4.3.0-227/hadoop-mapreduce/ Verzeichnis, es gibt ein Fall JAR Paket hadoop-mapreduce-examples.jar. Führen Sie das Programm Sudoku im Paket JAR aus, um die Ergebnisse der Sudoku-Aufgaben in der Tabelle unten zu berechnen . .

cat puzzle1.dta

hadoop jarhadoop-mapreduce-examples- 2.7.1.2.4.3.0-227.jar sudoku /root/puzzle1.dta

4.im Clusterknoten /usr/hdp/2.4.3.0-227/hadoop-mapreduce/ Verzeichnis, es gibt einen Fall JAR Paket hadoop-mapreduce-examples.jar. Führen Sie das Programm grep im Paket JAR aus, um das Dateisystem / 1daoyun/file/BigDataSkills zu zählen. txt Die Anzahl der Vorkommen von "Hadoop" in der Datei. Fragen Sie nach dem Zählen die statistischen Ergebnisinformationen ab.

hadoop jarhadoop-mapreduce-examples-2.7.1.2.4.3.0-227.jar grep /1daoyun/file/BigDataSkills.txt /output hadoop

Das obige ist der detaillierte Inhalt vonBigData-Big-Data-Betrieb und -Wartung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Wie verwende ich reguläre Ausdrücke (REGEX) unter Linux für das Musteranpassung?

Mar 17, 2025 pm 05:25 PM

Wie verwende ich reguläre Ausdrücke (REGEX) unter Linux für das Musteranpassung?

Mar 17, 2025 pm 05:25 PM

In dem Artikel wird erläutert, wie reguläre Ausdrücke (REGEX) unter Linux für Musteranpassung, Dateisuche und Textmanipulation, Detailsyntax, Befehle und Tools wie Grep, SED und awk detailliert werden.

Wie überwache ich die Systemleistung unter Linux mithilfe von Tools wie Top, HTOP und VMSTAT?

Mar 17, 2025 pm 05:28 PM

Wie überwache ich die Systemleistung unter Linux mithilfe von Tools wie Top, HTOP und VMSTAT?

Mar 17, 2025 pm 05:28 PM

In dem Artikel werden die Leistung von Top, HTOP und VMSTAT zur Überwachung der Systemleistung der Linux -Systeme erläutert und deren eindeutige Funktionen und Anpassungsoptionen für eine effektive Systemverwaltung beschrieben.

Wie implementiere ich die Zwei-Faktor-Authentifizierung (2FA) für SSH in Linux?

Mar 17, 2025 pm 05:31 PM

Wie implementiere ich die Zwei-Faktor-Authentifizierung (2FA) für SSH in Linux?

Mar 17, 2025 pm 05:31 PM

Der Artikel enthält eine Anleitung zum Einrichten der Zwei-Faktor-Authentifizierung (2FA) für SSH unter Linux unter Verwendung von Google Authenticator, Detaillierung der Installations-, Konfigurations- und Fehlerbehebungsschritte. Es unterstreicht die Sicherheitsvorteile von 2FA, wie z. B. die verstärkte SEC

Wie verwalte ich Softwarepakete unter Linux mithilfe von Paketmanagern (APT, YUM, DNF)?

Mar 17, 2025 pm 05:26 PM

Wie verwalte ich Softwarepakete unter Linux mithilfe von Paketmanagern (APT, YUM, DNF)?

Mar 17, 2025 pm 05:26 PM

In Artikel werden die Verwaltung von Softwarepaketen unter Linux mithilfe von APT, YUM und DNF besprochen, wobei die Installation, Updates und Entfernungen behandelt werden. Es vergleicht ihre Funktionen und Eignung für verschiedene Verteilungen.

Wie benutze ich Sudo, um Benutzern in Linux erhöhte Berechtigungen zu gewähren?

Mar 17, 2025 pm 05:32 PM

Wie benutze ich Sudo, um Benutzern in Linux erhöhte Berechtigungen zu gewähren?

Mar 17, 2025 pm 05:32 PM

In dem Artikel wird erläutert, wie die Sudo -Privilegien in Linux verwaltet werden, einschließlich Gewährung, Widerruf und Best Practices für Sicherheitsvorschriften. Der Hauptaugenmerk liegt auf der sicheren Bearbeitung /etc /sudoers und der Begrenzung des Zugangs. Charakterzahl: 159

Key Linux -Operationen: Ein Anfängerhandbuch

Apr 09, 2025 pm 04:09 PM

Key Linux -Operationen: Ein Anfängerhandbuch

Apr 09, 2025 pm 04:09 PM

Linux -Anfänger sollten grundlegende Vorgänge wie Dateiverwaltung, Benutzerverwaltung und Netzwerkkonfiguration beherrschen. 1) Dateiverwaltung: Verwenden Sie MKDIR-, Touch-, LS-, RM-, MV- und CP -Befehle. 2) Benutzerverwaltung: Verwenden Sie die Befehle von UserAdd-, PassWD-, UserDel- und UsMod -Befehlen. 3) Netzwerkkonfiguration: Verwenden Sie IFConfig-, Echo- und UFW -Befehle. Diese Vorgänge sind die Grundlage für das Linux -Systemmanagement, und das Beherrschen kann das System effektiv verwalten.

Die 5 Säulen von Linux: Verständnis ihrer Rollen

Apr 11, 2025 am 12:07 AM

Die 5 Säulen von Linux: Verständnis ihrer Rollen

Apr 11, 2025 am 12:07 AM

Die fünf Säulen des Linux -Systems sind: 1. Kernel, 2. Systembibliothek, 3. Shell, 4. Dateisystem, 5. Systemwerkzeuge. Der Kernel verwaltet Hardware -Ressourcen und bietet grundlegende Dienste an. Die Systembibliothek bietet vorkompilierte Funktionen für Anwendungen. Die Shell ist die Schnittstelle, in der Benutzer mit dem System interagieren können. Das Dateisystem organisiert und speichert Daten. und Systemwerkzeuge werden für das Systemmanagement und die Wartung verwendet.

Linux -Wartungsmodus: Werkzeuge und Techniken

Apr 10, 2025 am 09:42 AM

Linux -Wartungsmodus: Werkzeuge und Techniken

Apr 10, 2025 am 09:42 AM

In Linux -Systemen kann der Wartungsmodus eingegeben werden, indem eine bestimmte Taste beim Start gedrückt wird oder einen Befehl wie "sudosystemctlrescue" verwendet. Der Wartungsmodus ermöglicht es Administratoren, die Wartung und Fehlerbehebung ohne Störung durch die Systeme durchzuführen, z. B. das Reparieren von Dateisystemen, das Zurücksetzen von Kennwörtern, das Patch -Sicherheitslücken usw.