So installieren Sie Hadoop unter Linux: 1. Installieren Sie den SSH-Dienst. 2. Melden Sie sich mit SSH ohne Passwortauthentifizierung an. 3. Entpacken Sie das Hadoop-Installationspaket Hadoop.

Die Betriebsumgebung dieses Artikels: Ubuntu 16.04-System, Hadoop-Version 2.7.1, Dell G3-Computer.

Wie installiere ich Hadoop unter Linux?

[Big Data] Detaillierte Erläuterung der Installation von Hadoop (2.7.1) und der Ausführung von WordCount unter Linux

1. Einführung

Nachdem ich die Umgebungskonfiguration von Storm abgeschlossen habe, möchte ich an der Installation von Hadoop herumbasteln und Es gibt viele Tutorials im Internet, aber keines davon ist besonders geeignet, sodass ich während des Installationsprozesses immer noch auf große Probleme gestoßen bin, nachdem ich die Informationen ständig überprüft habe. Kommen wir zum Punkt.

Die Konfigurationsumgebung dieser Maschine ist wie folgt:

Hadoop(2.7.1)

Ubuntu Linux (64-Bit-System)

Der Konfigurationsprozess wird im Folgenden in mehreren Schritten ausführlich erläutert.

2. Installieren Sie den SSH-Dienst

Geben Sie den Shell-Befehl ein und geben Sie den folgenden Befehl ein, um zu überprüfen, ob der SSH-Dienst installiert wurde:

sudo apt- get install ssh openssh- serversudo apt-get install ssh openssh-server

安装过程还是比较轻松加愉快的。

三、使用ssh进行无密码验证登录

1.创建ssh-key,这里我们采用rsa方式,使用如下命令:

ssh-keygen -t rsa -P ""

2.出现一个图形,出现的图形就是密码,不用管它

cat ~/.ssh/id_rsa.pub >> authorized_keys(好像是可以省略的)

3.然后即可无密码验证登录了,如下:

ssh localhost

成功截图如下:

四、下载Hadoop安装包

下载Hadoop安装也有两种方式

1.直接上官网进行下载,http://mirrors.hust.edu.cn/apache/hadoop/core/stable/hadoop-2.7.1.tar.gz

2.使用shell进行下载,命令如下:

wget http://mirrors.hust.edu.cn/apache/hadoop/core/stable/hadoop-2.7.1.tar.gz

貌似第二种的方法要快点,经过漫长的等待,终于下载完成。

五、解压缩Hadoop安装包

使用如下命令解压缩Hadoop安装包

tar -zxvf hadoop-2.7.1.tar.gz

解压缩完成后出现hadoop2.7.1的文件夹

六、配置Hadoop中相应的文件

需要配置的文件如下,hadoop-env.sh,core-site.xml,mapred-site.xml.template,hdfs-site.xml,所有的文件均位于hadoop2.7.1/etc/hadoop下面,具体需要的配置如下:

1.core-site.xml 配置如下:

<configuration> <property> <name>hadoop.tmp.dir</name> <value>file:/home/leesf/program/hadoop/tmp</value> <description>Abase for other temporary directories.</description> </property> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property> </configuration>

其中的hadoop.tmp.dir的路径可以根据自己的习惯进行设置。

2.mapred-site.xml.template配置如下:

<configuration> <property> <name>mapred.job.tracker</name> <value>localhost:9001</value> </property> </configuration>

3.hdfs-site.xml配置如下:

<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:/home/leesf/program/hadoop/tmp/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:/home/leesf/program/hadoop/tmp/dfs/data</value> </property> </configuration>

其中dfs.namenode.name.dir和dfs.datanode.data.dir的路径可以自由设置,最好在hadoop.tmp.dir的目录下面。

补充,如果运行Hadoop的时候发现找不到jdk,可以直接将jdk的路径放置在hadoop.env.sh里面,具体如下:

export JAVA_HOME="/home/leesf/program/java/jdk1.8.0_60"

七、运行Hadoop

在配置完成后,运行hadoop。

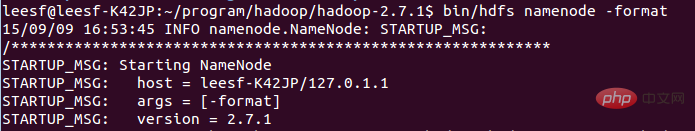

1.初始化HDFS系统

在hadop2.7.1目录下使用如下命令:

bin/hdfs namenode -format

截图如下:

过程需要进行ssh验证,之前已经登录了,所以初始化过程之间键入y即可。

成功的截图如下:

表示已经初始化完成。

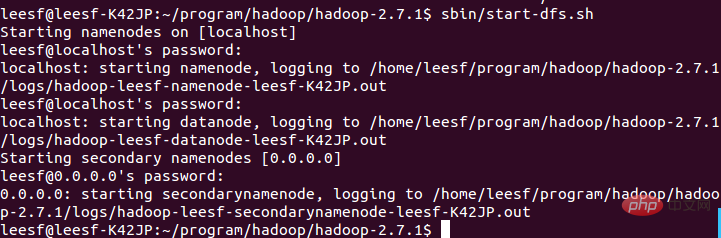

2.开启NameNode和DataNode守护进程

使用如下命令开启:

sbin/start-dfs.sh,成功的截图如下:

1. Erstellen Sie einen SSH-Schlüssel, hier verwenden wir die RSA-Methode, verwenden Sie den folgenden Befehl:

ssh-keygen -t rsa -P ""

2. Es erscheint eine Grafik, die das Passwort darstellt

cat ~/.ssh/id_rsa.pub >> 3. Anschließend können Sie sich wie folgt ohne Passwortbestätigung anmelden: 🎜🎜 ssh localhost🎜🎜 Der erfolgreiche Screenshot sieht wie folgt aus: 🎜🎜  🎜🎜🎜Vier. Laden Sie das Hadoop-Installationspaket herunter🎜🎜🎜Es gibt zwei Möglichkeiten, die Hadoop-Installation herunterzuladen 🎜🎜 1. Gehen Sie zum Herunterladen direkt zur offiziellen Website, http://mirrors.hust.edu.cn/apache/hadoop/core/stable/hadoop-2.7.1.tar.gz🎜🎜 2. Verwenden Sie zum Herunterladen die Shell , der Befehl lautet wie folgt: 🎜🎜

🎜🎜🎜Vier. Laden Sie das Hadoop-Installationspaket herunter🎜🎜🎜Es gibt zwei Möglichkeiten, die Hadoop-Installation herunterzuladen 🎜🎜 1. Gehen Sie zum Herunterladen direkt zur offiziellen Website, http://mirrors.hust.edu.cn/apache/hadoop/core/stable/hadoop-2.7.1.tar.gz🎜🎜 2. Verwenden Sie zum Herunterladen die Shell , der Befehl lautet wie folgt: 🎜🎜 wget http://mirrors .hust.edu.cn/apache/hadoop/core/stable/hadoop-2.7.1.tar.gz🎜🎜 Es scheint dass die zweite Methode schneller ist. Nach langem Warten ist der Download endlich abgeschlossen. 🎜🎜🎜 5. Dekomprimieren Sie das Hadoop-Installationspaket 🎜🎜🎜 Verwenden Sie den folgenden Befehl, um das Hadoop-Installationspaket zu dekomprimieren 🎜🎜 tar -zxvf hadoop-2.7.1.tar.gz 🎜🎜 Nach Abschluss der Dekomprimierung wird der Ordner hadoop2.7.1 angezeigt wird angezeigt 🎜🎜 🎜6. Konfigurieren Sie die entsprechenden Dateien in Hadoop🎜🎜🎜 Die Dateien, die konfiguriert werden müssen, sind wie folgt: hadoop-env.sh, core-site.xml, mapred-site.xml.template, hdfs-site .xml, alle Dateien befinden sich in hadoop2 .7.1/etc/hadoop, die spezifische erforderliche Konfiguration ist wie folgt: 🎜🎜 1.core-site.xml-Konfiguration ist wie folgt: 🎜rrreee🎜 Der Pfad von hadoop.tmp.dir kann nach Ihren eigenen Gewohnheiten eingestellt werden. 🎜🎜 2.mapred-site.xml.template ist wie folgt konfiguriert: 🎜rrreee🎜 3.hdfs-site.xml ist wie folgt konfiguriert: 🎜rrreee🎜 Die Pfade von dfs.namenode.name.dir und dfs.datanode.data .dir kann kostenlos eingestellt werden, vorzugsweise im Verzeichnis hadoop.tmp.dir. 🎜🎜 Wenn Sie außerdem feststellen, dass JDK beim Ausführen von Hadoop nicht gefunden werden kann, können Sie den Pfad von JDK wie folgt direkt in hadoop.env.sh einfügen: 🎜🎜 Export JAVA_HOME="/home/leesf/program/java/ jdk1. 8.0_60"🎜🎜🎜7. Führen Sie Hadoop aus🎜🎜🎜Nachdem die Konfiguration abgeschlossen ist, führen Sie Hadoop aus. 1. Initialisieren Sie das HDFS-System /000/000/ 020/7806f74f8f62cfb2f585c032aa4ffa02-1.png" alt=""/> 🎜🎜 Der Vorgang erfordert eine SSH-Überprüfung. Sie haben sich bereits zuvor angemeldet, also geben Sie zwischen dem Initialisierungsprozess einfach y ein. 🎜🎜 Der erfolgreiche Screenshot sieht wie folgt aus:🎜🎜  🎜🎜 Zeigt an, dass die Initialisierung abgeschlossen ist. 🎜🎜 2. Starten Sie die Daemons

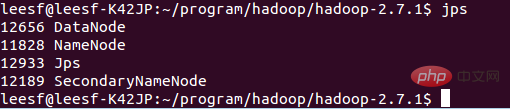

🎜🎜 Zeigt an, dass die Initialisierung abgeschlossen ist. 🎜🎜 2. Starten Sie die Daemons NameNode und DataNode 🎜🎜 Verwenden Sie zum Starten den folgenden Befehl: 🎜🎜 sbin/start-dfs.sh, der erfolgreiche Screenshot ist wie folgt: 🎜🎜 🎜🎜🎜 3. Prozessinformationen anzeigen🎜🎜 Verwenden Sie den folgenden Befehl, um Prozessinformationen anzuzeigen🎜🎜 jps, der Screenshot sieht wie folgt aus:🎜🎜 Das bedeutet, dass sowohl DataNode als auch NameNode vorhanden sind begonnen🎜<p> 4. Sehen Sie sich die Web-Benutzeroberfläche an</p>

<p> Geben Sie http://localhost:50070 in den Browser ein, um relevante Informationen anzuzeigen. Der Screenshot sieht wie folgt aus: </p>

<p><img src="/static/imghw/default1.png" data-src="https://img.php.cn/upload/article/000/000/020/bfb5bc22f461fcb2beb87197aa100a4e-5.png" class="lazy" alt=""></p>

<p> Zu diesem Zeitpunkt wurde die Hadoop-Umgebung eingerichtet. Beginnen wir mit der Verwendung von Hadoop, um ein WordCount-Beispiel auszuführen. </p>

<p><strong> 8. Führen Sie die WordCount-Demo aus</strong></p>

<p> 1. Erstellen Sie lokal eine neue Word-Datei im Verzeichnis home/leesf. Sie können den Inhalt nach Belieben ergänzen. </p>

<p> 2. Erstellen Sie einen neuen Ordner in HDFS zum Hochladen lokaler Word-Dokumente. Geben Sie den folgenden Befehl in das Verzeichnis hadoop2.7.1 ein: </p>

<p> bin/hdfs dfs -mkdir /test, was bedeutet, dass er im Stammverzeichnis von hdfs A erstellt wird Testverzeichnis</p>

<p> Verwenden Sie den folgenden Befehl, um die Verzeichnisstruktur unter dem HDFS-Stammverzeichnis anzuzeigen</p>

<p> bin/hdfs dfs -ls /</p>

<p> Der spezifische Screenshot lautet wie folgt:</p>

<p> <img src="/static/imghw/default1.png" data-src="https://img.php.cn/upload/article/000/000/020/2d6b7ed9c222079a563098cea81e4d89-6.png" class="lazy" alt=""></p>

<p> Es bedeutet, dass ein Testverzeichnis erstellt wurde im Stammverzeichnis von HDFS </p>

<p> 3. Laden Sie das lokale Word-Dokument in das Testverzeichnis hoch</p>

<p> Verwenden Sie zum Hochladen den folgenden Befehl: </p>

<p> bin/hdfs dfs -put /home/leesf/words /test/</p>

<p> Ich in in in in forth in den folgenden Worten: dfs -put /home/leesf/words /test/</p>

<p> hdfs dfs -ls /test/</p>

<p> Der Screenshot des Ergebnisses ist wie folgt: </p>

<p> <img src="/static/imghw/default1.png" data-src="https://img.php.cn/upload/article/000/000/020/2d6b7ed9c222079a563098cea81e4d89-7.png" class="lazy" alt=""></p>

<p> Das bedeutet, dass Das lokale Word-Dokument wurde in das Testverzeichnis hochgeladen. </p>

<p> 4. Wordcount ausführen</p>

<p> Verwenden Sie den folgenden Befehl, um Wordcount auszuführen:</p>

<p> bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar wordcount /test/words /test/out</p>

<p> Der Screenshot sieht wie folgt aus: </p>

<p> <img src="/static/imghw/default1.png" data-src="https://img.php.cn/upload/article/000/000/020/2d6b7ed9c222079a563098cea81e4d89-8.png" class="lazy" alt=""></p>

<p> Nachdem der Vorgang abgeschlossen ist, wird eine Datei mit dem Namen „out“ im Verzeichnis „/test“ generiert. Verwenden Sie den folgenden Befehl, um die Dateien im Verzeichnis „/test“ anzuzeigen: „bin/hdfs dfs“ ls /test</p>

<p> Der Screenshot sieht wie folgt aus: </p>

<p> </p> <p><img src="/static/imghw/default1.png" data-src="https://img.php.cn/upload/article/000/000/020/9e4e133c94861b62bd546dbeb0c3b6b4-9.png" class="lazy" alt=""> Zeigt an, dass im Testverzeichnis bereits ein Dateiverzeichnis mit dem Namen „Out“ vorhanden ist dfs dfs -ls /test/out, der Ergebnis-Screenshot lautet wie folgt: </p>

<p> </p>

<p> </p> Zeigt an, dass es erfolgreich ausgeführt wurde und das Ergebnis in part-r-00000 gespeichert wird. <p></p> 5. Überprüfen Sie die laufenden Ergebnisse <p><img src="/static/imghw/default1.png" data-src="https://img.php.cn/upload/article/000/000/020/9e4e133c94861b62bd546dbeb0c3b6b4-10.png" class="lazy" alt=""> An diesem Punkt ist der laufende Prozess abgeschlossen. </p>

<p></p>9. Zusammenfassung<p></p>

<p> Während des Hadoop-Konfigurationsprozesses sind die Befehle von hadoop1.x und 2.x immer noch sehr unterschiedlich Erfolgreich, ich möchte meine Erfahrungen mit dieser Konfiguration teilen, um die Hadoop-Umgebung zu vereinfachen. Wenn Sie während des Konfigurationsprozesses Fragen haben, können Sie diese gerne besprechen zum Anschauen~</p>

<p> Empfohlene Studie: „</p>Linux-Video-Tutorial<p>“</p>Das obige ist der detaillierte Inhalt vonSo installieren Sie Hadoop unter Linux. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!