Lassen Sie uns über die verschiedenen I/O-Modelle in Node sprechen

In diesem Artikel geht es um die verschiedenen I/O-Modelle in Node und es werden das blockierende I/O-Modell, das nicht blockierende I/O-Modell und das nicht blockierende asynchrone I/O vorgestellt . !

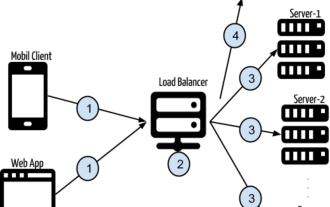

Nehmen wir als Beispiel Netzwerkanforderungs-IO. Zunächst stellen wir den typischen Prozess der Serververarbeitung einer vollständigen Netzwerk-IO-Anfrage vor:

Die Anwendung erhält ein Operationsergebnis, das normalerweise zwei verschiedene Phasen umfasst :

Warten, bis die Daten bereit sind

- Daten vom Kernel in den Prozess kopieren

Im Folgenden nehmen wir die recvfrom-Funktion als Beispiel, um verschiedene IO-Modelle zu erklären

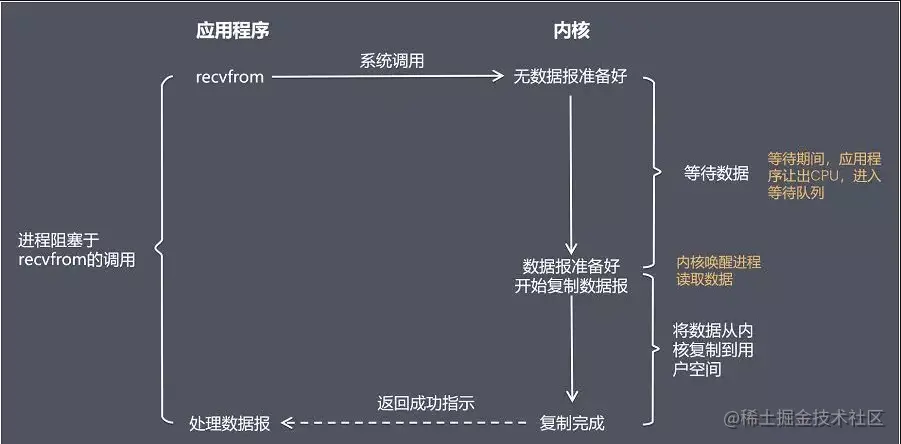

Blockieren I/O Modell (blockierende E/A)

Blockierender Aufruf bedeutet, dass der aktuelle Thread angehalten wird, bevor das Aufrufergebnis zurückgegeben wird. Der aufrufende Thread wird erst beendet, nachdem auf den Abschluss aller Vorgänge auf Systemkernelebene gewartet wurde.

Das Blockieren von E/A führt dazu, dass die CPU auf E/A wartet und CPU-Zeitscheiben verschwendet.

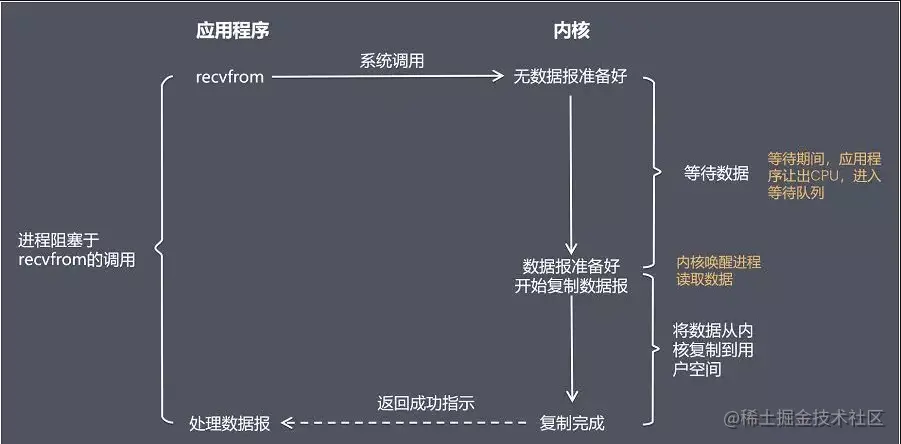

nicht blockierende E/Adirekt ohne Daten zurück, Sie müssen auch a übergeben Dateideskriptor Nachdem versucht wurde, die Daten erneut zu lesen

und die Rückgabe (nicht die tatsächlich erwarteten Daten) erhalten wurde, kann die CPU-Zeitscheibe für die Verarbeitung anderer Dinge verwendet werden, was die Leistung erheblich verbessern kann. Aber das damit verbundene Problem ist, dass der vorherige Vorgang keine vollständige E/A war und das zurückgegebene Ergebnis nicht die erwarteten Geschäftsdaten, sondern nur der asynchrone Anrufstatus war.

Um vollständige Daten zu erhalten, muss die Anwendung wiederholt den E/A-Vorgang aufrufen, um zu bestätigen, ob der Vorgang abgeschlossen ist. Mehrere gängige Abfragestrategien sind wie folgt:

Busy Polling

Dies ist die primitivste und leistungsschwächste Methode. Sie überprüft den E/A-Status durch wiederholte Aufrufe, um vollständige Daten zu erhalten. Vorteile: Einfache Programmierung. Nachteile: Die CPU wird beim Abfragen immer beansprucht Leistung, da der Server nach Ihrer Abfrage immer noch antworten muss

I/O-Multiplexing-Modell (I/O-Multiplexing)

Im I/O-Multiplexing-Modell wird die Select- oder Poll-Funktion oder die Epoll-Funktion (unterstützt von) verwendet (im Linux-Kernel nach 2.6) blockieren diese beiden Funktionen ebenfalls den Prozess, unterscheiden sich jedoch vom Blockieren von E/A.

Diese drei Funktionen können mehrere E/A-Vorgänge gleichzeitig blockieren und die E/A-Funktionen mehrerer Lesevorgänge und mehrerer Schreibvorgänge gleichzeitig erkennen. Sie werden erst dann tatsächlich aufgerufen, wenn die Daten lesbar oder beschreibbar sind. I/O-Betriebsfunktionen.

Die Unterschiede zwischen den drei E/A-Multiplexmechanismen sind wie folgt:

select

select

-

poll

-

ist der effizienteste E/A-Ereignisbenachrichtigungsmechanismus unter Linux. Wenn während der Abfrage kein E/A-Ereignis erkannt wird, bleibt es im Ruhezustand, bis ein Ereignis eintritt und der Thread aufwacht. Es nutzt die Ereignisbenachrichtigungen wirklich aus und führt Rückrufe aus, anstatt Abfragen (Dateideskriptoren) zu durchlaufen, sodass keine CPU verschwendet wird Warten auf die vollständige Rückkehr der E/A. Während der Wartezeit durchläuft es entweder den Dateibeschreibungsstatus oder schläft, um auf das Eintreten des Ereignisses zu warten.

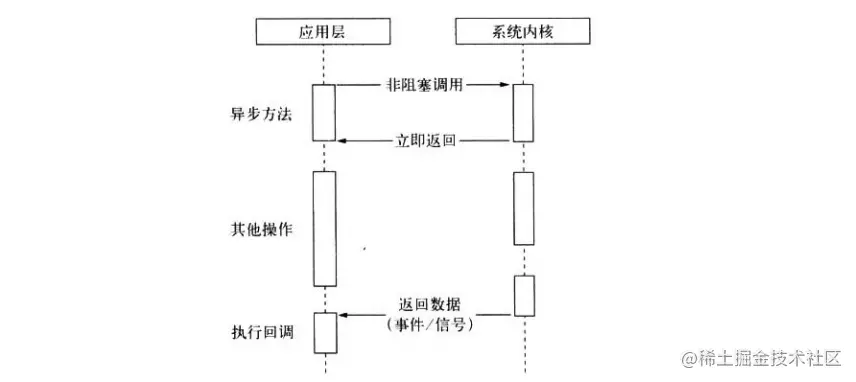

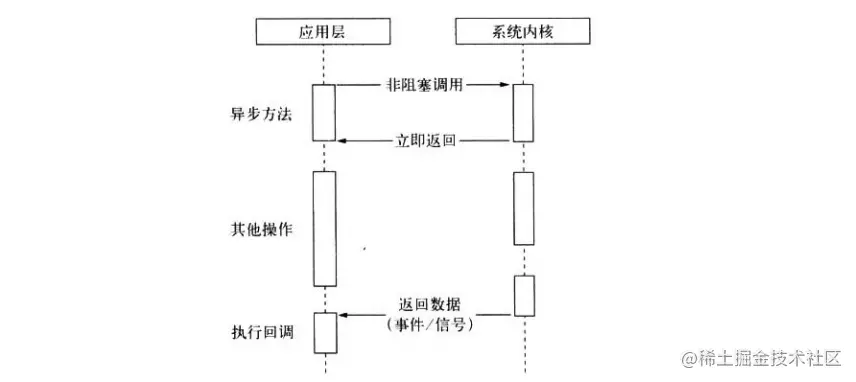

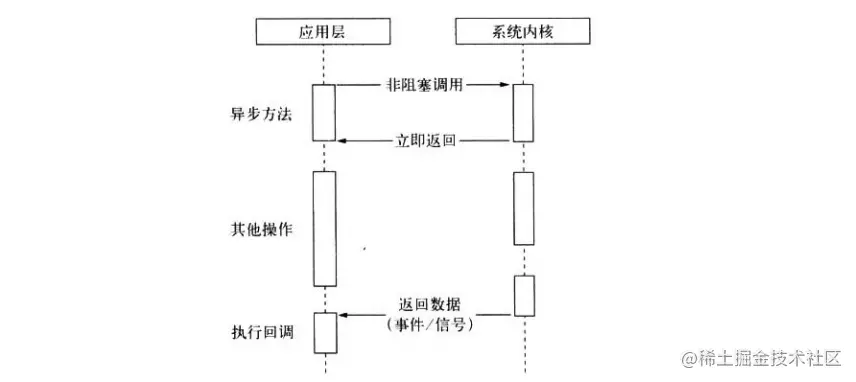

Signalgesteuertes E/A-Modell (signalgesteuertes E/A)

- Im signalgesteuerten E/A-Modell verwendet die Anwendung Signale zum Ansteuern von E/A und installiert eine Signalverarbeitungsfunktion. Der Prozess läuft ohne Blockierung weiter.

Wenn die Daten bereit sind, empfängt das Programm ein SIGIO-Signal und kann die E/A-Operationsfunktion in der Signalverarbeitungsfunktion aufrufen, um die Daten zu verarbeiten.

Zusammenfassung: Bisher entspricht das signalgesteuerte E/A-Modell eher unseren asynchronen Anforderungen. Das Programm führt andere Geschäftslogik asynchron aus, während es auf Daten wartet.

Aber! ! ! Während des Kopiervorgangs von Daten vom Kernel in den Benutzerbereich ist er immer noch blockiert, was keine vollständige Revolution darstellt (asynchron).

Ideale (Knoten) nicht blockierende asynchrone E/A

Unsere ideale asynchrone E/A sollte ein nicht blockierender Aufruf sein, der von der Anwendung initiiert wird, ohne dass Daten durch Abfragen abgerufen werden müssen und es keine Notwendigkeit gibt, sie zu kopieren Daten in der Phase Anstatt unnötig zu warten, können die E/A-Vorgänge nach Abschluss der E/A über ein Signal oder eine Rückruffunktion an die Anwendung übergeben werden, während die Anwendung andere Geschäftslogik ausführen kann.

Tatsächliche asynchrone E/A

Tatsächlich unterstützt die Linux-Plattform nativ asynchrone E/A (AIO), aber derzeit ist AIO nicht perfekt, sodass es bei der Implementierung von Netzwerkprogrammierung mit hoher Parallelität unter Linux hauptsächlich so ist /O Wiederverwendungsmodell.

Unter Windows wird echte asynchrone E/A über IOCP implementiert.

Multithread-Simulation asynchroner E/A

Unter der Linux-Plattform verwendet Node den Thread-Pool, um die Datenerfassung abzuschließen, indem er einige Threads blockierende E/A oder nicht blockierende E/A + Abfragen durchführen lässt Ein einzelner Thread führt Berechnungen durch und überträgt E/A-Ergebnisse durch Kommunikation zwischen Threads, wodurch die Simulation asynchroner E/A realisiert wird.

Tatsächlich wird die unterste Ebene der asynchronen und asynchronen IOCP-Lösung unter der Windows-Plattform auch mithilfe eines Thread-Pools implementiert. Der Unterschied besteht darin, dass der Thread-Pool des letzteren vom Systemkernel gehostet wird.

Wir sagen oft, dass Node Single-Threaded ist, aber tatsächlich kann man nur sagen, dass JS in einem einzelnen Thread ausgeführt wird Unabhängig davon, ob es sich um eine *nix- oder eine Windows-Plattform handelt, verwendet die unterste Ebene den Thread-Pool um E/A-Vorgänge abzuschließen.

Weitere Informationen zu Knoten finden Sie unter: nodejs-Tutorial!

Das obige ist der detaillierte Inhalt vonLassen Sie uns über die verschiedenen I/O-Modelle in Node sprechen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1389

1389

52

52

So verwenden Sie Express für den Datei-Upload im Knotenprojekt

Mar 28, 2023 pm 07:28 PM

So verwenden Sie Express für den Datei-Upload im Knotenprojekt

Mar 28, 2023 pm 07:28 PM

Wie gehe ich mit dem Datei-Upload um? Der folgende Artikel stellt Ihnen vor, wie Sie Express zum Hochladen von Dateien im Knotenprojekt verwenden. Ich hoffe, er ist hilfreich für Sie!

So löschen Sie einen Knoten in NVM

Dec 29, 2022 am 10:07 AM

So löschen Sie einen Knoten in NVM

Dec 29, 2022 am 10:07 AM

So löschen Sie einen Knoten mit nvm: 1. Laden Sie „nvm-setup.zip“ herunter und installieren Sie es auf dem Laufwerk C. 2. Konfigurieren Sie Umgebungsvariablen und überprüfen Sie die Versionsnummer mit dem Befehl „nvm -v“. install“-Befehl Knoten installieren; 4. Löschen Sie den installierten Knoten über den Befehl „nvm uninstall“.

Wie führt man eine Docker-Spiegelung des Node-Dienstes durch? Detaillierte Erläuterung der ultimativen Optimierung

Oct 19, 2022 pm 07:38 PM

Wie führt man eine Docker-Spiegelung des Node-Dienstes durch? Detaillierte Erläuterung der ultimativen Optimierung

Oct 19, 2022 pm 07:38 PM

Während dieser Zeit habe ich einen dynamischen HTML-Dienst entwickelt, der allen Kategorien von Tencent-Dokumenten gemeinsam ist. Um die Generierung und Bereitstellung des Zugriffs auf verschiedene Kategorien zu erleichtern und dem Trend der Cloud-Migration zu folgen, habe ich über die Verwendung von Docker nachgedacht Serviceinhalte verwalten und Produktversionen einheitlich verwalten. In diesem Artikel werden die Optimierungserfahrungen, die ich bei der Bereitstellung von Docker gesammelt habe, als Referenz weitergegeben.

Eine ausführliche Analyse des Prozessmanagement-Tools „pm2' von Node

Apr 03, 2023 pm 06:02 PM

Eine ausführliche Analyse des Prozessmanagement-Tools „pm2' von Node

Apr 03, 2023 pm 06:02 PM

In diesem Artikel stellen wir Ihnen das Prozessmanagement-Tool „pm2“ von Node vor und sprechen darüber, warum PM2 benötigt wird und wie Sie PM2 installieren und verwenden. Ich hoffe, dass es für alle hilfreich ist!

PI -Knotenunterricht: Was ist ein PI -Knoten? Wie installiere und richte ich einen PI -Knoten ein?

Mar 05, 2025 pm 05:57 PM

PI -Knotenunterricht: Was ist ein PI -Knoten? Wie installiere und richte ich einen PI -Knoten ein?

Mar 05, 2025 pm 05:57 PM

Detaillierte Erläuterungs- und Installationshandbuch für Pinetwork -Knoten In diesem Artikel wird das Pinetwork -Ökosystem im Detail vorgestellt - PI -Knoten, eine Schlüsselrolle im Pinetwork -Ökosystem und vollständige Schritte für die Installation und Konfiguration. Nach dem Start des Pinetwork -Blockchain -Testnetzes sind PI -Knoten zu einem wichtigen Bestandteil vieler Pioniere geworden, die aktiv an den Tests teilnehmen und sich auf die bevorstehende Hauptnetzwerkveröffentlichung vorbereiten. Wenn Sie Pinetwork noch nicht kennen, wenden Sie sich bitte an was Picoin ist? Was ist der Preis für die Auflistung? PI -Nutzung, Bergbau und Sicherheitsanalyse. Was ist Pinetwork? Das Pinetwork -Projekt begann 2019 und besitzt seine exklusive Kryptowährung PI -Münze. Das Projekt zielt darauf ab, eine zu erstellen, an der jeder teilnehmen kann

Lassen Sie uns darüber sprechen, wie Sie mit pkg Node.js-Projekte in ausführbare Dateien packen.

Dec 02, 2022 pm 09:06 PM

Lassen Sie uns darüber sprechen, wie Sie mit pkg Node.js-Projekte in ausführbare Dateien packen.

Dec 02, 2022 pm 09:06 PM

Wie packe ich die ausführbare Datei von nodejs mit pkg? Im folgenden Artikel erfahren Sie, wie Sie mit pkg ein Node-Projekt in eine ausführbare Datei packen. Ich hoffe, dass er Ihnen weiterhilft!

Was tun, wenn npm node gyp ausfällt?

Dec 29, 2022 pm 02:42 PM

Was tun, wenn npm node gyp ausfällt?

Dec 29, 2022 pm 02:42 PM

npm node gyp schlägt fehl, weil „node-gyp.js“ nicht mit der Version von „Node.js“ übereinstimmt. Die Lösung ist: 1. Löschen Sie den Knotencache über „npm cache clean -f“ 2. Über „npm install -“ g n“ Installieren Sie das n-Modul. 3. Installieren Sie die Version „node v12.21.0“ über den Befehl „n v12.21.0“.

Tokenbasierte Authentifizierung mit Angular und Node

Sep 01, 2023 pm 02:01 PM

Tokenbasierte Authentifizierung mit Angular und Node

Sep 01, 2023 pm 02:01 PM

Die Authentifizierung ist einer der wichtigsten Teile jeder Webanwendung. In diesem Tutorial werden tokenbasierte Authentifizierungssysteme und ihre Unterschiede zu herkömmlichen Anmeldesystemen erläutert. Am Ende dieses Tutorials sehen Sie eine voll funktionsfähige Demo, die in Angular und Node.js geschrieben wurde. Traditionelle Authentifizierungssysteme Bevor wir zu tokenbasierten Authentifizierungssystemen übergehen, werfen wir einen Blick auf traditionelle Authentifizierungssysteme. Der Benutzer gibt seinen Benutzernamen und sein Passwort im Anmeldeformular ein und klickt auf „Anmelden“. Nachdem Sie die Anfrage gestellt haben, authentifizieren Sie den Benutzer im Backend, indem Sie die Datenbank abfragen. Wenn die Anfrage gültig ist, wird eine Sitzung mit den aus der Datenbank erhaltenen Benutzerinformationen erstellt und die Sitzungsinformationen werden im Antwortheader zurückgegeben, sodass die Sitzungs-ID im Browser gespeichert wird. Bietet Zugriff auf Anwendungen, die unterliegen