Betrieb und Instandhaltung

Betrieb und Instandhaltung

Apache

Apache

Lassen Sie uns darüber sprechen, wie Apache Avro-Daten analysiert werden (Erklärung mit Beispielen).

Lassen Sie uns darüber sprechen, wie Apache Avro-Daten analysiert werden (Erklärung mit Beispielen).

Lassen Sie uns darüber sprechen, wie Apache Avro-Daten analysiert werden (Erklärung mit Beispielen).

Wie analysiere ich Apache Avro-Daten? In diesem Artikel werden Ihnen die Methoden der Serialisierung zum Generieren von Avro-Daten, des Deserialisierens zum Parsen von Avro-Daten und die Verwendung von FlinkSQL zum Parsen von Avro-Daten vorgestellt.

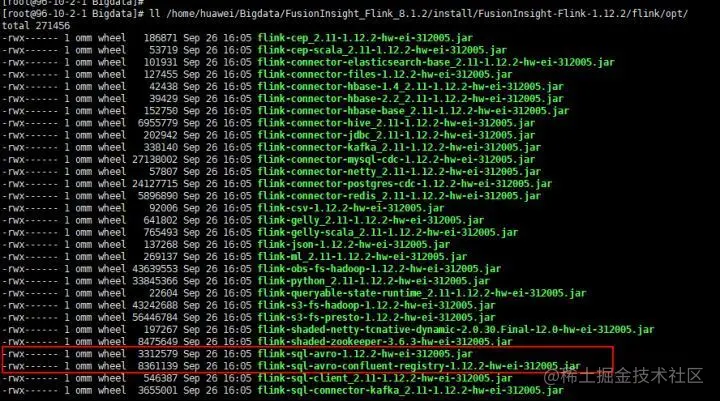

Mit der rasanten Entwicklung des Internets sind Spitzentechnologien wie Cloud Computing, Big Data, künstliche Intelligenz und das Internet der Dinge in der heutigen Zeit zu Mainstream-Hightech-Technologien geworden, beispielsweise E-Commerce-Websites , Gesichtserkennung, fahrerlose Autos und Smartphones erleichtern nicht nur die Ernährung, Kleidung, Unterkunft und den Transport der Menschen, sondern dahinter stehen auch große Datenmengen, die von gesammelt, gelöscht und analysiert werden Dabei ist es besonders wichtig, dass Apache Avro selbst über Schema für die Binärübertragung serialisiert wird Andererseits wird Avro derzeit in verschiedenen Branchen immer häufiger verwendet. Je umfangreicher es ist, desto wichtiger ist die Verarbeitung und Analyse von Avro-Daten Verwenden Sie FlinkSQL zur Analyse.

Dieser Artikel ist eine Demo des Avro-Parsings. Derzeit ist FlinkSQL nur für das einfache Parsen von Avro-Daten geeignet.

Szeneneinführung

In diesem Artikel werden hauptsächlich die folgenden drei Hauptinhalte vorgestellt:

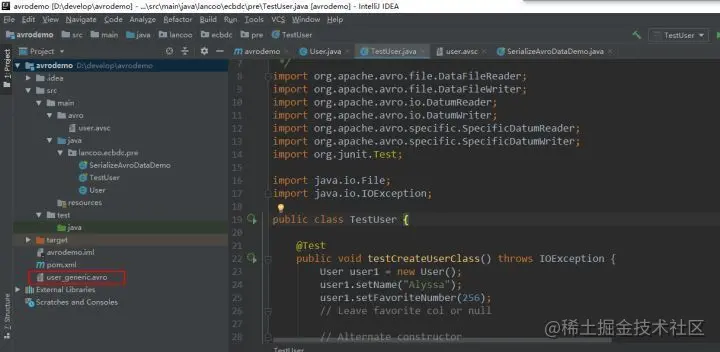

So serialisieren und generieren Sie Avro-Daten

So deserialisieren und analysieren Sie Avro-Daten

So verwenden Sie FlinkSQL zum Parsen von Avro-Daten

Voraussetzungen

Um zu verstehen, was Avro ist, können Sie sich die Kurzanleitung der offiziellen Apache-Avro-Website ansehen.

Avro-Anwendungsszenarien verstehen POM-Abhängigkeiten projektieren und konfigurieren

Der Inhalt der POM-Datei lautet wie folgt:

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.huawei.bigdata</groupId>

<artifactId>avrodemo</artifactId>

<version>1.0-SNAPSHOT</version>

<dependencies>

<dependency>

<groupId>org.apache.avro</groupId>

<artifactId>avro</artifactId>

<version>1.8.1</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.12</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.avro</groupId>

<artifactId>avro-maven-plugin</artifactId>

<version>1.8.1</version>

<executions>

<execution>

<phase>generate-sources</phase>

<goals>

<goal>schema</goal>

</goals>

<configuration>

<sourceDirectory>${project.basedir}/src/main/avro/</sourceDirectory>

<outputDirectory>${project.basedir}/src/main/java/</outputDirectory>

</configuration>

</execution>

</executions>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<configuration>

<source>1.6</source>

<target>1.6</target>

</configuration>

</plugin>

</plugins>

</build>

</project>

p

保存提交任务

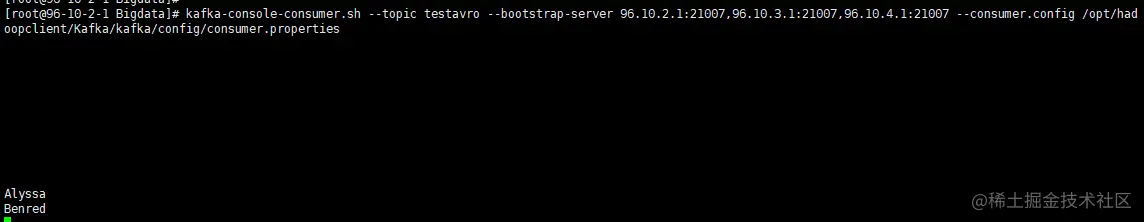

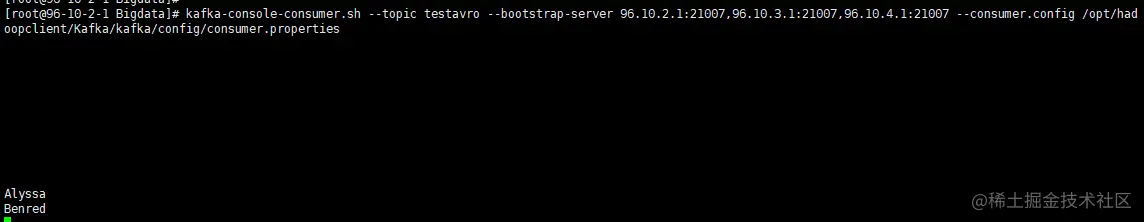

9、查看对应topic中是否有数据

FlinkSQL解析avro数据成功。

【推荐:Apache使用教程】

Das obige ist der detaillierte Inhalt vonLassen Sie uns darüber sprechen, wie Apache Avro-Daten analysiert werden (Erklärung mit Beispielen).. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

So setzen Sie das CGI -Verzeichnis in Apache

Apr 13, 2025 pm 01:18 PM

So setzen Sie das CGI -Verzeichnis in Apache

Apr 13, 2025 pm 01:18 PM

Um ein CGI-Verzeichnis in Apache einzurichten, müssen Sie die folgenden Schritte ausführen: Erstellen Sie ein CGI-Verzeichnis wie "CGI-bin" und geben Sie Apache-Schreibberechtigungen. Fügen Sie den Block "scriptalias" -Richtungsblock in die Apache-Konfigurationsdatei hinzu, um das CGI-Verzeichnis der URL "/cgi-bin" zuzuordnen. Starten Sie Apache neu.

So stellen Sie eine Verbindung zur Datenbank von Apache her

Apr 13, 2025 pm 01:03 PM

So stellen Sie eine Verbindung zur Datenbank von Apache her

Apr 13, 2025 pm 01:03 PM

Apache verbindet eine Verbindung zu einer Datenbank erfordert die folgenden Schritte: Installieren Sie den Datenbanktreiber. Konfigurieren Sie die Datei web.xml, um einen Verbindungspool zu erstellen. Erstellen Sie eine JDBC -Datenquelle und geben Sie die Verbindungseinstellungen an. Verwenden Sie die JDBC -API, um über den Java -Code auf die Datenbank zuzugreifen, einschließlich Verbindungen, Erstellen von Anweisungen, Bindungsparametern, Ausführung von Abfragen oder Aktualisierungen und Verarbeitungsergebnissen.

So starten Sie Apache

Apr 13, 2025 pm 01:06 PM

So starten Sie Apache

Apr 13, 2025 pm 01:06 PM

Die Schritte zum Starten von Apache sind wie folgt: Installieren Sie Apache (Befehl: sudo apt-Get-Get-Installieren Sie Apache2 oder laden Sie ihn von der offiziellen Website herunter). (Optional, Linux: sudo systemctl

Was tun, wenn der Port Apache80 belegt ist

Apr 13, 2025 pm 01:24 PM

Was tun, wenn der Port Apache80 belegt ist

Apr 13, 2025 pm 01:24 PM

Wenn der Port -80 -Port der Apache 80 besetzt ist, lautet die Lösung wie folgt: Finden Sie den Prozess, der den Port einnimmt, und schließen Sie ihn. Überprüfen Sie die Firewall -Einstellungen, um sicherzustellen, dass Apache nicht blockiert ist. Wenn die obige Methode nicht funktioniert, konfigurieren Sie Apache bitte so, dass Sie einen anderen Port verwenden. Starten Sie den Apache -Dienst neu.

So löschen Sie mehr als Servernamen von Apache

Apr 13, 2025 pm 01:09 PM

So löschen Sie mehr als Servernamen von Apache

Apr 13, 2025 pm 01:09 PM

Um eine zusätzliche Servername -Anweisung von Apache zu löschen, können Sie die folgenden Schritte ausführen: Identifizieren und löschen Sie die zusätzliche Servername -Richtlinie. Starten Sie Apache neu, damit die Änderungen wirksam werden. Überprüfen Sie die Konfigurationsdatei, um Änderungen zu überprüfen. Testen Sie den Server, um sicherzustellen, dass das Problem behoben ist.

So sehen Sie Ihre Apache -Version an

Apr 13, 2025 pm 01:15 PM

So sehen Sie Ihre Apache -Version an

Apr 13, 2025 pm 01:15 PM

Es gibt 3 Möglichkeiten, die Version auf dem Apache -Server anzuzeigen: Über die Befehlszeile (apachect -v- oder apache2CTL -v) überprüfen Sie die Seite Serverstatus (http: // & lt; Server -IP- oder Domänenname & GT;/Server -Status) oder die Apache -Konfigurationsdatei (Serversion: Apache/& lt; Versionsnummer & GT;).).

Wie Debian die Hadoop -Datenverarbeitungsgeschwindigkeit verbessert

Apr 13, 2025 am 11:54 AM

Wie Debian die Hadoop -Datenverarbeitungsgeschwindigkeit verbessert

Apr 13, 2025 am 11:54 AM

In diesem Artikel wird erläutert, wie die Effizienz der Hadoop -Datenverarbeitung auf Debian -Systemen verbessert werden kann. Optimierungsstrategien decken Hardware -Upgrades, Parameteranpassungen des Betriebssystems, Änderungen der Hadoop -Konfiguration und die Verwendung effizienter Algorithmen und Tools ab. 1. Hardware -Ressourcenverstärkung stellt sicher, dass alle Knoten konsistente Hardwarekonfigurationen aufweisen, insbesondere die Aufmerksamkeit auf die Leistung von CPU-, Speicher- und Netzwerkgeräten. Die Auswahl von Hochleistungs-Hardwarekomponenten ist wichtig, um die Gesamtverarbeitungsgeschwindigkeit zu verbessern. 2. Betriebssystem -Tunes -Dateideskriptoren und Netzwerkverbindungen: Ändern Sie die Datei /etc/security/limits.conf, um die Obergrenze der Dateideskriptoren und Netzwerkverbindungen zu erhöhen, die gleichzeitig vom System geöffnet werden dürfen. JVM-Parameteranpassung: Einstellen in der Hadoop-env.sh-Datei einstellen

So konfigurieren Sie Zend für Apache

Apr 13, 2025 pm 12:57 PM

So konfigurieren Sie Zend für Apache

Apr 13, 2025 pm 12:57 PM

Wie konfigurieren Sie Zend in Apache? Die Schritte zur Konfiguration von Zend Framework in einem Apache -Webserver sind wie folgt: Installieren Sie Zend Framework und extrahieren Sie es in das Webserververzeichnis. Erstellen Sie eine .htaccess -Datei. Erstellen Sie das Zend -Anwendungsverzeichnis und fügen Sie die Index.php -Datei hinzu. Konfigurieren Sie die Zend -Anwendung (application.ini). Starten Sie den Apache -Webserver neu.