Backend-Entwicklung

Backend-Entwicklung

Python-Tutorial

Python-Tutorial

Der Python-Crawler crawlt Webseitendaten und analysiert die Daten

Der Python-Crawler crawlt Webseitendaten und analysiert die Daten

Der Python-Crawler crawlt Webseitendaten und analysiert die Daten

Dieser Artikel vermittelt Ihnen relevantes Wissen über Python. Er stellt hauptsächlich vor, wie Python-Crawler Webseitendaten crawlen und die Daten analysieren, um Ihnen dabei zu helfen, Crawler besser zum Analysieren von Webseiten zu verwenden hilfreich für alle.

【Verwandte Empfehlung: Python3-Video-Tutorial】

1. Das Grundkonzept des Webcrawlers

Webcrawler (auch bekannt als Webspider, Roboter) besteht darin, den Client zu simulieren, um Netzwerkanfragen zu senden Anforderungsantworten erhalten, ein Programm, das Internetinformationen nach bestimmten Regeln automatisch erfasst.

Solange der Browser alles kann, kann der Crawler im Prinzip alles tun.

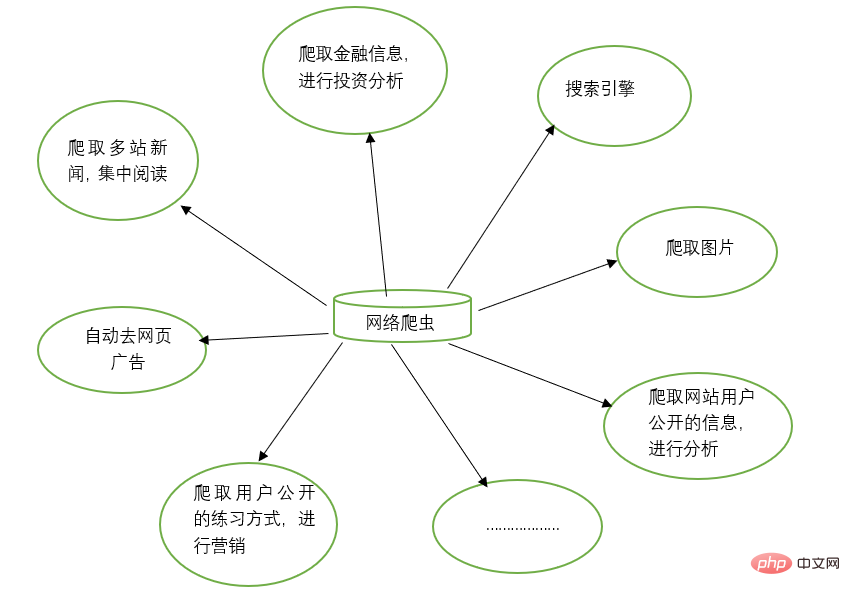

2. Funktionen von Webcrawlern

Webcrawler können die manuelle Arbeit bei vielen Dingen ersetzen, z. B. bei der Arbeit mit Suchmaschinen und beim Crawlen von Bildern auf Websites. Alle Bilder werden gecrawlt und durchsucht Gleichzeitig können Webcrawler auch im Bereich Finanzinvestitionen eingesetzt werden, um beispielsweise einige Finanzinformationen automatisch zu crawlen und Investitionsanalysen durchzuführen.

Manchmal haben wir möglicherweise mehrere Lieblingsnachrichten-Websites, und es ist mühsam, diese Nachrichten-Websites jedes Mal einzeln zum Durchsuchen zu öffnen. Zu diesem Zeitpunkt können Sie einen Webcrawler verwenden, um die Nachrichteninformationen von diesen mehreren Nachrichten-Websites zu crawlen und sie gemeinsam zu lesen.

Wenn wir im Internet nach Informationen suchen, stoßen wir manchmal auf jede Menge Werbung. Zu diesem Zeitpunkt können Sie auch einen Crawler verwenden, um die Informationen auf der entsprechenden Webseite zu crawlen, sodass diese Werbung automatisch herausgefiltert werden kann, um das Lesen und Verwenden der Informationen zu erleichtern.

Manchmal müssen wir Marketing betreiben, daher ist es von entscheidender Bedeutung, wie wir Zielkunden und deren Kontaktinformationen finden. Wir können manuell im Internet suchen, aber das wird sehr ineffizient sein. Derzeit können wir Crawler verwenden, um entsprechende Regeln festzulegen und automatisch die Kontaktinformationen und andere Daten der Zielbenutzer für unsere Marketingzwecke aus dem Internet zu sammeln.

Manchmal möchten wir die Benutzerinformationen einer bestimmten Website analysieren, z. B. die Benutzeraktivität, die Anzahl der Kommentare, beliebte Artikel und andere Informationen der Website. Wenn wir nicht der Website-Administrator sind, sind manuelle Statistiken sehr hilfreich Riesenprojekt. Zu diesem Zeitpunkt können Crawler verwendet werden, um diese Daten für die weitere Analyse einfach zu sammeln. Alle Crawling-Vorgänge werden automatisch ausgeführt. Wir müssen nur den entsprechenden Crawler schreiben und die entsprechenden Regeln entwerfen.

Darüber hinaus können Crawler auch viele leistungsstarke Funktionen erreichen. Kurz gesagt, das Aufkommen von Crawlern kann den manuellen Zugriff auf Webseiten bis zu einem gewissen Grad ersetzen. Daher können Vorgänge, die zuvor einen manuellen Zugriff auf Internetinformationen erforderten, jetzt mithilfe von Crawlern automatisiert werden, sodass effektive Informationen im Internet effizienter genutzt werden können. .

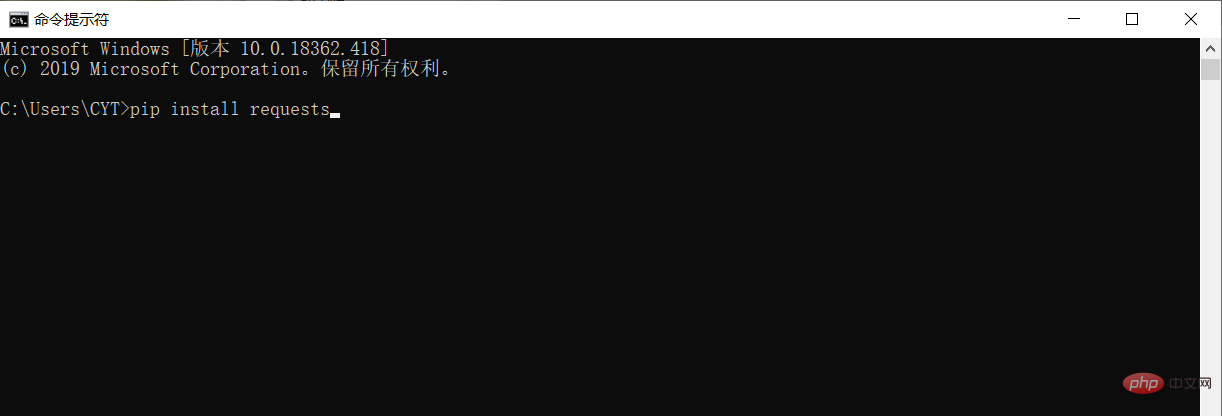

3. Installieren Sie Bibliotheken von Drittanbietern

Bevor Sie Daten crawlen und analysieren, müssen Sie die Bibliotheksanforderungen von Drittanbietern in der Python-Laufumgebung herunterladen und installieren.

Öffnen Sie im Windows-System die cmd-Schnittstelle (Eingabeaufforderung), geben Sie pip-Installationsanforderungen in die Schnittstelle ein und drücken Sie die Eingabetaste, um die Installation durchzuführen. (Achten Sie auf die Netzwerkverbindung) Wie unten gezeigt

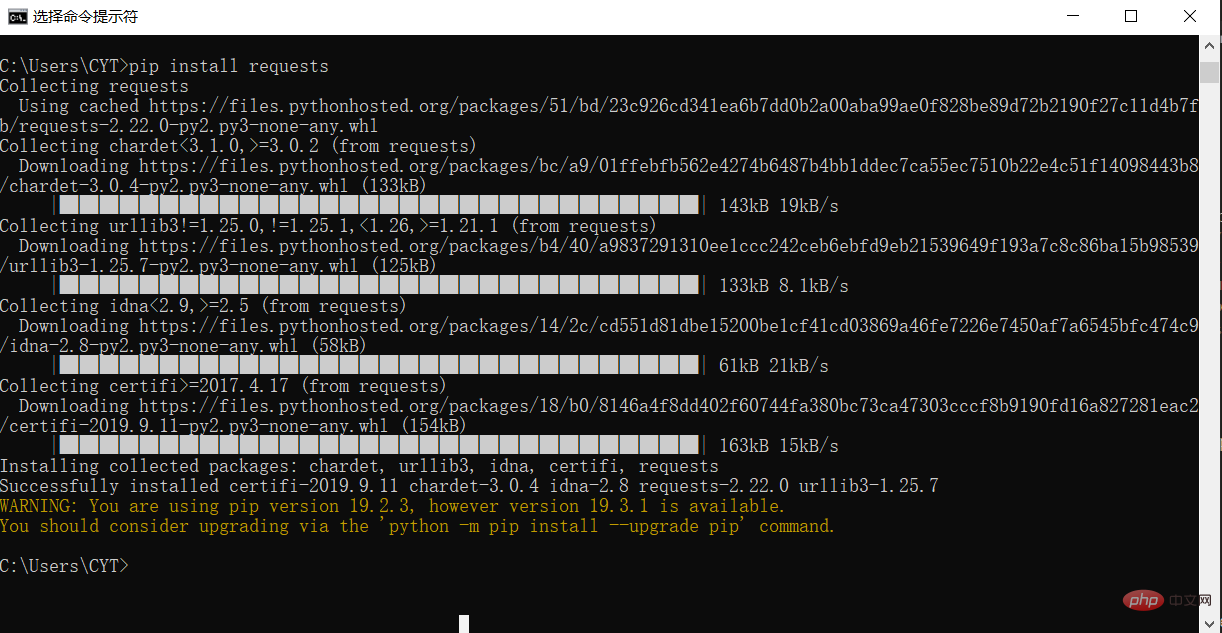

Die Installation ist abgeschlossen, wie im Bild gezeigt

4. Crawlen Sie die Taobao-Homepage

# 请求库

import requests

# 用于解决爬取的数据格式化

import io

import sys

sys.stdout = io.TextIOWrapper(sys.stdout.buffer,encoding='utf-8')

# 爬取的网页链接

r= requests.get("https://www.taobao.com/")

# 类型

# print(type(r))

print(r.status_code)

# 中文显示

# r.encoding='utf-8'

r.encoding=None

print(r.encoding)

print(r.text)

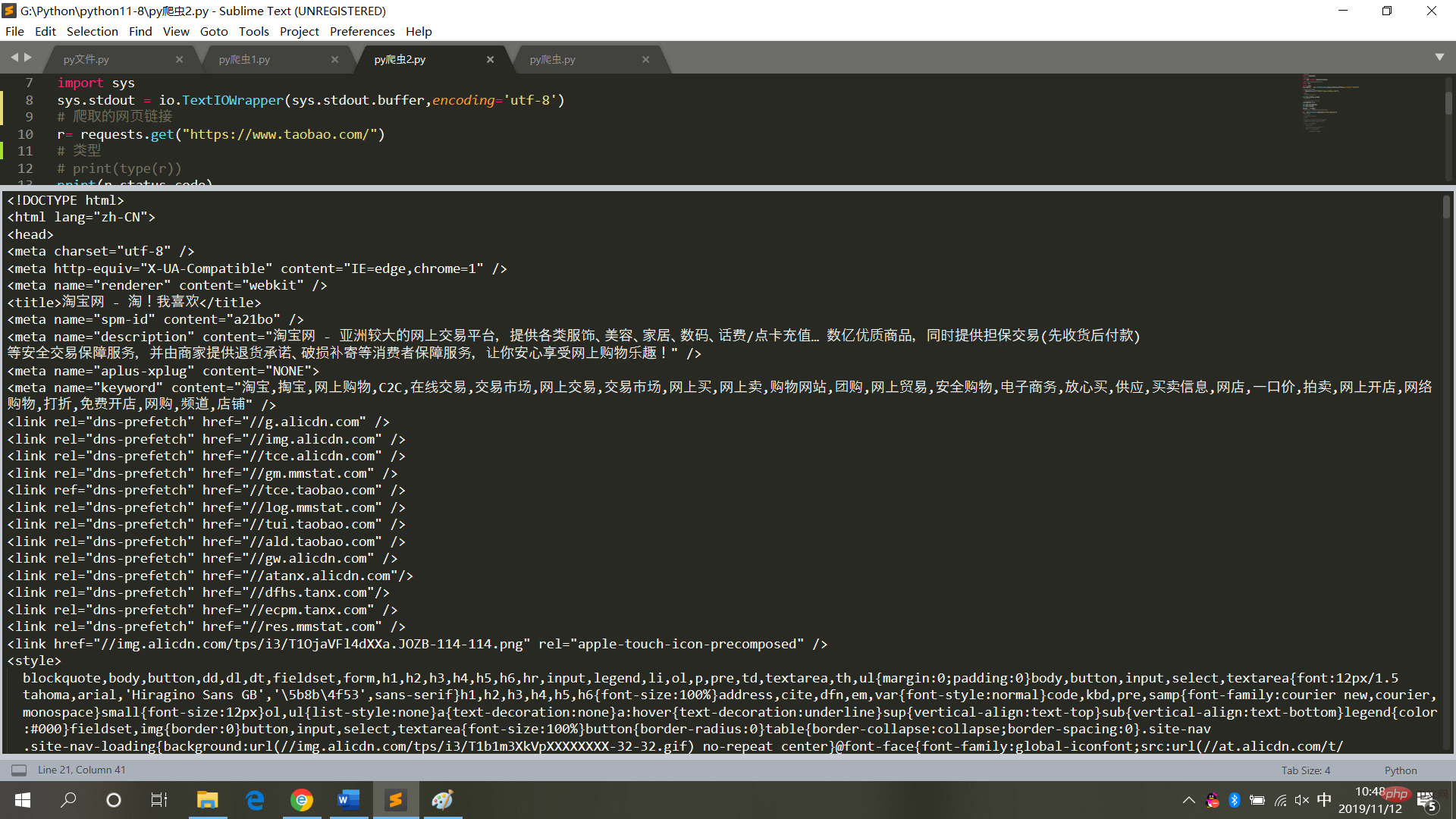

result = r.textDie laufenden Ergebnisse sind wie im Bild gezeigt Bild

5. Die laufenden Ergebnisse der Taobao-Homepage

# 请求库

import requests

# 解析库

from bs4 import BeautifulSoup

# 用于解决爬取的数据格式化

import io

import sys

sys.stdout = io.TextIOWrapper(sys.stdout.buffer,encoding='utf-8')

# 爬取的网页链接

r= requests.get("https://www.taobao.com/")

# 类型

# print(type(r))

print(r.status_code)

# 中文显示

# r.encoding='utf-8'

r.encoding=None

print(r.encoding)

print(r.text)

result = r.text

# 再次封装,获取具体标签内的内容

bs = BeautifulSoup(result,'html.parser')

# 具体标签

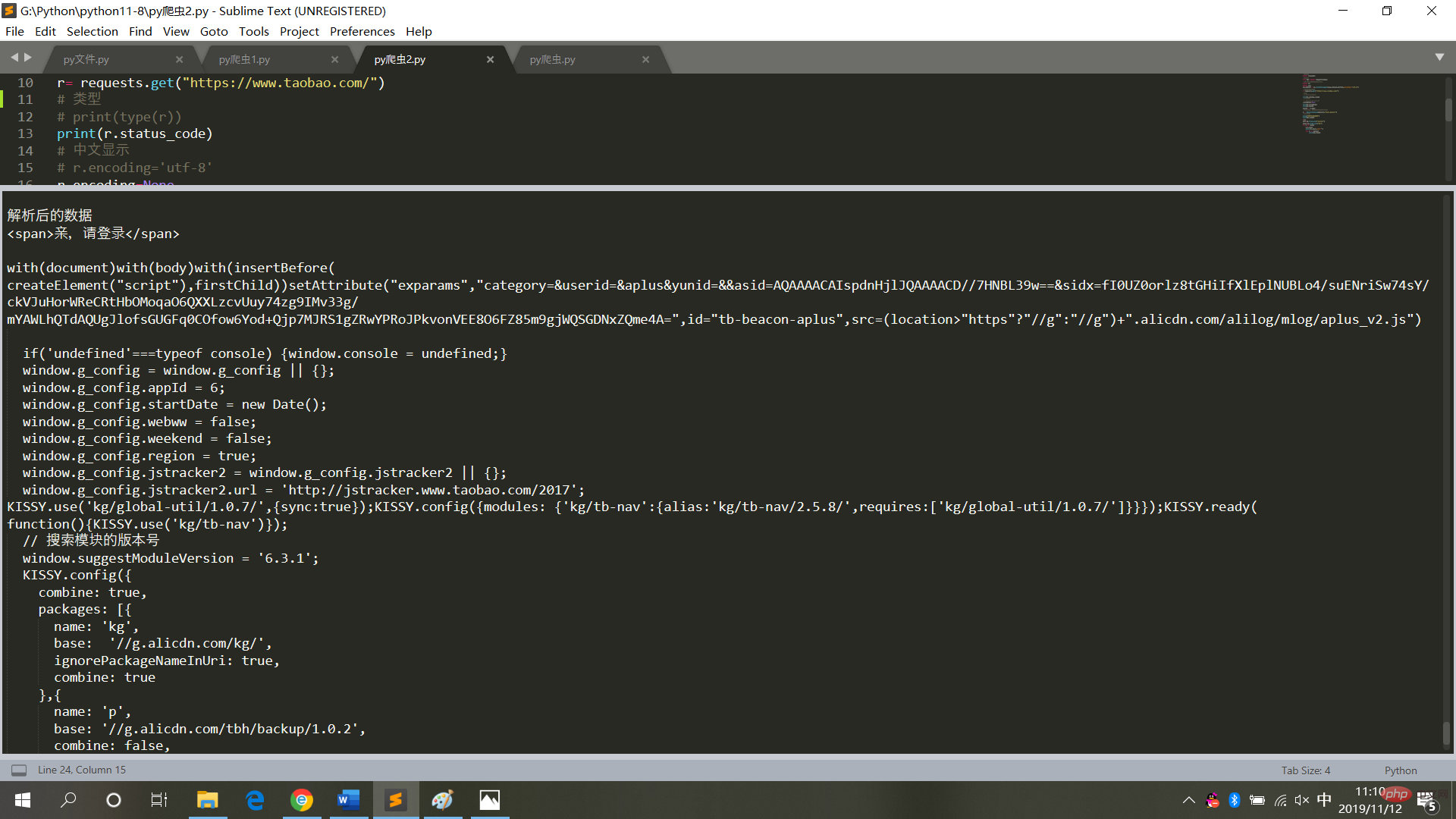

print("解析后的数据")

print(bs.span)

a={}

# 获取已爬取内容中的script标签内容

data=bs.find_all('script')

# 获取已爬取内容中的td标签内容

data1=bs.find_all('td')

# 循环打印输出

for i in data:

a=i.text

print(i.text,end='')

for j in data1:

print(j.text)sind wie in der Abbildung dargestellt

6. Zusammenfassung

Führen Sie beim Crawlen des Webseitencodes keine Operationen aus es häufig, geschweige denn, es in einen Endlosschleifenmodus zu versetzen (jedes Mal, wenn Crawling sich auf den Zugriff auf Webseiten bezieht. Häufige Vorgänge führen zum Absturz des Systems und es wird eine rechtliche Haftung eingeleitet).

Nachdem Sie die Webseitendaten erhalten haben, speichern Sie sie im lokalen Textmodus und analysieren Sie sie dann (Sie müssen nicht mehr auf die Webseite zugreifen).

【Verwandte Empfehlung: Python3-Video-Tutorial】

Das obige ist der detaillierte Inhalt vonDer Python-Crawler crawlt Webseitendaten und analysiert die Daten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Wie kontrolliert PS -Federn die Weichheit des Übergangs?

Apr 06, 2025 pm 07:33 PM

Wie kontrolliert PS -Federn die Weichheit des Übergangs?

Apr 06, 2025 pm 07:33 PM

Der Schlüssel zur Federkontrolle liegt darin, seine allmähliche Natur zu verstehen. PS selbst bietet nicht die Möglichkeit, die Gradientenkurve direkt zu steuern, aber Sie können den Radius und die Gradientenweichheit flexius durch mehrere Federn, Matching -Masken und feine Selektionen anpassen, um einen natürlichen Übergangseffekt zu erzielen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

MySQL hat eine kostenlose Community -Version und eine kostenpflichtige Enterprise -Version. Die Community -Version kann kostenlos verwendet und geändert werden, die Unterstützung ist jedoch begrenzt und für Anwendungen mit geringen Stabilitätsanforderungen und starken technischen Funktionen geeignet. Die Enterprise Edition bietet umfassende kommerzielle Unterstützung für Anwendungen, die eine stabile, zuverlässige Hochleistungsdatenbank erfordern und bereit sind, Unterstützung zu bezahlen. Zu den Faktoren, die bei der Auswahl einer Version berücksichtigt werden, gehören Kritikalität, Budgetierung und technische Fähigkeiten von Anwendungen. Es gibt keine perfekte Option, nur die am besten geeignete Option, und Sie müssen die spezifische Situation sorgfältig auswählen.

Wie richte ich PS -Federn ein?

Apr 06, 2025 pm 07:36 PM

Wie richte ich PS -Federn ein?

Apr 06, 2025 pm 07:36 PM

PS Federn ist ein Bildkantenschwärcheneffekt, der durch den gewichteten Durchschnitt der Pixel im Randbereich erreicht wird. Das Einstellen des Federradius kann den Grad der Unschärfe steuern und je größer der Wert ist, desto unscharfer ist er. Eine flexible Einstellung des Radius kann den Effekt entsprechend den Bildern und Bedürfnissen optimieren. Verwenden Sie beispielsweise einen kleineren Radius, um Details bei der Verarbeitung von Charakterfotos zu erhalten und einen größeren Radius zu verwenden, um ein dunstiges Gefühl bei der Verarbeitung von Kunst zu erzeugen. Es ist jedoch zu beachten, dass zu groß der Radius leicht an Kantendetails verlieren kann, und zu klein ist der Effekt nicht offensichtlich. Der Federneffekt wird von der Bildauflösung beeinflusst und muss anhand des Bildverständnisses und des Griffs von Effekten angepasst werden.

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

Die MySQL -Leistungsoptimierung muss von drei Aspekten beginnen: Installationskonfiguration, Indexierung und Abfrageoptimierung, Überwachung und Abstimmung. 1. Nach der Installation müssen Sie die my.cnf -Datei entsprechend der Serverkonfiguration anpassen, z. 2. Erstellen Sie einen geeigneten Index, um übermäßige Indizes zu vermeiden und Abfrageanweisungen zu optimieren, z. B. den Befehl Erklärung zur Analyse des Ausführungsplans; 3. Verwenden Sie das eigene Überwachungstool von MySQL (ShowProcessList, Showstatus), um die Datenbankgesundheit zu überwachen und die Datenbank regelmäßig zu sichern und zu organisieren. Nur durch kontinuierliche Optimierung dieser Schritte kann die Leistung der MySQL -Datenbank verbessert werden.

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Die MySQL-Datenbankleistung Optimierungshandbuch In ressourcenintensiven Anwendungen spielt die MySQL-Datenbank eine entscheidende Rolle und ist für die Verwaltung massiver Transaktionen verantwortlich. Mit der Erweiterung der Anwendung werden jedoch die Datenbankleistung Engpässe häufig zu einer Einschränkung. In diesem Artikel werden eine Reihe effektiver Strategien zur Leistungsoptimierung von MySQL -Leistung untersucht, um sicherzustellen, dass Ihre Anwendung unter hohen Lasten effizient und reaktionsschnell bleibt. Wir werden tatsächliche Fälle kombinieren, um eingehende Schlüsseltechnologien wie Indexierung, Abfrageoptimierung, Datenbankdesign und Caching zu erklären. 1. Das Design der Datenbankarchitektur und die optimierte Datenbankarchitektur sind der Eckpfeiler der MySQL -Leistungsoptimierung. Hier sind einige Kernprinzipien: Die Auswahl des richtigen Datentyps und die Auswahl des kleinsten Datentyps, der den Anforderungen entspricht, kann nicht nur Speicherplatz speichern, sondern auch die Datenverarbeitungsgeschwindigkeit verbessern.

Lösungen für den Dienst, der nach der MySQL -Installation nicht gestartet werden kann

Apr 08, 2025 am 11:18 AM

Lösungen für den Dienst, der nach der MySQL -Installation nicht gestartet werden kann

Apr 08, 2025 am 11:18 AM

MySQL hat sich geweigert, anzufangen? Nicht in Panik, lass es uns ausprobieren! Viele Freunde stellten fest, dass der Service nach der Installation von MySQL nicht begonnen werden konnte, und sie waren so ängstlich! Mach dir keine Sorgen, dieser Artikel wird dich dazu bringen, ruhig damit umzugehen und den Mastermind dahinter herauszufinden! Nachdem Sie es gelesen haben, können Sie dieses Problem nicht nur lösen, sondern auch Ihr Verständnis von MySQL -Diensten und Ihren Ideen zur Fehlerbehebungsproblemen verbessern und zu einem leistungsstärkeren Datenbankadministrator werden! Der MySQL -Dienst startete nicht und es gibt viele Gründe, von einfachen Konfigurationsfehlern bis hin zu komplexen Systemproblemen. Beginnen wir mit den häufigsten Aspekten. Grundkenntnisse: Eine kurze Beschreibung des Service -Startup -Prozesses MySQL Service Startup. Einfach ausgedrückt, lädt das Betriebssystem MySQL-bezogene Dateien und startet dann den MySQL-Daemon. Dies beinhaltet die Konfiguration

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

Die Hauptgründe für den Fehler bei MySQL -Installationsfehlern sind: 1. Erlaubnisprobleme, Sie müssen als Administrator ausgeführt oder den Sudo -Befehl verwenden. 2. Die Abhängigkeiten fehlen, und Sie müssen relevante Entwicklungspakete installieren. 3. Portkonflikte müssen Sie das Programm schließen, das Port 3306 einnimmt, oder die Konfigurationsdatei ändern. 4. Das Installationspaket ist beschädigt. Sie müssen die Integrität herunterladen und überprüfen. 5. Die Umgebungsvariable ist falsch konfiguriert und die Umgebungsvariablen müssen korrekt entsprechend dem Betriebssystem konfiguriert werden. Lösen Sie diese Probleme und überprüfen Sie jeden Schritt sorgfältig, um MySQL erfolgreich zu installieren.